前面介绍了本地部署DeepSeek-R1,也有很多小伙伴们使用三方模型服务,开放的API调用,更加方便日常工作生活的使用,仍有隐私内容和个人知识想让DeepSeek模型引用,如何打造个人知识库,本地DeepSeek-R1 + 个人知识库打造,开启自己的RAG。

推荐最近很火的工具 Cherry Studio - 全能的AI助手免费且简单易用。

一 安装CherryStudio

下载地址:Cherry Studio - 全能的AI助手,根据类型下载,笔者MacBookPro为例子。

下载完成后正常Mac安装:

二 配置Cherry Studio

如下提供2种方式配置样例,分别用1第三方服务硅基流动;2本地Ollama部署模型方式:

方式一(第三方DeepSeek服务API方式):

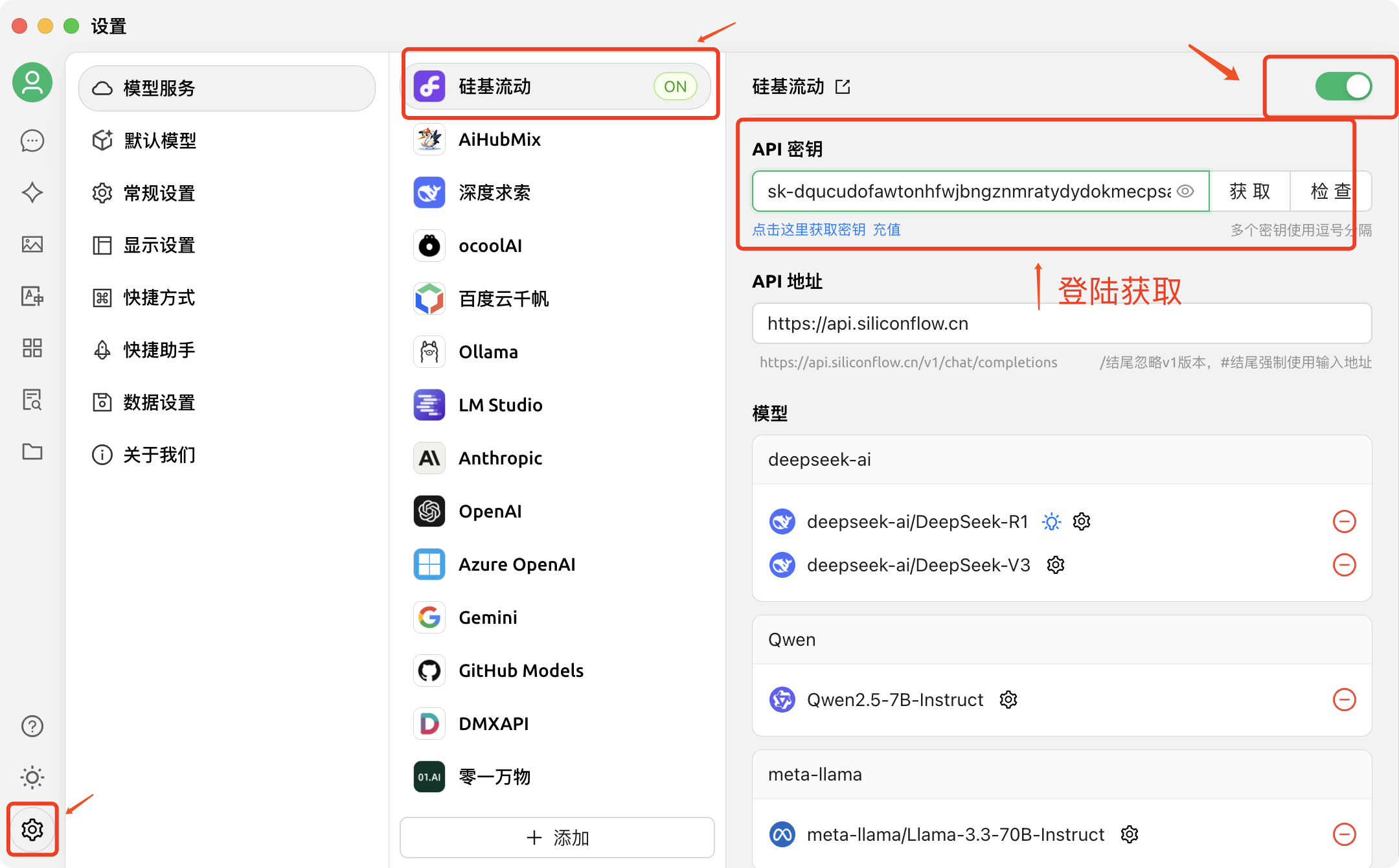

1 可选择多种API进行配置,可采用硅基流动的一个在线API,目前免费注册。如下演示使用为在线API调用,选择注册的用户点击登陆-获取一个API密钥(登陆就可获取)。

选择左下角设置,选择模型服务,选择调用API密钥方式(登陆后授权获取一串密钥)。

2 继续找到对应模型服务中,绿色-【管理按钮】,选择一个LLM的推理模型DeepSeek-R1模型用于对话交互。

3 选择嵌入模型BAAI/bge-m3,也可尝试其他内嵌模型:BAAI/bge-m3是BAAI开源的嵌入模型,主要用于生成文本嵌入(text embeddings)。它是一个多功能、多语言、多粒度的模型用于检索本地知识库。

方式二:使用本地Ollama部署方式:

1 使用本地Ollama方式部署(参考之前博客:本地部署DeepSeek精简易懂(Ollama支持多种LLM模型)-优快云博客):

2 本地使用Ollama同样需要额外下载一个 bge-m3 模型用于检索本地知识库,打开命令终端

命令:

ollama pull bge-m3

完成后为success。

3 开启-模型服务-Ollama-选择绿色按钮-管理,将本地运行的模型进行添加:

三 本地个人知识库添加

1 如下找到知识库按钮,点击+添加,添加知识库,填写名称,并选择嵌入模型BAAI/bge-m3。

2 编辑自己的知识库文件,可以是doc,xlsx,pdf等,也可以添加整个目录。

四 使用本地知识库问答

1选择对话窗口后,选择刚才创建的本地知识库:-本地知识库1,并向DeepSeek-R1提问:本地知识库包含的知识内容,回答可看到其引用来源为本地目录中的: 本地知识库文档1.docx

2 也可切换本地Ollama模型进行问答:

3 下面我们可以好好整理一下个人知识库了,这样DeepSeek也可以让他参考我们自己的本地知识库来思考给出答案了。(点赞关注,十分感谢大家👍)

2321

2321

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?