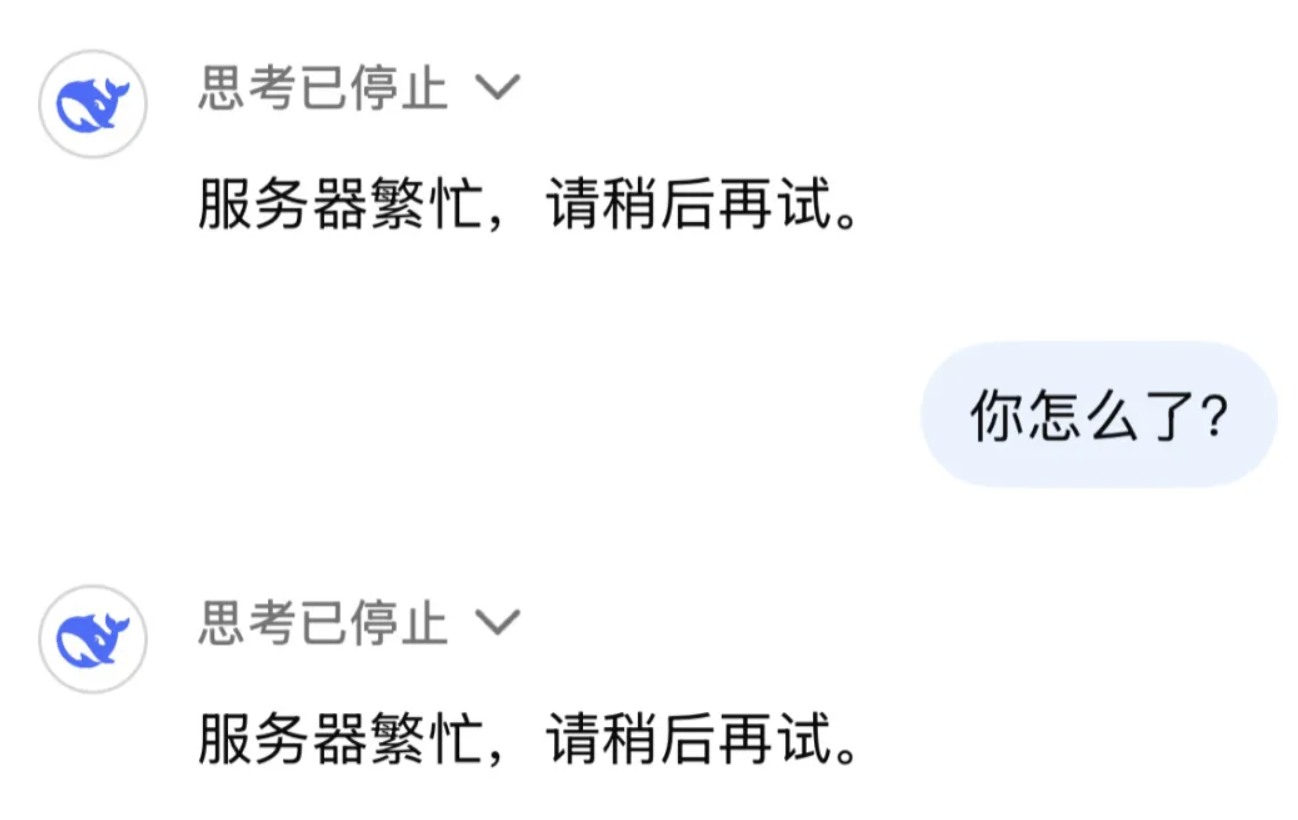

为什么本地部署DeepSeek?

最近访问DeepSeek出现服务器繁忙,请稍后尝试,介于大家过于“热情”,本地部署DeepSeek及支持多种LLM模型,那本地化部署DeepSeek就十分必要了😄,最简单方法来了,以mac版例子,windows,linux类似。

本次部署还有三大优点:

1 不联网,全私密,不担心隐私泄露,还可以挂载本地知识库。

2 完全免费,彻底告别“服务器繁忙”。

3 小白快速使用精简易懂,插件仓库及下载地址方便,无需科学上网(请关注支持感谢🙏)。

汇总我们需要用到两个神器

1 Ollama,这是一个可以在本地运行和管理大模型的软件。

2 Chrome浏览器插件 Page Assist,这是个浏览器插件,提供本地大模型的图形化管理和对话界面。(当然也有很多其他工具比如Open WebUI,但本次给大家直接提供PageAssist插件,有Chrome浏览器就能用哦)

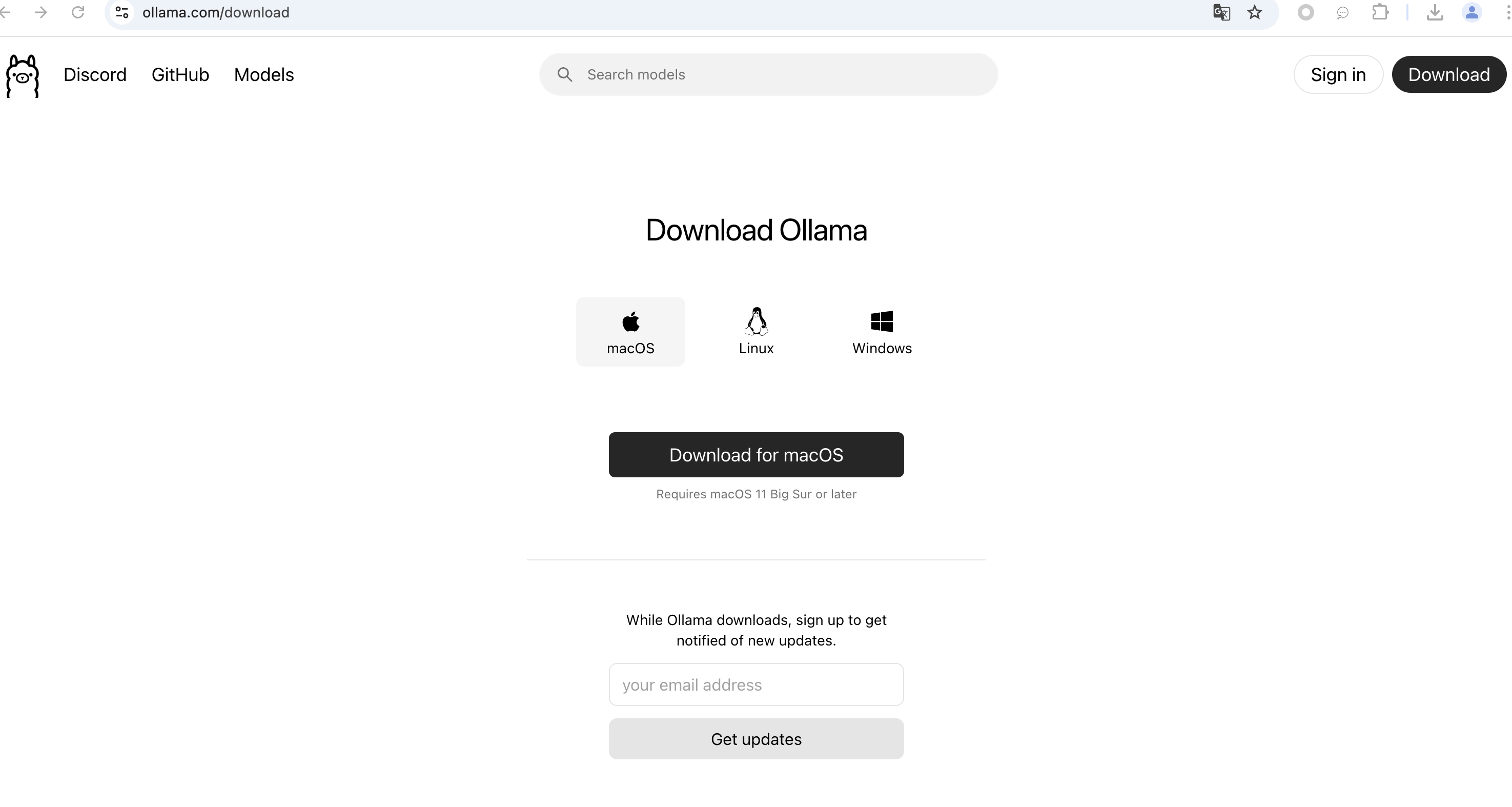

一、Ollama 安装和使用

Ollama 是一个专门用来在本地环境下运行和部署LLM的一个工具,安装和部署使用都很简单,同时支持多种语言模型(Run Llama 3.3, DeepSeek-R1, Phi-4, Mistral, Gemma 2, and other models, locally)。

直接下载macOS版本的程序,其实从上图你可以发现,Linux和Windows也是OK(这个咱后面再讲)。

下载后是一个压缩包,二话不说,直接解压,你会得到一个“草泥马”头像的程序

将压缩包解压后,这个程序可以直接点击运行,但是建议你拖到「应用程序」目录下,便于用的时候以后好找。

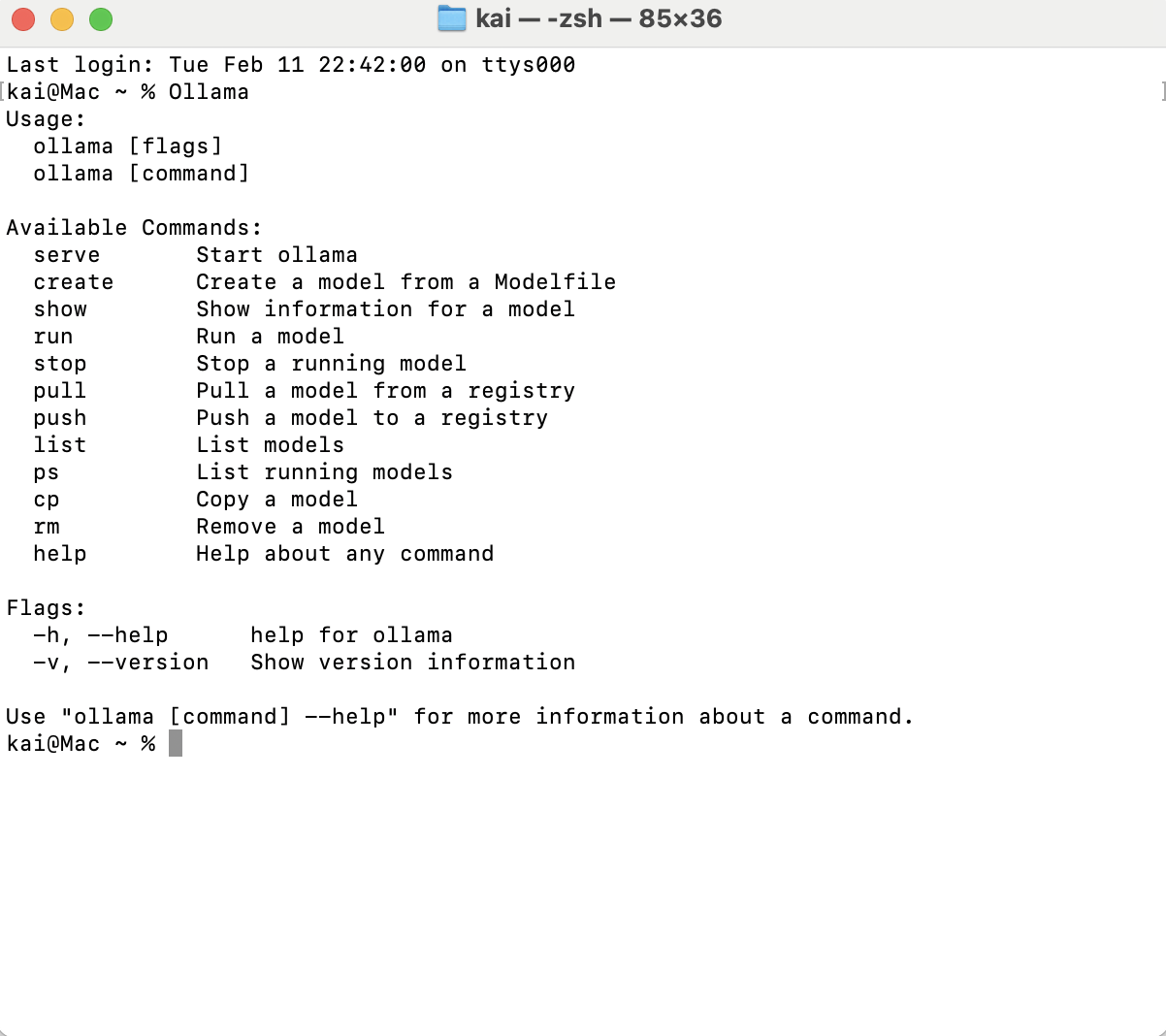

好了,接下来直接运行Ollama,然后进入到终端窗口↓

↓

终端输入Ollama后,返回如下图代表安装完成。

接下来运行命令,拉取对应版本的模型即可。

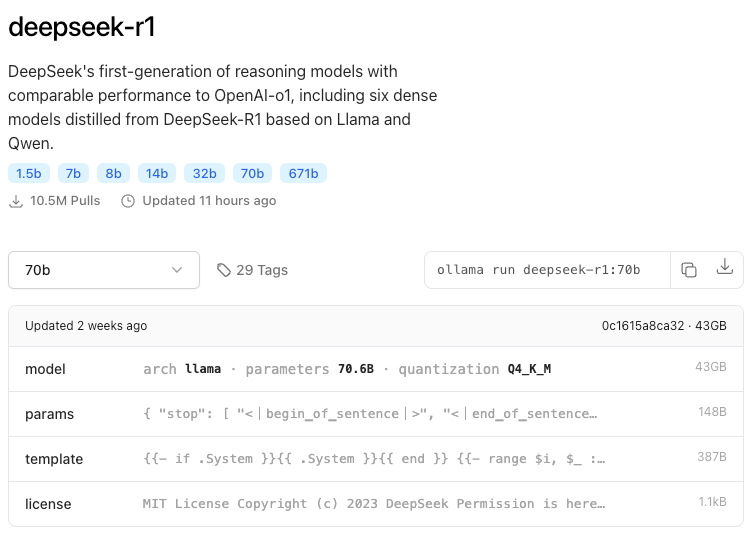

目前DeepSeek-R1可选的模型有满血版671B,和蒸馏版1.5B、7B、8B、14B、32B、70B:

下面根据自己选择,来选择下载什么模型(根据自己的实际情况来做,也可以下载多个模型,下载速度有些慢...😑),我们以DeepSeek-r1:7b为例子:

下载命令:

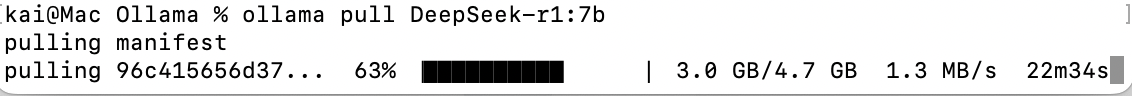

ollama pull DeepSeek-r1:7b

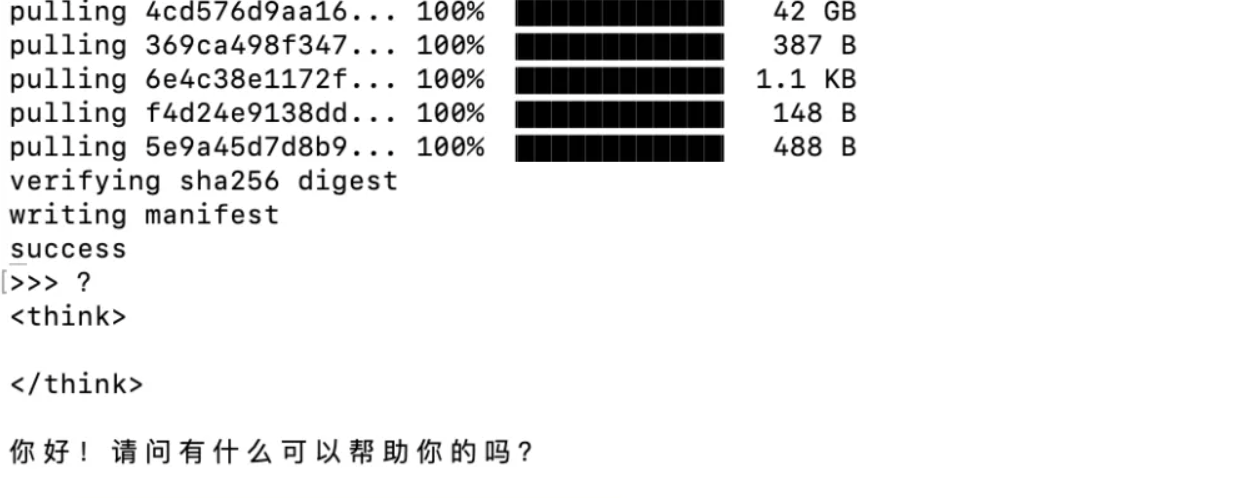

运行下载模型(直接run默认拉取下载),执行完成 success 提示完成模型运行。

ollama run DeepSeek-r1:7b

二、Chrome Page Assist插件安装使用

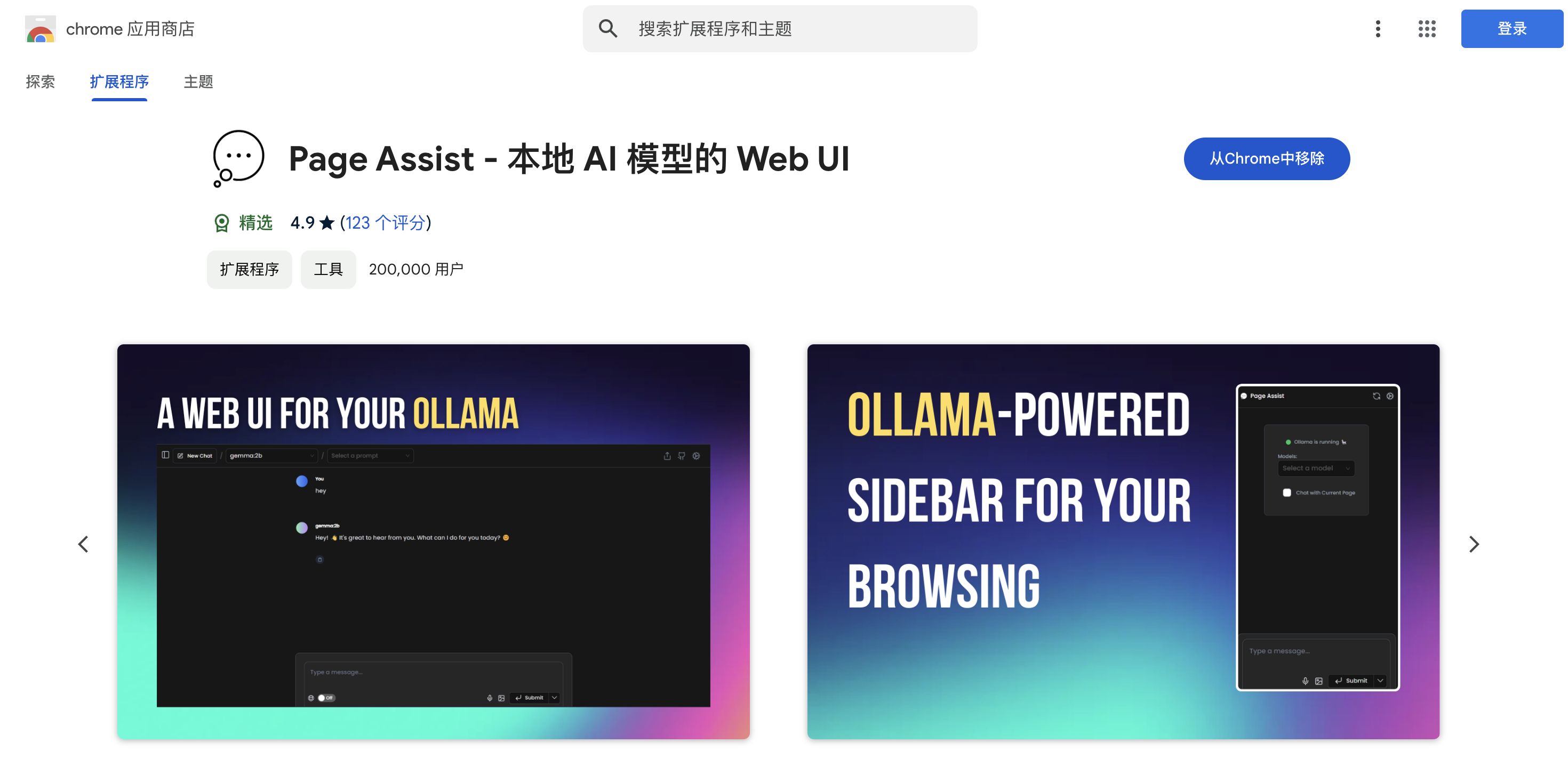

Chrome 应用商店搜索 Page Assist (也可直接用博主提供方式下载后导入)Page Assist - 本地 AI 模型的 Web UI,轻量化且十分方便能够Web UI调用和切换本地部署模型,简单易用十分方便 GitHub仓库地址: Release v1.5.0 · n4ze3m/page-assist · GitHub 。

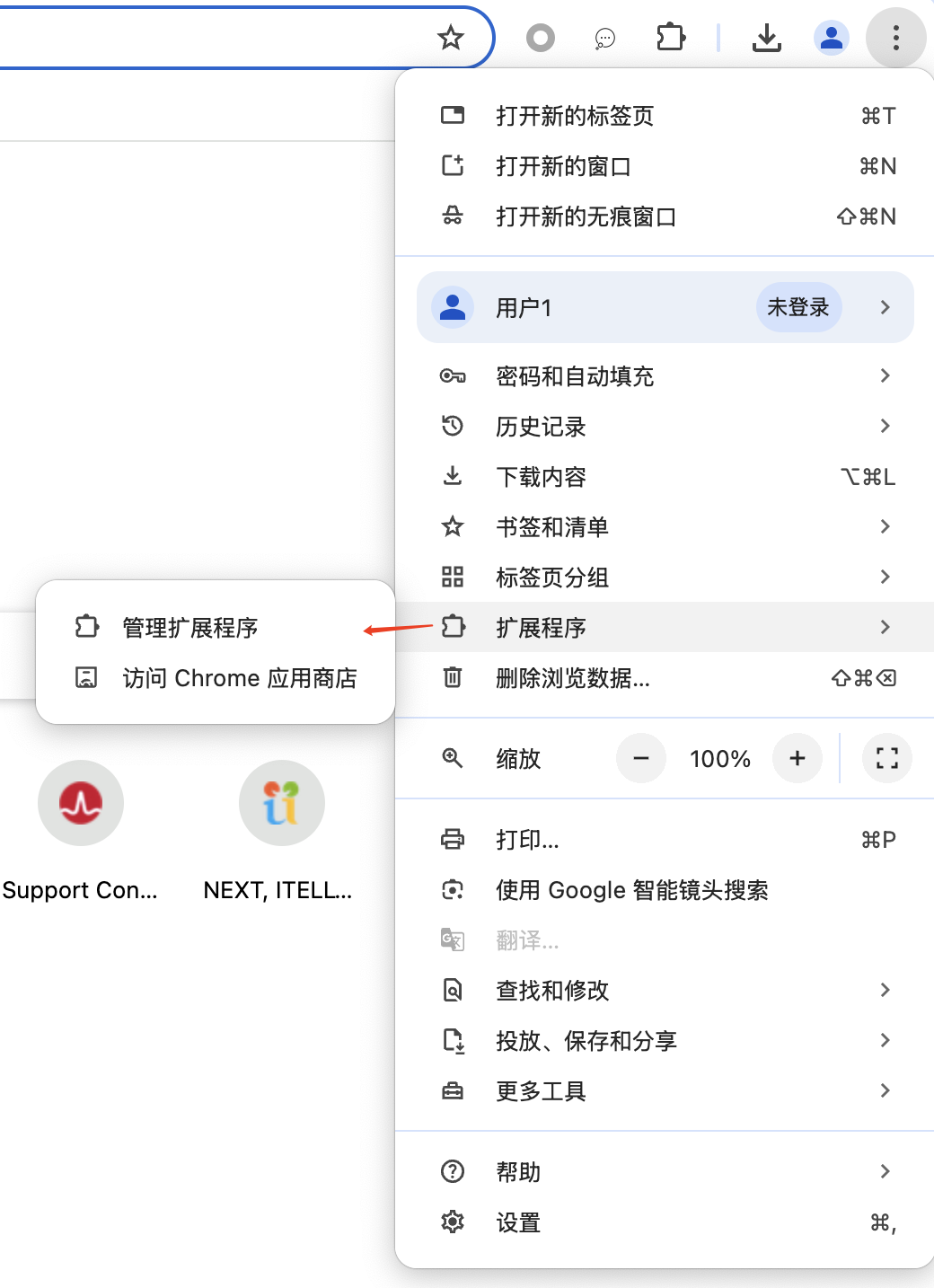

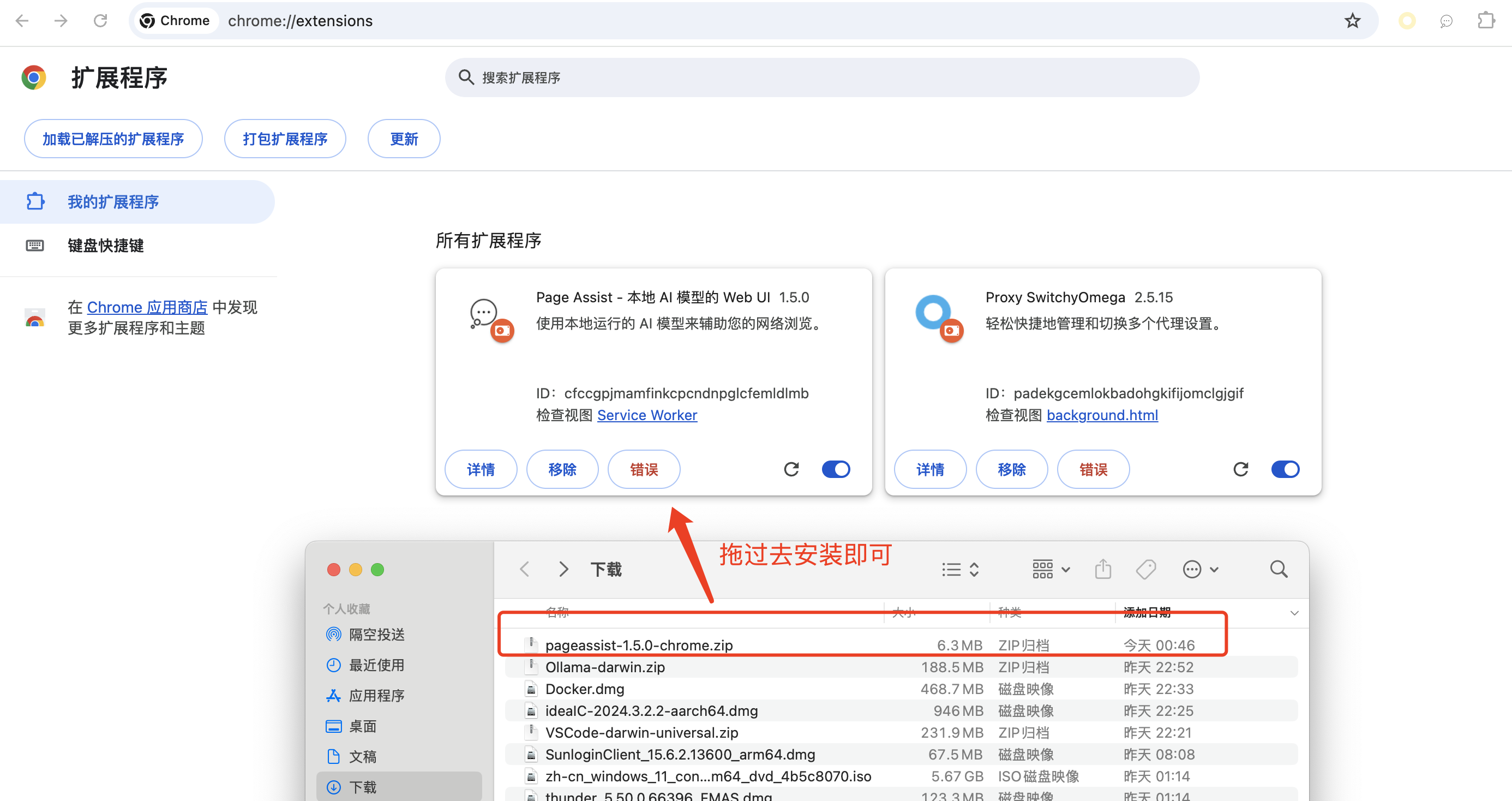

1 在更多中找到扩展程序,直接可以下载提供的插件,管理扩展程序中添加,或者在Chrome商城搜索后下载。

pageassist-1.5.0-chrome.zip,支持其他浏览器版本,根据需求对应版本下载。)

打开Chrome浏览器,点到如下图:更多 - 扩展程序 - 管理扩展程序

将下载后的pageassist-1.5.0-chrome.zip直接拖过去安装即可。

也可在商店搜索直接下载安装插件(需科学上网,可跳过此方法)。

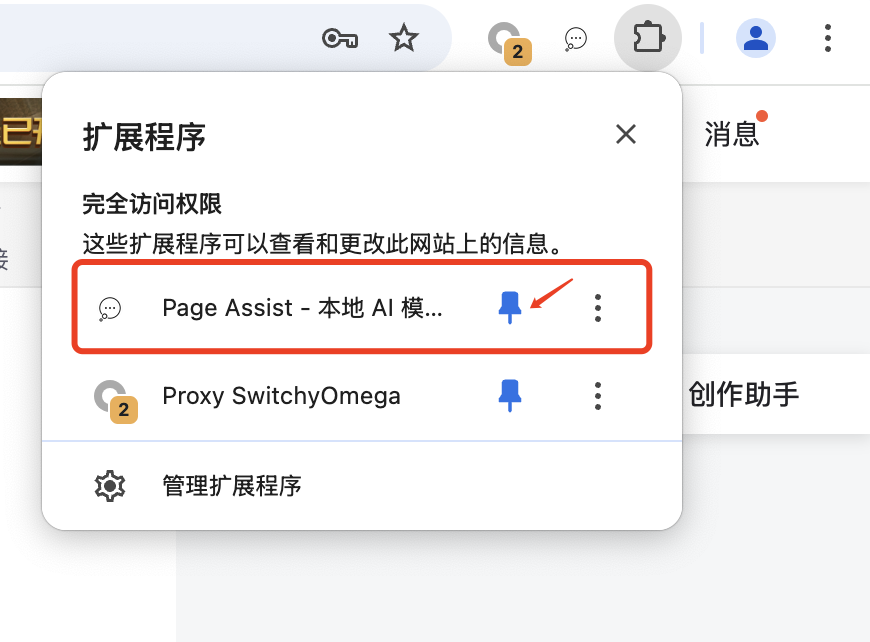

2 浏览器安装后也可将Page Assist插件置顶为固定方便使用。

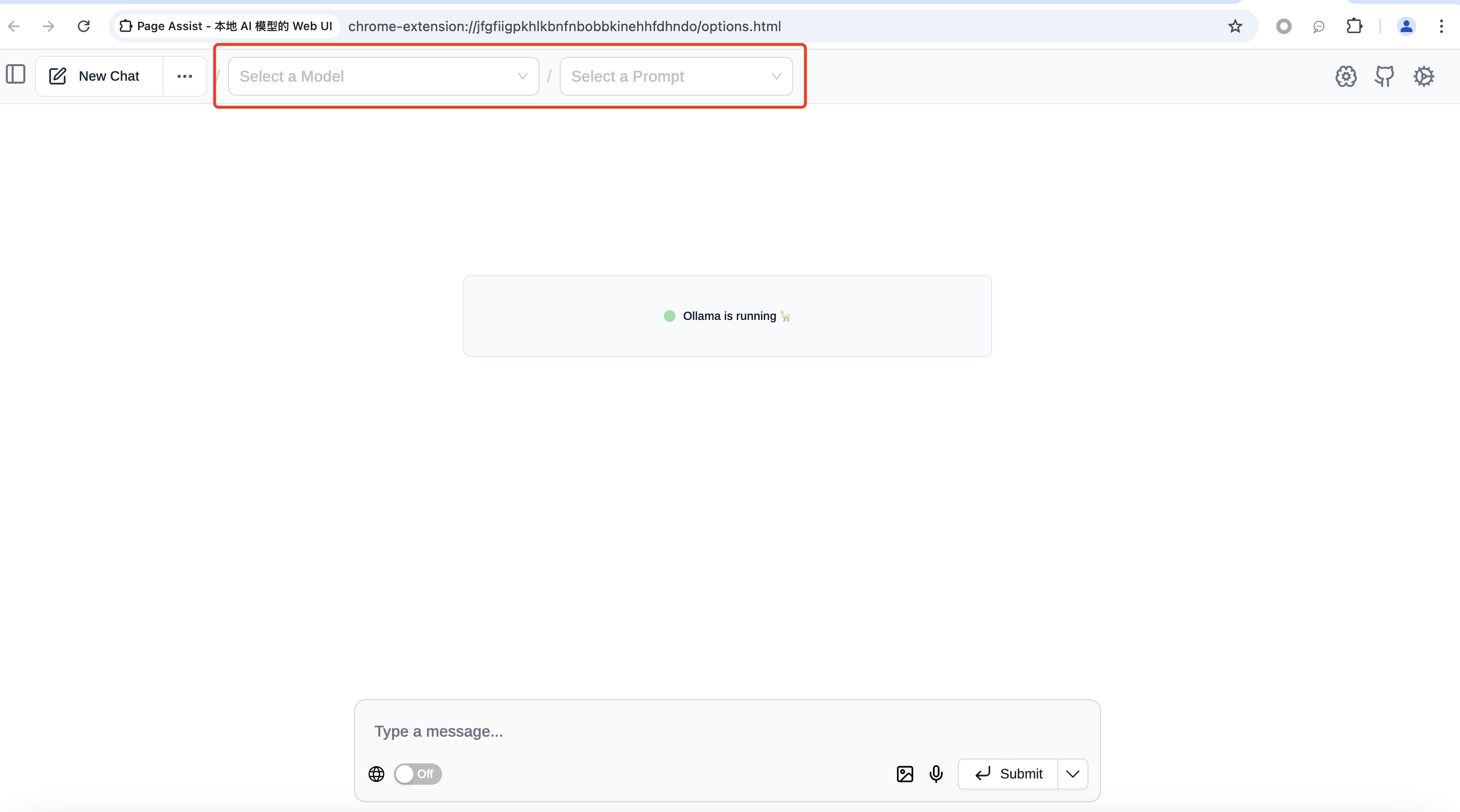

3 下面我们就可以打开Chrome Page Assist ,选择模型开始使用😄。

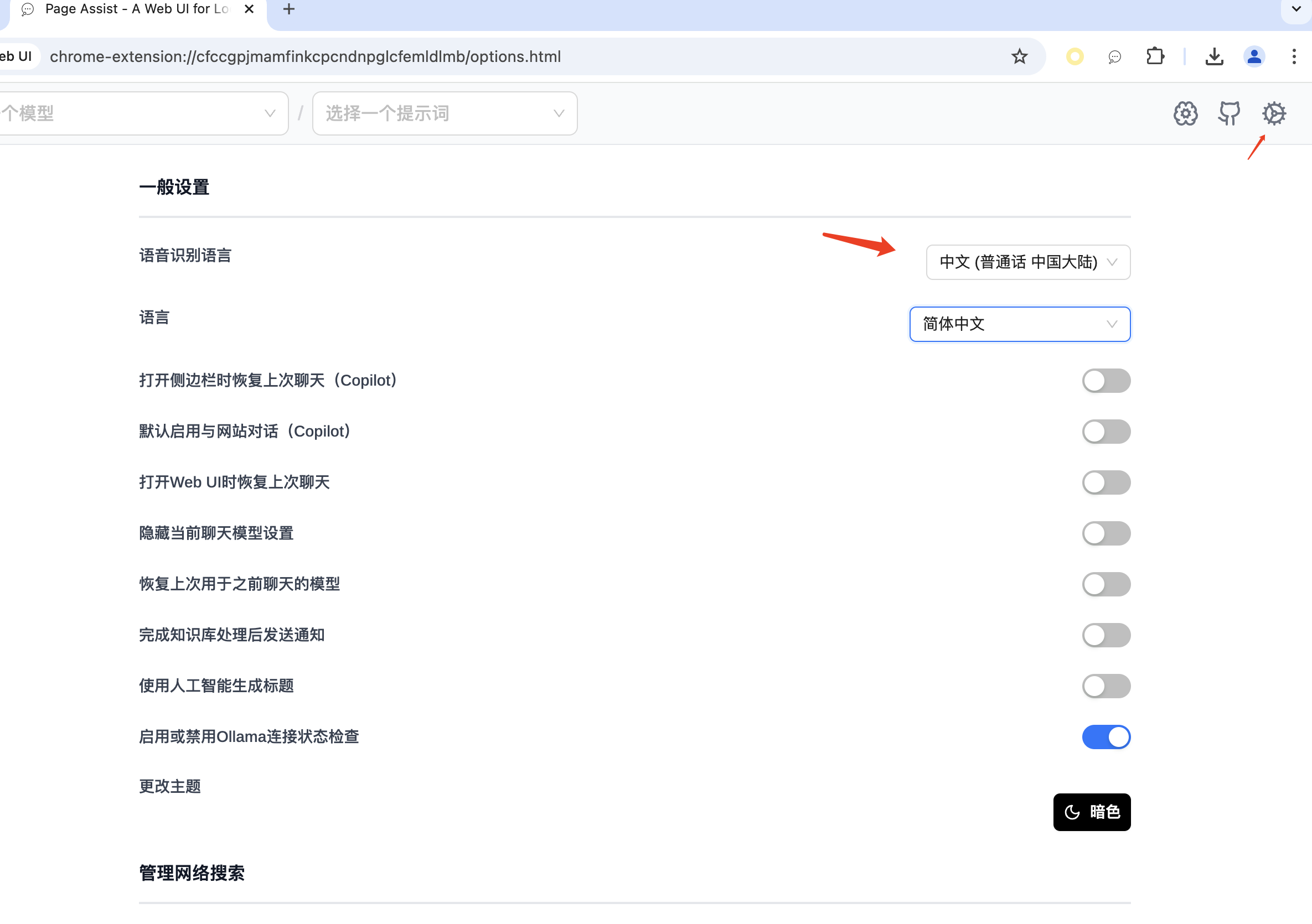

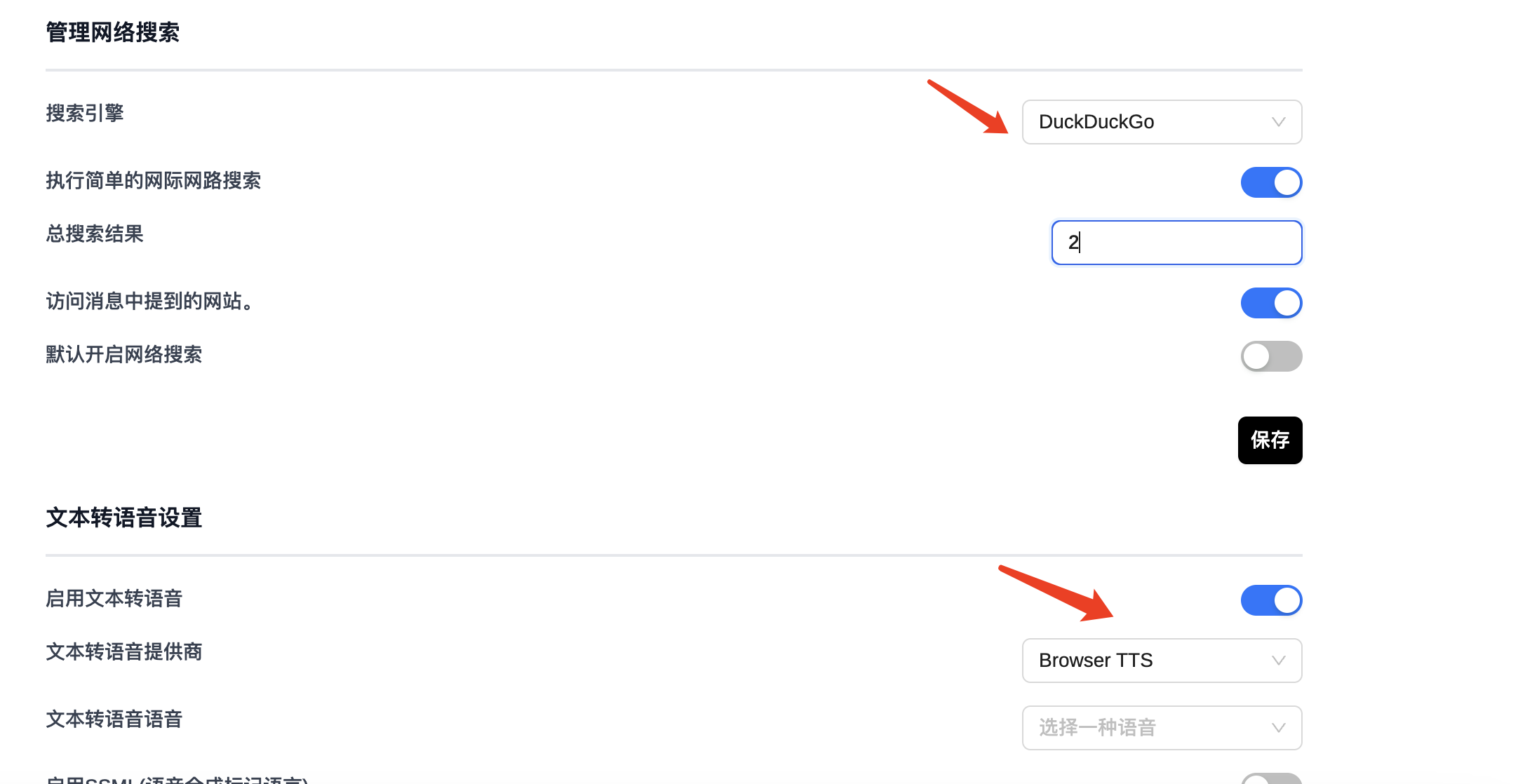

点击右上角的齿轮,可以进行基础设置,比如更改语言、语音(默认都是英文,可以修改为简体中文)。

还可以更改默认搜索引擎,让大模型在推理的同时,开启联网搜索功能,文本转语音等。

总结扩展

还可以添加本地知识库,让DeepSeek更具备个性化和专属性。

至此,万事具备,让我们来体验本地DeepSeek,祝大家部署顺利,天天好心情!🙏关注 点赞 👍

1167

1167

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?