一、创建项目

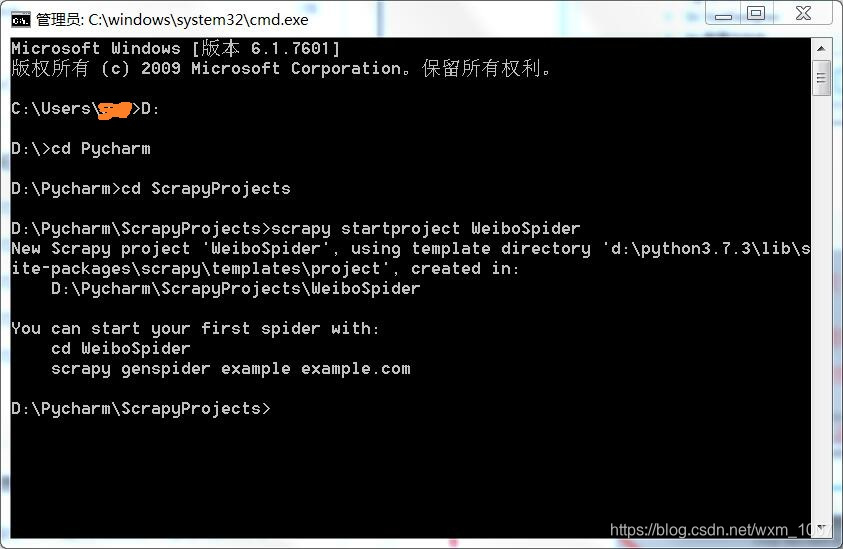

cmd打开命令行

打开项目保存的文件夹地址如下图

我的项目保存在D:\Pycharm\ScrapyProjects

然后在终端输入 scrapy startproject 项目名称(此处我的项目名称为WeiboSpider)

以上则为创建项目成功

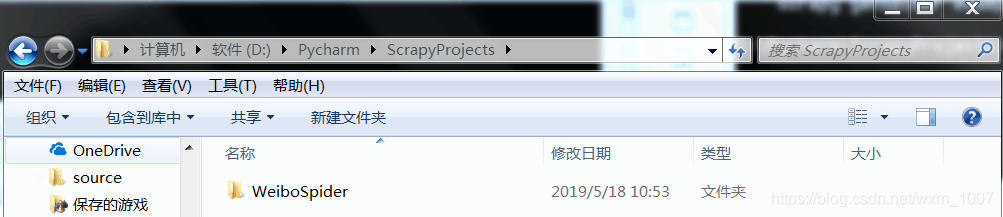

此时存储位置会出现创建的项目文件夹,如下图:

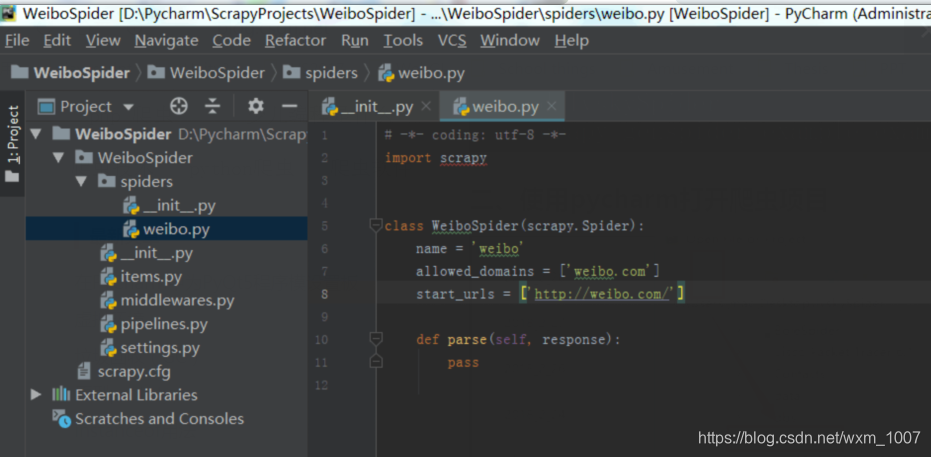

二、打开爬虫项目

用Pycharm打开项目文件夹

则有如下的文件

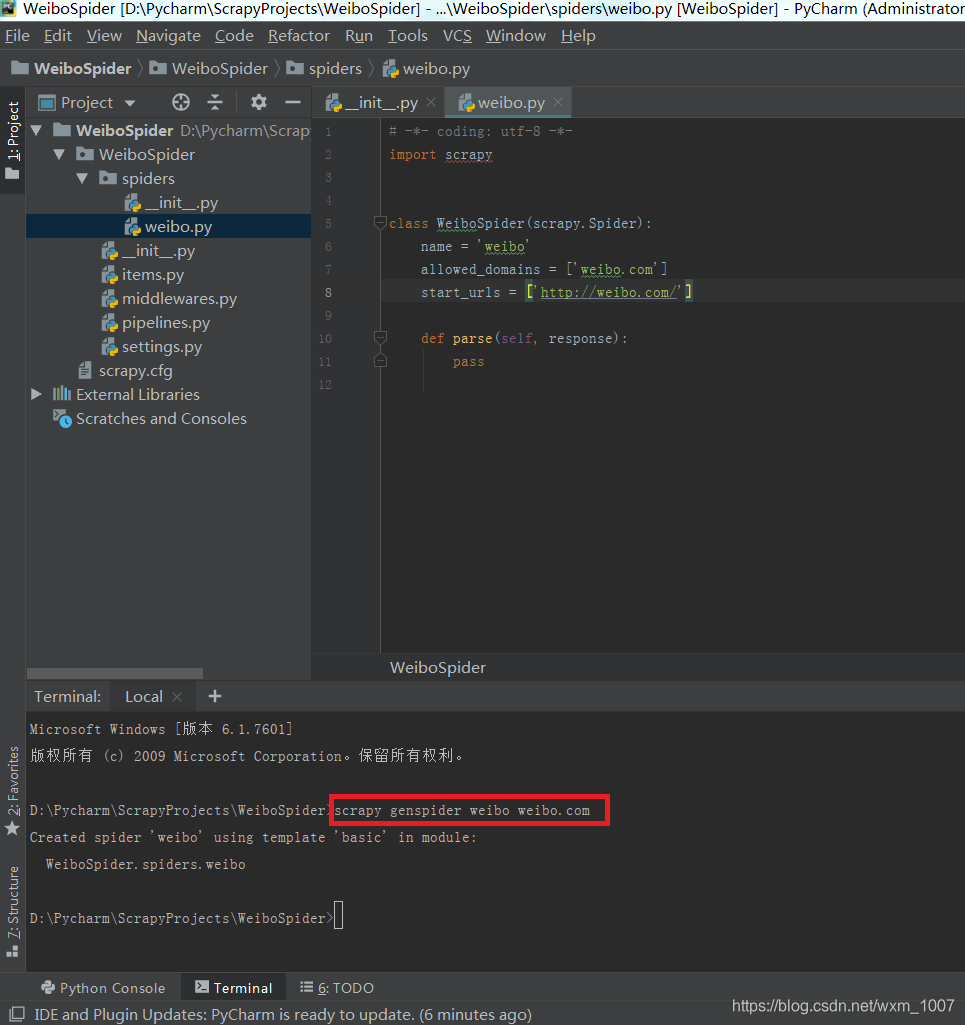

再在Pycharm终端创建爬虫项目,如下图所示输入

weibo是爬虫名称,weibo.com是网站域名

三、运行爬虫文件

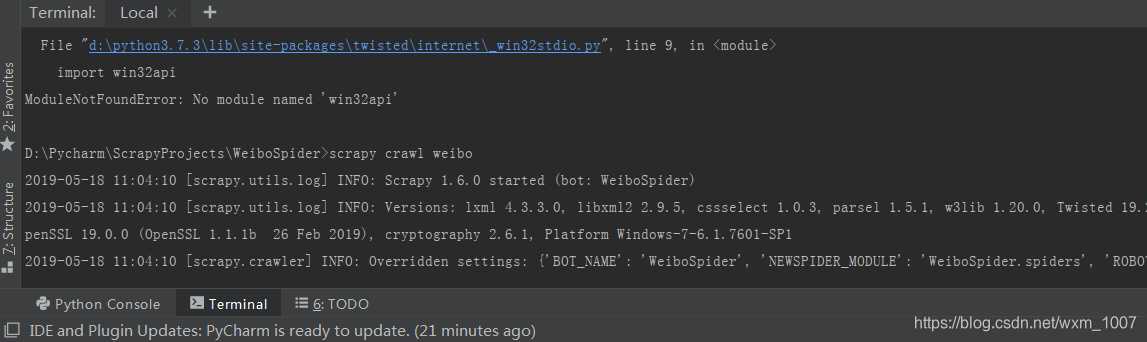

在上图终端输入scrapy crawl weibo

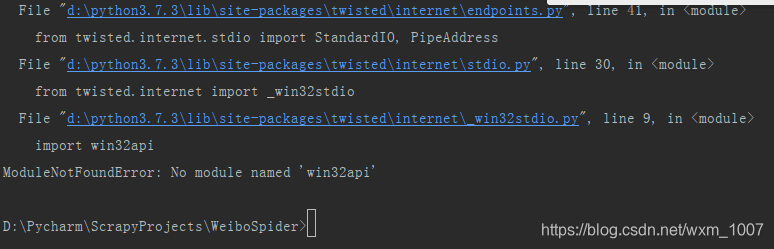

然后出现了下图错误

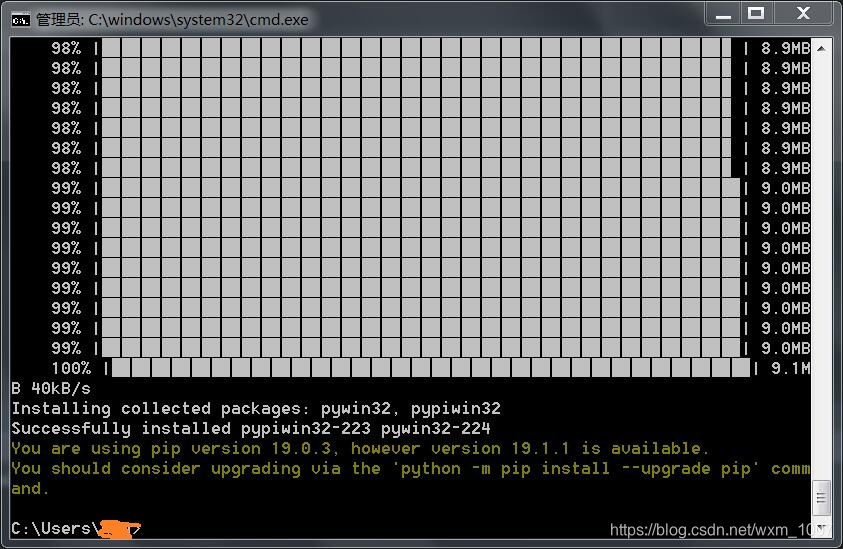

解决方法:cmd打开命令行,输入pip install pypiwin32安装pypiwin32,如下图则为安装成功

然后再在终端输入scrapy crawl weibo

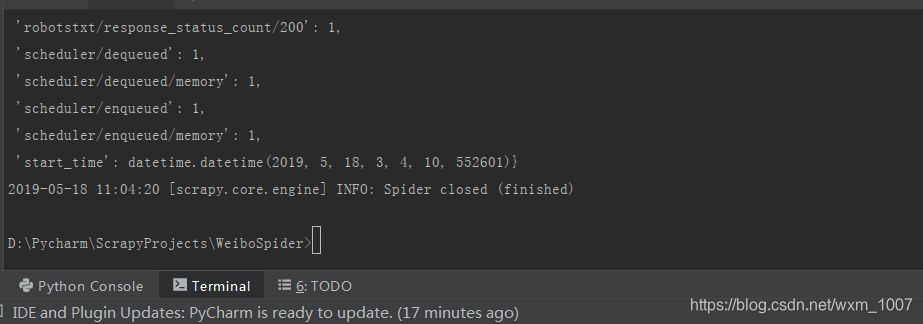

最后显示结果如下图:

借鉴了此篇博客写的https://blog.youkuaiyun.com/dayun555/article/details/79415782

以上仅为个人操作编辑

菜鸟一枚,写下来以备不时之需。

文档还不够完整,后续更新

Scrapy创建第一个爬虫项目

最新推荐文章于 2025-04-04 04:18:51 发布

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?