深入理解循环神经网络(RNN)及其变体LSTM

在自然语言处理(NLP)和时间序列分析等领域,循环神经网络(RNN)因其能够处理序列数据而受到广泛关注。本文将通过一系列图解,详细介绍RNN的基本概念、存在的问题以及其改进版本——长短期记忆网络(LSTM)。

RNN的基本概念

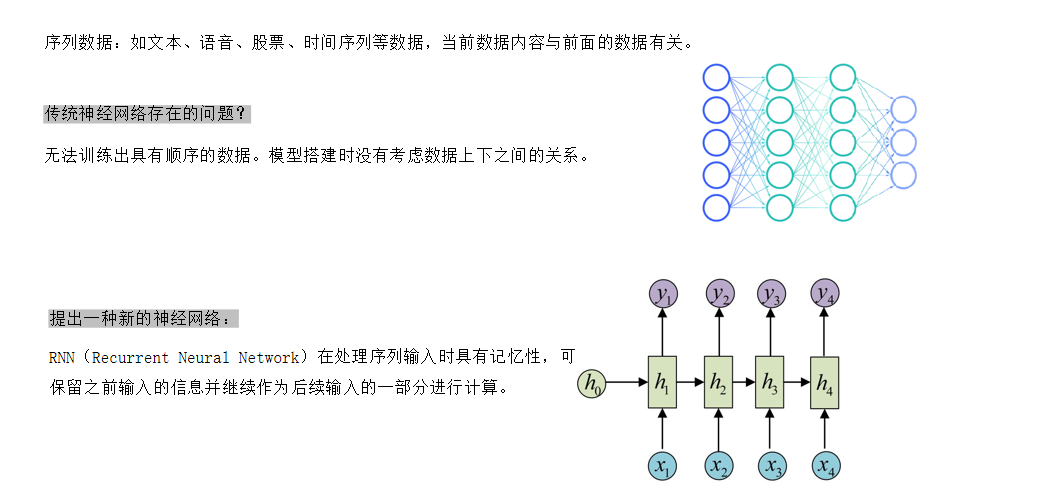

RNN是一种特殊的神经网络,它能够处理序列输入,并具有记忆功能。与传统的神经网络不同,RNN在处理序列数据时,能够考虑数据上下文之间的关系。这种特性使得RNN在处理文本、语音、股票和时间序列等数据时表现出色。

序列数据的处理

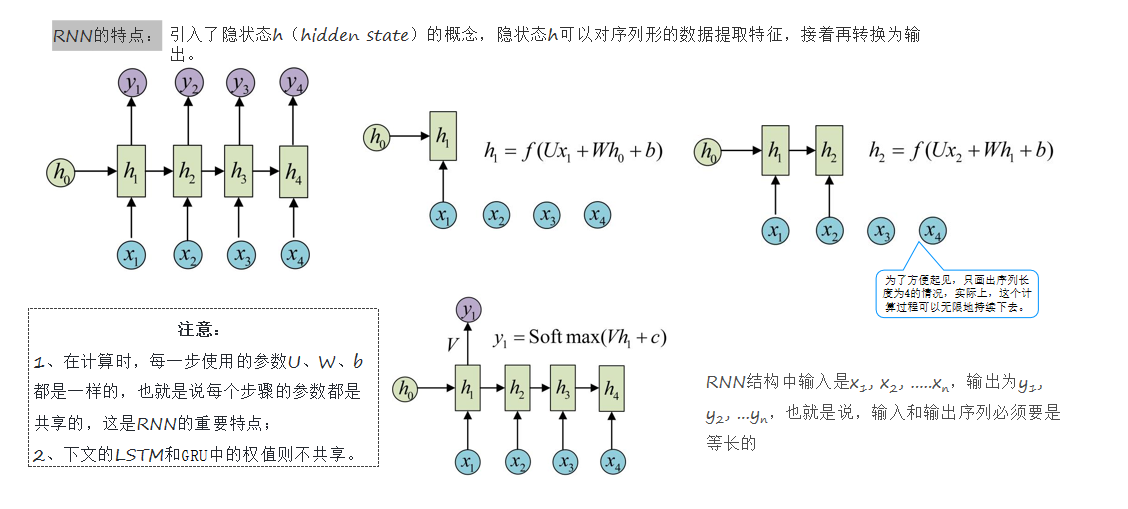

序列数据是指数据之间存在前后顺序关系的数据类型,如文本、语音、股票和时间序列等。在这些数据中,当前数据内容与前面的数据有关。RNN通过引入隐状态(hidden state)的概念,能够对序列形的数据提取特征,接着再转换为输出。

RNN的结构

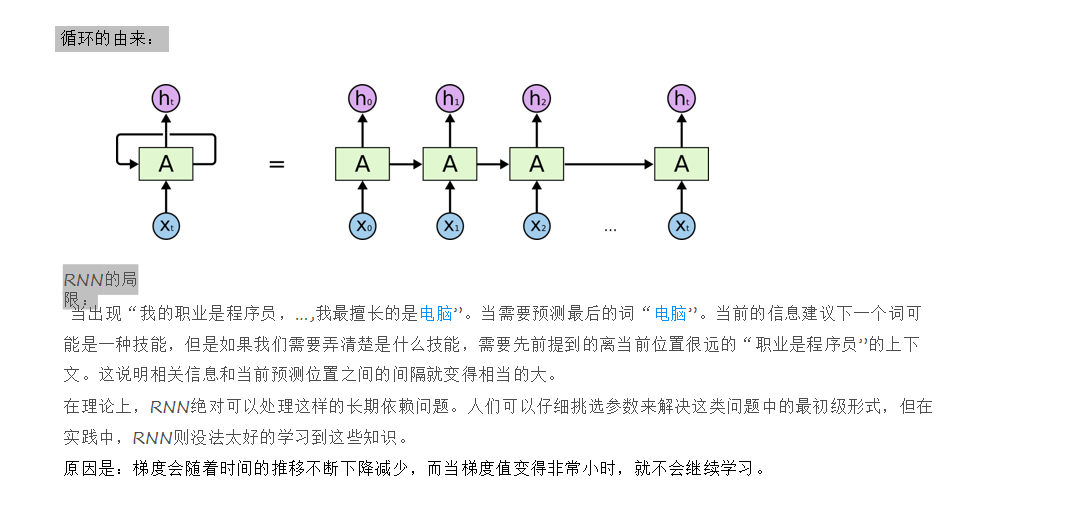

RNN的结构中,输入是序列数据,输出也是序列数据。在每一步计算中,每一步使用的参数(U、W、b)都是共享的。这意味着RNN在处理序列数据时,能够将之前输入的信息保留下来,并继续作为后续输入的一部分进行计算。

RNN存在的问题

尽管RNN在处理序列数据时具有优势,但它也存在一些问题。主要问题是无法训练出具有长序列的数据。这是因为在模型搭建时没有考虑数据上下之间的关系,导致梯度会随着时间的推移不断下降减少,当梯度值变得非常小时,就不会继续学习。

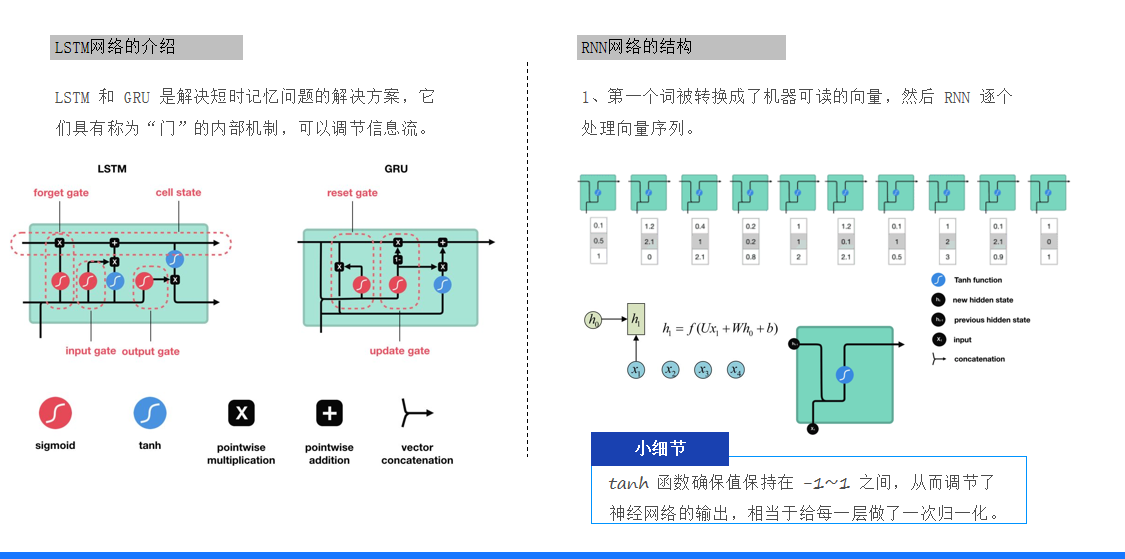

LSTM网络

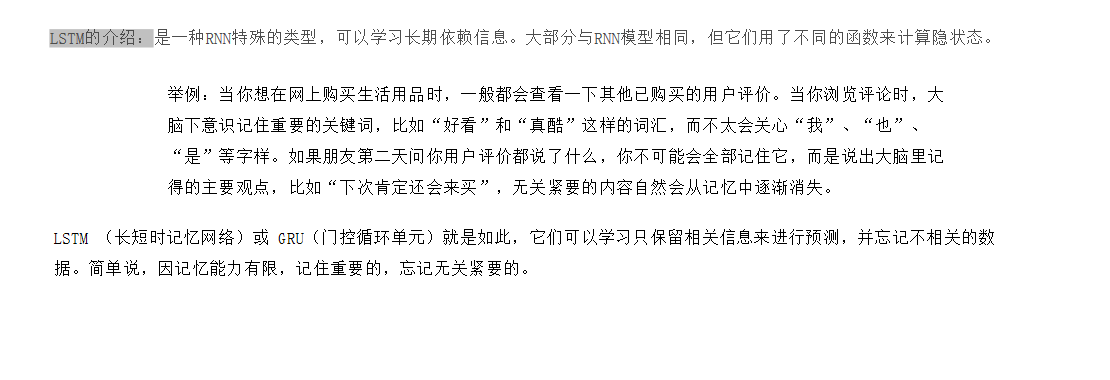

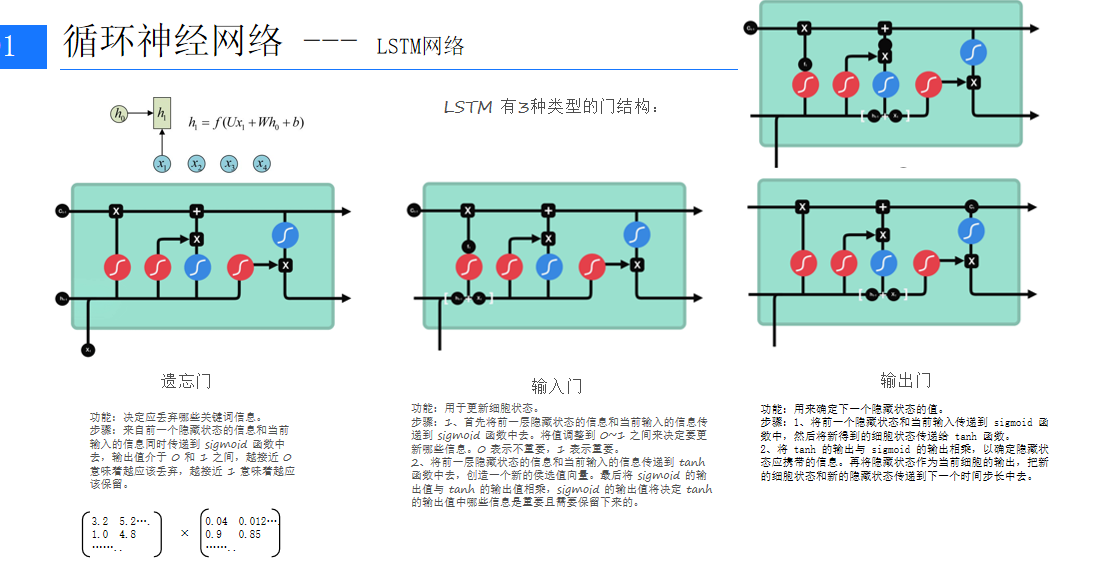

为了解决RNN的短时记忆问题,LSTM(长短期记忆网络)被提出。LSTM是一种RNN特殊的类型,它可以学习长期依赖信息。LSTM通过引入门控机制(包括遗忘门、输入门和输出门)来控制信息的流动,从而解决了RNN的短时记忆问题。

LSTM的结构

LSTM网络的结构包括三个门:遗忘门、输入门和输出门。这些门通过sigmoid和tanh函数来控制信息的流动。遗忘门决定哪些信息应该丢弃,输入门决定哪些新信息应该添加到细胞状态中,输出门决定输出哪些信息。

LSTM的优势

LSTM的优势在于它能够记住重要的信息,并忘记无关紧要的数据。这种特性使得LSTM在处理长序列数据时表现出色。例如,当你想在网上购买生活用品时,你可能会查看其他已购买的用户评价。在浏览评论时,你的大脑会下意识记住重要的关键词,而不太关心“我”、“也”、“是”等字样。LSTM正是利用这种机制来学习并预测序列数据。

总结

RNN和LSTM在处理序列数据时具有独特的优势,但它们也存在一些局限性。RNN在处理长序列数据时容易遇到梯度消失的问题,而LSTM通过引入门控机制有效地解决了这一问题。在实际应用中,我们可以根据具体需求选择合适的模型,并对其进行优化和调整,以获得更好的性能。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?