Sqoop报错ERROR tool.ExportTool: Error during export)

第一步:完整的检查mysql和hive表的结构(字段名称和数据类型)是否一致,以及字段的长度:

比如:

1、字段名称

比如mysql的字段cname

hive字段的name,字段不一致就会有问题

2、字段类型

mysql

double 字段类型

hive的string导出时如果有格式问题就报错

3.字段的长度,因为hive使用concat的情况也有,会使值的长度很长,如果较长,就会保存,如:

hive的string

对应mysql的text比较好

第二步:查看时间问题?可以将mysql和hive中的时间类型都改成string或varchar类型试一下。如果有导入,但是导入的数据不全或者不对。说明肯定是你的数据类型和实际的数据不一致。

如mysql的timestamp

hive 的时间为string

第三步:null值的处理

--input-null-string '\\N' \

--input-null-non-string '\\N' \

第四步:查看分隔符是否跟建表的分隔符一致

--input-fields-terminated-by '\t' \

mysl表的编码与问题

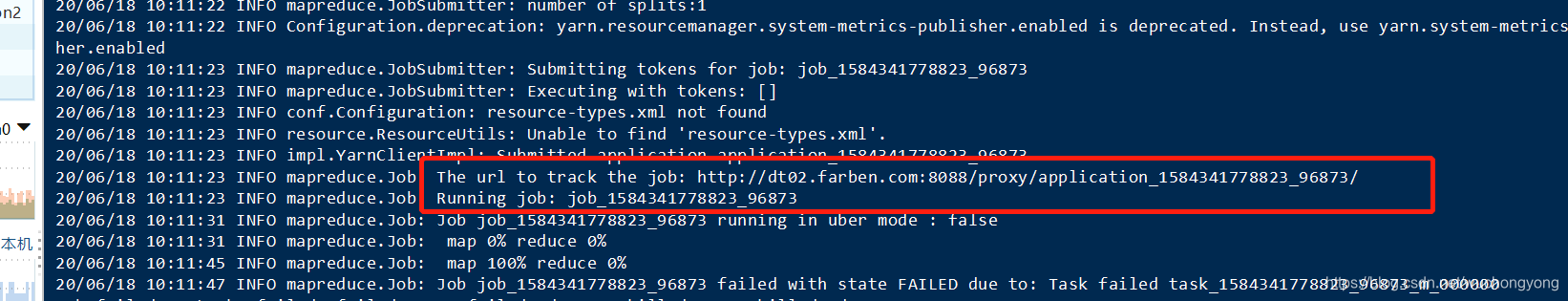

看job的任务

复制控制台的任务链接

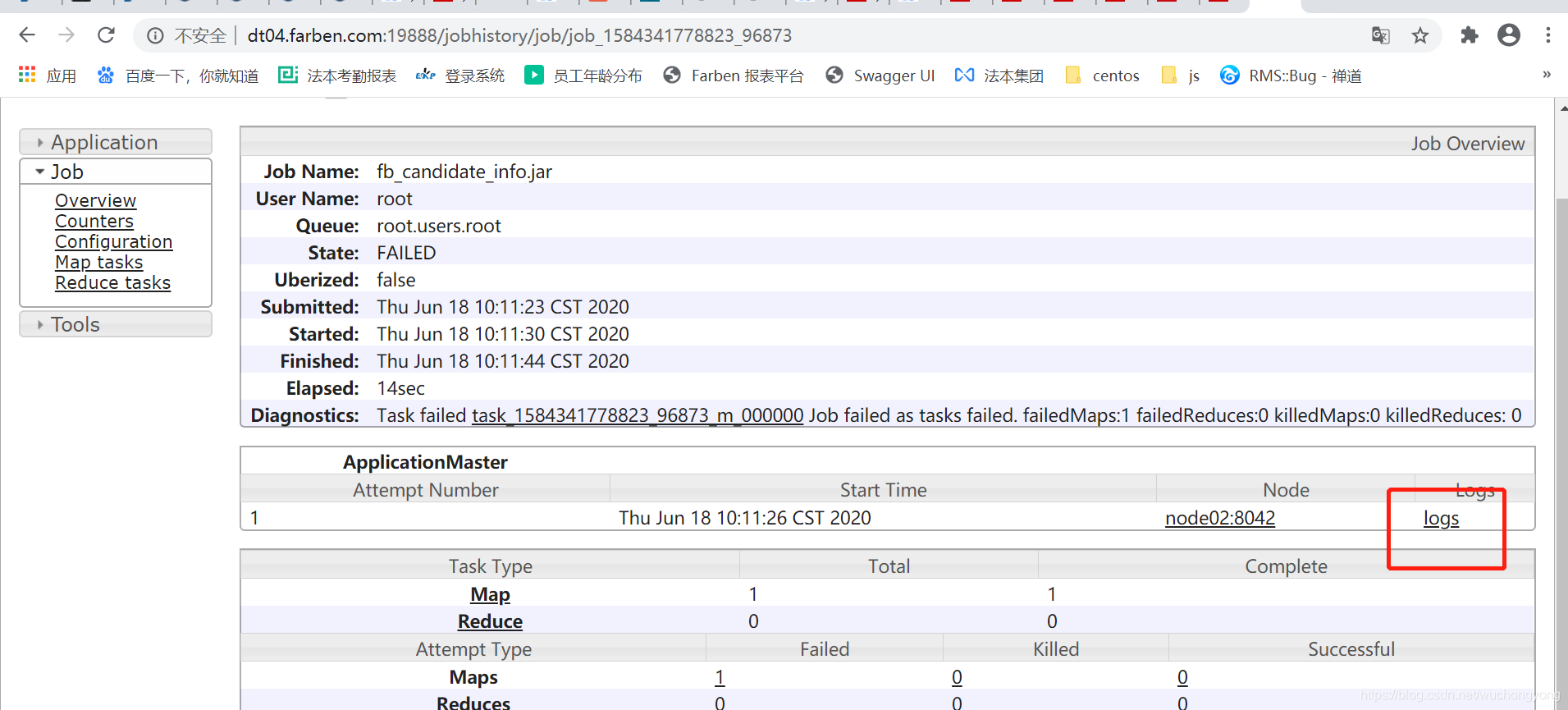

找页面上找到logs

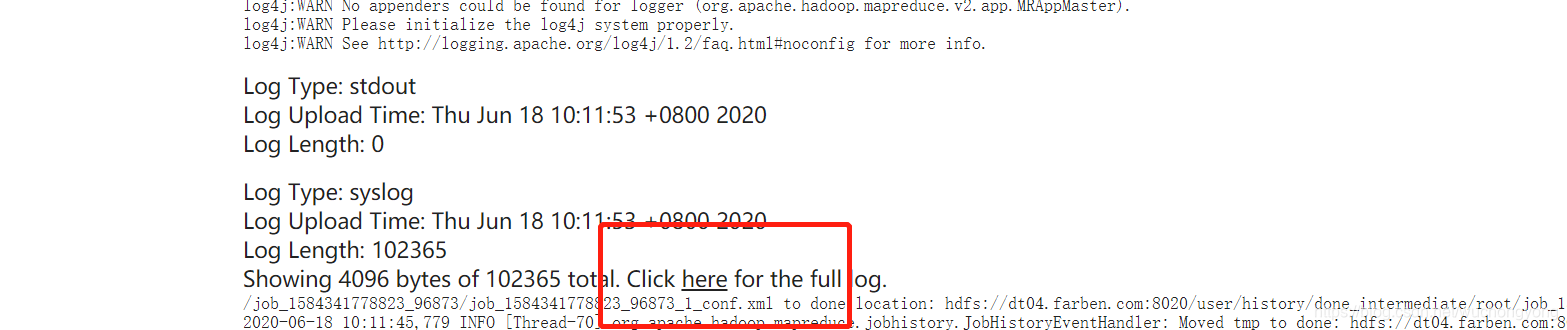

查看更多的日志

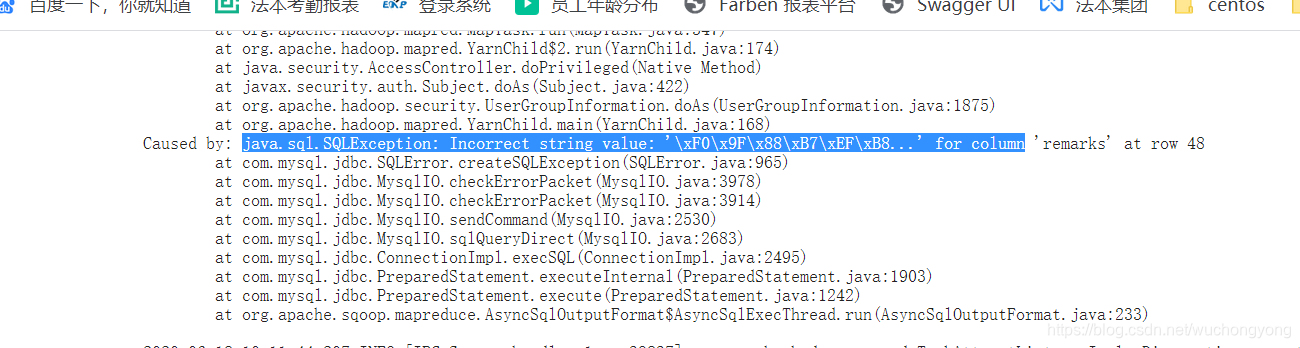

异常详细信息

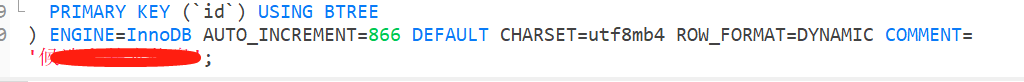

将表编码设置为utf8mb4

若需还原展示该字段,则建议此种方式。

导出脚本示例

sqoop export \

--connect "jdbc:mysql://xxxx:3306/xxx?useUnicode=true&characterEncoding=UTF-8&useSSL=false&serverTimezone=Asia/Shanghai" \

--username xxx \

--password xxx \

--input-null-string '\\N' \

--input-null-non-string '\\N' \

--input-fields-terminated-by '\t' \

--table fb_candidate_info \

--columns "resume_id, dept_id, dept_name, login_name, rule_id, group_name, cname, channel_source, specific_time, name, phone, e_mail, expect_salary, sex, education, graduation_date, graduation_school, major, order_status, remarks, demand_name, customer_name, customer_job_name, filtrate_status, filtrate_remakes, interview_date, attendance_status, attendance_remarks, interview_status, interview_remarks, offer_status, offer_remarks, initiate_status, entry_status, entry_date, entry_remarks, entry_info, creator, create_time, modify_by, modify_time, creator_name, modify_name" \

--hcatalog-database fb_data_report \

--hcatalog-table ads_fb_candidate_info \

-m 1;

本文提供了一套全面的解决方案,用于解决在使用Sqoop将数据从Hive导出到MySQL时遇到的各种常见错误。文章详细介绍了如何检查和调整数据表结构、字段类型、字段长度、时间格式、NULL值处理以及分隔符设置,以确保数据的顺利迁移。

本文提供了一套全面的解决方案,用于解决在使用Sqoop将数据从Hive导出到MySQL时遇到的各种常见错误。文章详细介绍了如何检查和调整数据表结构、字段类型、字段长度、时间格式、NULL值处理以及分隔符设置,以确保数据的顺利迁移。

3366

3366

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?