1.URL 和 URI

URI全称为 Uniform Resource Identifier,即统一资源标志符,URL全称为 Uniform Resource Locator,即统一资源定位符。

举一个栗子,https://github.com/favicon.ico 是github 的网站图标链接,它既是一个URL又是一个URI。他的意思是有一个这样的图标资源,我们用URL/URI来唯一指定了他的访问方式,这其中包含了访问协议HTTPS,访问路径(即根目录)还有资源名称favicon.ico。通过这个链接,我们便可以从网上找到这个资源,这就是URL/URI。

URL是URI的真子集,也就是说每个URL都是URI,但不是每个URI都是URL。因为URI里还包括。URN,URN全称 Universal Resource Name,即统一资源名称。URN只命名资源但是不会指定如何定位资源。在现在的互联网中URN用的非常少,几乎所有的URI都是URL。通常情况下URI强调的是给资源标记命名,URL强调的是给资源定位。下图是URL,URI和URN的关系图。

2.HTTP和HTTPS

web页面的URL开头往往会有http或https,如https://www.baidu.com/index.php?tn=monline_3_dg,这是访问资源所需要的协议类型。有时我们能看到ftp、sftp、smb开头的URL,这些都是协议类型。爬虫中爬取得页面通常就是http和https协议的。

HTTP全称HyperText Transfer Protocol,即超文本传输协议。HTTP协议用于从网络传输超文本数据到本地浏览器的传输协议。它能够保证准确高效的传输超文本文档。HTTP默认端口号为80,但是你也可以改为8080或者其他端口

HTTP三点注意事项:

- HTTP是无连接:无连接的含义是限制每次连接只处理一个请求。服务器处理完客户的请求,并收到客户的应答后,即断开连接。采用这种方式可以节省传输时间。

- HTTP是媒体独立的:这意味着,只要客户端和服务器知道如何处理的数据内容,任何类型的数据都可以通过HTTP发送。客户端以及服务器指定使用适合的MIME-type内容类型。

- HTTP是无状态:HTTP协议是无状态协议。无状态是指协议对于事务处理没有记忆能力。缺少状态意味着如果后续处理需要前面的信息,则它必须重传,这样可能导致每次连接传送的数据量增大。另一方面,在服务器不需要先前信息时它的应答就较快。

HTTPS全称 Hyper Text Transfer Protocol over Secure Socket Layer,即超文本传输安全协议。是以安全为目的的HTTP通道,HTTPS是身披SSL外壳的HTTP,即在HTTP上加入了SSL层。(如今的SSL已经由TLS代替,但是后者通常还是使用SSL这个名称)https的安全基础是SSL,因此通过他传输的内容都是通过SSL加密的,它的主要作用分两种。

- 建立一个信息安全通道来保证数据传输的安全

- 确认网站的真实性,凡是用了https的网站,都可以通过点击浏览器地址栏的锁头标志(如下图所示)

来查看网站认证之后的真实信息,也可以通过CA机构颁发的安全签章来查询。

来查看网站认证之后的真实信息,也可以通过CA机构颁发的安全签章来查询。

而某些网站虽然使用了https协议,但还是会被浏览器提示不安全。例如几年前我们我们使用谷歌浏览器里打开12306,链接为https://www.12306.cn/,浏览器会提示你的链接不是私密链接(现在已经不存在这种情况了)。这是因为12306的CA证书是中国铁道部自行签发的,但这个证书不被CA机构认证的。

HTTP请求过程

当我们在浏览器的地址栏中输入: www.baidu.com,然后回车,这个过程中到底发生了什么?

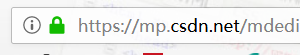

1.域名解析

过程概览

1.对www.baidu.com这个网址进行DNS域名解析,得到对应的IP地址

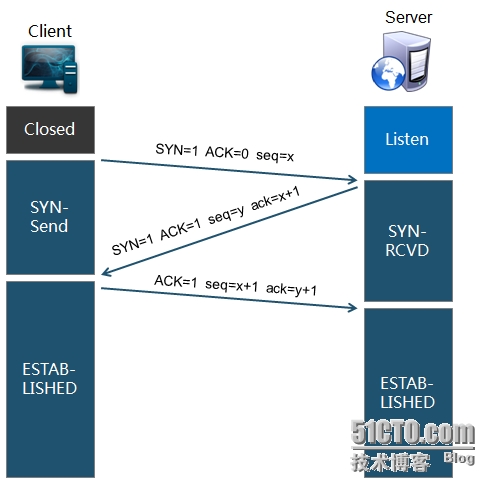

2.根据这个IP,找到对应的服务器,发起TCP的三次握手

3.建立TCP连接后发起HTTP请求

4.服务器响应HTTP请求,浏览器得到html代码

5.浏览器解析html代码,并请求html代码中的资源(如js、css图片等)(先得到html代码,才能去找这些资源)

6.浏览器对页面进行渲染呈现给用户

注:

1. DNS域名解析采用的是递归查询的方式,过程是,先去找DNS缓存->缓存找不到就去找根域名服务器->根域名又会去找下一级,这样递归查找之后,找到了,给我们的web浏览器

-

为什么HTTP协议要基于TCP来实现? TCP是一个端到端的可靠的面相连接的协议,HTTP基于传输层TCP协议不用担心数据传输的各种问题(当发生错误时,会重传)

-

最后一步浏览器是如何对页面进行渲染的? a)解析html文件构成 DOM树,b)解析CSS文件构成渲染树, c)边解析,边渲染 , d)JS 单线程运行,JS有可能修改DOM结构,意味着JS执行完成前,后续所有资源的下载是没有必要的,所以JS是单线程,会阻塞后续资源下载

DNS优化:两个方面:DNS缓存、DNS负载均衡

DNS优化:两个方面:DNS缓存、DNS负载均衡

2.TCP连接(三次握手)

拿到域名对应的IP地址之后,User-Agent(一般指浏览器)会以一个随机端口(1024<端口<65535)向服务器的WEB程序(常用的有httpd,nginx)等的80端口。这个连接请求(原始的http请求经过TCP/IP4层模型的层层封包)到达服务器端后(这中间有各种路由设备,局域网内除外),进入到网卡,然后是进入到内核的TCP/IP协议栈(用于识别连接请求,解封包,一层一层的剥开),还有可能要经过Netfilter防火墙(属于内核的模块)的过滤,最终达到WEB程序,最终建立了TCP/IP的连接

图解:

3.建立TCP连接之后,发起HTTP请求

3.建立TCP连接之后,发起HTTP请求

HTTP请求报文由三部分组成:请求行,请求头和请求正文

请求行:用于描述客户端的请求方式,请求的资源名称以及使用的HTTP协议的版本号(例:GET/books/java.html HTTP/1.1)

请求头:用于描述客户端请求哪台主机,以及客户端的一些环境信息等

注:这里提一个请求头 Connection,Connection设置为 keep-alive用于说明 客户端这边设置的是,本次HTTP请求之后并不需要关闭TCP连接,这样可以使下次HTTP请求使用相同的TCP通道,节省TCP建立连接的时间

请求正文:当使用POST, PUT等方法时,通常需要客户端向服务器传递数据。这些数据就储存在请求正文中(GET方式是保存在url地址后面,不会放到这里)

4.服务器端响应http请求,浏览器得到html代码

HTTP响应也由三部分组成:状态码,响应头和实体内容

状态码:状态码用于表示服务器对请求的处理结果

列举几种常见的:200(没有问题) 302(要你去找别人) 304(要你去拿缓存) 307(要你去拿缓存) 403(有这个资源,但是没有访问权限) 404(服务器没有这个资源) 500(服务器这边有问题)

若干响应头:响应头用于描述服务器的基本信息,以及客户端如何处理数据

实体内容:服务器返回给客户端的数据

注:html资源文件应该不是通过 HTTP响应直接返回去的,应该是通过nginx通过io操作去拿到的吧

5.浏览器解析html代码,并请求html代码中的资源

浏览器拿到html文件后,就开始解析其中的html代码,遇到js/css/image等静态资源时,就向服务器端去请求下载(会使用多线程下载,每个浏览器的线程数不一样),这是时候就用上 keep-alive特性了,建立一次HTTP连接,可以请求多个资源,下载资源的顺序就是按照代码里面的顺序,但是由于每个资源大小不一样,而浏览器又是多线程请求请求资源,所以这里显示的顺序并不一定是代码里面的顺序。

6.浏览器对页面进行渲染呈现给用户

最后,浏览器利用自己内部的工作机制,把请求的静态资源和html代码进行渲染,渲染之后呈现给用户

浏览器是一个边解析边渲染的过程。首先浏览器解析HTML文件构建DOM树,然后解析CSS文件构建渲染树,等到渲染树构建完成后,浏览器开始布局渲染树并将其绘制到屏幕上。这个过程比较复杂,涉及到两个概念: reflow(回流)和repain(重绘)。DOM节点中的各个元素都是以盒模型的形式存在,这些都需要浏览器去计算其位置和大小等,这个过程称为relow;当盒模型的位置,大小以及其他属性,如颜色,字体,等确定下来之后,浏览器便开始绘制内容,这个过程称为repain。页面在首次加载时必然会经历reflow和repain。reflow和repain过程是非常消耗性能的,尤其是在移动设备上,它会破坏用户体验,有时会造成页面卡顿。所以我们应该尽可能少的减少reflow和repain。

JS的解析是由浏览器中的JS解析引擎完成的。JS是单线程运行,JS有可能修改DOM结构,意味着JS执行完成前,后续所有资源的下载是没有必要的,所以JS是单线程,会阻塞后续资源下载。

接下来我们就对实例进行解析。

在火狐浏览器中打开百度页面按下f12调出开发者工具,刷新页面后得到一些结果

- 文件列下显示请求的名称,一般会将URL的最后一部分内容当做名称。

- 域名列下显示HTTP请求过程中访问过的URL地址。

- 触发源头列下是文档的类型。这里为document,代表我们这一次的请求是一个HTML文档,内容就是一些HTML代码。

- 方法列下是请求的方法。这里为GET型

在旁边的小窗口中可以看到更详细的内容

接下来我们对图片下半部分的请求头和响应头进行讲解

接下来我们对图片下半部分的请求头和响应头进行讲解

请求

请求,由客户端向服务端可分为四个部分:请求方法、请求的网址、请求头和请求体。

请求方法

常见的请求方法有两种:GET和POST。

在浏览器中直接输入URL并按下回车,这便发起了一个GET请求。例如在百度中搜索python,这是一个GET请求,链接为https://www.baidu.com/s?wd=python,其URL中包括了请求的参数信息,参数wd要搜寻的关键字。POST请求大多数在提交时发起。如,对与一个登入表单,你输入账号密码后按下登入按钮,通常会发起一个POST请求,其数据往往以表单形式传输,并不会提现在URL中。

GET和POST请求方法有如下区别

- 个体请求中的参数包含在URL中,数据可在URL中看到,而POST请求的URL不会包含这些数据,数据都是通过表单形式传输的,会包含在请求体中。

- GET请求提交的数据最多只有1024个字节,而POST方式没有限制。故上传文件都为POST方式。

请求的网址

即统一资源定位符URL,他可以唯一确定我们想请求的资源。

请求头

请求头,用于服务器要使用的附加信息,比较重要的信息有cookie,referer,user-agent等。

Accept:请求报头域.,用于指定客户端可接受哪些类型的信息。

Accept-Language:指定客户端可接受的语言类型。

Accept-Encoding:指定客户端可接受的内容编码。

Host:用于指定请求资源的主机ip和端口号内容为请求URL的原始服务器或网关位置。

Cookie:Cookie是用来存储一些用户信息以便让服务器辨别用户身份的(大多数需要登录的网站上面会比较常见),比如cookie会存储一些用户的用户名和密码,当用户登录后就会在客户端产生一个cookie来存储相关信息,这样浏览器通过读取cookie的信息去服务器上验证并通过后会判定你是合法用户,从而允许查看相应网页。当然cookie里面的数据不仅仅是上述范围,还有很多信息可以存储是cookie里面,比如sessionid等。

Referer:表示浏览器所访问的前一个页面,可以认为是之前访问页面的链接将浏览器带到了当前页面。服务器可以拿到这一信息并作出相应的处理。可以用来做源统计和防盗链接处理等。Referer其实是Referrer这个单词,但RFC制作标准时给拼错了,后来也就将错就错使用Referer了。

User-Agent:简称UA,是一个特殊的字符串头,告诉HTTP服务器, 客户端使用的操作系统和浏览器的名称和版本。

Content:客户端(浏览器)想要优先使用的连接类型

例如: Connection: keep-alive 当一个网页打开完成后,客户端和服务器之间用于传输HTTP数据的TCP连接不会关闭,如果客户端再次访问这个服务器上的网页,会继续使用这一条已经建立的连接

例如: Connection: close 代表一个Request完成后,客户端和服务器之间用于传输HTTP数据的TCP连接会关闭, 当客户端再次发送Request,需要重新建立TCP连接。

请求体

请求体一般承载的内容是POST请求中的表单数据,GTT请求的请求体为空。

响应

响应,由服务器返回给客户端,可以分为三部分:响应状态码,响应头,响应体。

响应状态码:表示服务器的响应状态。

响应头:

请求体:

请求体:

最重要的当属响应体内容了。响应的数据都在响应体中。如请求网页时他的响应体就是网页的HTML代码,请求一张图片时他的响应体就是图片的二进制数据。

参考博客:

http://www.cnblogs.com/engeng/articles/5959335.html

http://www.cnblogs.com/engeng/articles/5943382.html

https://www.cnblogs.com/xuzekun/p/7527736.html

参考书籍:

python3网络爬虫开发实战

HTTP权威指南

本文深入解析HTTP与HTTPS协议的区别,包括URL与URI的概念,HTTP的无连接、媒体独立与无状态特性,HTTPS的安全机制,以及HTTP请求与响应的全过程。

本文深入解析HTTP与HTTPS协议的区别,包括URL与URI的概念,HTTP的无连接、媒体独立与无状态特性,HTTPS的安全机制,以及HTTP请求与响应的全过程。

1620

1620

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?