这里所讲的是windows环境下调试的初级教程

题目背景:

面对没有进行lumina的简单go语言逆向,都是sub函数无法看出输入输出点,只判断出print函数,不知道scanf,用动态调式

注:ida7.6版本以前的版本不支持go语言的逆向解析。lumina是ida提供的一种服务,由于大部分人用的都是ida破解版无法连接lumina,有的人用lemen(但这个需要经过手工配置)

所以,通过ida打开这个程序发现没有识别其中函数,只能用动静态相结合来测试

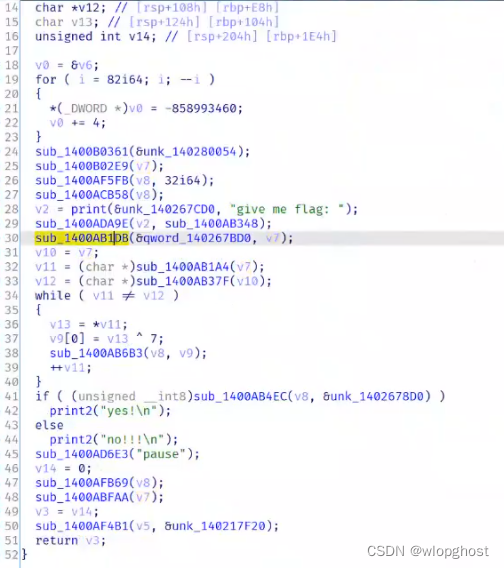

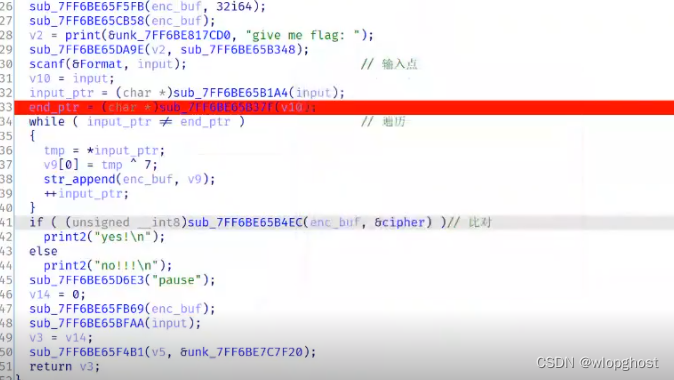

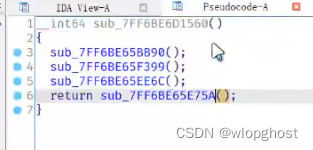

找到的主函数长这样

通过语句推断大概在黄标sub_1400AB1DB,用F2在该行下断点,选择localhost windows debugger运行

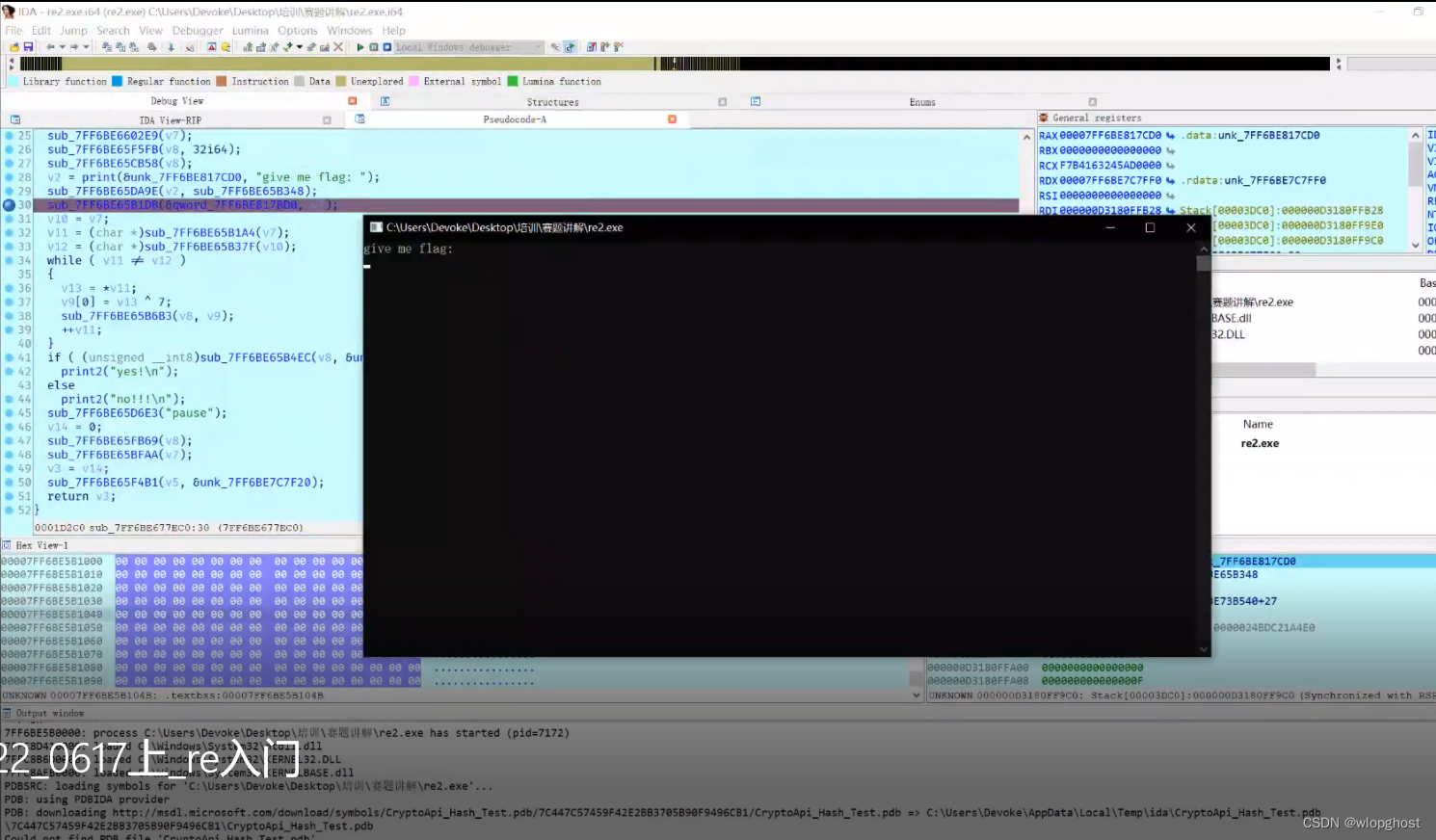

发现输入没有反应,推定黄标这句是scanf(如果还不行就在黄标下一行再设一个断点,原本的取消,运行时发现可以输入,就能确定是黄标这行),记住,推断完后用N键将函数重命名增强可视性,像下图

发现输入没有反应,推定黄标这句是scanf(如果还不行就在黄标下一行再设一个断点,原本的取消,运行时发现可以输入,就能确定是黄标这行),记住,推断完后用N键将函数重命名增强可视性,像下图

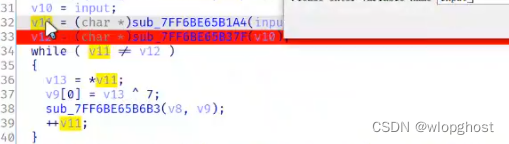

推断完上面来到下面,来到v11=sub_7ff6be65b1a4( )这行,由于不知道该函数作用是什莫,在此处下断点,运行后双击v11这个变量,跳转到内存地址栈中的数据界面(此处可以进行scanf操作了,我们假设输入的是a123123)

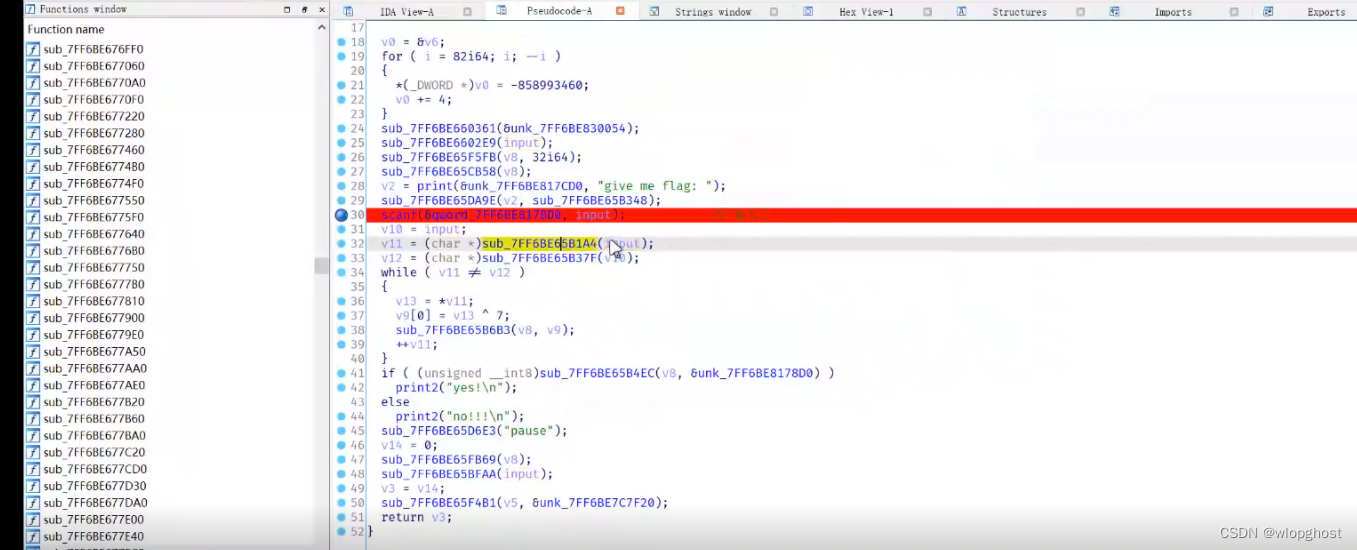

注意:动态调试时ida不会自动识别内存中的内存地址,所以双击v11进去后发现是一字节形式

如图:标注的栈上原本只是一个字节形式,然后按D转为两个字节形式,再按D转为四字节形式

按四下D转为八字节形式,最终看到自己输入的内容再栈中的体现

![]()

如果这个是个地址的话双击后就可以跳到数据形式界面,但这里双击后没有效果,结合我们输入的就是 a123123,所以保存的是数值

可见v11也是我们的输入,由于看到下面还有++v11的操作,可以判断v11是v4的指针,如下图

猜测v9是v11加密后的结果,因为肯定存在一个将新值保存下来的过程,将v9的结果添加到v8中存储,所以盲猜sub_7ff6be65b6b3是append函数,将v8重命名为enc_buf

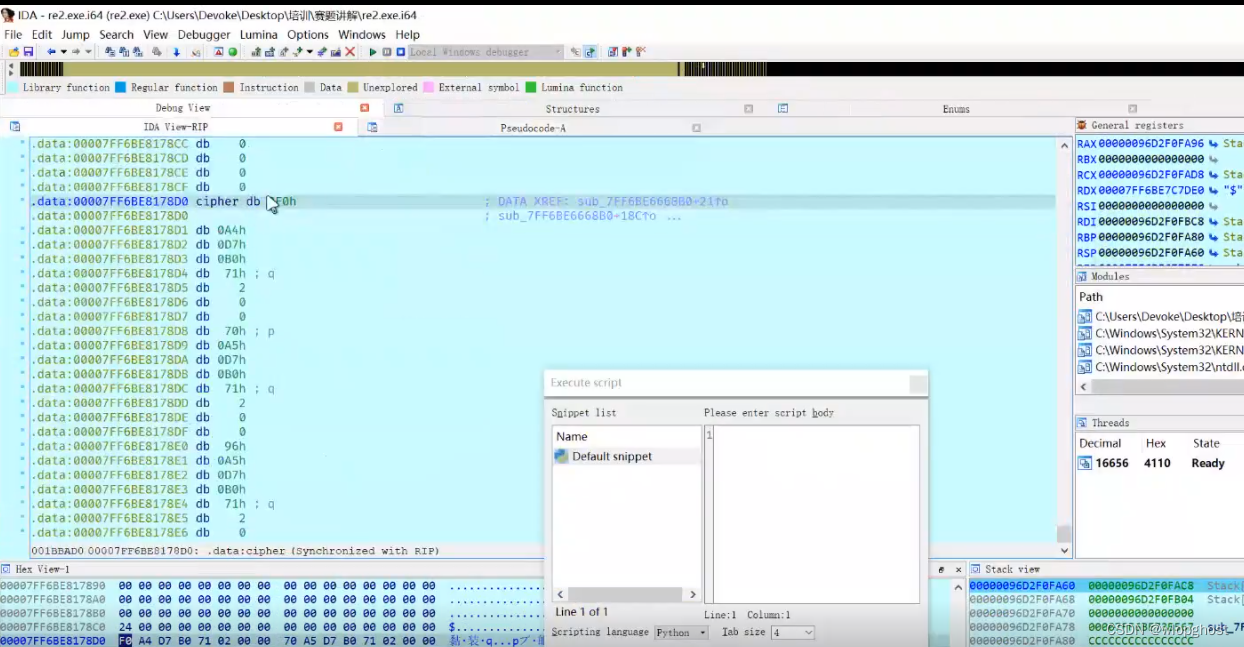

来到第41行,不难看出是与加密结果进行比对,enc_buf是是加密结果,则&cipher就肯定是给定的定值来进行比较的。

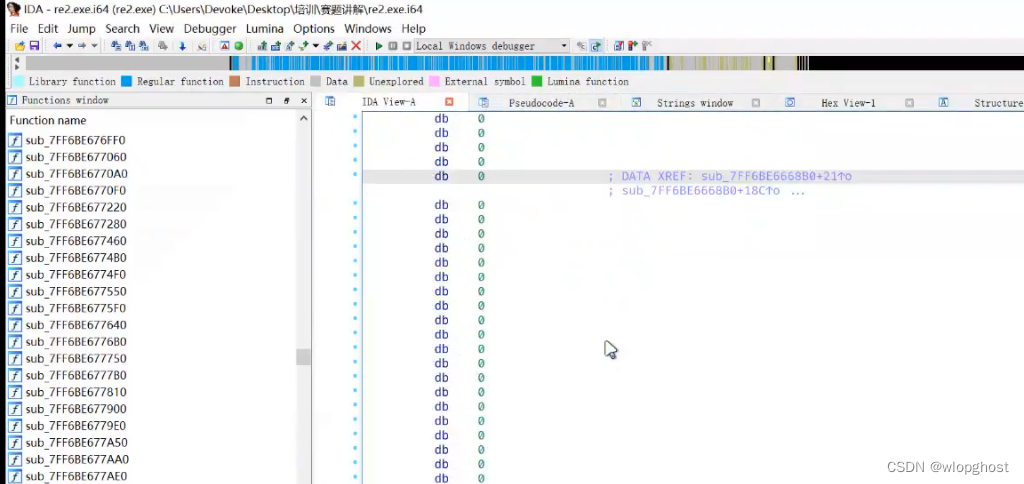

双击&cipher变量进入会发现其中的db是空的,这是因为C++的初始化并不是保存在段中,而是在函数运行后进行的初始化 ,如下图db内是空的

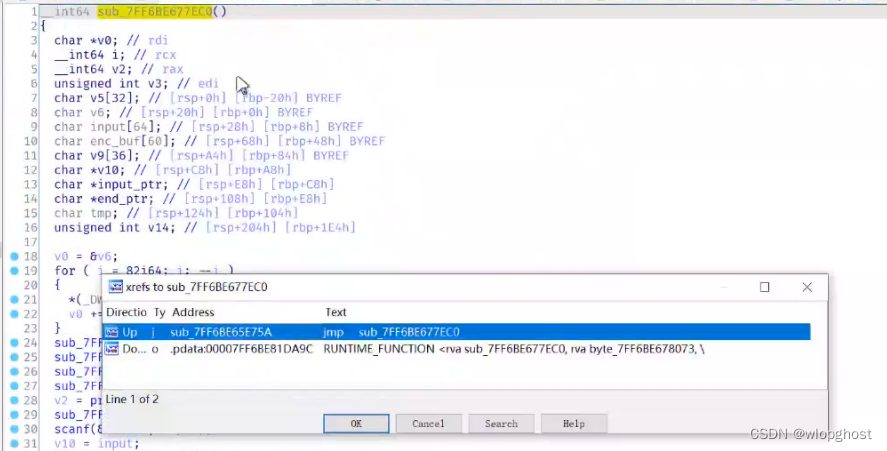

所以这个关键变量初始化的操作并不会出现在函数的入口点,(对函数sub_7ff6be677ec0这个函数(即主函数)进行交叉引用)

回到主函数点击函数名按x进行交叉引用

这个关键变量初始化的操作并不会出现在函数的入口点,而是出现在入口点很深的位置,如下图,在主函数的初始化前还初始化了一些配置函数与异常处理

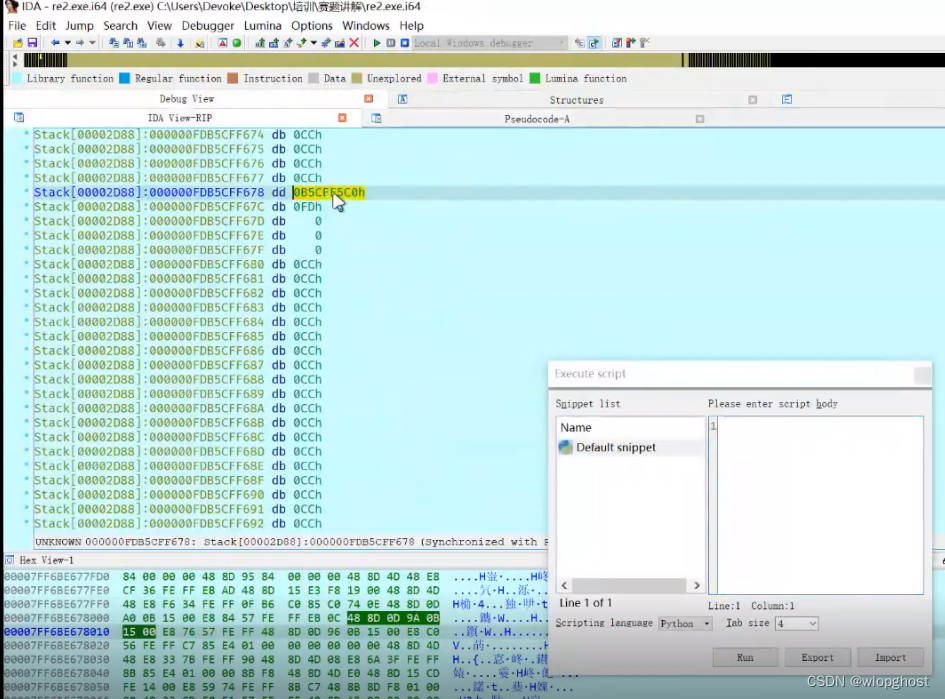

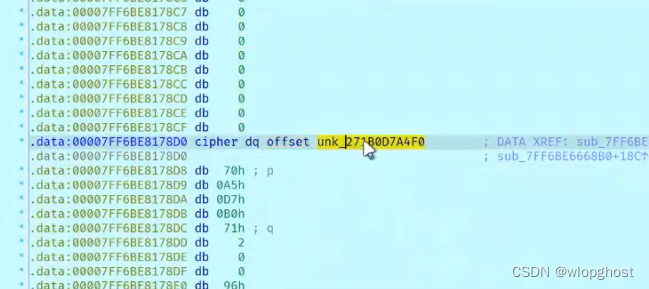

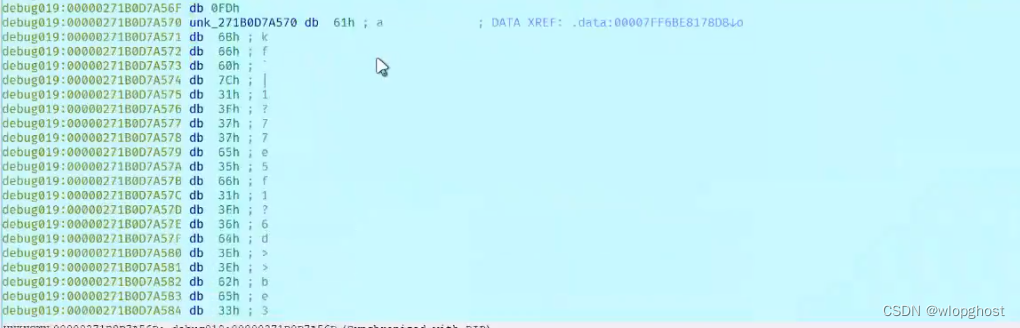

在该句下一个断点,运行到这里时cipher存在数值,

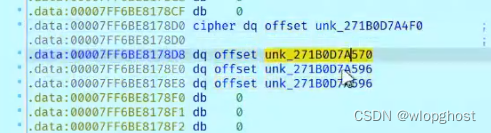

因为发现数据看不了,利用前面讲的,连按三下D,转化发现转成了四个地址

双击第一个地址,发现还是指向cipher函数,第二个地址如下

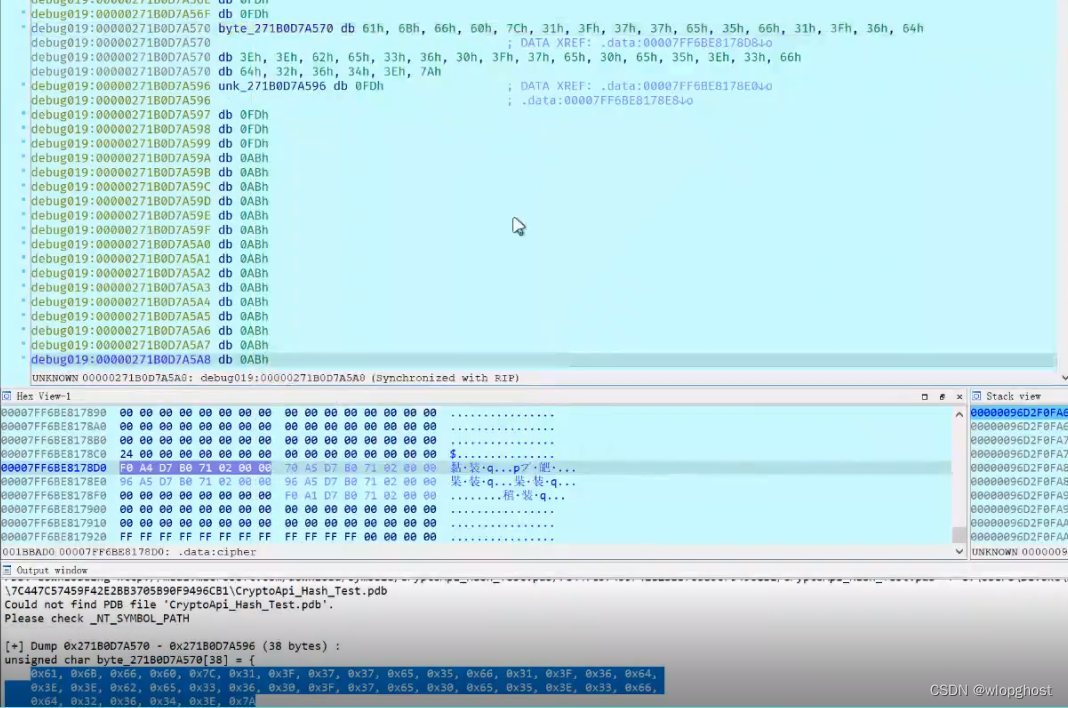

这里存储的数据一看就直到很有信息量,单击这个地址

用shift+8创建一个数组

长度数组创建器自动会算好,是38,创建完后右键该地址选择convert——>convert to C++array(byte)(转换成C++的字节数组形式)

得到数组后就可以开始写脚本了

就是用这个数组与7异或就可以了

本文介绍了在Windows下使用IDA进行Go语言程序的逆向工程,由于IDA对Go语言的支持有限,需要结合动态调试来识别函数和输入输出点。通过设置断点、分析内存栈以及转换数据类型,作者逐步揭示了程序的输入处理、加密过程以及关键变量的初始化方法。

本文介绍了在Windows下使用IDA进行Go语言程序的逆向工程,由于IDA对Go语言的支持有限,需要结合动态调试来识别函数和输入输出点。通过设置断点、分析内存栈以及转换数据类型,作者逐步揭示了程序的输入处理、加密过程以及关键变量的初始化方法。

6922

6922