Q1:为什么要本地部署DeepSeek?

2025年新春最大的科技新闻莫过于DeepSeek开源发布了其R1版本,凭借蒸馏后的“小模型”(相对于大模型参数量和训练算力需求而言)依旧可以有媲美OpenAI-O1-min的优秀表现。

如果说之前大模型虽然功能强大,但是其较高的部署与应用门槛依旧将普通人拒之门外,那么如今的DeepSeek的R1版本的各种蒸馏版本可以说直接让大模型“飞入寻常百姓家”。

为什么要尝试本地部署开源大模型,比如DeepSeek?因为使用本地模型(简写为Local Model,LM)拥有诸多优势:

- 完全离线运行,保护隐私数据安全

- 无需支付在线API费用

- 完全离线,服务稳定,无网络延迟

- 可以自由调整和定制模型参数(利于后续扩展业务应用)

本着上述考虑,利用春节假期难得闲暇,我们也来对DeepSeek尝尝鲜!

Q2:本地部署DeepSeek的简便方法

若想在本地部署我们自己的DeepSeek,我们需要两个工具:Ollama和ChatBox。

Ollama是一个开源的本地模型运行工具,可以方便地下载和运行各种开源模型,比如目前已经发布的Llama、Qwen以及DeepSeek等;而且Ollama支持Windows、MacOS以及Linux各种操作系统,十分方便。

ChatBox则是一款AI客户端应用和智能助手,支持众多先进的AI模型和API调用,同样可在Windows、MacOS、Linux等桌面系统上使用,难能可贵地是,ChatBox还提供IOS与Android等移动端和网页端使用。

我们的计划是使用Ollama下载运行大模型,使用ChatBox提供友好的用户图形交互界面(调用Ollama的API)。

21 | 安装Ollama大模型平台

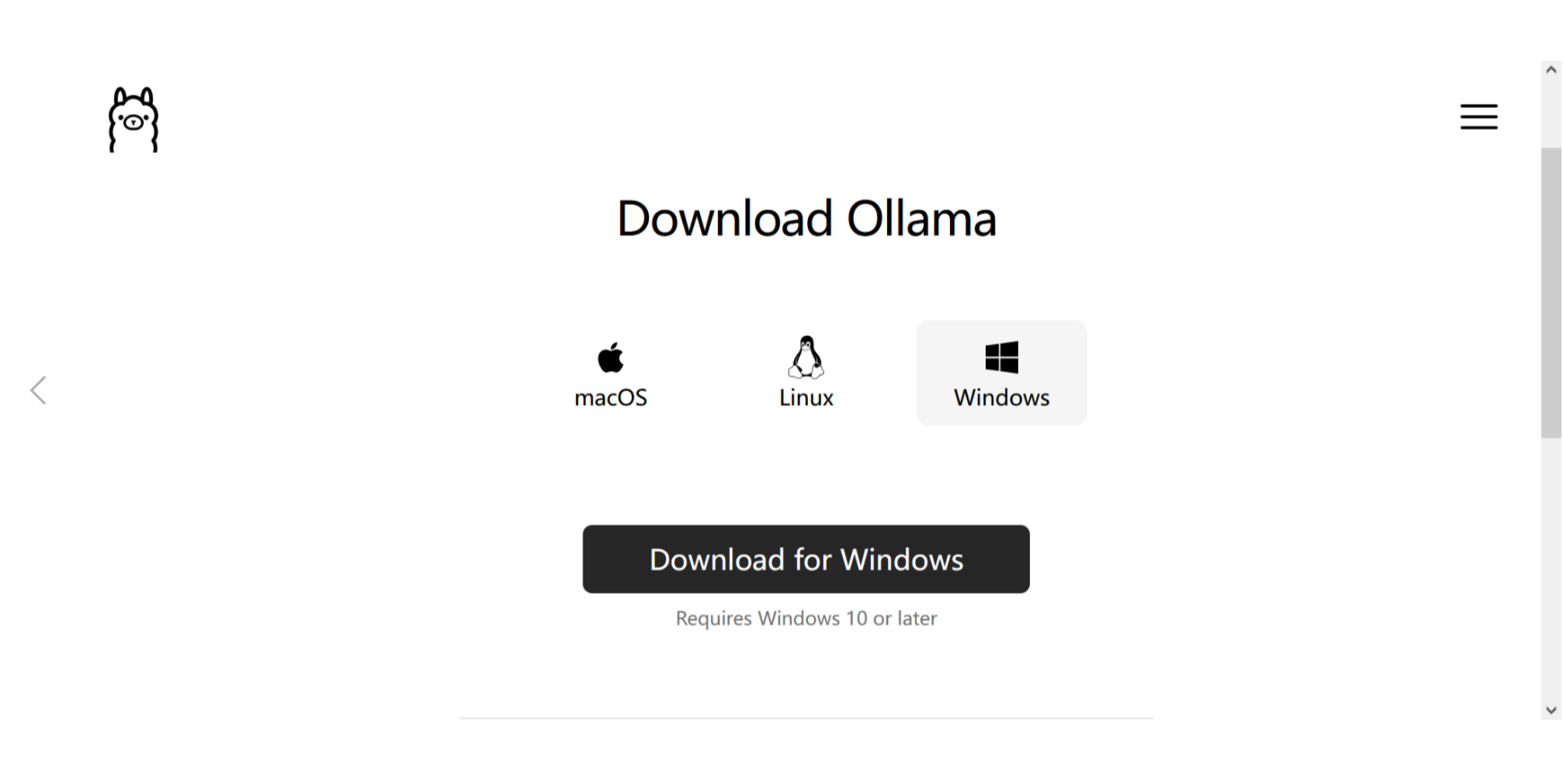

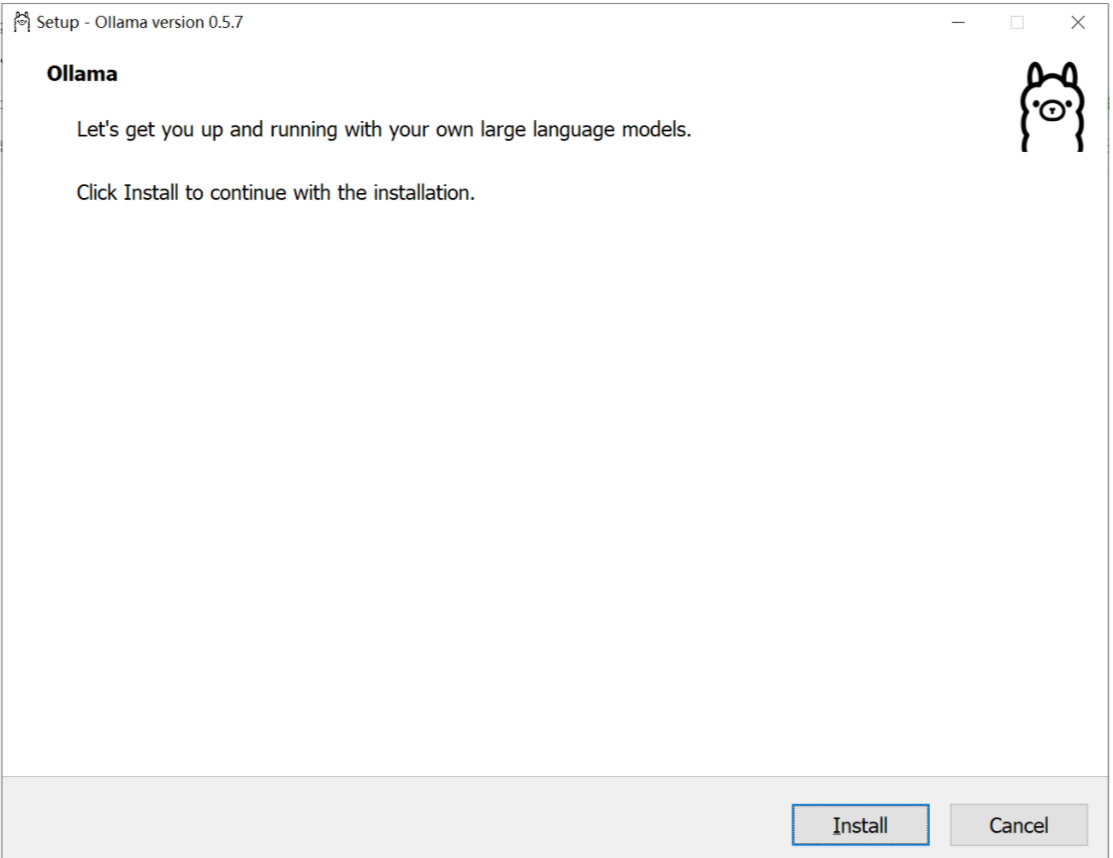

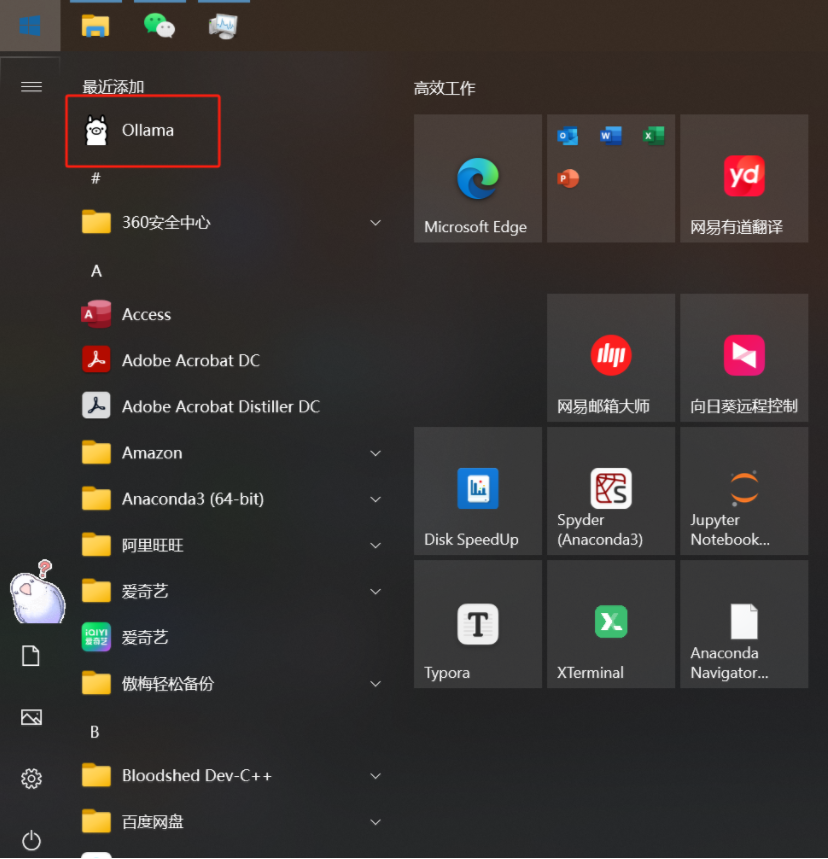

首先访问Ollama的官网(https://ollama.com/),选择自己系统对应的版本进行下载(OllamaSetup.exe),完成后点击安装(INSTALL)等待完成即可。安装完成后可以在Windows的“开始”菜单中发现“羊驼”图标,表示安装完成。

22 | 安装本地DeepSeek大模型

接下来首先点击上图中的“羊驼”图标,查看任务管理器或Windows系统右侧任务图标可以发现“羊驼”在运行。

注意Ollama需要在命令行中调用大模型安装与运行命令,因此可以打开Windows上的命令行界面(CMD或PowerShell均可,推荐PowerShell,因为命令更贴近Linux风格)

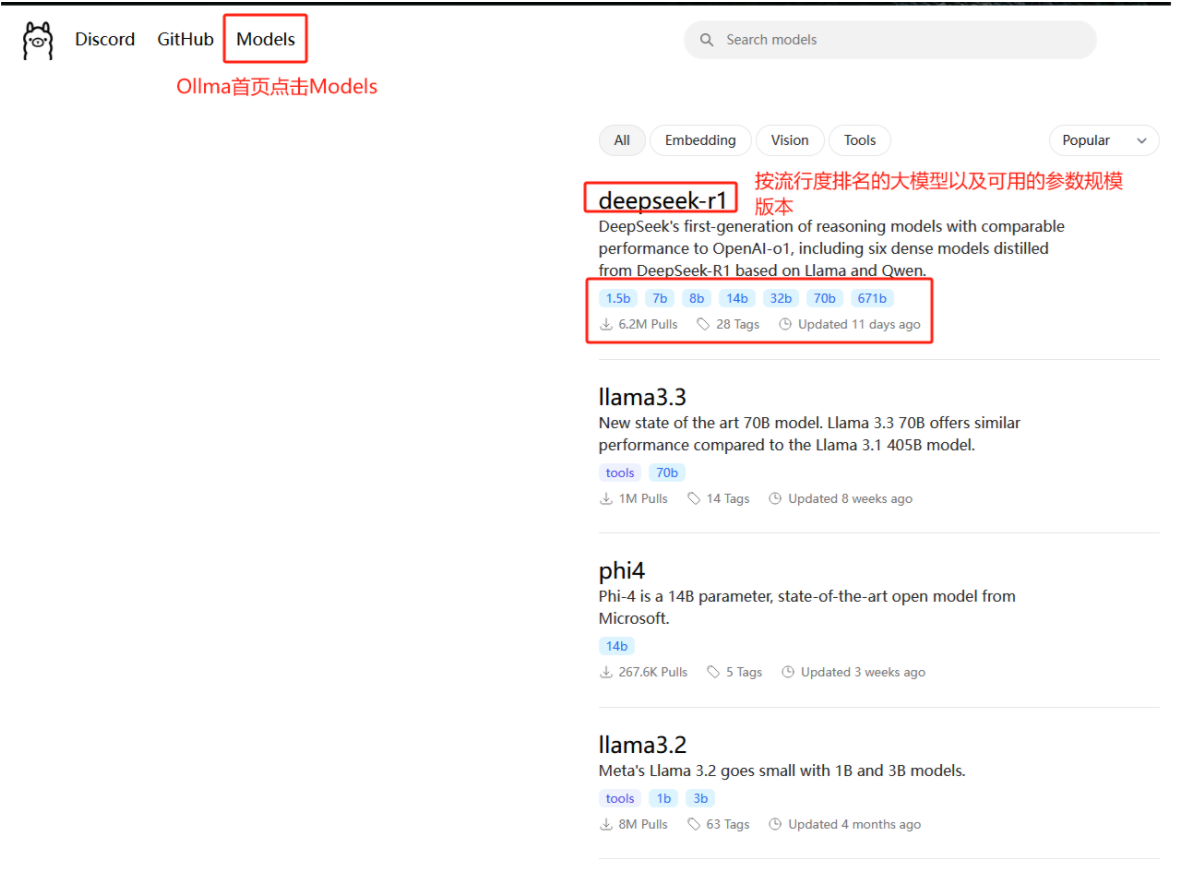

为了获取Ollama中安装DeepSeek-R1的命令,我们需要在Ollama首页选择“Models”页面,然后从中选择DeepSeek。

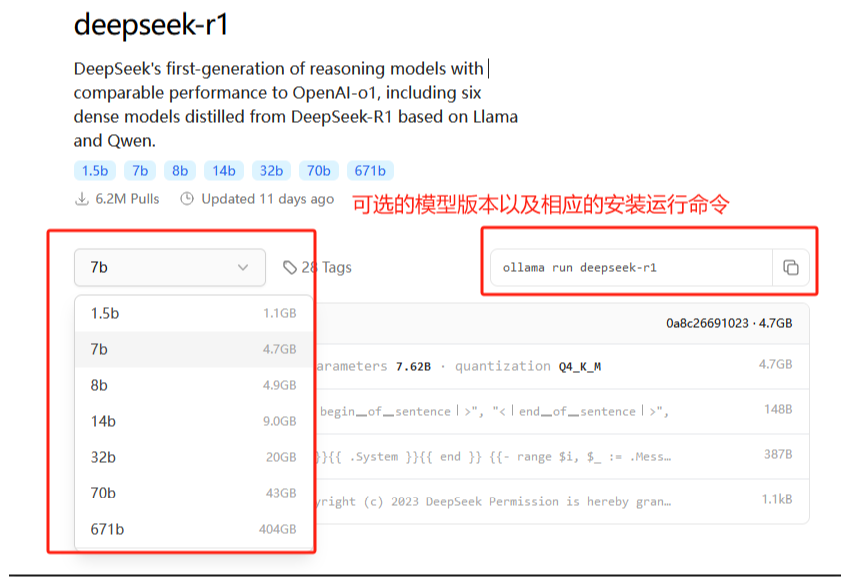

点击进入到DeepSeek-R1模型界面,可以通过下拉框选择适合自己的R1蒸馏版本(类似于以R1模型为老师学习得到的不同年级的学生模型),其中“7b”代表模型参数量为70亿,越大的参数规模意味着安装运行更大的算力资源,从而对笔记本或服务器的性能要求越高。

点击进入到DeepSeek-R1模型界面,可以通过下拉框选择适合自己的R1蒸馏版本(类似于以R1模型为老师学习得到的不同年级的学生模型),其中“7b”代表模型参数量为70亿,越大的参数规模意味着安装运行更大的算力资源,从而对笔记本或服务器的性能要求越高。

如何选择适合自己笔记本或个人电脑的DeepSeek-R1?可以参考下述性能需要表。根据表中需求,此次我们选择了较小的R1-7b模型。

如何选择适合自己笔记本或个人电脑的DeepSeek-R1?可以参考下述性能需要表。根据表中需求,此次我们选择了较小的R1-7b模型。

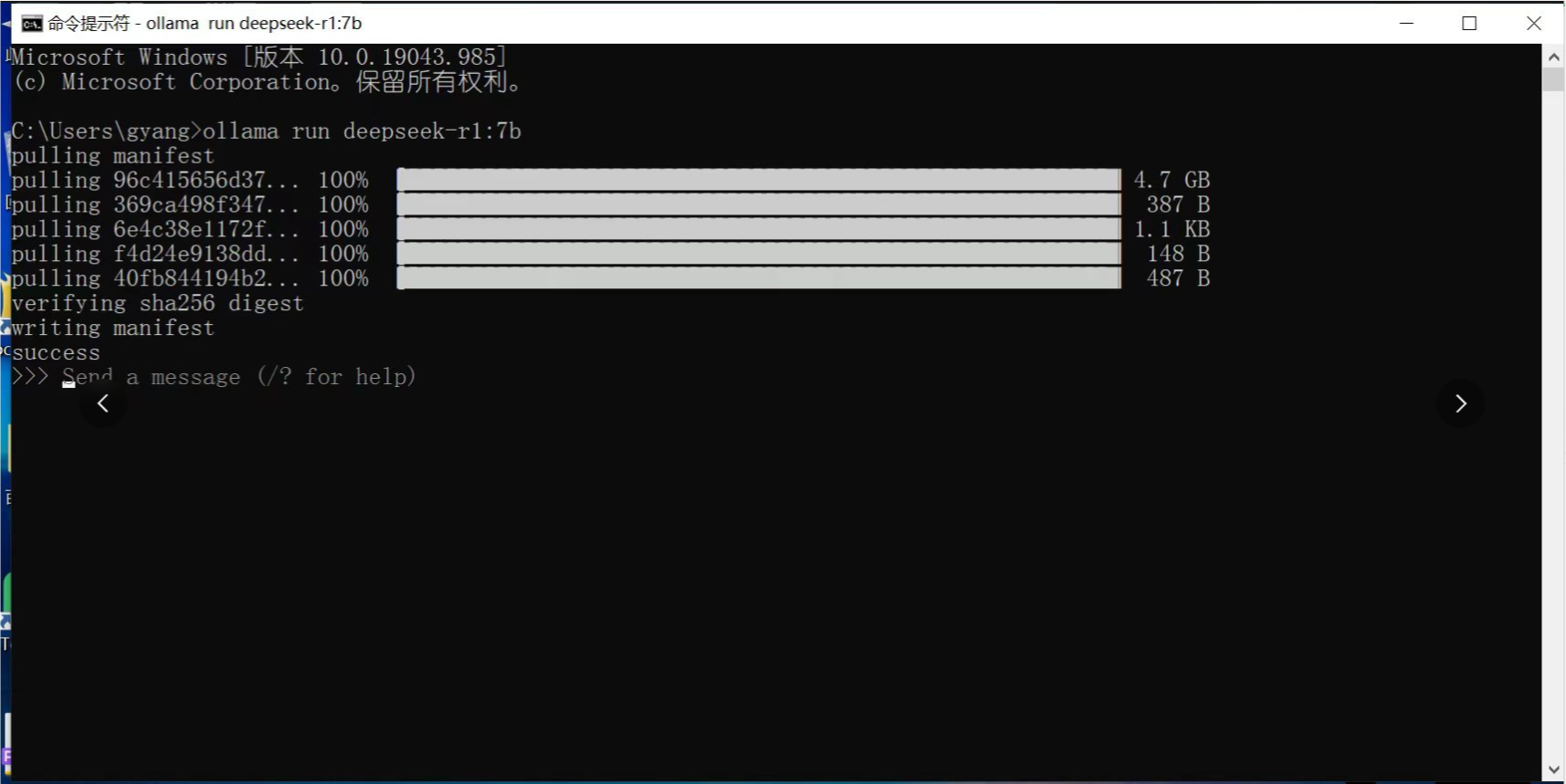

接下来只需要在命令行界面中运行Ollama的运行命令即可:

接下来只需要在命令行界面中运行Ollama的运行命令即可:

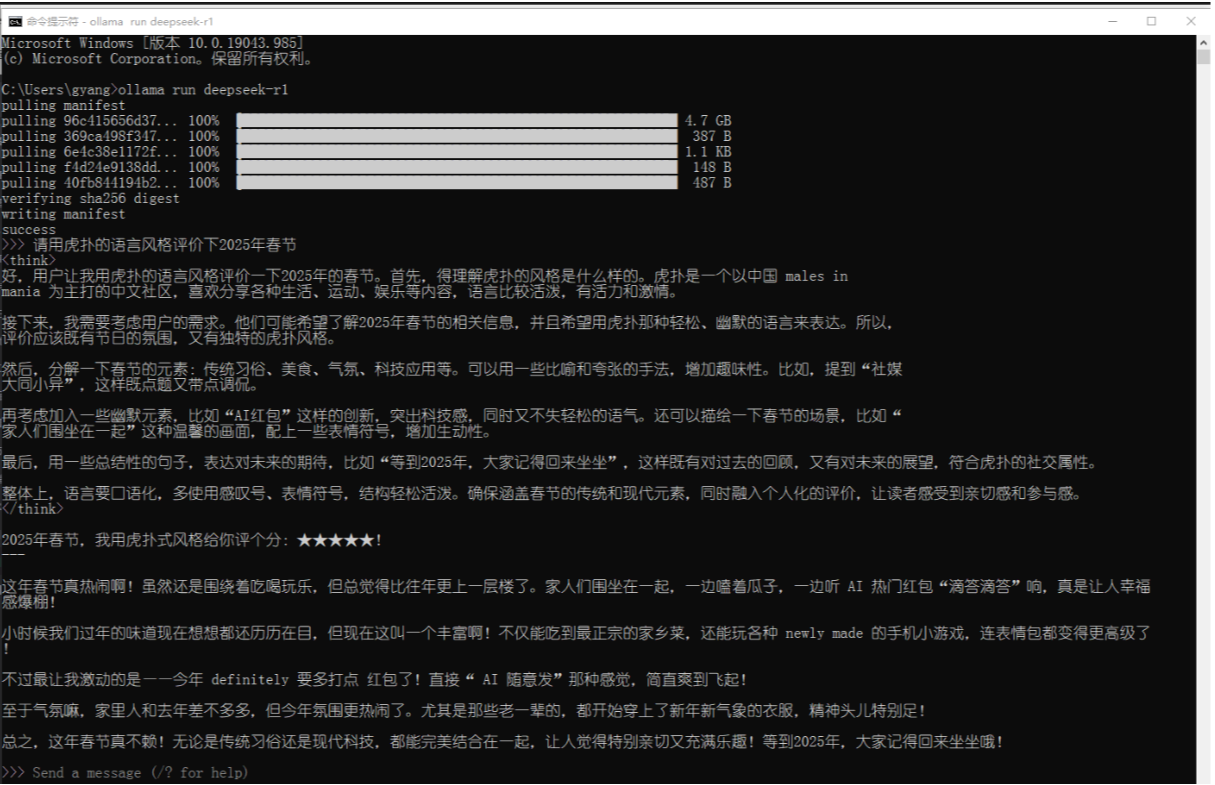

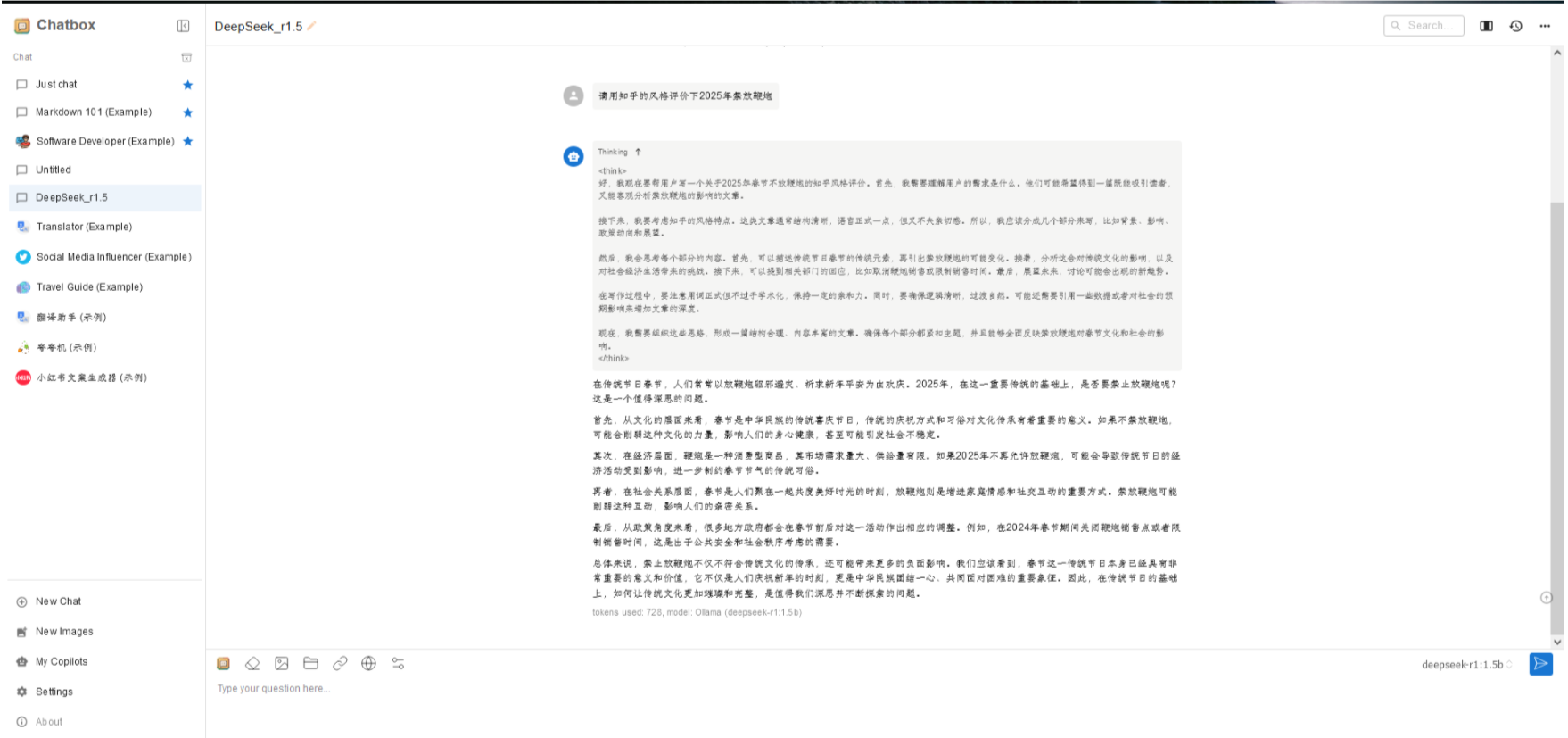

一旦安装完成,其实我们就可以在命令行的提示中运行测试DeepSeek-R1-7b了,接下来自己尝试要求DeepSeek以虎扑的风格来“评价2025年春节”,可以看到其清晰的思考过程()和输出结果,其幽默的风格确实很像虎扑UP主(#.#)

一旦安装完成,其实我们就可以在命令行的提示中运行测试DeepSeek-R1-7b了,接下来自己尝试要求DeepSeek以虎扑的风格来“评价2025年春节”,可以看到其清晰的思考过程()和输出结果,其幽默的风格确实很像虎扑UP主(#.#)

## 23 | 安装ChatBox,接入Ollama API

## 23 | 安装ChatBox,接入Ollama API

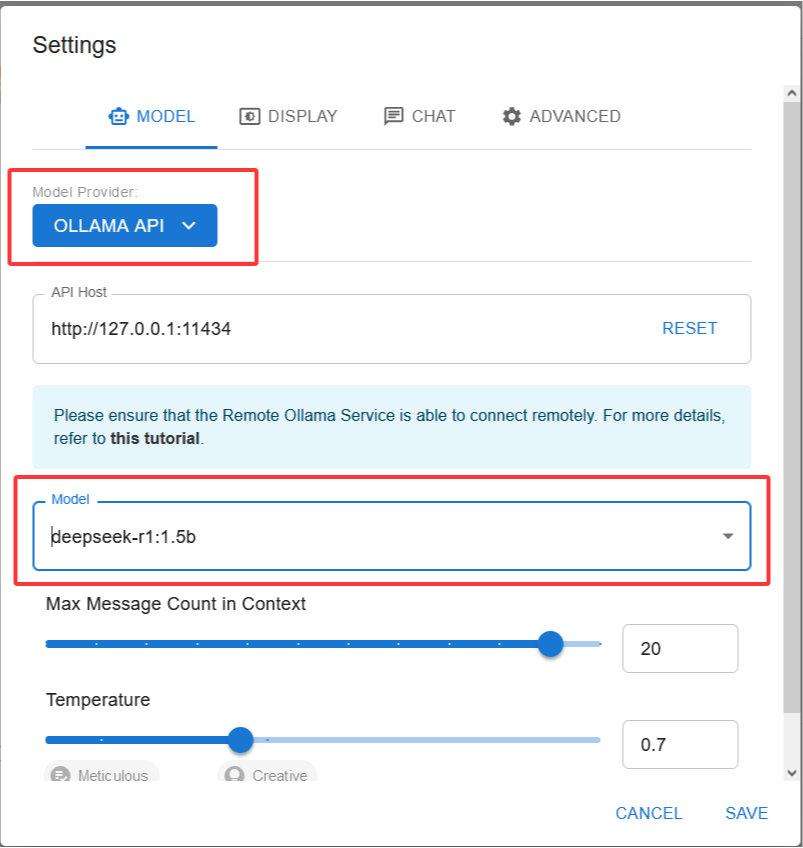

本质上来说,程序员使用上述命令行界面已经可以自然地与DeepSeek交互。但是为了获得更好的用户图形体验,我们可以进一步下载ChatBox并调用Ollama的API,在图形界面中与DeepSeek交互。

在ChatBox的下载页面选择自己喜欢的方式,也可以使用网页端进行体验(https://chatboxai.app/zh#download)。

此时需要在ChatBox的Setting中选择Ollama-API,并在相应的模型中选择DeepSeek。如果没有可用的模型,需要根据自己的操作系统进行相应的本地配置。配置完成后保存即可在新对话中与DeepSeek进行对话啦!

DeepSeek模型本地化部署指南

DeepSeek模型本地化部署指南

7万+

7万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?