ConcurrentLinkedQueue:高性能无界非阻塞队列深度解析

一、核心价值与应用场景

在并发编程的世界中,线程安全队列是最基础的并发组件之一。Java并发包提供了两种主要类型的线程安全队列:阻塞队列和非阻塞队列。ConcurrentLinkedQueue作为后者的代表,以其独特的设计哲学和高性能特性,在高并发场景中占据重要地位。

-

《ConcurrentLinkedQueue:每秒百万级操作的高性能队列实现原理》

-

《非阻塞vs阻塞队列:如何选择正确的并发队列策略?》

-

《深入ConcurrentLinkedQueue:CAS如何成就无锁并发奇迹》

-

《ConcurrentLinkedQueue实战:电商秒杀系统的队列选型优化》

-

《从源码看ConcurrentLinkedQueue:Java并发大师的设计艺术》

二、ConcurrentLinkedQueue架构设计

2.1 基础设计理念

ConcurrentLinkedQueue是一个基于单向链表实现的无界线程安全队列,采用FIFO(先进先出)原则。它的核心设计目标是:

-

完全非阻塞:没有任何锁操作

-

高吞吐量:适应高并发场景

-

线性一致性:提供线程安全的原子操作

// 简化版数据结构示意

public class ConcurrentLinkedQueue<E> {

private volatile Node<E> head; // 头节点指针

private volatile Node<E> tail; // 尾节点指针

private static class Node<E> {

volatile E item; // 存储的元素

volatile Node<E> next; // 下一个节点

}

}

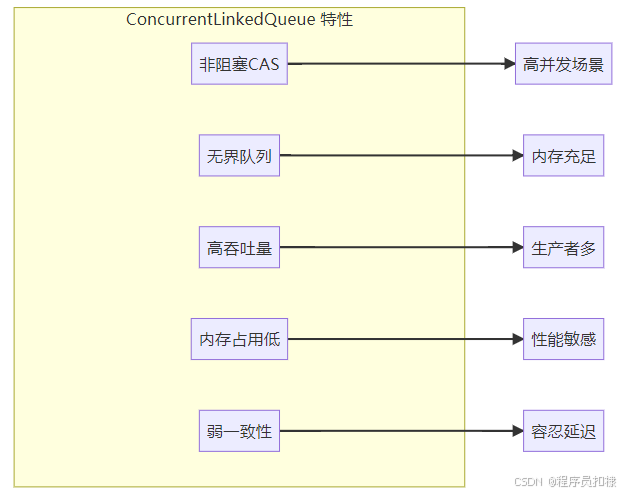

2.2 核心特性解析

2.2.1 "非阻塞"的深刻含义

非阻塞不仅仅意味着"不使用锁",更意味着不会让线程进入等待状态:

-

阻塞队列:线程在队列满/空时被挂起,等待条件满足

-

非阻塞队列:立即返回结果(成功/失败),线程继续执行其他工作

这种设计使得ConcurrentLinkedQueue在高争用环境下表现出色,避免了线程上下文切换的开销。

2.2.2 "无界"的设计权衡

无界队列意味着理论上可以无限增长:

-

优势:不会因为容量限制导致操作失败

-

风险:可能引发内存溢出(OutOfMemoryError)

-

应对策略:需要应用层进行容量监控和流量控制

三、Michael & Scott非阻塞算法实现

3.1 CAS操作的核心地位

CAS(Compare-And-Swap)是ConcurrentLinkedQueue实现非阻塞的基石:

// CAS操作伪代码示意

boolean casNext(Node<E> cmp, Node<E> val) {

return UNSAFE.compareAndSwapObject(this, nextOffset, cmp, val);

}

CAS的三大特性:

-

原子性:硬件保证的原子操作

-

乐观并发:先尝试,失败则重试

-

无锁:不需要获取和释放锁

3.2 入队操作(offer)深度剖析

// 入队操作的简化流程

public boolean offer(E e) {

Node<E> newNode = new Node<E>(e);

for (Node<E> t = tail, p = t;;) {

Node<E> q = p.next;

if (q == null) {

// p是最后一个节点,尝试插入

if (p.casNext(null, newNode)) {

// 成功插入,尝试更新tail(可能失败)

if (p != t)

casTail(t, newNode);

return true;

}

}

// 重新定位到真正的尾节点

p = (p != t && t != (t = tail)) ? t : q;

}

}

入队算法的精妙之处:

-

延迟更新tail:tail不一定指向真正的尾节点,这是为了减少CAS争用

-

"hop"跳过已删除节点:通过p != t检查判断是否需要向前推进

-

乐观重试:CAS失败后重新获取最新状态再次尝试

入队过程图示:

初始状态: head → A → B → C (tail指向C)

↑ ↑

head tail

步骤1: 创建新节点D

步骤2: C.casNext(null, D) 成功

步骤3: casTail(C, D) 更新tail到D

最终状态: head → A → B → C → D

↑ ↑

head tail

3.3 出队操作(poll)实现机制

// 出队操作的简化流程

public E poll() {

restartFromHead:

for (;;) {

for (Node<E> h = head, p = h, q;;) {

E item = p.item;

if (item != null && p.casItem(item, null)) {

// 成功取出元素

if (p != h) {

// 更新head,跳过已出队节点

updateHead(h, ((q = p.next) != null) ? q : p);

}

return item;

}

else if ((q = p.next) == null) {

// 队列为空

updateHead(h, p);

return null;

}

else if (p == q) {

// 遇到自引用,重新开始

continue restartFromHead;

}

else {

// 向后推进

p = q;

}

}

}

}

出队的关键设计:

-

延迟删除:item置为null,节点物理上还在链表中

-

head更新策略:不一定每次出队都更新head,减少CAS操作

-

自引用检测:处理并发环境下的异常情况

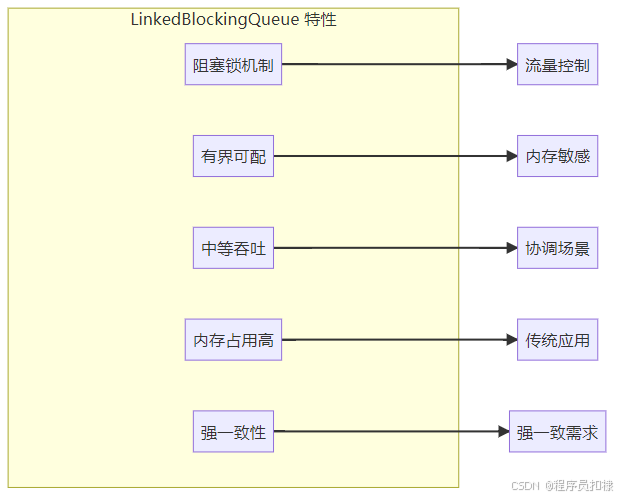

四、ConcurrentLinkedQueue与LinkedBlockingQueue对比

4.1 性能特征对比

| 特性 | ConcurrentLinkedQueue | LinkedBlockingQueue |

|---|---|---|

| 并发模型 | 非阻塞(CAS) | 阻塞(ReentrantLock) |

| 有界/无界 | 无界 | 可配置有界或无界 |

| 吞吐量 | 极高(高争用场景) | 中等 |

| 公平性 | 不保证 | 可配置公平/非公平锁 |

| 内存占用 | 较低 | 较高(锁开销) |

| 适用场景 | 高并发、生产者多 | 生产者-消费者协调 |

4.2 选型决策指南

选择ConcurrentLinkedQueue的场景:

-

高吞吐需求:每秒处理百万级消息的系统

-

生产者远多于消费者:避免生产者被阻塞

-

任务不均衡:任务处理时间差异大,避免饥饿

-

内存充足:可以接受队列暂时膨胀

选择LinkedBlockingQueue的场景:

-

流量控制需求:需要限制队列最大长度

-

生产者-消费者协调:需要精确的流量控制

-

内存敏感:必须限制队列大小

-

公平性要求:需要保证处理顺序的公平性

4.3 实战案例:电商秒杀系统

// 秒杀系统队列选型示例

public class SeckillSystem {

// 场景分析:

// 1. 瞬时高并发(数万QPS)

// 2. 生产者(用户请求)远多于消费者(订单处理器)

// 3. 可以接受短暂的内存增长

// → 选择ConcurrentLinkedQueue

private final ConcurrentLinkedQueue<SeckillRequest> requestQueue =

new ConcurrentLinkedQueue<>();

// 请求接收(高并发)

public void submitRequest(SeckillRequest request) {

// 非阻塞入队,立即返回

boolean success = requestQueue.offer(request);

if (!success) {

// 实际上很少发生,除非极端情况

handleFullQueue(request);

}

}

// 异步处理

private void processRequests() {

while (running) {

SeckillRequest request = requestQueue.poll();

if (request != null) {

try {

handleRequest(request);

} catch (Exception e) {

// 失败重试或记录日志

retryOrLog(request, e);

}

} else {

// 队列空时短暂休眠

Thread.yield();

}

}

}

}

五、ConcurrentLinkedQueue的陷阱与最佳实践

5.1 常见陷阱

陷阱1:size()方法的性能问题

// size()需要遍历整个链表,时间复杂度O(n)

int size = queue.size(); // 谨慎使用!

// 替代方案:使用计数器

class CountingQueue<E> {

private final ConcurrentLinkedQueue<E> queue =

new ConcurrentLinkedQueue<>();

private final AtomicLong counter = new AtomicLong();

public boolean offer(E e) {

if (queue.offer(e)) {

counter.incrementAndGet();

return true;

}

return false;

}

public long size() {

return counter.get(); // O(1)时间复杂度

}

}

陷阱2:迭代器的弱一致性

// 迭代器反映创建时的状态,不反映后续修改

Iterator<T> it = queue.iterator();

// 此时其他线程的修改可能不会在迭代器中体现

陷阱3:内存泄漏风险

// 长期运行的系统需要注意

while (true) {

Object item = queue.poll();

if (item == null) break;

// 处理item

}

// 出队后节点可能仍被head引用,无法被GC

5.2 最佳实践

-

避免使用size()方法

// 错误用法 if (queue.size() > MAX_SIZE) { ... } // 正确做法:使用专门的容量控制队列 -

批量操作优化

// 批量出队,减少CAS操作 public List<E> pollBatch(int batchSize) { List<E> batch = new ArrayList<>(batchSize); for (int i = 0; i < batchSize; i++) { E item = queue.poll(); if (item == null) break; batch.add(item); } return batch; } -

配合背压机制

// 实现简单的背压控制 class BackPressureQueue<E> { private final ConcurrentLinkedQueue<E> queue; private final int warningThreshold; public boolean offerWithBackPressure(E e) { if (estimatedSize() > warningThreshold) { return false; // 触发背压 } return queue.offer(e); } private int estimatedSize() { // 使用采样或其他估算方法 } }

六、高级应用与性能优化

6.1 性能调优技巧

-

CAS失败处理优化

// 自适应自旋等待 private static final int MAX_SPINS = Runtime.getRuntime().availableProcessors() > 1 ? 64 : 0; int spins = 0; while (!casOperation()) { if (++spins > MAX_SPINS) { Thread.yield(); // 让出CPU spins = 0; } } -

内存预分配

// 预分配节点,减少GC压力 private final NodePool<E> nodePool = new NodePool<>(); public boolean offer(E e) { Node<E> newNode = nodePool.acquire(); newNode.item = e; // ... 入队逻辑 }

6.2 监控与诊断

// 队列健康度监控

public class QueueMonitor {

private final ConcurrentLinkedQueue<?> queue;

private long lastCheckTime;

private long lastSize;

public void monitor() {

long currentSize = estimateSize();

long currentTime = System.currentTimeMillis();

// 计算增长率

double growthRate = (currentSize - lastSize) * 1000.0

/ (currentTime - lastCheckTime);

if (growthRate > WARNING_RATE) {

alert("队列增长过快: " + growthRate + " elements/sec");

}

lastSize = currentSize;

lastCheckTime = currentTime;

}

}

七、未来展望:并发队列的发展趋势

7.1 硬件友好的队列设计

随着硬件发展,新的队列优化方向:

-

缓存行友好设计:避免false sharing

// 使用@Contended注解避免伪共享 @sun.misc.Contended class PaddedNode<E> { // 节点实现 } -

NUMA架构优化:针对多处理器系统的优化

7.2 混合并发策略

结合阻塞和非阻塞的优点:

class HybridQueue<E> {

// 低争用时使用CAS

// 高争用时切换到锁模式

// 动态切换策略

}

八、总结

ConcurrentLinkedQueue代表了Java并发编程的一种哲学:通过乐观并发和无锁设计实现极致性能。它的成功不仅在于技术的精妙,更在于设计理念的先进性:

-

简单性:相比复杂的锁机制,CAS提供了更简洁的并发控制

-

可扩展性:真正实现了多核环境下的线性扩展

-

实用性:在真实的高并发系统中证明了其价值

然而,"没有银弹"原则同样适用。ConcurrentLinkedQueue的无界特性和弱一致性需要开发者深刻理解。在选择使用它时,必须考虑:

-

应用的具体并发模式

-

内存资源和监控能力

-

一致性和性能的权衡

正如并发大师Doug Lea所言:"好的并发设计是艺术和工程的结合。"ConcurrentLinkedQueue正是这种结合的典范,它既展示了并发算法的精妙,又体现了工程实践的智慧。

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?