ResNet 作为小型网络的组合

《具有随机深度的深度网络》提出了一种反直觉的方式,训练一个非常深层的网络,通过在训练期间随机丢弃它的层,并在测试时间内使用完整的网络。Veit 等人有一个更反直觉的发现:我们实际上可以删除一些已训练的 ResNet 的一些层,但仍然具有可比性能。这使得ResNet 架构更加有趣,该论文亦降低了 VGG 网络的层,并大大降低了其性能。

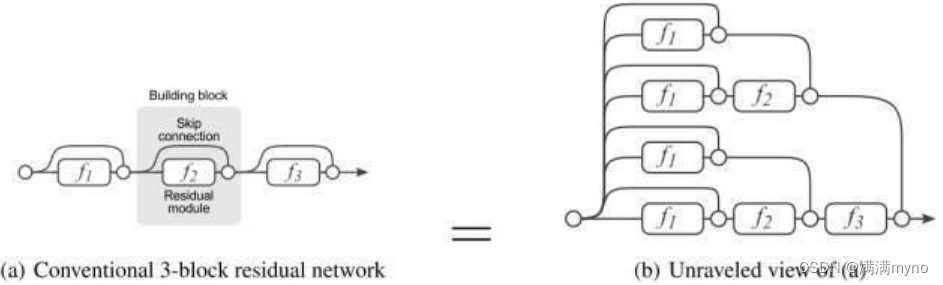

该论文首先提供了 ResNet 的一个简单的视图,使事情更清晰。在我们展开网络架构之后,这是很显而易见的,具有 i 个残差块的 ResNet 架构具有 2 ** i 个不同的路径(因为每个残差块提供两个独立的路径)。

鉴于上述发现,我们很容易发现为什么在 ResNet 架构中删除几层,对于其性能影响不大——架构具有许多独立的有效路径,在我们删除了几层之后,它们大部分保持不变。相反,VGG网络只有一条有效的路径,所以删除一层是唯一的途径。

作者还进行了实验,表明 ResNet 中的路径集合具有集合行为。他们是通过在测试时间删除不同数量的层,然后查看网络的性能是否与已删除层的数量平滑相关,这样的方式做到的。

结果表明,网络确实表现得像集合,如下图所示:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

364

364

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?