Softmax 函数

softmax 用于多分类过程中,它将多个神经元的输出,映射到(0,1)区间内,可以看成概率来理解,从而来进行多分类!

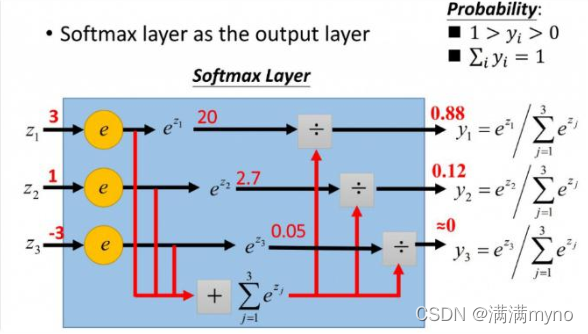

形象的映射过程如下图所示:

softmax直白来说就是将原来输出是3,1,-3通过softmax函数一作用,就映射成为(0,1)的值,而这些值的累和为 1(满足概率的性质),那么我们就可以将它理解成概率,在最后选取输出结点的时候,我们就可以选取概率最大(也就是值对应最大的)结点,作为我们的预测目标!

Batch_Size

Batch 的选择,首先决定的是下降的方向。

如果数据集比较小,可采用全数据集的形式,好处是:

1、由全数据集确定的方向能够更好地代表样本总体,从而更准确地朝向极值所在的方向。

2、由于不同权重的梯度值差别巨大,因此选取一个全局的学习率很困难。 Full Batch Learning 可以使用 Rprop 只基于梯度符号并且针对性单独更新各权值。

对于更大的数据集,采用全数据集的形式,坏处是:

1、随着数据集的海量增长和内存限制,一次性载入所有的数据进来变得越来越不可行。

2、以 Rprop 的方式迭代,会由于各个 Batch 之间的采样差异性,各次梯度修正值相互抵消,无法修正。这才有了后来 RMSProp

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?