Generalized Robust Regression for Jointly Sparse Subspace Learning

Zhihui Lai , Dongmei Mo , Jiajun Wen, Linlin Shen, and Wai Keung Wong

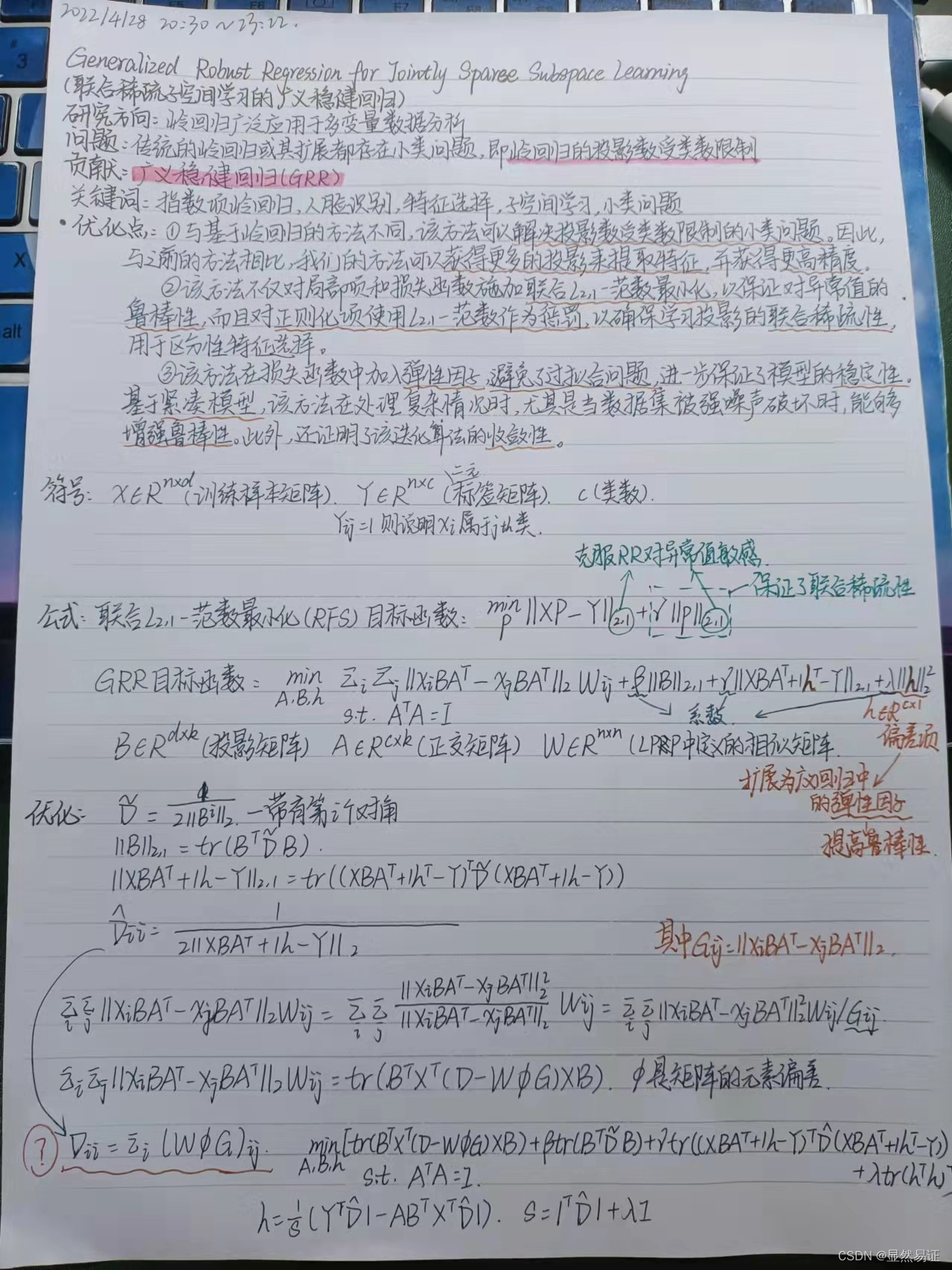

联合稀疏子空间学习的广义稳健回归

ABSTRACT

岭回归广泛应用于多变量数据分析。然而,在图像特征提取和识别等高维情况下,传统的岭回归或其扩展都存在小类问题,即岭回归得到的投影数受类数的限制。在这篇论文中,我们提出了一种新的方法,称为广义稳健回归(GRR),用于联合稀疏子空间学习,可以解决这个问题。GRR不仅对损失函数和正则化项施加

L

2

,

1

−

L_{2,1}-

L2,1−范数惩罚,以保证有效特征选择的联合稀疏性和对异常值的鲁棒性,而且还利用

L

2

,

1

−

L_{2,1}-

L2,1−范数作为度量,考虑数据固有的局部几何结构,以提高性能。此外,通过在损失函数上加入弹性因子,GRR可以增强鲁棒性,以获得更多用于特征选择或分类的投影。为了获得GRR的最优解,提出了一种迭代算法,并证明了算法的收敛性。在六个已知数据集上的实验证明了该方法的优点。结果表明,GRR是一种稳健有效的人脸识别回归方法。

关键词: 指数项岭回归,人脸识别,特征选择,子空间学习,小班问题。

I. INTRODUCTION

作为广泛使用的统计分析技术,最小二乘回归(LSR)[1]已被应用于许多实际应用中,如人脸识别[2],基于视频的步态识别[3]。然而,在多重共线性问题中,LSR的估计是无偏的,当它们的方差较大时,这可能会使结果远离真实值[4]。岭回归(RR)是一种正则化最小二乘法,它在传统的LSR中添加了一个偏差项,以减少标准误差,从而提高回归估计的性能[4]。许多基于LSR或RR的扩展被应用于降维和特征提取。

经典的PCA降维方法[5]解决了最佳特征向量的降维问题。与主成分分析类似,线性判别分析(LDA)是另一种著名的降维方法。与PCA不同,LDA是一种有监督的方法,它在计算过程中使用标签信息来学习最优投影矩阵。从LDA学习的投影不仅使类间距离最大化,而且使特征空间中的类内距离最小化,从而提高模式识别的性能[6]。虽然PCA和LDA是著名的降维技术,但它们仍然存在一些缺点。首先,它们只考虑数据集的全局结构,而忽略了局部几何信息。这会影响性能,因为局部性在降维或特征选择中至关重要[7]。其次,作为基于 L 2 L2 L2范数的方法,传统的PCA和LDA对异常值非常敏感,因为 L 2 L2 L2范数中的平方残差会导致在计算投影矩阵时过度强调噪声和异常值的不良趋势。此外,对于LDA或基于LDA的方法,投影的数量受到类间散射矩阵的限制(即小样本量(SSS)问题)[8]。这种限制会降低特征提取和分类的性能。

为了缓解上述第一个问题,提出了许多基于局部性(即邻域保持特性)的方法,以提高计算机视觉和模式识别的有效性[9]。其中,有代表性的非线性降维算法包括局部线性嵌入(LLE)[10]、拉普拉斯特征映射[11]、Isomap[12]等。基于局部性的方法的著名线性版本包括局部保持投影(LPP)[13]、拉普拉斯面[14]和线性版本的LLE(即邻域保持投影(NPP)[15]、邻域保持嵌入(NPE)[16]等)。

对于上面提到的第二个问题,由于在损失函数上使用 L 2 − L2- L2−范数的方法对异常值敏感,另一种解决方案是使用 L 1 − L1- L1−范数代替 L 2 − L2- L2−范数,大量实验结果证明 L 1 − L1- L1−范数比 L 2 − L2- L2−范数对异常值更具鲁棒性[17],[18]。为了增强人脸识别中对异常值的鲁棒性,提出了一些基于PCA的 L 1 − L1- L1−范数方法。其中一种流行的方法是鲁棒主成分分析(RPCA)[19],它可以通过使用增广拉格朗日乘子算法解决主成分追踪问题来恢复低秩和稀疏分量[20]。其他方法包括L1-PCA[21]、R1-PCA[22]、PCA-L1[23]等。拟议的L1-PCA和R1-PCA复杂且计算成本高,而PCA-L1快速且稳健[6]。受R1-PCA的启发,提出了一种基于LDA的方法,称为旋转不变 L 1 − L1- L1−范数线性判别分析(LDA-R1)[24],以提高降维和特征选择的鲁棒性。受PCA-L1的启发,提出了另一种基于LDA的方法,称为基于 L 1 − L1- L1−范数最大化的线性判别分析(LDA-L1)[6],以克服LDA-R1在高维情况下需要花费太多时间才能收敛的缺点[6]。

最近,稀疏学习方法在图像处理、人脸识别[25]、[26]和模式识别[27]中引起了广泛关注。 L 2 , 1 − L_{2,1}- L2,1−范数最近变得流行起来,因为它是一种获得联合稀疏投影的有效方法,用于区分性特征选择或提取。通过对损失函数和正则化项施加联合 L 2 , 1 − L_{2,1}- L2,1−范数最小化,Nie等人提出了一种称为通过联合 L 2 , 1 − L_{2,1}- L2,1−范数最小化(RFS)进行高效稳健特征选择的方法[28],用于联合稀疏特征选择。受[28]的启发, L 2 , 1 − L_{2,1}- L2,1−范数极小化也被推广到稀疏回归、子空间学习[29],[30]的研究中。还提出了另一种联合稀疏方法,称为用于无监督学习的 L 2 , 1 − L_{2,1}- L2,1−范数正则化鉴别特征选择(UDFS)[31],以提高无监督学习的性能。虽然已经提出了许多基于 L 2 , 1 − L_{2,1}- L2,1−范数的方法来处理不同的情况,但它们与稀疏回归和子空间学习的理论关系仍然不清楚。此外,现有的基于 L 2 , 1 − L_{2,1}- L2,1−范数的方法还存在一些缺陷。例如,RFS利用损失函数和正则化项上的 L 2 , 1 − L_{2,1}- L2,1−范数来获得用于特征选择的联合稀疏性。然而,它只关注数据集的全局结构,而忽略了数据的局部性。此外,RFS中的小类问题仍未解决。对于其他一些方法,尽管它们考虑了数据的局部几何结构,但学习的局部保持投影对异常值不具有鲁棒性,因为传统的基于LPP的项将 L 2 L2 L2范数作为目标函数的度量。此外,在不同的情况下,尤其是当数据集被强噪声破坏时,这些方法的鲁棒性不能得到保证。因此,为了提高人脸识别或其他应用的性能,有必要提出一种更稳健、更高效的方法。

本文提出了一种结合LPP、RR和 L 2 , 1 − L_{2,1}- L2,1−范数性质的新方法来缓解RR及其扩展中的潜在问题。该方法能够解决基于回归的方法中的小类问题,同时保证人脸识别的鲁棒性和有效性。这项工作的主要贡献如下:

- 与基于岭回归的方法不同,该方法可以解决投影数受类数限制的小类问题。因此,与以前的方法相比,我们的方法可以获得更多的投影来进行特征提取,并获得更高的精度。

- 该方法不仅对局部项和损失函数施加联合 L 2 , 1 − L_{2,1}- L2,1−范数最小化,以保证对异常值的鲁棒性,而且对正则化项使用 L 2 , 1 − L_{2,1}- L2,1−范数作为惩罚,以确保学习投影的联合稀疏性,用于区分性特征选择。这使得该模型不同于所有现有的基于LPP的方法、基于岭回归的方法或以前的基于 L 2 , 1 − L_{2,1}- L2,1−范数的方法。

- 该方法在损失函数中加入了弹性因子,避免了过拟合问题,从而进一步保证了模型的稳定性。基于紧凑模型,该方法在处理复杂情况时,尤其是当数据集被强噪声破坏时,能够增强鲁棒性。此外,还证明了该迭代算法的收敛性。

论文的其余部分组织如下。在第二节中,我们首先给出了一些符号,然后提出了新的方法及其相应的迭代算法。第三节给出了理论分析,包括所提出方法的收敛性及其计算复杂性。在第四节中,我们进行了一系列实验来评估所提出的方法的性能,然后在第五节中得出结论。

II. GENERALIZED ROBUST REGRESSION(广义稳健回归)

在本节中,将介绍一种用于联合稀疏子空间学习的广义稳健回归(GRR)模型,并设计交替迭代算法来解决优化问题。

A.Notations

标量表示为小写斜体字母,即 i i i、 j j j、 n n n、 d d d、 c c c、 m m m等,而向量表示为粗体小写斜体字母,即 x x x、 y y y、 v v v等。矩阵定义为粗体大写斜体字母,即 X X X、 Y Y Y、 A A A、 B B B等。

定义 X ∈ R n × d X\in R^{n×d} X∈Rn×d是训练集样本矩阵,其中 n n n是总体训练样本的个数, d d d是每个样本的特征维。每一行是一个样本 x i x_i xi,定义 Y ∈ R n × c Y\in R^{n×c} Y∈Rn×c是二元标签矩阵,当 Y i j = 1 Y_{ij}=1 Yij=1,而 x i x_i xi属于第 j j j类;否则 Y i j = 0 Y_{ij}=0 Yij=0.

B. The Motivations and the Novel Definitions

最小二乘回归(LSR)[1]和岭回归(RR)[4]存在一些明显的缺点。

首先,他们有小类问题。也就是说,当训练数据中的类数太少时,只能获得c投影来执行特征提取和选择。其次,由于LSR和RR是基于

L

2

L2

L2范数的方法,对目标函数的平方运算将导致对异常值的敏感性。第三,由于从传统岭回归中学习到的投影不是稀疏的,因此从LSR或RR中学习到的投影对于特征选择没有稀疏性。因此,特征选择需要更稳健的损失函数。Nie等人提出了一种称为通过联合

L

2

,

1

−

L_{2,1}-

L2,1−范数最小化(RFS)进行高效鲁棒特征选择的方法[28]。RFS的目标函数是

m

i

n

P

∣

∣

X

P

−

Y

∣

∣

2

,

1

+

γ

∣

∣

P

∣

∣

2

,

1

(

1

)

min_P||XP-Y||_{2,1}+γ||P||_{2,1}(1)

minP∣∣XP−Y∣∣2,1+γ∣∣P∣∣2,1(1)

通过在损失函数和正则化项上使用

L

2

,

1

−

L_{2,1}-

L2,1−范数,RFS能够克服岭回归对异常值敏感的缺点。此外,RFS中的正则化项保证了联合稀疏性,从而提高了特征选择和人脸识别的性能。但是RFS仍然存在一些缺点。首先,它仍然存在小班化问题。其次,由于RFS学习的投影只是数据点全局结构的线性组合,因此忽略了数据集的局部几何结构。然而,大量实验结果表明,保持局部性有助于提高特征提取和分类的性能[14]。因此,需要新的技术来解决这些问题。

本文提出了一种联合稀疏子空间学习的广义稳健回归方法。该方法既继承了RFS的优点,又结合了LPP、RR的特性,进一步提高了特征选择的性能。即利用损失函数上的L2,1-范数最小化平方运算误差,同时利用正则化项上的 L 2 , 1 − L_{2,1}- L2,1−范数最小化来保证鉴别特征选择的联合稀疏性。此外,该算法在释放小类问题的同时,考虑了局部几何结构。它还对局部保持投影项施加 L 2 , 1 − L_{2,1}- L2,1−范数惩罚,以确保对异常值的鲁棒性。此外,为了提高该方法的鲁棒性,在损失函数中加入弹性因子,进行联合稀疏子空间学习。

C. The Objective Function of GRR

GRR的目标函数是在某些约束条件下最小化基于

L

2

,

1

−

L_{2,1}-

L2,1−范数的优化问题:

m

i

n

A

,

B

,

h

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

,

1

W

i

j

+

β

∣

∣

B

∣

∣

2

,

1

+

γ

∣

∣

X

B

A

T

+

1

h

T

−

Y

∣

∣

2

,

1

+

λ

∣

∣

h

∣

∣

2

2

s

.

t

.

A

T

A

=

I

(

2

)

min_{A,B,h}||x_iBA^T-x_jBA^T||_{2,1}W_{ij}+β||B||_{2,1}+γ||XBA^T+1h^T-Y||_{2,1}+λ||h||_2^2\\ s.t. A^TA=I(2)

minA,B,h∣∣xiBAT−xjBAT∣∣2,1Wij+β∣∣B∣∣2,1+γ∣∣XBAT+1hT−Y∣∣2,1+λ∣∣h∣∣22s.t.ATA=I(2)

其中

B

∈

R

d

×

k

B\in R^{d×k}

B∈Rd×k是一个射影矩阵,

A

∈

R

c

×

k

A\in R^{c×k}

A∈Rc×k是一个正交矩阵,

d

d

d和

k

k

k是矩阵大小的个数,

c

c

c是类的个数。

W

∈

R

n

×

n

W∈ R^{n×n}

W∈Rn×n是LPP中定义的相似矩阵。

1

∈

R

n

×

1

1∈ R^{n×1}

1∈Rn×1是所有元素都等于1的向量。向量

h

∈

R

c

×

1

h∈ R^{c×1}

h∈Rc×1是偏置项,三个系数

β

β

β、

γ

γ

γ和

λ

λ

λ是平衡不同项的参数。请注意,偏差项

h

h

h用于一些以前的半监督算法,即LapRLS/L[32]、FME[33]等。。该方法将该偏差项扩展为广义回归中的弹性因子,以提高人脸识别的鲁棒性,尤其是当数据点被强噪声破坏时。

在(2)中,第一部分 ∑ i ∑ j ∣ ∣ x i B A T − x j B A T ∣ ∣ 2 W i j \sum_i{\sum_j||x_iBA^T-x_jBA^T||_2}W_{ij} ∑i∑j∣∣xiBAT−xjBAT∣∣2Wij旨在保护当地的财产[13]。该方法在保留局部信息的同时,不计算每个训练样本 x i ( i = 1 , 2 , … , n ) x_i(i=1,2,…,n) xi(i=1,2,…,n)和 x j ( j = 1 , 2 , … , n ) x_j(j=1,2,…,n) xj(j=1,2,…,n)之间的欧氏距离,而是使用 L 2 , 1 − L_{2,1}- L2,1−范数作为度量来增强局部保持能力的鲁棒性。通过继承局部保持特性,提出的GRR不仅保留了数据固有的局部几何结构[13],而且保证了对异常值的鲁棒性。

(2)中的第二部分是正则化项 β ∣ ∣ B ∣ ∣ 2 , 1 β||B||_{2,1} β∣∣B∣∣2,1,这保证了学习到的投影矩阵B对于区分性特征选择是联合稀疏的[28],[31]。联合稀疏性保证了学习投影的大部分元素为零,并选择重要特征进行特征提取。

在(2)中,第三部分 γ ∣ ∣ X B A T + 1 h T − Y ∣ ∣ 2 , 1 γ||XBA^T+1h^T-Y||_{2,1} γ∣∣XBAT+1hT−Y∣∣2,1是损失函数,与经典RR和第四部分 λ ∣ ∣ h ∣ ∣ 2 2 λ||h||_2^2 λ∣∣h∣∣22作为偏差项,以保证整个模型的稳定性。与RR相比,(2)在损失函数上使用 L 2 , 1 − L_{2,1}- L2,1−范数最小化使得模型对异常值更具鲁棒性[28]。GRR鲁棒性的另一个潜在原因是,损失函数上的弹性因子 h h h可以避免实际中的过度拟合问题。在RFS的损失函数上,矩阵 P P P必须始终适合于 Y Y Y,以确保矩阵 X P XP XP和标签矩阵 Y Y Y之间的误差可以最小化,这将导致过度拟合问题的潜在风险。然而,GRR将弹性因子 h h h作为损失函数的补充项,并且不严格需要矩阵 X B A T XBA^T XBAT来拟合矩阵 Y Y Y,从而释放过拟合问题,以保证特征选择或提取的强泛化能力,尤其是在图像被块减法或噪声破坏的情况下。

此外,通过在损失函数上使用矩阵 B A T BA^T BAT而不是(1),(2)中的P来解决LSR、RR和RFS中的小类问题。也就是说,P的大小是 d × c d×c d×c,而 B B B、 A A A的大小分别是 d × k d×k d×k和 c × k c×k c×k,那么bat的大小是 d × c d×c d×c(即 B A T BA^T BAT与 P P P的大小相同)。在LSR、RR和RFS中,投影矩阵为 P P P,学习的投影数为 c c c(即类数)。然而,在GRR中,学习的投影矩阵是大小为 d × k d×k d×k的 B B B, k k k可以设置为任意整数,以获得足够的投影来执行人脸识别。因此,建议的GRR中投影的数量不受类别数量的限制,并且可以解决RR中的小类别问题。

D. The Optimal Solution

根据投影矩阵B上

L

2

,

1

−

L_{2,1}-

L2,1−范数的定义,带有第

i

i

i个对角元素的对角矩阵

D

~

\widetilde{D}

D

可以定义为[28]:

D

~

=

1

2

∣

∣

B

i

∣

∣

2

(

3

)

\widetilde{D}=\frac{1}{2||B^i||_2}(3)

D

=2∣∣Bi∣∣21(3)

其中,

B

i

B_i

Bi表示矩阵

B

B

B的第

i

i

i行。因此(2)中的第二部分重写为

∣

∣

B

∣

∣

2

,

1

=

t

r

(

B

T

D

~

B

)

(

4

)

||B||_{2,1}=tr(B^T\widetilde{D}B) (4)

∣∣B∣∣2,1=tr(BTD

B)(4)

类似地,(2)中的第三部分改写为

∣

∣

X

B

A

T

+

1

h

T

−

Y

∣

∣

2

,

1

=

t

r

(

(

X

B

A

T

+

1

h

T

−

Y

)

T

D

~

(

X

B

A

T

+

1

h

T

−

Y

)

)

(

5

)

||XBA^T+1h^T-Y||_{2,1}\\ =tr((XBA^T+1h^T-Y)^T\widetilde{D}(XBA^T+1h^T-Y))(5)

∣∣XBAT+1hT−Y∣∣2,1=tr((XBAT+1hT−Y)TD

(XBAT+1hT−Y))(5)

其中

D

~

\widetilde{D}

D

也是一个对角线矩阵,第

i

i

i个对角线元素为

D

i

i

~

=

1

2

∣

∣

(

X

B

A

T

+

1

h

T

−

Y

)

i

∣

∣

2

(

6

)

\widetilde{D_{ii}}=\frac{1}{2||(XBA^T+1h^T-Y)^i||_2}(6)

Dii

=2∣∣(XBAT+1hT−Y)i∣∣21(6)

对于(2)中的第一部分,由于我们将欧氏范数的平方改为

L

2

,

1

−

L_{2,1}-

L2,1−范数,因此为了利用LPP的性质,我们将其重新表述为:

∑

i

∑

j

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

W

i

j

=

∑

i

∑

j

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

2

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

W

i

j

=

∑

i

∑

j

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

2

W

i

j

/

G

i

j

(

7

)

\\ \sum_i{\sum_j||x_iBA^T-x_jBA^T||_2}W_{ij} \\ =\sum_i{\sum_j \frac{||x_iBA^T-x_jBA^T||_2^2}{||x_iBA^T-x_jBA^T||_2}}W_{ij} \\ = \sum_i{\sum_j||x_iBA^T-x_jBA^T||_2^2}W_{ij}/G_{ij}(7)

i∑j∑∣∣xiBAT−xjBAT∣∣2Wij=i∑j∑∣∣xiBAT−xjBAT∣∣2∣∣xiBAT−xjBAT∣∣22Wij=i∑j∑∣∣xiBAT−xjBAT∣∣22Wij/Gij(7)

其中,

G

i

j

=

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

G_{ij}=||x_iBA^T-x_jBA^T||_2

Gij=∣∣xiBAT−xjBAT∣∣2.因此,

∑

i

∑

j

∣

∣

x

i

B

A

T

−

x

j

B

A

T

∣

∣

2

W

i

j

=

t

r

(

B

T

X

T

(

D

−

W

∅

G

)

X

B

)

\sum_i{\sum_j||x_iBA^T-x_jBA^T||_2}W_{ij}=tr(B^TX^T(D-W∅G)XB)

∑i∑j∣∣xiBAT−xjBAT∣∣2Wij=tr(BTXT(D−W∅G)XB)

其中,

∅

∅

∅是矩阵的元素偏差,

D

D

D是对角矩阵,其元素是

W

∅

G

W∅G

W∅G的行(或列),也就是

D

i

i

=

∑

i

(

W

∅

G

)

i

j

D_{ii}=\sum_i(W∅G)_{ij}

Dii=∑i(W∅G)ij

从(4)、(5)和(8)中,目标函数(2)等于以下函数:

m

i

n

A

,

B

,

h

[

t

r

(

B

T

X

T

(

D

−

W

∅

G

)

X

B

)

+

β

t

r

(

B

T

D

~

B

)

+

γ

t

r

(

(

X

B

A

T

+

1

h

T

−

Y

)

T

D

~

(

X

B

A

T

+

1

h

T

−

Y

)

)

+

λ

t

r

(

h

T

h

)

]

s

.

t

.

A

T

A

=

I

(

9

)

min_{A,B,h}[tr(B^TX^T(D-W∅G)XB)+βtr(B^T\widetilde{D}B)+γtr((XBA^T+1h^T-Y)^T\widetilde{D}(XBA^T+1h^T-Y))+λtr(h^Th)] \\ s.t. A^TA=I(9)

minA,B,h[tr(BTXT(D−W∅G)XB)+βtr(BTD

B)+γtr((XBAT+1hT−Y)TD

(XBAT+1hT−Y))+λtr(hTh)]s.t.ATA=I(9)

为了得到GRR的局部最优解,我们固定两个变量

A

A

A,

B

B

B,并将(9)对

h

h

h的导数设为零,然后

h

=

1

s

(

Y

T

D

^

1

−

A

B

T

X

T

D

^

1

)

(

10

)

h=\frac1s(Y^T\widehat{D}1-AB^TX^T\widehat{D}1)(10)

h=s1(YTD

1−ABTXTD

1)(10)

其中,

s

=

1

T

D

^

1

+

λ

I

.

s=1^T\widehat{D}1+λI.

s=1TD

1+λI.

类似地,对于固定的A和h,我们将(9)对B的导数设为零,然后(9)通过

B

=

γ

[

β

D

~

+

X

T

(

(

D

−

W

∅

G

)

+

γ

D

~

)

X

]

−

1

X

T

D

^

(

Y

−

1

h

T

)

A

B = γ[β\widetilde{D}+X^T((D−W∅G)+γ\widetilde{D})X]^{−1}X^T\widehat{D}(Y−1h^T)A

B=γ[βD

+XT((D−W∅G)+γD

)X]−1XTD

(Y−1hT)A

在(9)中,当两个变量

B

B

B和

h

h

h固定时,下面关于

A

A

A的最大化问题提供了最优解。

m

a

x

A

A

T

(

h

1

T

−

Y

T

)

D

^

X

B

s

.

t

.

A

T

A

=

1

max_AA^T(h1^T-Y^T)\widehat{D}XB\\ s.t.A^TA=1

maxAAT(h1T−YT)D

XBs.t.ATA=1

(12)中的最优解可以从以下定理得到:定理1[5]:设

S

S

S和

Z

Z

Z是

c

×

k

c×k

c×k矩阵,

Z

Z

Z的秩为

k

k

k。给出以下优化问题:

S

^

=

a

r

g

m

a

x

S

T

r

(

S

T

Z

)

s

.

t

.

S

T

S

=

I

k

\widehat{S}=argmax_S Tr(S^TZ)\\ s.t. S^TS=I_k

S

=argmaxSTr(STZ)s.t.STS=Ik

SVD分解

Z

Z

Z为

Z

=

U

˘

D

˘

V

˘

T

Z=\breve{U}\breve{D}\breve{V}^T

Z=U˘D˘V˘T,那么

S

^

=

U

˘

V

˘

T

\widehat{S}=\breve{U}\breve{V}^T

S

=U˘V˘T

从定理1中,我们可以知道对于给定的

B

B

B和

h

h

h在(12)中,假设SVD为

(

h

1

T

−

Y

T

)

D

^

X

B

(h1^T-Y^T)\widehat{D}XB

(h1T−YT)D

XB是

(

h

1

T

−

Y

T

)

D

^

X

B

=

U

D

~

V

T

(h1^T-Y^T)\widehat{D}XB=U\widetilde{D}V^T

(h1T−YT)D

XB=UD

VT然后

A

=

U

V

T

(

13

)

A=UV^T(13)

A=UVT(13)

为了获得目标函数的局部最优解,迭代算法的细节如表1所示。下一节将证明所提出算法的收敛性。

E. Comparison and Discussion

从以上小节中,我们可以总结出GRR和以前方法之间的主要区别。与传统的岭回归或基于岭回归的方法相比,该方法可以很容易地解决小类问题,获得足够的投影来进行特征选择和提取。Yang等人提出了UDF[31],通过在正则化项上施加

L

2

,

1

−

L_{2,1}-

L2,1−范数最小化,从整个特征集中获得判别特征子集,用于无监督学习[31]。Nie等人提出了RFS[28],通过对损失函数和正则化项施加

L

2

,

1

−

L_{2,1}-

L2,1−范数最小化来保证联合特征选择函数和对异常值的鲁棒性。所有这些基于

L

2

,

1

−

L_{2,1}-

L2,1−范数的方法都在一定程度上取得了良好的性能。然而,大多数方法在特征选择时没有考虑局部几何结构。相比之下,该方法不仅使用损失函数和正则化项的联合

L

2

,

1

−

L_{2,1}-

L2,1−范数最小化作为保证联合稀疏性和鲁棒性的基本度量,而且通过在目标函数上加入局部保持特性,考虑了内在数据的局部几何结构。此外,通过用

L

2

,

1

−

L_{2,1}-

L2,1−范数替换局部项上的

L

2

−

L2-

L2−范数,GRR比传统的基于LPP的方法对异常值更具鲁棒性。其他一些基于LPP的方法在目标函数上用

L

1

−

L1-

L1−范数代替

L

2

−

L2-

L2−范数,在人脸识别中也取得了良好的效果。LPP-L1[7]和DLPP-L1[34]分别在基于LPP[13]和DLPP[35]的局部性术语中使用

L

1

−

L1-

L1−范数而不是

L

2

−

L2-

L2−范数。低秩保持投影(LRPP)利用

L

2

,

1

−

L_{2,1}-

L2,1−范数作为噪声矩阵的稀疏约束来进行降维[36]。与这些方法相比,GRR的优点在于它利用损失函数和正则化项的

L

2

,

1

−

L_{2,1}-

L2,1−范数最小化来保证联合特征选择函数,同时增强了对异常值的鲁棒性。GRR的另一个贡献是,它在损失函数中加入了弹性因子,以提高数据集被噪声或异常值破坏时的鲁棒性。简而言之,GRR是一种新的广义稳健回归方法,用于联合稀疏子空间学习。通过在损失函数、正则化项和局部性项上加入

L

2

,

1

−

L_{2,1}-

L2,1−范数惩罚,GRR可以很容易地获得用于鉴别特征选择的联合稀疏性,同时提高对异常值的鲁棒性。此外,GRR还解决了传统回归方法中的小类问题。此外,GRR通过在损失函数上加入弹性因子来减少数据被强噪声破坏时的负面影响,从而提高了联合稀疏子空间学习的鲁棒性。第四节将介绍实验,以展示这些优势。

我的理解

论文提出了一种名为广义稳健回归(GRR)的新方法,用于解决图像特征提取和识别中的小类问题。GRR结合了岭回归、局部保持投影(LPP)和L2,1-范数的特性,以解决传统方法对异常值敏感、小类问题及缺乏联合稀疏性的不足。通过在损失函数和正则化项上施加L2,1-范数惩罚,GRR增强了鲁棒性并实现了联合稀疏投影,同时利用弹性因子提高模型稳定性。实验证明,GRR在人脸识别任务中表现优越,具有更好的性能和鲁棒性。"

40427757,1024587,Unity3D动态创建对象教程,"['Unity3D开发', '游戏开发', '脚本编程']

论文提出了一种名为广义稳健回归(GRR)的新方法,用于解决图像特征提取和识别中的小类问题。GRR结合了岭回归、局部保持投影(LPP)和L2,1-范数的特性,以解决传统方法对异常值敏感、小类问题及缺乏联合稀疏性的不足。通过在损失函数和正则化项上施加L2,1-范数惩罚,GRR增强了鲁棒性并实现了联合稀疏投影,同时利用弹性因子提高模型稳定性。实验证明,GRR在人脸识别任务中表现优越,具有更好的性能和鲁棒性。"

40427757,1024587,Unity3D动态创建对象教程,"['Unity3D开发', '游戏开发', '脚本编程']

2097

2097

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?