集成学习(Ensemble learning)通过构建并结合多个学习器来完成学习任务

集成学习的一般结构为:先产生一组“个体学习器”,再用某种策略将它们结合起来

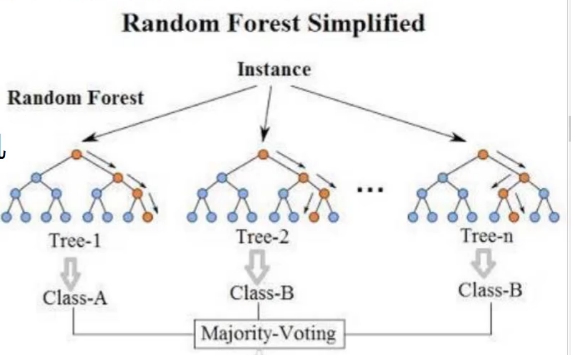

Bagging 随机森林

并行训练多个学习器(多个决策树模型),将分别得到的预测结果综合决策(比如取平均,或以多数为准等)

样本随机采样与特征随机采样,每个树模型的数据、特征都随机选取,比如树模型A随机选择选择80%的数据,60%的特征来做训练,而树模型B随机选择另外的80%的数据,60%的特征来做训练,多个树模型的随机性使得随机森林的泛化性更强,最终的结果更可靠

随机森林训练后可以得出Feature Importance即特征的重要程度

理论上讲,树模型越多效果越好,但是也会有上升的瓶颈

Boosting 提升算法

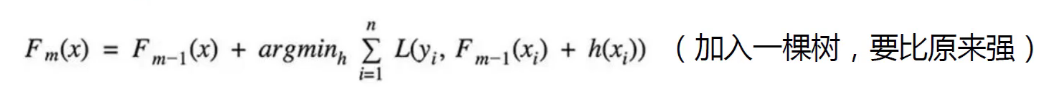

与随机森林并行训练多个树模型不同,提升算法相当于在原有的一个树模型基础上,不断融合进另一个树模型,使得结果变得更好

典型代表为AdaBoost和XgBoost

XgBoost

AdaBoost

Stacking 堆叠模型

分两个阶段,第一个阶段使用多种算法,得出各自的结果,第二个阶段使用前一个阶段的结果,选择一个算法再进行训练

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?