线性分类和线性回归的差别:

输出意义不同:属于某类的概率<->回归具体值

参数意义不同:最佳分类直线<->最佳拟合直线

维度不同:前面的例子中,一个是一维的回归,一个是二维的分类

softmax概念示例图:

人工神经元模型:M-P模型

作用函数

非对称型Sigmoid函数(Log Sigmoid)

对称型Sigmoid函数(Tangent Sigmoid)

对称型阶跃函数

Hebb规则:

目标定位:常用的定位方法有边界框定位和特征点定位;同时,定位问题与分类问题的区别无非在神经网络的输出环节多输出了几个数字用于传达更多的信息。 目标检测:常用的方法有滑动窗口算法和YOLO算法。YOLO算法改善了滑动窗口边界框定位不准的问题,同时运算效率高,甚至可用于实时检测。

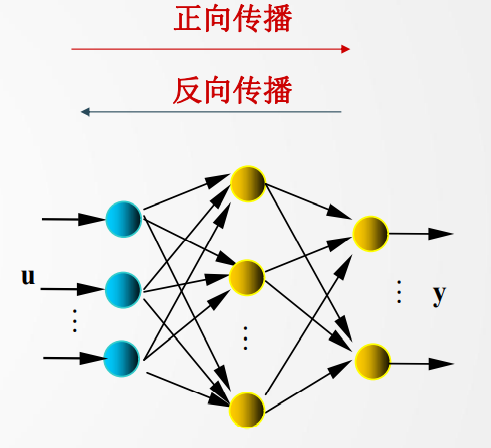

多层感知机(多层前馈神经网络)

在输入和输出层之间加一或多层隐单元。三层网络便可以解决异或(XOR)问题。

多层前馈网络的反向传播 (BP)学习算法,简称BP算法

正向传播是输入信号从输入层经隐层,传向输出层,若输出层得到了期望的输出,则学习算法结束;否则,转至反向传播。反向传播是将误差(样本输出与网络输出之差)按原联接通路反向计算,由梯度下降法调整各层节点的权值和阈值,使误差减小。

Tips:层用上标[l]表示,共L层。其中输入为第0层,输出为L层。

表示连接第l层第i个节点和第l-1层第j个节点的权值

表示连接第l层第i个节点和第l-1层第j个节点的权值

BP算法基本思想——梯度下降算法

① 设置初始权系数 为较小的随机非零值;

为较小的随机非零值;

② 给定输入/输出样本对,计算网络输出, 完成前向传播

③ 计算目标函数J。如 , 训练成功,退出;否则转入④

, 训练成功,退出;否则转入④

④ 反向传播计算 由输出层,按梯度下降法将误差反向传播,逐层调整权值。

文章探讨了线性分类与线性回归的区别,如输出意义、参数含义和维度差异。介绍了softmax在分类中的应用,以及人工神经元模型,包括Sigmoid和阶跃函数。接着讨论了目标定位与分类的区别,提到了YOLO算法在目标检测中的高效性。最后,讲解了多层感知机和反向传播(BP)算法在神经网络学习中的作用。

文章探讨了线性分类与线性回归的区别,如输出意义、参数含义和维度差异。介绍了softmax在分类中的应用,以及人工神经元模型,包括Sigmoid和阶跃函数。接着讨论了目标定位与分类的区别,提到了YOLO算法在目标检测中的高效性。最后,讲解了多层感知机和反向传播(BP)算法在神经网络学习中的作用。

1626

1626

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?