1.基本原理

一元凸函数求极值

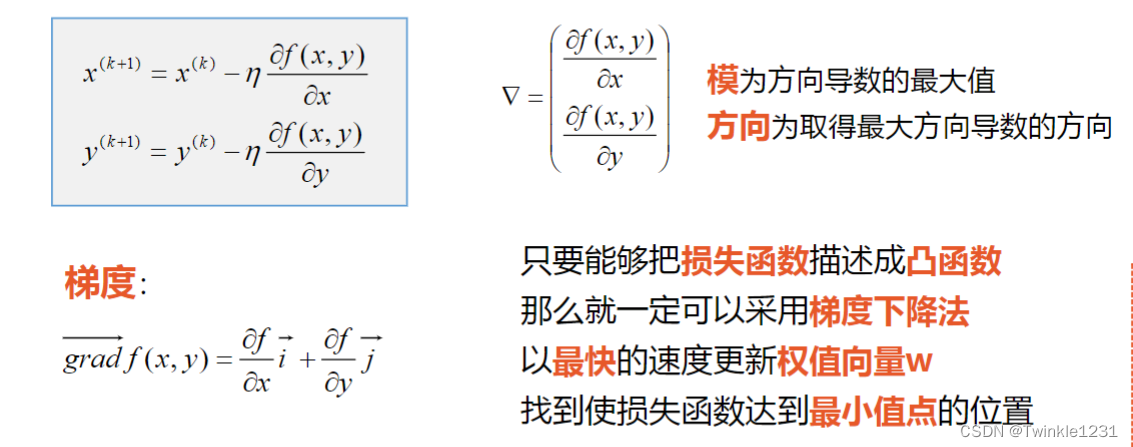

二元凸函数求极值

2.梯度下降法实现线性回归问题

一元线性回归可以转换为二元函数求极值的问题

学习率:对于凸函数,只要学习率设置的足够小,可以保证一定收敛。

超参数:在开始学习之前设置,不是通过训练得到的。

(包含学习率、迭代次数等)

归一化/标准化:将数据的值限制在一定的范围之内

使所有属性处于同一个范围、同一个数量级下;更快收敛到最优解;提高学习器的精度。

3.模型评估

误差(error):学习器的预测输出和样本的真实标记之间的差异

训练误差(traning error):训练集上的误差

泛化误差(generalization error):在新样本上的误差

过拟合(overfitting):学习过度,在训练集上表现很好,在新样本上泛化误差很大

欠拟合(underfitting):学习不足,没有学习到样本中的通用的特征

1463

1463

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?