前言

在这个科技飞速发展的时代,AI技术已经渗透到我们生活的方方面面。你是否曾经幻想过拥有一个属于自己的智能助手?想象一下,在你的电脑上就能运行强大的语言模型,并且能够为你解答各种问题、提供个性化建议,是不是很酷呢?

今天,我们就来一起探索如何在Windows环境中本地搭建这样一个大语言模型应用!我们将详细介绍每一步操作,从下载和安装Ollama框架到配置LLaMA2模型,再到使用MaxKB将这个强大的工具集成到你的知识库中。最重要的是,整个过程完全不需要公网IP或域名,只需要一个小小的内网穿透工具cpolar就能搞定。

无论你是AI初学者还是有一定基础的技术爱好者,这篇文章都将为你提供详尽的指导和实用的操作步骤。让我们一起开启这段激动人心的技术之旅吧!

1. 下载运行Ollama

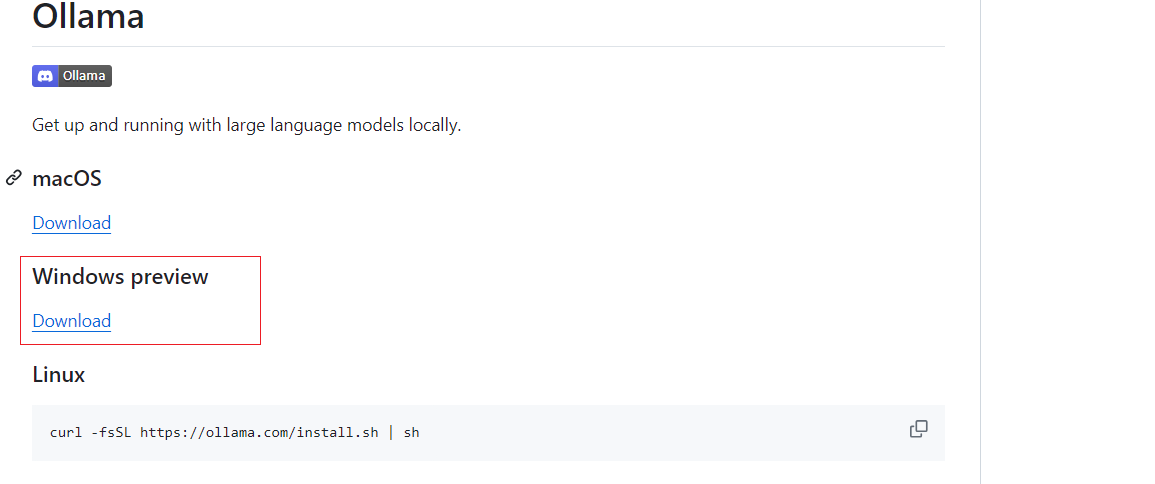

进入Ollama Github 界面:https://github.com/ollama/ollama?tab=readme-ov-file ,我们选择windwos版本下载

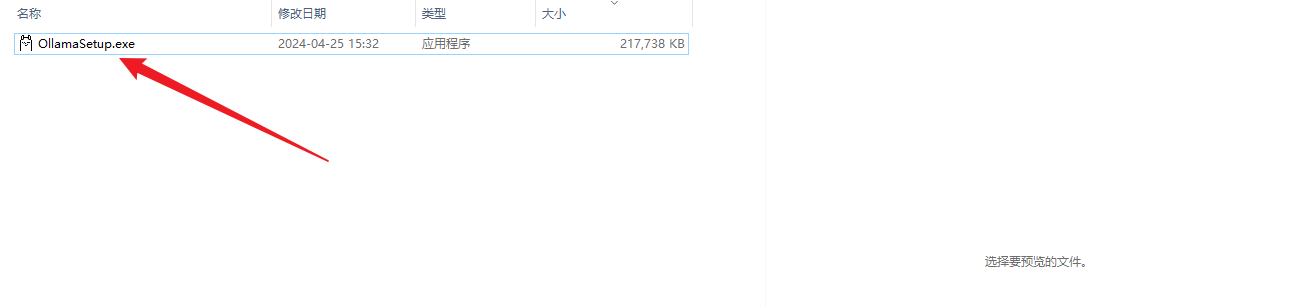

下载后,双击进行安装,默认会安装到C盘,然后等待安装完成,安装完成后正常会自动运行,如果没有运行,可以去应用列表双击运行即可

然后打开命令窗口,输入:ollama -v,可以看到版本信息

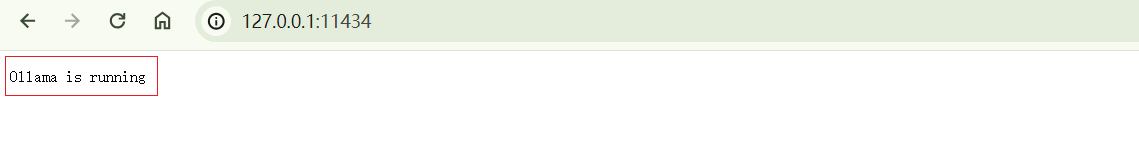

同样,在浏览器输入http://127.0.0.1:11434/访问ollama服务,即可看到,运行的字样,表示本地运行成功了,下面进行安装大语言模型.

2. 安装大语言模型

ollama安装完成后,下面进行下载运行大语言模型,本例采用llama2模型,当然还有其他模型,可以到github上面选择,命令窗口输入下面命令

ollama run llama2

然后等待安装完成即可,出现success 表示下载完成了,然后按ctrl&

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?