Zookeeper

1、Zookeeper快速入门

1.1、Zookeeper 概述

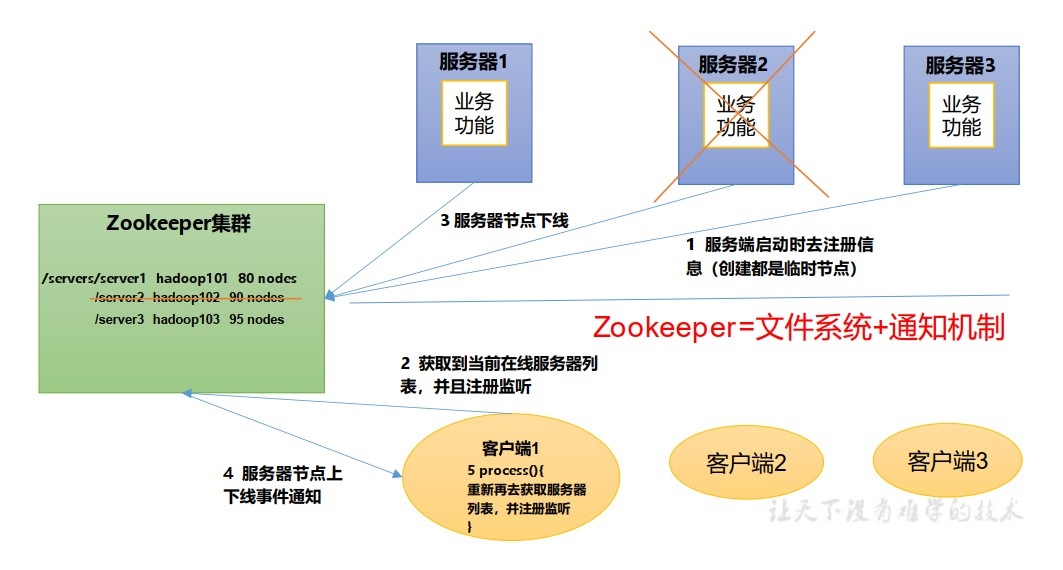

- Zookeeper 是一个基于观察者模式设计的分布式服务管理框架,负责存储和管理数据,接受观察者的注册,一旦这些数据的状态发生变化,Zookeeper 就将负责通知已经在Zookeeper上注册的那些观察者做出相应的反应。

1.2、Zookeeper 的特点

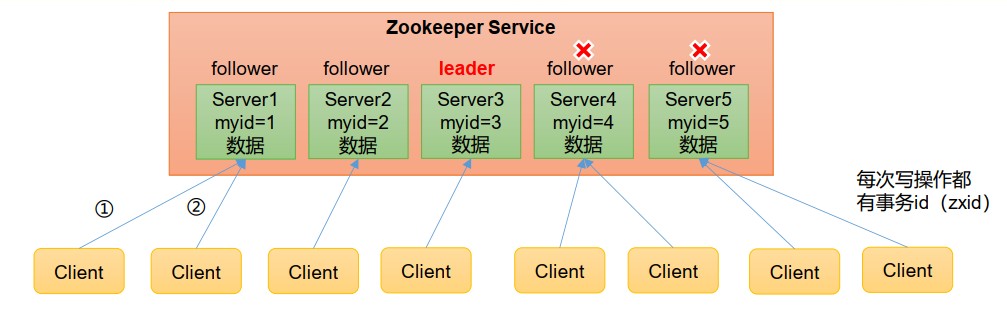

1):Zookeeper :一个领导者 (Leader),多个跟随者 (Follower)组成的集群。

2):集群中只要有半数以上节点存活,Zookeeper 集群就能正常服务,所以Zookeeper 适合安装奇数台服务器。

3):全局数据一致:每个Server保存一份相同的数据副本,Client无论连接到哪个Server,数据都是一致的。

4):更新请求顺序执行,来自同一个Client的更新请求按其发送顺序依次执行。

5):数据更新原子性,一次数据更新要么成功,要么失败。

6):实时性,在一定时间范围内,Client能读到最新数据。

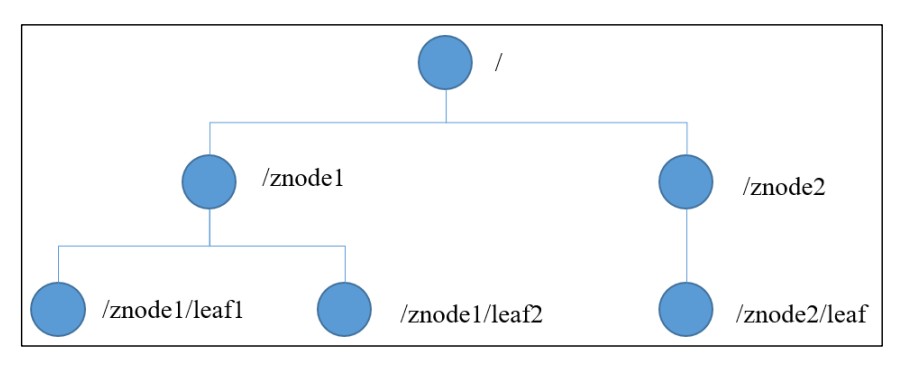

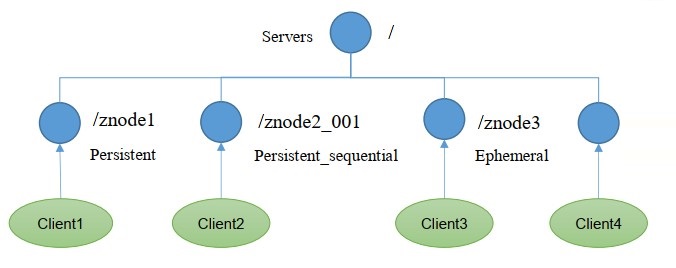

1.3、数据结构

- Zookeeper 数据模型的结构与Unix 文件系统很类似,像一个分布式的小文件存储系统,整体上可以看作是一棵树,每个节点称做一个 ZNode。每一个 ZNode 默认能够存储 1MB 的数据,每个 ZNode 都可以通过其路径唯一标识。

1.4、应用场景

-

提供的服务包括:统一命名服务、统一配置管理、统一集群管理、服务器节点动态上下线、软负载均衡等 。

-

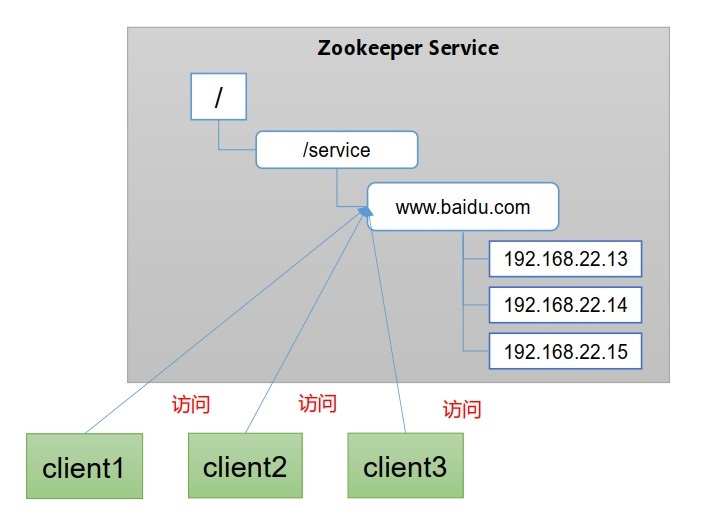

同一服务命名:在分布式环境下,经常需要对应用/服务进行统一命名,便于识别。例如:IP不容易记住,而域名容易记住。

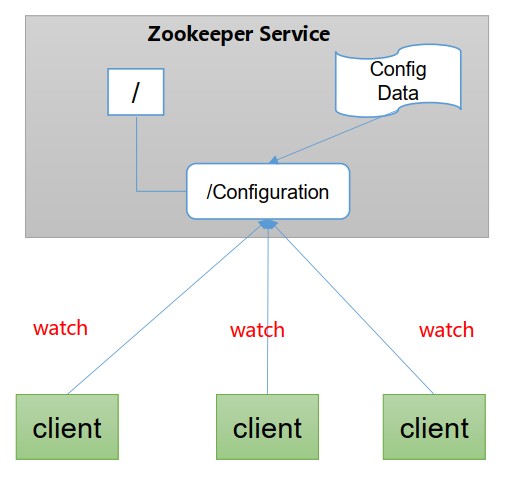

- 统一配置管理

- 分布式环境下,配置文件同步非常常见:1、一般要求一个集群中,所有节点的配置信息是一致的,比如Kafka集群。2、对配置文件修改之后,希望能够快速同步到各个节点上。

- 配置管理可交由Zookeeper实现:1、可将配置信息写入Zookeeper上的一个Znode。2、各个客户端服务器监听这个Znode。3、一旦Znode中的数据被修改,Zookeeper将通知各个客户端服务器。

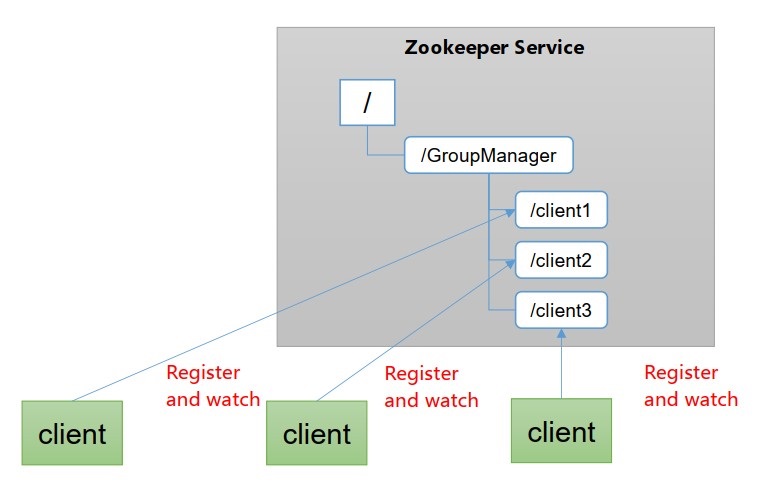

- 同一集群管理

- 分布式环境中,实时掌握每个节点的状态是必要的:可根据节点实时状态做出一些调整。

- Zookeeper可以实现实时监控节点状态变化:1、可将节点信息写入Zookeeper上的一个Znode。2、监听这个Znode可获取它的实时状态变化。

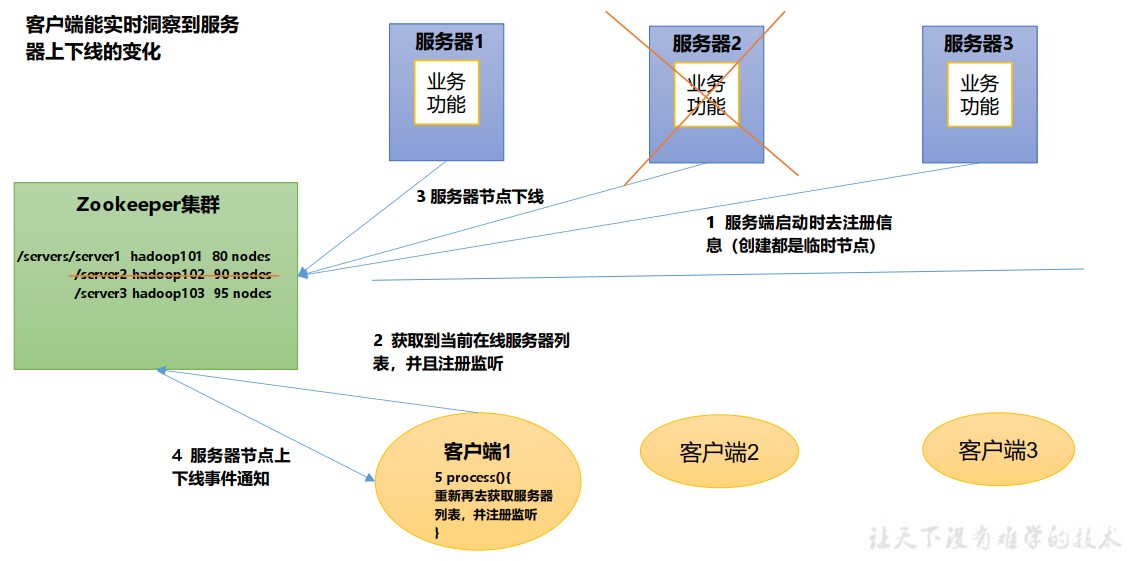

- 服务器动态上下线

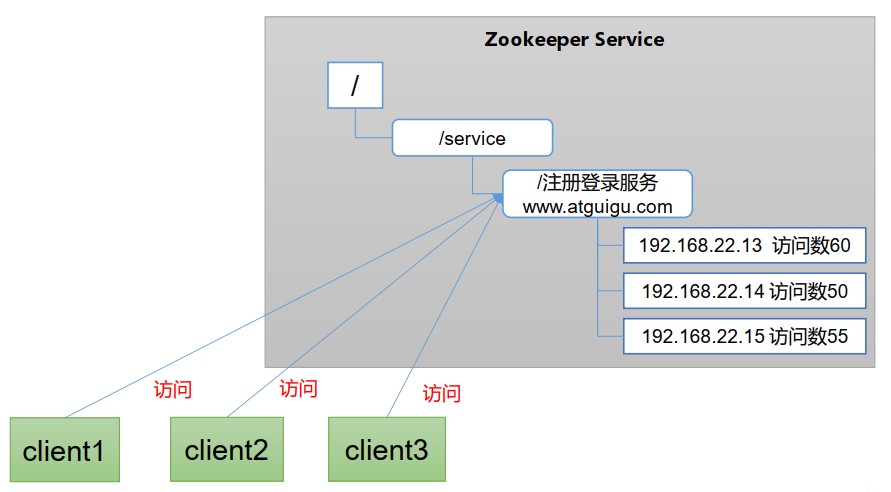

- 负载均衡:在Zookeeper中记录每台服务器的访问数,让访问数最少的服务器去处理最新的客户daunt请求

2、Zookeeper操作

2.1、简单操作:

1、启动Zookeeper:

[root@192 zookeeper-3.5.7]# bin/zkServer.sh start

2、查看进程是否启动

[root@192 zookeeper-3.5.7]# jps

102109 Jps

20286 QuorumPeerMain

3、查看状态

[root@192 zookeeper-3.5.7]# bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost.

Mode: standalone

4、启动客户端

[root@192 zookeeper-3.5.7]# bin/zkCli.sh

5、退出客户端

[zk: localhost:2181(CONNECTED) 0] quit

6、停止Zookeeper

[root@192 zookeeper-3.5.7]# bin/zkServer.sh stop

2.2、配置参数解读

- Zookeeper中的配置文件zoo.cfg中参数含义解读如下 :

- tickTime = 2000: 通信心跳时间, Zookeeper服务器与客户端心跳时间,单位毫秒

- initLimit = 10: LF初始通信时限 :Leader和Follower初始连接时能容忍的最多心跳数(tickTime的数量)

- syncLimit = 5: LF同步通信时限 :Leader和Follower之间通信时间如果超过syncLimit * tickTime, Leader认为Follwer死

掉,从服务器列表中删除Follwer - dataDir: 保存Zookeeper中的数据 。注意: 默认的tmp目录,容易被Linux系统定期删除,所以一般不用默认的tmp目录。

- clientPort = 2181:客户端连接端口,通常不做修改。

3、Zookeeper 集群操作

3.1、集群操作

3.1.1、集群安装

-

集群规划:在 hadoop102、 hadoop103 和 hadoop104 三个节点上都部署 Zookeeper。

- 思考:如果是 10 台服务器,需要部署多少台 Zookeeper?

-

解压安装

1、在 hadoop102 解压 Zookeeper 安装包到/opt/module/目录下 :

[192@hadoop102 software]$ tar -zxvf apache-zookeeper-3.5.7-bin.tar.gz -C /opt/module/

2、修改 apache-zookeeper-3.5.7-bin 名称为 zookeeper-3.5.7

[192@hadoop102 module]$ mv apache-zookeeper-3.5.7-bin/zookeeper-3.5.7

-

配置服务器编号

1、在/opt/module/zookeeper-3.5.7/这个目录下创建 zkData

[192@hadoop102 zookeeper-3.5.7]$ mkdir zkData

2、在/opt/module/zookeeper-3.5.7/zkData 目录下创建一个 myid 的文件

[192@hadoop102 zkData]$ vi myid

在文件中添加与 server 对应的编号(注意:上下不要有空行,左右不要有空格)

2

注意: 添加 myid 文件,一定要在 Linux 里面创建,在 notepad++里面很可能乱码

3、拷贝配置好的 zookeeper 到其他机器上

[192@hadoop102 module ]$ xsync zookeeper-3.5.7

并分别在 hadoop103、 hadoop104 上修改 myid 文件中内容为 3、 4

-

配置zoo.cfg文件

1、重命名/opt/module/zookeeper-3.5.7/conf 这个目录下的 zoo_sample.cfg 为 zoo.cfg

[192@hadoop102 conf]$ mv zoo_sample.cfg zoo.cfg

2、打开 zoo.cfg 文件

[192@hadoop102 conf]$ vim zoo.cfg

#修改数据存储路径配置

dataDir=/opt/module/zookeeper-3.5.7/zkData

#增加如下配置

#######################cluster##########################

server.2=hadoop102:2888:3888

server.3=hadoop103:2888:3888

server.4=hadoop104:2888:3888

3、配置参数解读

server.A=B:C:D。

A 是一个数字,表示这个是第几号服务器;

集群模式下配置一个文件 myid, 这个文件在 dataDir 目录下,这个文件里面有一个数据就是 A 的值, Zookeeper 启动时读取此文件,拿到里面的数据与 zoo.cfg 里面的配置信息比较从而判断到底是哪个 server。

B 是这个服务器的地址;

C 是这个服务器 Follower 与集群中的 Leader 服务器交换信息的端口;

D 是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新的

Leader,而这个端口就是用来执行选举时服务器相互通信的端口。

4、同步 zoo.cfg 配置文件

[192@hadoop102 conf]$ xsync zoo.cfg

-

集群操作

1、分别启动 Zookeeper

[192@hadoop102 zookeeper-3.5.7]$ bin/zkServer.sh start

[192@hadoop103 zookeeper-3.5.7]$ bin/zkServer.sh start

[192@hadoop104 zookeeper-3.5.7]$ bin/zkServer.sh start

2、查看状态

[192@hadoop102 zookeeper-3.5.7]# bin/zkServer.sh status

JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Mode: follower

[192@hadoop103 zookeeper-3.5.7]# bin/zkServer.sh status

JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Mode: leader

[192@hadoop104 zookeeper-3.4.5]# bin/zkServer.sh status

JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Mode: follower

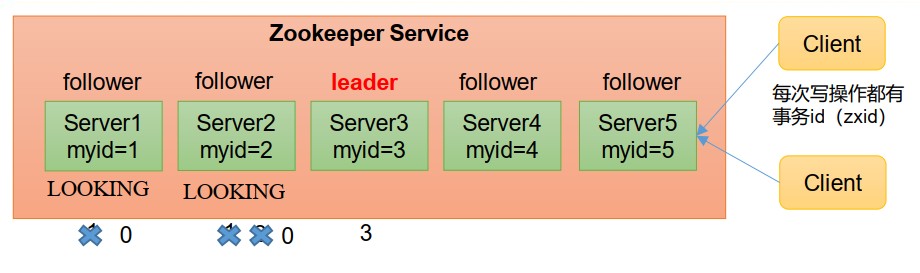

3.1.2 选举机制

- 第一次启动

- 服务器1启动,发起一次选举。服务器1投自己一票。此时服务器1票数一票,不够半数以上(3票),选举无法完成,服务器1状态保持为 LOOKING;

- 服务器2启动,在发起一次选举。服务器1和2分别投自己一票并交换选票信息:此时服务器1发现服务器2的myid比自己目前投票推举的(服务器1)大,更改选票为推举服务器2。此时服务器1票数0票,服务器2票数2票,没有半数以上结果,选举无法完成,服务器1和2保持状态LOOKING。

- 服务器3启动,发起一次选举。此时服务器1和2都会更改选票为服务器3.此次投票结果:服务器1为0票,服务器2为0票,服务器3为3票,此时服务器3的票数已经超过半数,服务器3当选Leader。服务器1,2更改状态为FOLLOWING,服务器3更改状态为LEADING。

- 服务器4启动,发起一次选举。此时服务器1,2,3已经不是LOOKING状态,不会更改选票信息。交换选票结果:服务器3位3票,服务器4为1票。此时服务器4服从多数,更改选票信息为服务器3,并更改状态为FOLLOING。

- 服务器5启动,同4一样当小弟。

SID:服务器ID。用来唯一标识一台Zookeeper集群中的机器,每台机器不能重复,和myid一致。

ZXID:事务ID。ZXID是一个事务ID,用来表示一次服务器状态的变更。在某一时刻,集群中的每台机器的ZXID值不一定完全一致,这和Zookeeper服务器对于客户端“更新请求”的处理逻辑有关。

Epoch:每个Leader任期的代号。没有Leader时同一轮投票过程中的逻辑时钟值是相同的。每投完一次票这个数据就会增加。

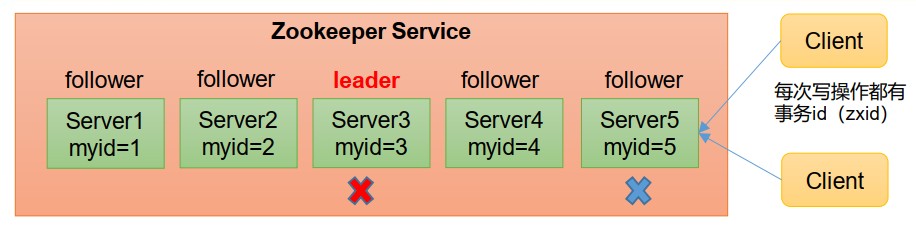

- 非第一次启动

- 当Zookeeper集群中的一台服务器出现以下两种情况之一时,就会开始进入Leader选举:

- 服务器初始化启动

- 服务器运行期间无法和Leader保持连接

- 而当一台机器进入Leader选举流程时,当前集群也可能会处于以下两种状态:

- 集群中本来就已经存在一个Leader:机器试图去选举Leader时,会被告知当前服务器的Leader信息,对于该机器来说, 仅仅需要和Leader机器建立连接,并进行状态同步即可。

- 集群中确实不存在Leader:假设Zookeeper由5台服务器组成,SID分别为1、2、3、4、5,ZXID分别为8、8、8、7、7,并且此时SID为3的服务器是Leader。某一时刻3和5服务器出现故障,因此开始进行Leader选举。选举规则:1、EPOCH大的直接胜出,2、EPOCH相同,事务id大的胜出,3、事务id相同,服务器id大的胜出。

- 当Zookeeper集群中的一台服务器出现以下两种情况之一时,就会开始进入Leader选举:

3.1.3 ZK 集群启动停止脚本

- 在 hadoop102 的/home/ktf/bin 目录下创建脚本

[192@hadoop102 bin]$ vim zk.sh

在脚本中编写如下内容

#!/bin/bash

case $1 in

"start"){

for i in hadoop102 hadoop103 hadoop104

do

echo ---------- zookeeper $i 启动 ------------

ssh $i "/opt/module/zookeeper-3.5.7/bin/zkServer.sh

start"

done

};;

"stop"){

for i in hadoop102 hadoop103 hadoop104

do

echo ---------- zookeeper $i 停止 ------------

ssh $i "/opt/module/zookeeper-3.5.7/bin/zkServer.sh

stop"

done

};;

"status"){

for i in hadoop102 hadoop103 hadoop104

do

echo ---------- zookeeper $i 状态 ------------

ssh $i "/opt/module/zookeeper-3.5.7/bin/zkServer.sh

status"

done

};;

esac

- 增加脚本执行权限

[192@hadoop102 bin]$ chmod u+x zk.sh

- Zookeeper 集群启动脚本

[192@hadoop102 module]$ zk.sh start

- Zookeeper 集群停止脚本

[192@hadoop102 module]$ zk.sh stop

3.2、客户端命令行操作

3.2.1、命令行基本语法

| 命令基本语法 | 功能描述 |

|---|---|

| help | 显示所有操作命令 |

| ls path | 使用 ls 命令来查看当前 znode 的子节点 [可监听] |

| -w 监听子节点变化 | |

| -s 附加次级信息 | |

| create | 普通创建 |

| -s 含有序列 | |

| -e 临时(重启或者超时消失) | |

| get path | 获得节点的值 [可监听] |

| -w 监听节点内容变化 | |

| -s 附加次级信息 | |

| set | 设置节点的具体值 |

| stat | 查看节点状态 |

| delete | 删除节点 |

| deleteall | 递归删除节点 |

- 启动客户端

[192@hadoop102 zookeeper-3.5.7]$ bin/zkCli.sh -server hadoop102:2181

- 显示所有操作命令

[zk: hadoop102:2181(CONNECTED) 1] help

3.2.2 znode 节点数据信息

- 查看当前znode中所包含的内容

[zk: hadoop102:2181(CONNECTED) 0] ls /

[zookeeper]

- 查看当前节点详细数据

[zk: hadoop102:2181(CONNECTED) 5] ls -s /

[zookeeper]cZxid = 0x0 // 创建节点的事务 zxid

ctime = Thu Jan 01 08:00:00 CST 1970 //znode 被创建的毫秒数(从 1970 年开始)

mZxid = 0x0 // znode 最后更新的事务 zxid

mtime = Thu Jan 01 08:00:00 CST 1970 // znode 最后修改的毫秒数(从 1970 年开始)

pZxid = 0x0 // znode 最后更新的子节点 zxid

cversion = -1 // znode 子节点变化号, znode 子节点修改次数

dataVersion = 0 // znode 数据变化号

aclVersion = 0 // znode 访问控制列表的变化号

ephemeralOwner = 0x0 // 如果是临时节点,这个是 znode 拥有者的 session id。如果不是临时节点则是 0。

dataLength = 0 // znode 的数据长度

numChildren = 1 // znode 子节点数量

3.2.3 节点类型(持久/短暂/有序号/无序号)

- 持久(Persistent):客户端和服务器断开连接后,创建的节点不删除

- 短暂(Ephemeral):客户端和服务器断开连接后,创建的节点自己删除

- 持久化目录节点:客户端与Zookeeper断开连接后,该节点依旧存在

- 持久化顺序编号目录节点:客户端与Zookeeper断开连接后,该节点依旧存在,只是Zookeeper给 该节点名称进行顺序编号

- 临时目录节点:客户端与Zookeeper断开连接后,该节点被删除

- 临时顺序编号目录节点:客户端与Zookeeper断开连接后,该节点被删除,只是Zookeeper给该节点名称进行顺序编号。

说明:创建Znode时设置顺序表示,Znode名称后会附加一个值,顺序号是一个单调递增的计数器,由父节点维护。

注意:在分布式系统中,顺序号可以被用于为所有的事件进行全局排序,这样客户端可以通过顺序号推断事件的顺序。

1、分别创建2个普通节点(永久节点 + 不带序号)

[zk: localhost:2181(CONNECTED) 3] create /sanguo "diaochan"

Created /sanguo

[zk: localhost:2181(CONNECTED) 4] create /sanguo/shuguo "liubei"

Created /sanguo/shuguo

注意:创建节点时, 要赋值

2、获得节点的值

[zk: localhost:2181(CONNECTED) 5] get -s /sanguo

diaochan

cZxid = 0x100000003

ctime = Wed Aug 29 00:03:23 CST 2018

mZxid = 0x100000003

mtime = Wed Aug 29 00:03:23 CST 2018

pZxid = 0x100000004

cversion = 1

dataVersion = 0

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 7

numChildren = 1

[zk: localhost:2181(CONNE

本文全面深入地探讨了Zookeeper,包括快速入门、数据结构、集群操作、分布式锁实现和源码分析。重点讲解了Zookeeper的选举机制、客户端操作以及Paxos算法和ZAB协议。此外,还涵盖了Zookeeper在分布式锁和数据一致性中的应用。

本文全面深入地探讨了Zookeeper,包括快速入门、数据结构、集群操作、分布式锁实现和源码分析。重点讲解了Zookeeper的选举机制、客户端操作以及Paxos算法和ZAB协议。此外,还涵盖了Zookeeper在分布式锁和数据一致性中的应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2567

2567

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?