Java -version 查看 jdk版本

whereis javac 查看jdk安装路径

搭建spark

搭建单机版本

在/data/spark目录下上传spark的包

解压压缩包

tar -xzvf spark-2.4.4-bin-hadoop2.7.tgz

修改文件夹的名字(去掉版本号)

mv spark-2.4.4-bin-hadoop2.7/ spark

安装好后尝试运行一下圆周率

bin/run-example SparkPi 10

这次把圆周率次数调大,让spark运行的时间加长然后从网页中访问运行的进度

这次把圆周率次数调大,让spark运行的时间加长然后从网页中访问运行的进度

bin/run-example SparkPi 100000

在网页中访问运行的进度

http://node7-1:4040/

node7-3

node7-4

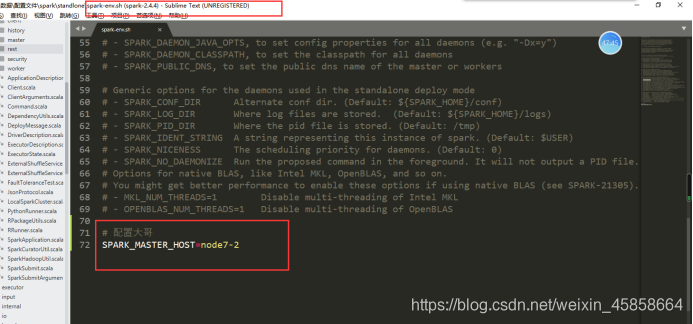

配置文件:(复制conf/spark-env.sh.template为spark-env.sh)

SPARK_MASTER_HOST=node7-2

启动大哥

sbin/start-master.sh

启动小弟

#参数是大哥的Url

sbin/start-slave.sh spark://node7-2:7077

启动脚本(只需要在大哥上启动-node7-2)

sbin/start-all.sh

停止脚本(只需要在大哥上停止-node7-2)

sbin/stop-all.sh

集群高可用和yarn

启动zookeeper

配置大哥;在二哥上面,MASTER_PORT=指的是自己

SPARK_MASTER_HOST=node7-1

#设置zookeepr,不能换行

SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER-Dspark.deploy.zookeeper.url=node7-1:2181,node7-2:2181,node7-3:2181 -Dspark.deploy.zookeeper.dir=/spark"

告诉Spark,hadoop放到哪里面了,前题是每一个Spark,的服务器上都装有hadoop

HADOOP_CONF_DIR=/data/hadoop/hadoop/etc/hadoop/

在启动之前确认node7-2,node7-3,node7-4配置文件一样

访问的时候:

启动spark集群(standlone-高可用);启动脚本(只需要在大哥上启动-node7-2)

http://node7-2:8081/

由于8080被占用了,就换成了8081

使用下面这个命令可以查看是哪个应用程序在使用这个端口

netstat -anp|grep 8080

启动二哥(在node7-1)上启动

sbin/start-master.sh

#–master:把任务提交给大哥;

#node7-1:7077可以去掉 bin/spark-submit

–master spark://xiaobai02:7077,xiaobai01:7077

–name myPi

–class org.apache.spark.examples.SparkPi \ examples/jars/spark-examples_2.11-2.4.4.jar \ 100000

bin/spark-submit

–master spark://xiaobai02:7077

–name myPi

–class org.apache.spark.examples.SparkPi \ examples/jars/spark-examples_2.11-2.4.4.jar \ 100000

417

417

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?