前言

在之前的一篇里面已经写了flume的单机部署以及两个采集,一个是监听日志端口,一个是采集目录到HDFS。这篇主要是对flume进行简介 和采集文件到HDFS

一、概述

Flume 是 Cloudera 提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的软件。

Flume 的核心是把数据从数据源(source)收集过来,再将收集到的数据送到指定的目的地(sink)。为了保证输送的过程一定成功,在送到目的地(sink)之前,会先缓存数据(channel),待数据真正到达目的地(sink)后,flume 在删除自己缓存的数据。

Flume 支持定制各类数据发送方,用于收集各类型数据;同时,Flume 支持定制各种数据接受方,用于最终存储数据。一般的采集需求,通过对 flume 的简单配置即可实现。针对特殊场景也具备良好的自定义扩展能力。因此,flume 可以适用于大部分的日常数据采集场景。

二、运行机制

Flume 系统中核心的角色是 agent,agent 本身是一个 Java 进程,一般运行在日志收集节点。

-

每一个 agent 相当于一个数据传递员,内部有三个组件:

- Source:采集源,用于跟数据源对接,以获取数据;

- Sink:下沉地,采集数据的传送目的,用于往下一级 agent 传递数据或者往最终存储系统传递数据;

- Channel:agent 内部的数据传输通道,用于从 source 将数据传递到 sink;

-

在整个数据的传输的过程中,流动的是 event,它是 Flume 内部数据传输的最基本单元。event 将传输的数据进行封装。如果是文本文件,通常是一行记录,event 也是事务的基本单位。event 从 source,流向 channel,再到 sink,本身为一个字节数组,并可携带 headers(头信息)信息。event 代表着一个数据的最小完整单元,从外部数据源来,向外部的目的地去。

-

一个完整的 event 包括:event headers、event body、event 信息,其event 信息就是 flume 收集到的日记记录。

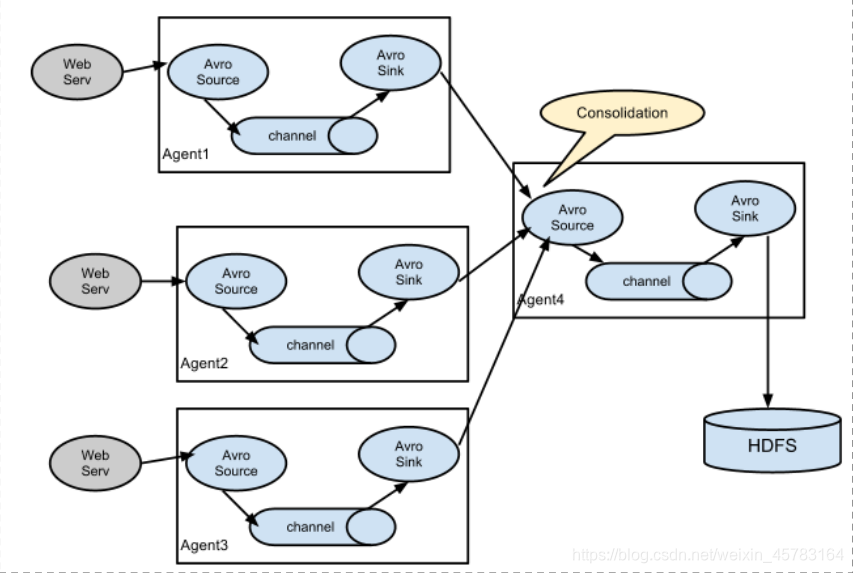

三、Flume采集系统结构图

简单结构

单个 agent 采集数据

复杂结构

多级 agent 之间串联

四、采集文件到HDFS

采集文件到HDFS

在flume的目录下进入./conf目录

vi tail-hdfs.conf

本文介绍了Flume的基本概念、运行机制以及如何将文件数据采集到HDFS。Flume作为Cloudera提供的大数据采集工具,通过Source、Channel和Sink实现数据的可靠传输。文中详细阐述了Flume agent的组件及其工作流程,并提供了设置Flume采集文件到HDFS的步骤和模拟数据生成的方法。

本文介绍了Flume的基本概念、运行机制以及如何将文件数据采集到HDFS。Flume作为Cloudera提供的大数据采集工具,通过Source、Channel和Sink实现数据的可靠传输。文中详细阐述了Flume agent的组件及其工作流程,并提供了设置Flume采集文件到HDFS的步骤和模拟数据生成的方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8057

8057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?