1.为什么会提出图神经网络?

答:为了处理图Graph这种特殊的数据结构。

2.为什么要与神经网络搭上关系?

答:利用神经网络能够拟合任意函数的能力(或者理解为强大的为特征变换能力)。

3.图神经网络的最终目的是什么?

答:最根本的目的:给节点做特征聚合。原因如下,首先图神经网络的提出是在卷积CNN的基础上提出的,通过不断堆层,最下层的特征图就能够获取整张图片的信息。在图结构中,目的也是将整个图的信息汇聚到节点身上。

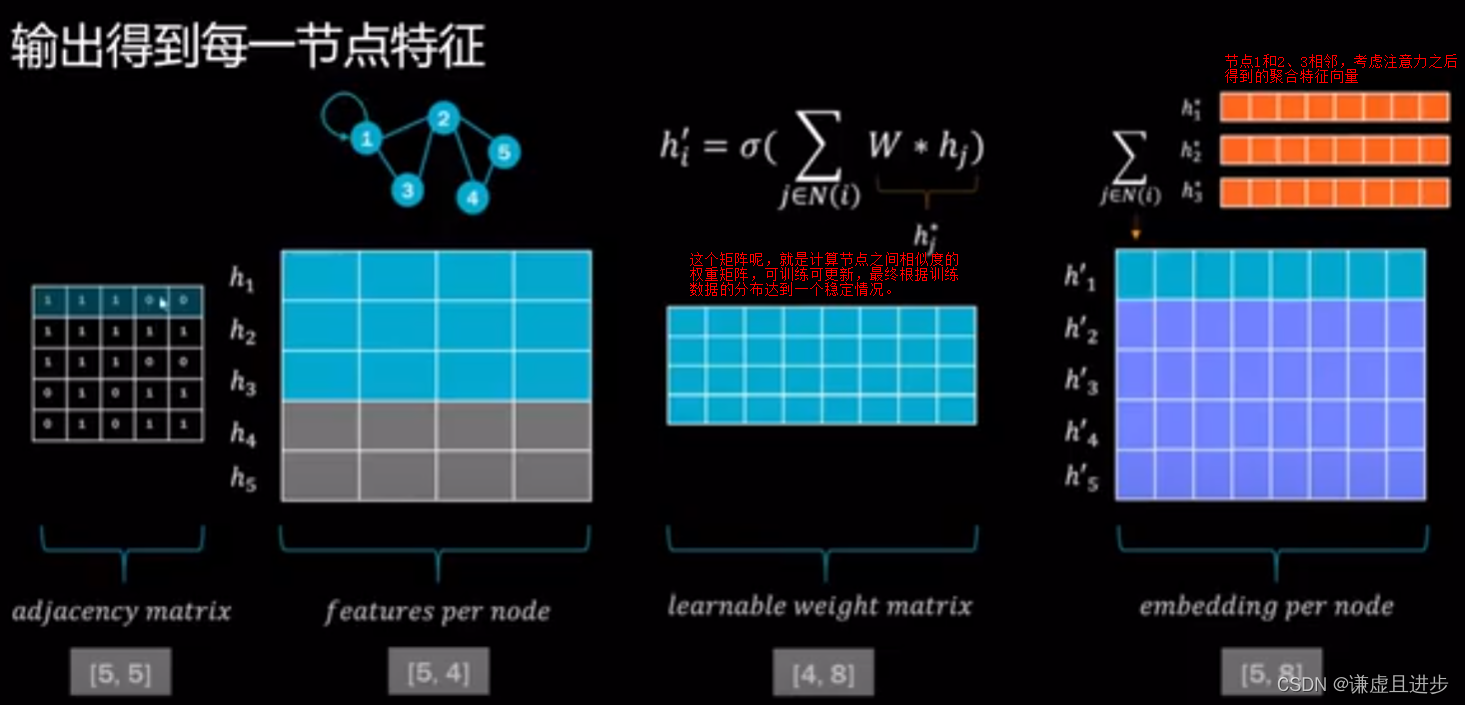

4.神经网络如何给节点做特征聚合呢?

答:每一个节点都需要聚合图中其他节点的信息,把这个聚合过程当中一个函数,神经网络的作用就是学习这些聚合函数,如果有10个节点,就需要学习10个特征聚合函数。

5.做节点特征聚合的方式有哪些?

答:利用下面的方法,不断地堆层即可(堆2-3层即可)。注意:堆层就叫做图卷积。这里的卷积只是借鉴了图像领域卷积的意义,操作方式和图像领域地卷积是不同的。

6.图神经网络的样本形状是什么样的?

答:①可以只有一个图样本。比如只有一张很大图,节点上百个,此时,更小的样本就是节点了,我们可以做节点分类、节点状态估计等操作。这种操作就是实际上就是在一张图上给节点特征做聚合其他节点信息的特征变换。

②可以有多个样本,即大量的图样本,此时需要考虑batch的概念。实际上,这才是真正的神经网络,因为神经网络就是在指定数据集上进行似然,使模型适应数据集的数据分布情况。这种情况下,网络不断学习大量样本,聚合函数更具鲁棒性。

7.图神经网络与注意力结合?

答:这里有自注意力机制为例,自注意力机制本质上就是一个特征加权的过程,把别人的特征通过注意力得分加到自己身上的过程,这一点和节点信息聚合是类似的。

但是在图神经网络当中,不关注每个节点的重要性,而是关注节点之间(边)的重要性,重要性可以根据节点特征的相似度进行计算。如果不考虑注意力机制,最原始的就是哪个A~归一化矩阵,考虑注意力机制的话,就得对便之间的联系进行修正,此时加一个修正权重矩阵即可。

8.图神经网络与时间序列结合?

答:我们已经指定图神经网络就是做特征聚合换用的。图时间序列结合是指每一个时刻的数据都是图,而不是一个截面多特征变量了。而且与时间序列有关的神经网络模型适应RNN,通过学习和编码大量时间序列数据得到一个高阶的向量Ht。所以图神经网络与时间序列结合,即T-GNN的基本要求就是,给RNN的每一个时刻提供信息聚合之后的特征向量。

总结:

1.图神经网络的处理对象是图Graph结构。本质上就是一种特征聚合变换的方法,考虑整个图个特征,原理类似于自注意力机制,是一个将其他特征加权到自身的过程。神经网络在里面的作用是实现一个端到端的优化任务(梯度下降),进而实现这种特征自动聚合,即自动学习特征的功能。

2.图神经网络与注意力机制的结合主要是考虑节点之间的联系程度。而不着重考虑每个节点的重要性。

本文围绕图神经网络展开,介绍其提出是为处理图结构数据,利用神经网络拟合能力做节点特征聚合。阐述了特征聚合方式、样本形状,还探讨了与注意力机制、时间序列的结合,本质是特征聚合变换方法,神经网络实现自动学习特征。

本文围绕图神经网络展开,介绍其提出是为处理图结构数据,利用神经网络拟合能力做节点特征聚合。阐述了特征聚合方式、样本形状,还探讨了与注意力机制、时间序列的结合,本质是特征聚合变换方法,神经网络实现自动学习特征。

1311

1311

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?