1.logstash简介

官网地址: Logstash: Collect, Parse, Transform Logs | Elastic

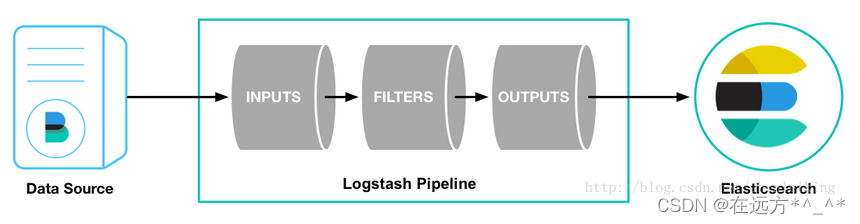

Logstash是一个开源的服务器端数据处理管道。

logstash拥有200多个插件,能够同时从多个来源采集数据,转换数据,然后将数据发送到“存储库” 中。(大多都是 Elasticsearch。)

Logstash管道有两个必需的元素,输入和输出,以及一个可选元素过滤器。

输入:采集各种样式、大小和来源的数据

- Logstash 支持各种输入选择 ,同时从众多常用来源捕捉事件。

- 能够以连续的流式传输方式,轻松地从日志、指标、Web 应用、数据存储以及各种 AWS 服务采集数据。

过滤器:实时解析和转换数据

数据从源传输到存储库的过程中,Logstash 过滤器能够解析各个事件,识别已命名的字段以构建结构,并将它们转换成通用格式,以便更轻松、更快速地分析和实现商业价值。

- 利用 Grok 从非结构化数据中派生出结构

- 从 IP 地址破译出地理坐标

- 将 PII 数据匿名化,完全排除敏感字段

- 简化整体处理,不受数据源、格式或架构的影响

输出:选择存储库,导出数据

- 尽管 Elasticsearch 是首选输出方向,能够为搜索和分析带来无限可能,但它并非唯一选择。

- Logstash 提供众多输出选择,可以将数据发送到要指定的地方,并且能够灵活地解锁众多下游用例

2.Logstash安装与配置

软件下载

logstash安装

[root@server4 ~]# rpm -ivh jdk-8u181-linux-x64.rpm

[root@server4 ~]# rpm -ivh logstash-7.6.1.rpm

[root@server4 ~]# ln -s /usr/share/logstash/bin/logstash /usr/bin/

[root@server4 ~]# which logstash

3.elasticsearch输出插件

标准输入到es主机:

[root@server4 ~]# vim /etc/logstash/conf.d/test.conf

input {

stdin {}

}

output {

stdout {}

elasticsearch {

hosts => ["172.25.52.1:9200"] ##输出到的ES主机与端口

index => "logstash-%{+yyyy.MM.dd}" ##定制索引名称

}

}

[root@server4 ~]# logstash -f /etc/logstash/conf.d/test.conf ##指定配置文件运行

看到此信息为运行成功,输入

前端查看:

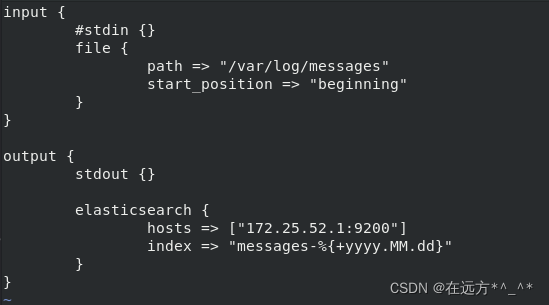

4.file输入插件

[root@server4 conf.d]# ll /var/log/messages

-rw------- 1 root root 58665 Dec 24 17:01 /var/log/messages

[root@server4 conf.d]# id logstash

uid=998(logstash) gid=996(logstash) groups=996(logstash)

[root@server4 conf.d]# chmod 644 /var/log/messages

[root@server4 conf.d]# vim test.conf

input {

#stdin {}

file {

path => "/var/log/messages"

start_position => "beginning"

}

}

output {

stdout {}

elasticsearch {

hosts => ["172.25.52.1:9200"]

index => "messages-%{+yyyy.MM.dd}"

}

}

[root@server4 conf.d]# logstash -f /etc/logstash/conf.d/test.conf

输出结果:

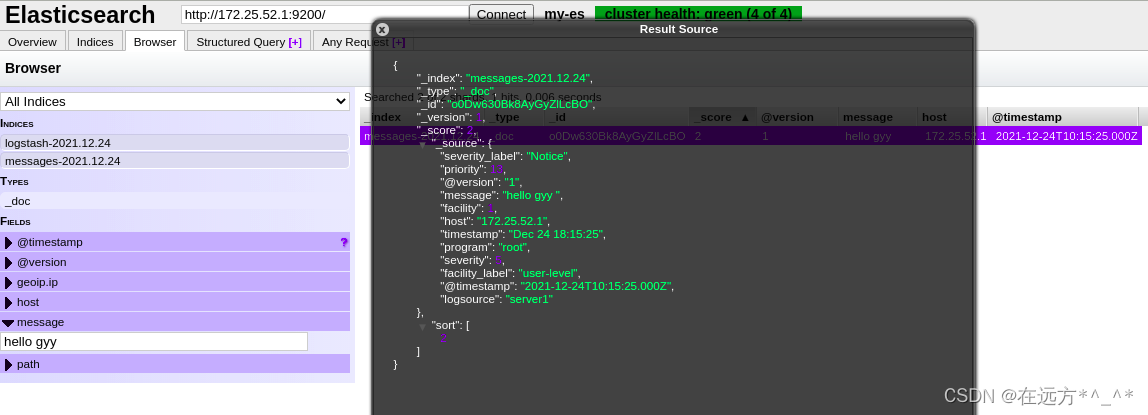

前端查看:

注意:因为避免冗余,所以输出进度保存,如果需要重新采集,要先删除之前的

注意:因为避免冗余,所以输出进度保存,如果需要重新采集,要先删除之前的

[root@server4 conf.d]# cd /usr/share/logstash/data/plugins/inputs/file/

[root@server4 file]# ld

ld: no input files

[root@server4 file]# l.

. .. .sincedb_452905a167cf4509fd08acb964fdb20c

[root@server4 file]# cat .sincedb_452905a167cf4509fd08acb964fdb20c

50590424 0 64768 58665 1640339529.266728 /var/log/messages

[root@server4 file]# rm -f .sincedb_452905a167cf4509fd08acb964fdb20c

[root@server4 file]# ls

logstash会把进度保存到sincedb文件中

sincedb文件内容解释:

[root@server4 file]# cat .sincedb_452905a167cf4509fd08acb964fdb20c

50590424 0 64768 58665 1640339529.266728 /var/log/messages

1.inode编号 ---->50590424

2.文件系统的主要设备号---->0

3. 文件系统的次要设备号---->64768

4. 文件中的当前字节偏移量---->58665

5. 最后一个活动时间戳(浮点数)---->1640339529.266728

6. 与此记录匹配的最后一个已知路径---->/var/log/messages5.Syslog输入插件

logstash可以伪装成日志服务器,直接接受远程日志

[root@server4 conf.d]# vim test.conf

input {

#stdin {}

#file {

# path => "/var/log/messages"

# start_position => "beginning" ##每次都是从头读数据

#}

syslog {

port => 514

}

}

output {

stdout {}

elasticsearch {

hosts => ["172.25.52.1:9200"]

index => "messages-%{+yyyy.MM.dd}"

}

}

[root@server4 conf.d]# logstash -f /etc/logstash/conf.d/test.conf

在server1和2中,设置主机中日志指向172.25.52.4:514

[root@server1 ~]# vim /etc/rsyslog.conf

*.* @@172.25.52.4:514

[root@server1 ~]# systemctl restart rsyslog.service

[root@server2 ~]# vim /etc/rsyslog.conf

*.* @@172.25.52.4:514

[root@server2 ~]# systemctl restart rsyslog.service 配置客户端传入日志

执行结果:

测试:

开启一个新窗口,查看server4中的514端口是否开启

6.多行过滤插件

多行过滤可以把多行日志记录合并为一行事件

[root@server1 ~]# cd /var/log/elasticsearch/

[root@server1 elasticsearch]# ls

[root@server1 elasticsearch]# scp my-es.log server4:/var/log/

[root@server4 conf.d]# ll /var/log/my-es.log

-rw-r--r-- 1 root root 260889 Dec 24 18:21 /var/log/my-es.log

[root@server4 conf.d]# vim test.conf ##一个事件放在一起

input {

#stdin {}

file {

path => "/var/log/my-es.log"

start_position => "beginning"

codec =>multiline {

pattern => "^\["

negate => true

what => previous

}

}

#syslog {

# port => 514

#}

}

output {

stdout {}

elasticsearch {

hosts => ["172.25.52.1:9200"]

index => "myes-%{+yyyy.MM.dd}"

}

}

[root@server4 conf.d]# logstash -f /etc/logstash/conf.d/test.conf

执行结果:

在前端查看:

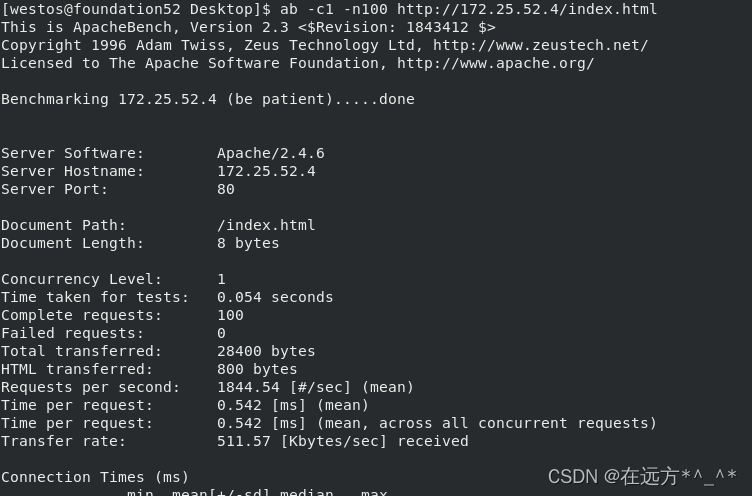

7.grok过滤插件

apache服务日志过滤

[root@server4 conf.d]# cd /usr/share/logstash/data/plugins/inputs/file/

[root@server4 file]# l.

. .. .sincedb_13f094911fdac7ab3fa6f4c93fee6639

[root@server4 file]# rm -f .sincedb_13f094911fdac7ab3fa6f4c93fee6639

[root@server4 file]# cd -

/etc/logstash/conf.d

[root@server4 conf.d]# yum install -y httpd

[root@server4 conf.d]# echo server4 > /var/www/html/index.html

[root@server4 conf.d]# systemctl start httpd

[root@server4 conf.d]# curl localhost

server4

[root@server4 conf.d]# ll /var/log/httpd/access_log

-rw-r--r-- 1 root root 10278 Dec 24 19:06 /var/log/httpd/access_log

[root@server4 conf.d]# ll -d /var/log/httpd/

drwx------ 2 root root 41 Dec 24 19:02 /var/log/httpd/

[root@server4 conf.d]# chmod 755 /var/log/httpd/

[root@server4 conf.d]# vim grok.conf

input {

file {

path => "/var/log/httpd/access_log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" }

}

}

output {

stdout {}

elasticsearch {

hosts => ["172.25.52.1:9200"]

index => "apachelog-%{+yyyy.MM.dd}"

}

}

[root@server4 conf.d]# logstash -f /etc/logstash/conf.d/grok.conf

测试:

执行结果:

在前端查看:

1427

1427

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?