这是发表在ACL2018的文章。

摘要:

情感资源包括情感词典、否定词和程度副词,这在传统的情感分类中具有非常重要的作用。然而,在深度学习模型中(例如CNN,LSTM),情感资源却没有得到有效的利用。

于是,文章提出了Multi-sentiment-resource Enhanced Attention Network(MEAN),以在句子级情感分类中通过注意力机制将以上三种情感知识整合到深度神经网络中。文章的创新点主要有两个:(1) 设计了一种耦合的向量模型能够利用字向量和词向量来表示句子向量(这能够帮助捕获一些形态信息比如前缀或者后缀);(2) 提出了一种attention机制结合多种情感资源。

实验结果证明本文提出的方法和其他方法相比有稳定的优势。

模型:

整个模型分为三部分:耦合词向量模型,多情感来源注意力模型,情感分类模型

1.耦合词向量

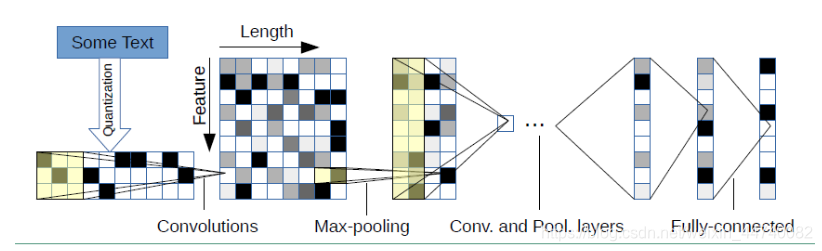

1.1char-CNN:获得字符级的向量(2015其他文章提出的方法)。全卷积没有最大池化(为了更好地获得语义信息)

把字符的one-hot向量先输入1x1卷积神经网络,来增强模型的非线性语义表示能力。再将结果输入到不同窗口大小的卷积层中来捕获不同的局部特征块。最后得到这一个词的向量表示。

2.word-level:采用Glo ve将每一个词映射为向量。

3.最终的词向量是由char级向量和word级向量联结组成的,对于上下文单词和三种情感来源的词都采用这样的处理。最终的词向量均为d维。 t个词的句子,m个情感词,k个程度副词,p个否定词。

该论文提出了一种名为MEAN的深度学习模型,通过注意力机制融合情感词典、否定词和程度副词等情感资源,用于句子级情感分类。模型包括耦合词向量、多情感来源注意力和分类器,实验显示其在多个数据集上表现优越。

该论文提出了一种名为MEAN的深度学习模型,通过注意力机制融合情感词典、否定词和程度副词等情感资源,用于句子级情感分类。模型包括耦合词向量、多情感来源注意力和分类器,实验显示其在多个数据集上表现优越。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1609

1609