1.背景知识

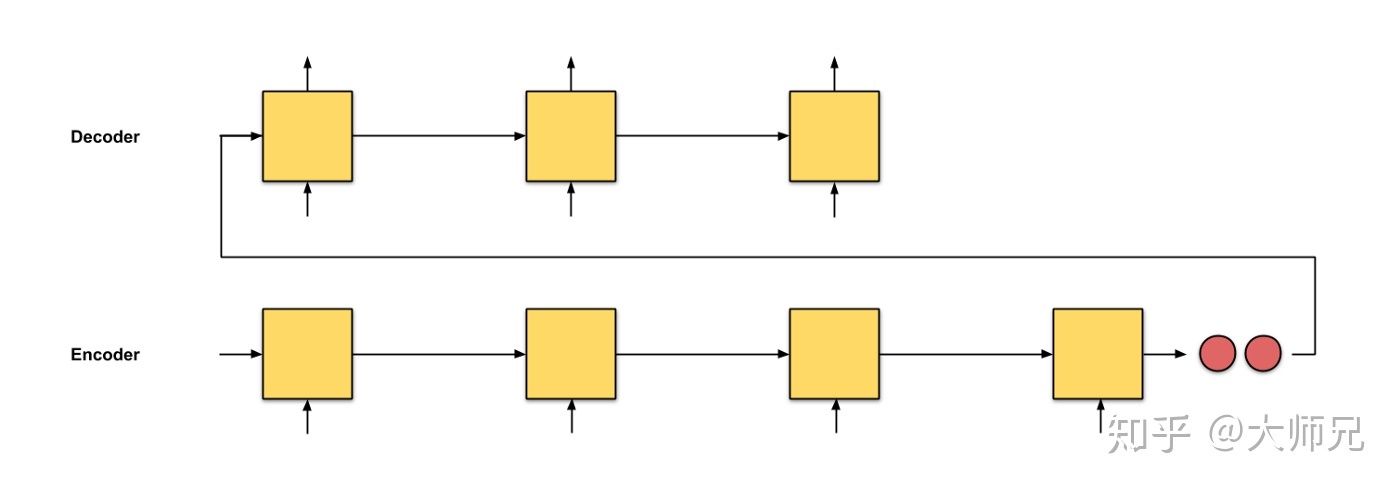

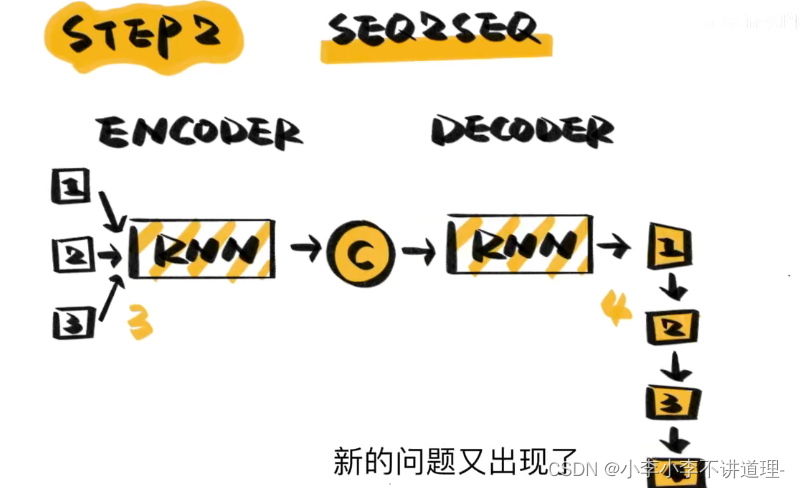

Seq2Seq模型:使用两个RNN,一个作为编码器,一个作为解码器。

编码器:将输入数据编码成一个特征向量。

解码器:将特征向量解码成预测结果。

缺点:只将编码器的最后一个节点的结果进行了输出,但是对于一个序列长度特别长的特征来说,这种方式无疑将会遗忘大量的前面时间片的特征。也就是句子太长,翻译精度会进行下降。

优点:解决输入输出结点不对等,RNN只能输出N对N,N对1

2.Attention机制

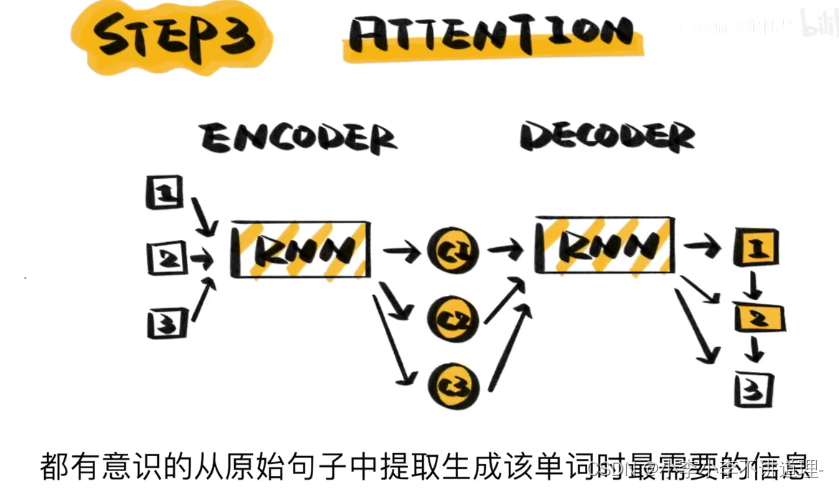

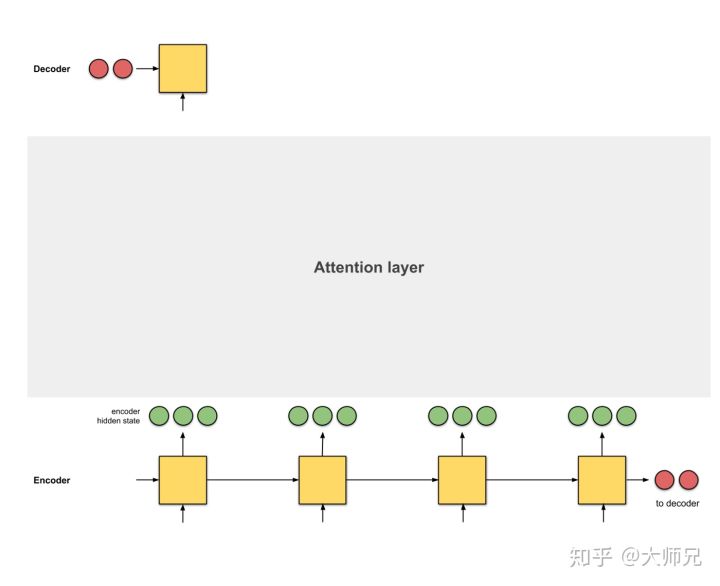

注意力机制:生成每个单词时,都会有意识的从原始句子提取生成该单词时最需要的信息,成功摆脱了输入序列的长度限制。

缺点:计算太慢,RNN需要逐个看过句子中的单词,才能给出输出

Attention是一个介于编码器和解码器之间的一个接口,用于将编码器的编码结果以一种更有效的方式传递给解码器。一个特别简单且有效的方式就是让解码器知道哪些特征重要,哪些特征不重要

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

11万+

11万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?