@inproceedings{li2020hscnet,

title = {Hierarchical Scene Coordinate Classification and Regression for Visual Localization},

author = {Li, Xiaotian and Wang, Shuzhe and Zhao, Yi and Verbeek, Jakob and Kannala, Juho},

booktitle = {CVPR},

year = {2020}

}

总结:大致思想:本文提出一种用于场景坐标预测的分层结构回归网络。有别于基于特征的方法,场景坐标回归不需要通过匹配描述符建立2D-3D的对应关系,而是直接从图像中回归场景6DOF位姿。由于现有场景坐标回归网络只考虑一个小的局部图像块,使得网络不适用于大规模场景,本文使用由粗到细的分层网络结构,使得网络可以适用于较大规模的场景。

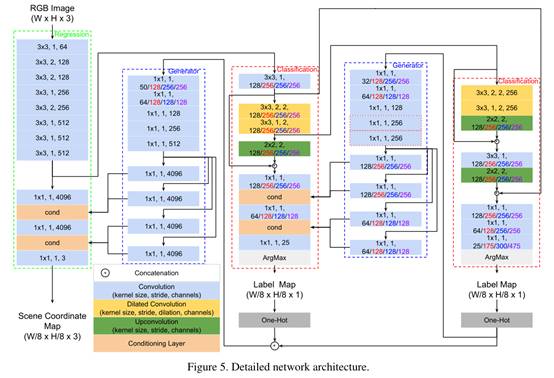

左图,网络流程:(1)colmap建图获得点云;(2)k-means划分点云;(3)输入图片经过卷积层后进入分类层,每个像素进行分类(K类)获得Label-map;(4)参考FiLM(Feature-wise Linear Modulation,注:FiLM层通过简单的特征仿射变换来影响神经网络计算)方法,Label-map和feature-map作为输入形成调节层,以达到将较粗层次上预测的标签信息反馈到较细的层次上。(5)最后一个分类层结束后,进入回归层,输出6DOF位姿。

右图,调节层

γ和β由生成器网络生成,与x(feature-map)结构一致,公式里的乘法是哈达玛积(直接点乘)。

损失函数:两部分组成,Label-map的损失函数(欧式距离)+图片位姿的损失函数(交叉熵)

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XqNsWzJH-1606286702801)(https://gitee.com/caiyingfeng/cloudimage/raw/master/images/20201125141902.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IT7adClf-1606286702805)(https://gitee.com/caiyingfeng/cloudimage/raw/master/images/20201125141902.png)]

上图中两层分类层和一层回归层的总损失函数,w1,w2,w3为权重。

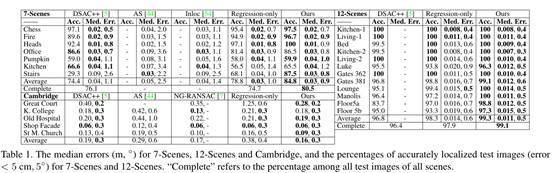

实验

小场景

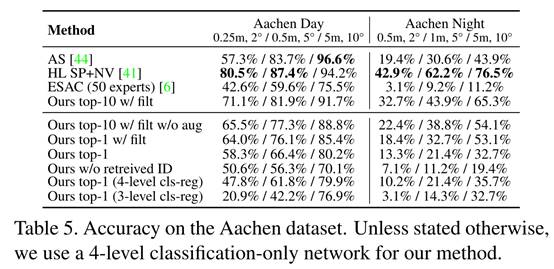

大场景

大场景

[外链图片转存中…(img-ultdX10d-1606286702817)]

本文提出用于场景坐标预测的分层结构回归网络,有别于基于特征的方法,可直接从图像中回归场景6DOF位姿。采用由粗到细的分层网络结构,适用于较大规模场景。介绍了网络流程、调节层、损失函数,并进行了小场景和大场景实验。

本文提出用于场景坐标预测的分层结构回归网络,有别于基于特征的方法,可直接从图像中回归场景6DOF位姿。采用由粗到细的分层网络结构,适用于较大规模场景。介绍了网络流程、调节层、损失函数,并进行了小场景和大场景实验。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?