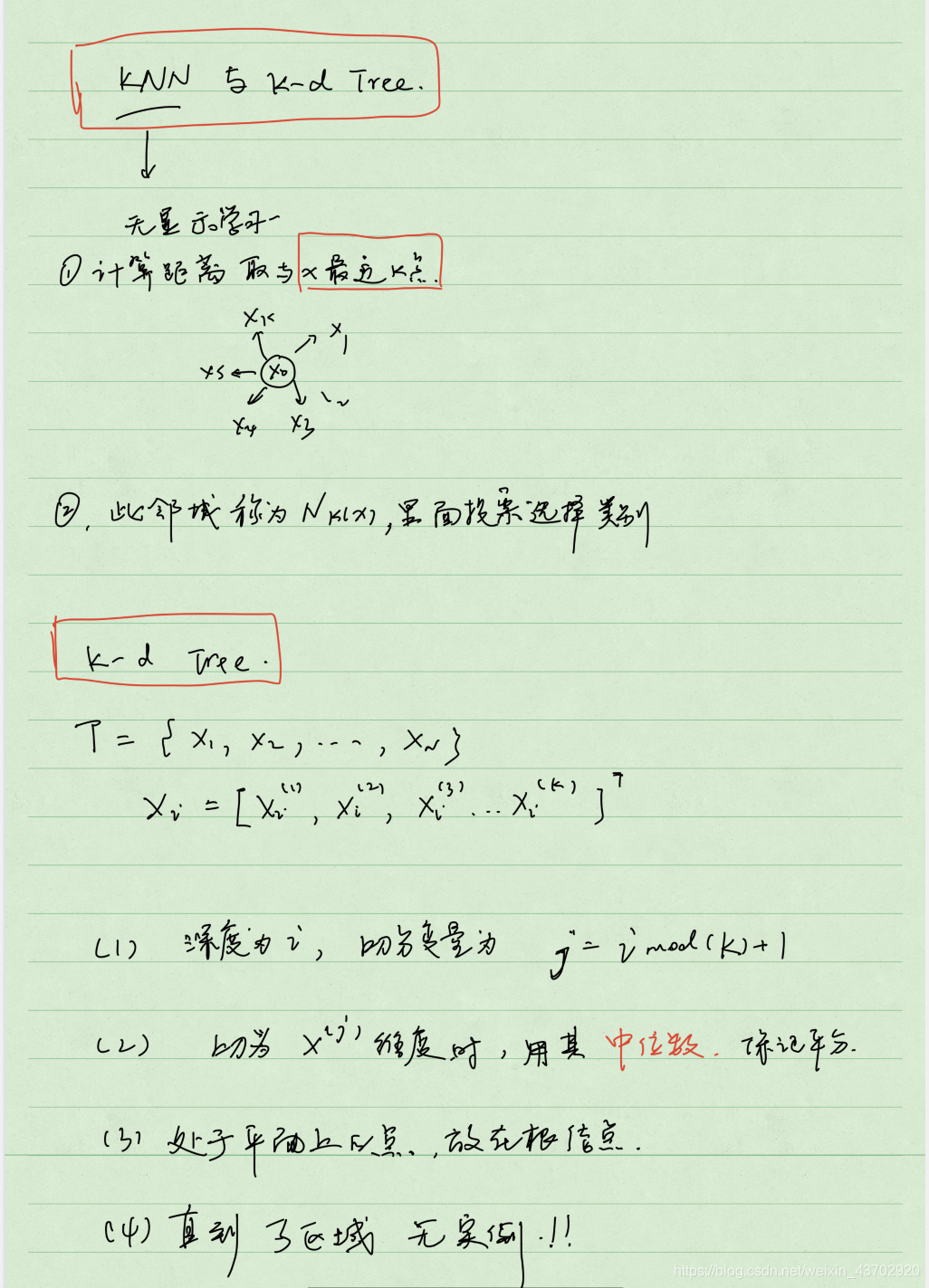

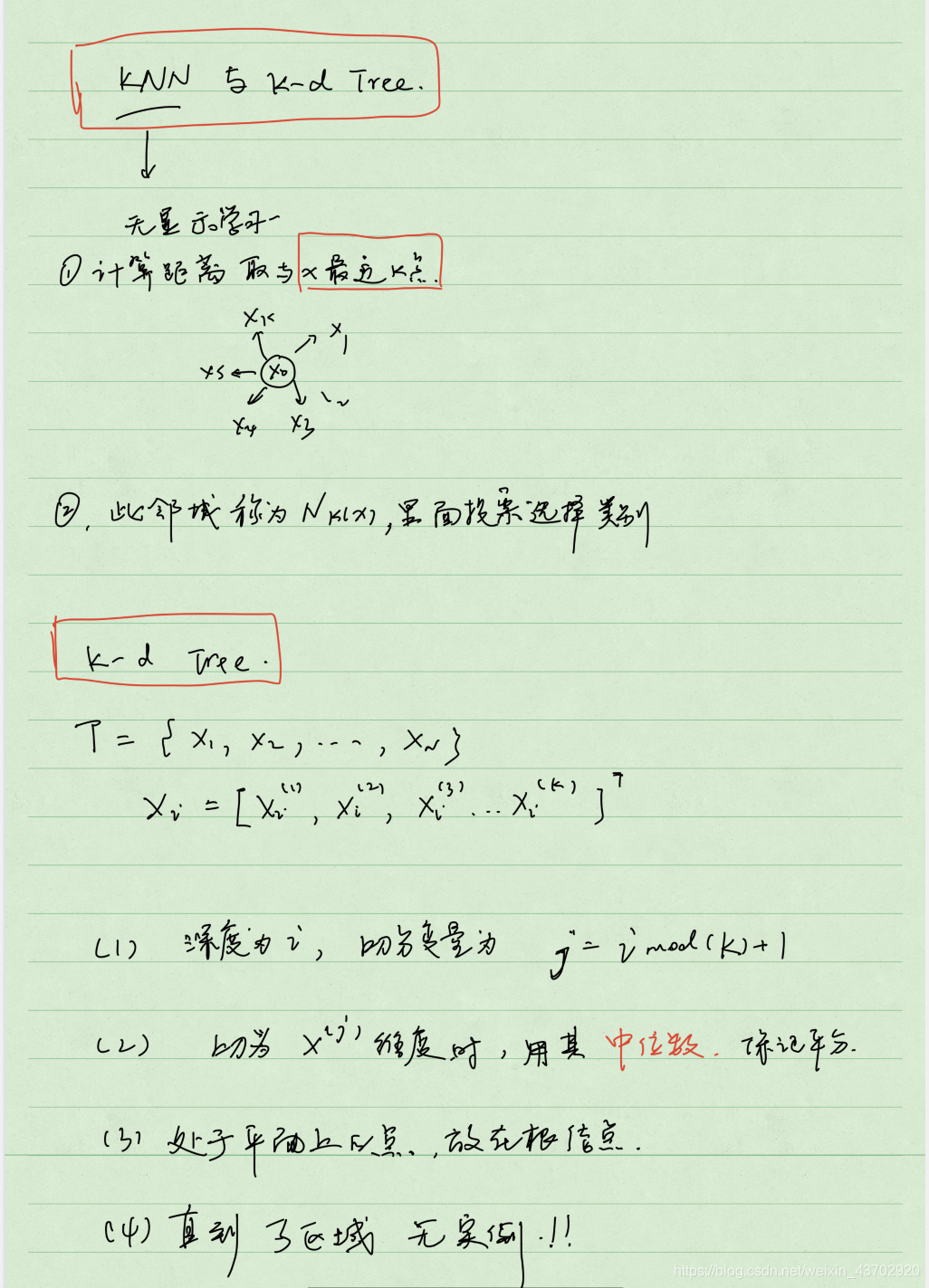

手写,KNN与k-d树简述

最新推荐文章于 2025-05-08 20:52:45 发布

博客围绕机器学习和算法展开,但具体内容缺失。机器学习是人工智能重要领域,算法则是实现各种功能的核心逻辑,二者在信息技术中至关重要。

博客围绕机器学习和算法展开,但具体内容缺失。机器学习是人工智能重要领域,算法则是实现各种功能的核心逻辑,二者在信息技术中至关重要。

博客围绕机器学习和算法展开,但具体内容缺失。机器学习是人工智能重要领域,算法则是实现各种功能的核心逻辑,二者在信息技术中至关重要。

博客围绕机器学习和算法展开,但具体内容缺失。机器学习是人工智能重要领域,算法则是实现各种功能的核心逻辑,二者在信息技术中至关重要。

333

333

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?