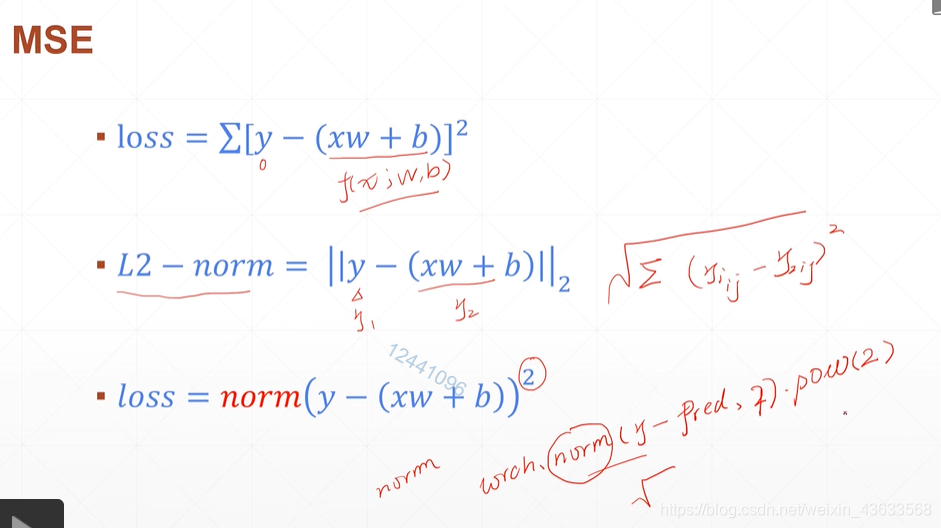

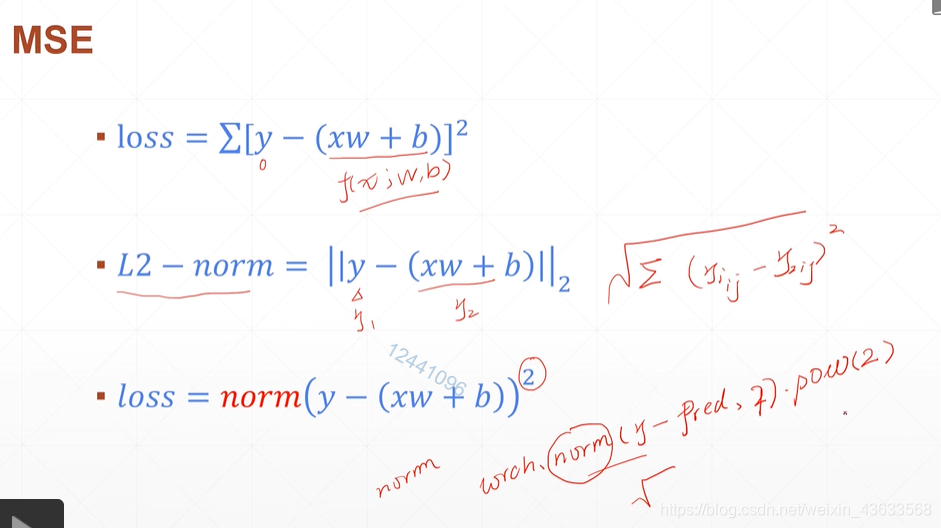

MSE:均方差

需要求偏导的参数,要特别写出来

因为是动态图,所以要再次求mse

两种求梯度的写法

softmax

由来

输出的值想要最大的,认为转化为概率0-1

如果用sigmoid,概率相加可能不等于1

softmax:把值大的变的更大,值小的压缩

深度学习(十三)——loss及其梯度

最新推荐文章于 2025-01-06 13:58:30 发布

MSE:均方差

需要求偏导的参数,要特别写出来

因为是动态图,所以要再次求mse

两种求梯度的写法

softmax

由来

输出的值想要最大的,认为转化为概率0-1

如果用sigmoid,概率相加可能不等于1

softmax:把值大的变的更大,值小的压缩

2193

2193

759

759

675

675

4014

4014

1837

1837

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?