k-近邻法是一种基本分类与回归方法。

k近邻法的输入为实例的特征向量,对应于特征空间的点;输出为实例的类别,可以取多类。

k近邻法的基本思想:给定一个训练数据集,对新的输入实例,在训练数据集中找到与该实例最邻近的k个实例,这k个实例的多数属于某个类,就把该输入实例分为这个类。

详细描述为:

输入:训练数据集T={(x1,y1),(x2,y2),…(xn,yn)},其中,xi∈X⊆R^n为实例的特征向量,yi∈Y={c1,c2,…,ck)为实例的类别,i=1,2,…n,实例特征向量x

输出:实例x所属的类y

(1)根据给定的距离度量,在训练集T中找出与x最近邻的k个点,涵盖这k个点的x的邻域记作Nk(x);

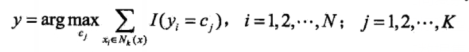

(2)在Nk(x)中根据分类决策规则(如多数表决)决定x的类别y:

式中I为指示函数,即当yi=cj时I为1,否则I为0。

k值的选择、距离度量及分类决策规定是k近邻法模型的三个基本要素。

k近邻法中,当训练集、距离度量(如欧氏距离)、k值及分类决策规则(如多数表决)确定后,对于任何一个新的输入实例,它所属的类就能唯一的确定。

特征空间中,对每个训练实例点xi,距离该点比其他更近的所有点组成一个区域,叫作单元。每个训练实例点拥有一个单元,所有训练实例点的单元构成对特征空间的一个划分。最近邻法将实例xi的类yi作为其单元中所有点的类标记。这样,每个单元的实例点的类别是确定的。

距离度量

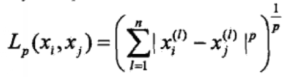

设特征空间X是n维实数向量空间R^n,xi,xj∈X,xi=(xi ^(1),xi ^(2),…,xi ^(n)) ^T,

xj=(xj ^(1),xj ^(2),…,xj ^(n)) ^T,xi,xj的Lp距离定义为:

这里p≥1.

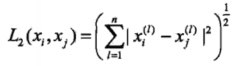

当p=2时,称为欧式距离:

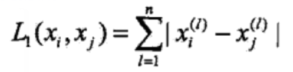

当p=1时,称为曼哈顿距离:

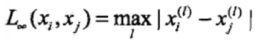

当p=∞时,它是各个坐标距离的最大值:

不同的距离度量所确定的最近邻点是不同的。

k值的选择

如果选择较小的k值,“学习”的近似误差会减小,但是“学习”的估计误差会增大,预测结果会对近邻的实例点非常敏感。换句话说,k值的减小就意味着整体模型变得复杂,容易发生过拟合现象。

如果选择较大的k值,可以减少学习的估计误差,但是学习的近似误差会增大。

我们一般采用交叉验证法来选取最优的k值。

分类决策规则

k近邻法中的分类决策规则往往是多数表决,即有输入实例的k个邻近的训练实例中的多数类决定输入实例的类。

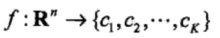

多数表决规则:如果分类的损失函数为0-1损失函数,分类函数为:

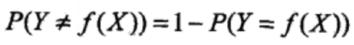

那么误分类的概率是:

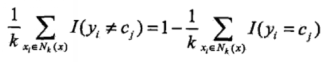

对给定的实例x∈X,其最近邻的k个训练实例点构成集合Nk(x)。如果涵盖Nk(x)的区域的类别是Cj,那么误分类率是:

要使误分类率最小即经验风险最小,就要使∑I(yi=cj)最大,所以多数表决规则等价于经验风险最小化。

k近邻法的实现:kd树

kd树是一种对k为空间中的实例点进行存储以便对其进行快速检索的树形数据结构。kd树是二叉树,表示对k维空间的一个划分。

构造kd树的方法如下:构造根结点,使根结点对应于k为空间中包含所有实例点的超矩形区域;通过下面的递归方法,不断的对k维空间进行切分,生成子节点。在超矩形区域(结点)上选择一个坐标轴和在此坐标轴上的一个切分点,确定一个超平面,这个超平面通过选定的切分点并垂直于选定的坐标轴,将当前超矩形区域且分为左右两个子区域(子结点);这时,实例被分到两个子区域。这个过程直到子区域内没有实例时终止(终止时的结点为叶结点)。在此过程中,将实例保存在相应的结点上。

构造平衡kd树

输入:k维空间数据集T={x1,x2,…xn},其中xi=(xi ^(1),xi ^(2),…xi ^(k)) ^T,i=1,2,3,…,n;

输出kd树

(1)开始:构造根结点,根结点对应于包含T的k维空间的超矩形矩阵。选择x^(1)为坐标轴,以T中所有实例的x ^(1)坐标的中位数为切分点,将根结点对应的超矩形区域切分为两个字区域。切分由通过切分点并与坐标轴x ^(1)垂直的超平面实现。

由根结点生成深度为1的左、右子结点:左子结点对应坐标x ^(1)小于切分点的子区域,右子结点对应于坐标x ^(1)大于切分点的子区域。将落在切分超平面上的实例点保存在根结点。

(2)重复:对深度为j的结点,选择x^(l)为切分的坐标轴,l=j(mod)k+1,以该结点的区域中所有实例的x ^(l)坐标的中位数为切分点,将该结点对应的超矩形区域切分为两个子区域。切分由通过切分点并与坐标轴x ^(l)垂直的超平面实现。

由该结点生成深度为j+1的左、右子结点:左子结点对应坐标x ^(l)小于切分点的子区域,右子结点对应坐标x ^(l)大于切分点的子区域。将落在切分超平面上的实例点保存在该结点。

(3)直到两个子区域没有实例存在时停止。从而形成kd树的区域划分。

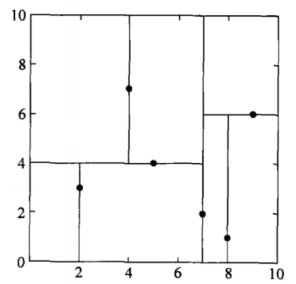

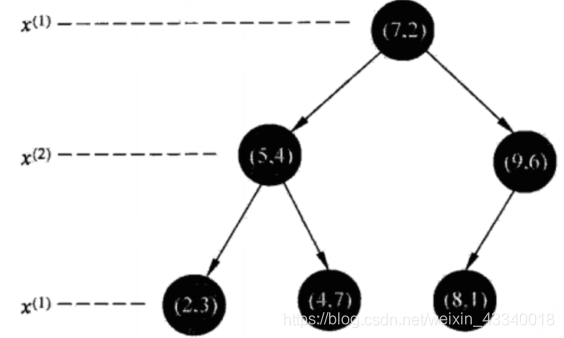

**例:**给定一个二维空间的数据集:T={(2,3) ^T,(5,4) ^T,(9,6) ^T,(4,7) ^T,(8,1) ^T,(7,2) ^T}构造一个平衡kd树。

根结点对应包含数据集T的矩形,选择x ^(1)轴,6个数据点的x ^(1)坐标的中位数是7,以平面x ^(1)=7将空间分为左右两个子矩形(子结点);接着,左矩形以x ^(2)=4分为两个子矩阵,右矩阵以x ^(2)=6分为两个子矩阵,如此递归,最后得到如下图所示的特征空间划分和如下图所示的kd树。

kd树的最近邻搜索

输入:已构造的kd树;目标点x

输出:x的最近邻

(1)在kd树中找出包含目标点x的叶结点:从根结点出发,递归地向下访问kd树。若目标点x当前维的坐标小于切分点的坐标,则移动到左子结点,否则移动到右子结点。直到子结点为叶结点为止。

(2)以此叶结点为“当前最近点”

(3)递归地向上回退,在每个结点进行以下操作:

(a)如果该结点保存的实例点比当前最近点距离目标点更近,则以该实例点为“当前最近点”

(b)当前最近点一定存在于该结点一个子结点对应的区域。检查该子结点的父结点的另一子结点对应的区域是否有更近的点。具体地,检查另一子结点对应的区域是否以目标为球心、以目标点与“当前最近点”间的距离为半径的超球体相交。如果相交,可能在另一个子结点对应的区域内存在距目标点更近的点,移动到另一个子结点。接着,递归地进行最近邻搜索;如果不想交,向上回退。

(4)当回退到根结点时,搜索结束。最后的“当前最近点”即为x的最近邻点。

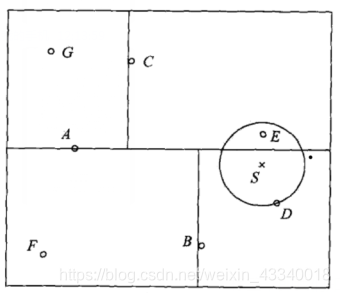

**例:**给定下图所示的kd树,根结点为A,其子结点为B,C等。树上共存储7个实例点;另一个输入目标实例点S,求S的最近邻点。

首先在kd树中找到包含点S的叶结点D,以点D作为近似最近邻。真正最近邻一定在以点S为中心通过点D的圆的内部。然后返回结点D的父结点B,在结点B的另一子结点F的区域内搜索最近邻。结点F的区域与圆不想交,不可能有最近邻点。继续返回上一级父结点A,在结点A的另一结点C的区域内搜索最近邻。结点C的区域与圆相交;该区域在圆内的实例点有点E,点E比点D更近,成为新的最近邻近似。最后得到点E是点S的最近邻。

k-近邻算法采用测量不同特征值之间的距离方法进行分类。

优点:精度高、对异常值不敏感、无数据输入假定。

缺点:计算复杂度高、空间复杂度高。

适用数据范围:数值型和标称型。

工作原理:存在一个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据与所属分类的对应关系。输入没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进行比比较,然后算法提取样本集中特征最相似数据(最邻近)的分类标签。一般来说,我们只选择样本数据集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不大于20的整数。最后,选择k个最相似数据中出现次数最多的分类,作为新数据的分类。

k-近邻算法的一般流程

- 收集数据:可以使用任何方法

- 准备数据:距离计算所需要的数值,最好是结构化的数据格式。

- 分析数据:可以使用任何方法。

- 训练算法:此步骤不适用于k-近邻算法

- 测试算法:计算错误率

- 使用算法:首先需要输入样本数据和结构化的输出结果,然后运行k-近邻算法判定输入数据分别属于哪个分类,最后应用对计算出的分类执行后续的处理。

本文深入解析k-近邻算法的工作原理,包括输入实例的特征向量、输出实例的类别、距离度量、k值选择、分类决策规则以及kd树的构建与搜索。讨论了算法的优点与缺点,适合数值型和标称型数据的分类。

本文深入解析k-近邻算法的工作原理,包括输入实例的特征向量、输出实例的类别、距离度量、k值选择、分类决策规则以及kd树的构建与搜索。讨论了算法的优点与缺点,适合数值型和标称型数据的分类。

5895

5895

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?