【Spark Core篇】RDD基础与执行原理

一、什么是RDD

- RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是 Spark 中最基本的数据处理模型。代码中是一个抽象类,它代表一个弹性的、不可变、可分区、里面的元素可并行计算的集合。

- 弹性:

存储的弹性:内存与磁盘的自动切换;

容错的弹性:数据丢失可以自动恢复;

计算的弹性:计算出错重试机制;

分片的弹性:可根据需要重新分片。 - 分布式:数据存储在大数据集群不同节点上

- 数据集:RDD 封装了计算逻辑,并不保存数据

- 数据抽象:RDD 是一个抽象类,需要子类具体实现

- 不可变:RDD 封装了计算逻辑,是不可以改变的,想要改变,只能产生新的 RDD,在新的 RDD 里面封装计算逻辑

- 可分区、并行计算

- 弹性:

二、核心属性

1、分区列表

RDD 数据结构中存在分区列表,用于执行任务时并行计算,是实现分布式计算的重要属性。

2、分区计算函数

Spark 在计算时,是使用分区函数对每一个分区进行计算

3、RDD 之间的依赖关系

RDD 是计算模型的封装,当需求中需要将多个计算模型进行组合时,就需要将多个 RDD 建立依赖关系

4、分区器(可选)

当数据为 KV 类型数据时,可以通过设定分区器自定义数据的分区

5、首选位置(可选)

计算数据时,可以根据计算节点的状态选择不同的节点位置进行计算

三、执行原理

- 从计算的角度来讲,数据处理过程中需要计算资源(内存 & CPU)和计算模型(逻辑)。执行时,需要将计算资源和计算模型进行协调和整合。

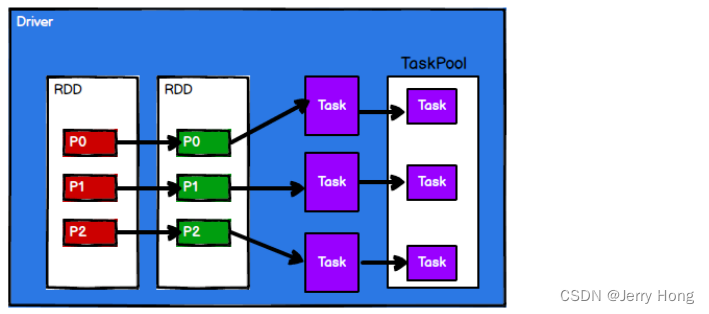

- Spark 框架在执行时,先申请资源,然后将应用程序的数据处理逻辑分解成一个一个的计算任务。然后将任务发到已经分配资源的计算节点上, 按照指定的计算模型进行数据计算。最后得到计算结果。

- RDD 是 Spark 框架中用于数据处理的核心模型,在 Yarn 环境中,RDD的工作原理:

-

启动 Yarn 集群环境

-

Spark 通过申请资源创建调度节点和计算节点

-

Spark 框架根据需求将计算逻辑根据分区划分成不同的任务

-

调度节点将任务根据计算节点状态发送到对应的计算节点进行计算

-

从以上流程可以看出 RDD 在整个流程中主要用于将逻辑进行封装,并生成 Task 发送给Executor 节点执行计算。

RDD(Resilient Distributed Dataset)是Spark的核心数据模型,表示不可变、可分区的并行数据集。RDD具备弹性、容错和计算能力,通过分区列表、计算函数和依赖关系实现分布式计算。在执行时,Spark将RDD的计算逻辑拆分为任务,分配到Yarn集群的计算节点上执行。

RDD(Resilient Distributed Dataset)是Spark的核心数据模型,表示不可变、可分区的并行数据集。RDD具备弹性、容错和计算能力,通过分区列表、计算函数和依赖关系实现分布式计算。在执行时,Spark将RDD的计算逻辑拆分为任务,分配到Yarn集群的计算节点上执行。

665

665

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?