1. 摘要

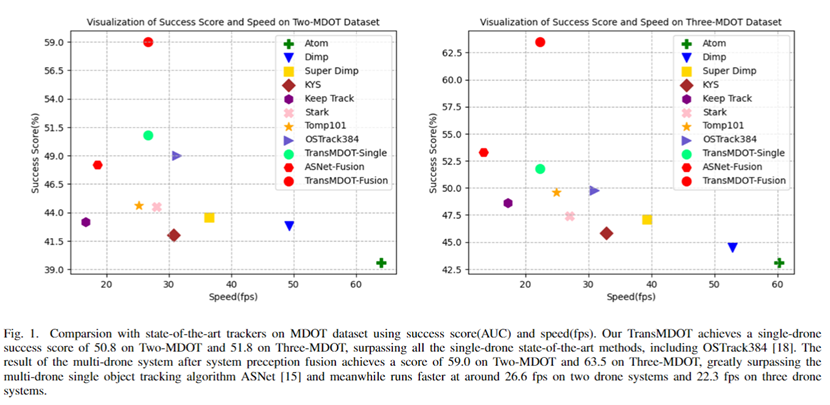

无人机已被广泛用于各种应用,如空中摄影和军事安全,因为与固定摄像机相比,无人机具有高机动性和广阔的视野。多架无人机跟踪系统可以通过收集不同视角的互补视频片段来提供丰富的目标信息,特别是当目标在某些视角下被遮挡或消失时。 然而,在多架无人机视觉追踪中,处理跨无人机信息交互和多架无人机信息融合是一个挑战。最近,Transformer在为视觉追踪自动建模模板和搜索区域之间的关联性方面显示出显著的优势。为了利用其在多架无人机跟踪中的潜力,我们提出了一种新型的跨无人机Transformer网络(TransMDOT),用于视觉物体跟踪任务。Self-Attention机制被用来自动捕捉多个模板和相应搜索区域之间的相关性,以实现多机特征融合。在跟踪过程中,以跟踪状态良好的无人机的周边信息为参考,提出了跨无人机的映射机制,协助失去目标的无人机重新校准,实现了跨无人机的实时信息交互。由于现有的多架无人机评价指标只考虑空间信息而忽略了时间信息,我们进一步提出了一个系统感知指数(SPFI),结合时间和空间信息来评价多架无人机的跟踪状态。在MDOT数据集上的实验证明,TransMDOT在单架无人机性能和多架无人机系统融合性能方面都大大超过了最先进的方法。我们的代码将在https://github.com/cgjacklin/transmdot上提供。

本文介绍了一种新型的跨无人机Transformer网络(TransMDOT),应用于视觉物体跟踪任务。通过Self-Attention机制实现多无人机间信息交互和特征融合,解决目标遮挡和消失问题。TransMDOT还包括跨无人机映射机制,协助无人机重新校准跟踪状态,并提出了系统感知指数(SPFI)以评估多无人机跟踪性能。实验显示TransMDOT在单机和多机跟踪上均优于现有先进方法。

本文介绍了一种新型的跨无人机Transformer网络(TransMDOT),应用于视觉物体跟踪任务。通过Self-Attention机制实现多无人机间信息交互和特征融合,解决目标遮挡和消失问题。TransMDOT还包括跨无人机映射机制,协助无人机重新校准跟踪状态,并提出了系统感知指数(SPFI)以评估多无人机跟踪性能。实验显示TransMDOT在单机和多机跟踪上均优于现有先进方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

512

512