Q学习是常见的强化学习方法,深度Q学习是为了解决传统Q学习的限制(存储空间)而出现的方法,目前多用于对高维数据的学习(深度--可以处理高维数据)。在python中使用tensorflow等框架可轻松实现深度Q学习,但是理解其过程是有难度的或者几乎黑盒。处理的难度在于误差的梯度计算。接下来介绍一下我的一些做法,在java中实现相关的方法。

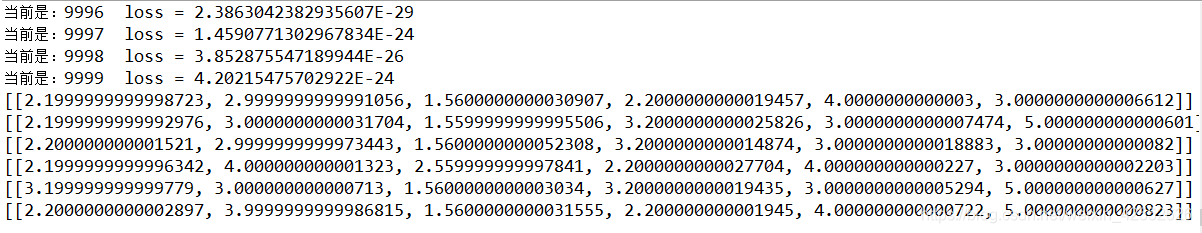

首先,Q学习的入门例子,可参看百度搜索第一名的讲解(房间),程序非常好实现,为后面实验需要,将正反馈值设为1。python结果如下:

房间状态的转移值很快得到,那么如何使用深度Q学习实现这个房间问题?对照2013年的DQL版本伪代码可轻松 实现,需要注意的是,误差loss的计算应该如下图所示,谁最大,谁才拥有误差,其他动作的误差可设置为0(softmax应该可以)。

这样在java中可实现

可以看到他的泛化能力,下一步可深入研究其机制。

在java中实现的过程如下:首先需要一个支持神经网络的类(github可找),使用激活函数tanh(效果就是好),将误差方法设置到神经网络类即可。状态可用hotindex进行处理,(1,100000。2,010000)。

使用这样的方法,可以在任何平台组建自己的深度Q学习,当然其中的优化这里不谈,算法有了,有的是空间可做研究。

2015年的DQN可用在这里吗?当然可以,不过需要添加一个Q值神经网络,其他的按照伪代码实现即可。

如何快速提高本质的训练速度?使用DDQL(double Q)

输入的东西比较高维如何?使用DRQN(循环dqn)

语音等如何处理?使用DDRQN(lstm dqn)

本文介绍了深度Q学习作为强化学习的一种方法,用于处理高维数据。通过对比传统Q学习和深度Q学习(DQL)的区别,展示了如何在Python中使用TensorFlow实现,并探讨了在Java中实现DQL的细节,包括误差计算和状态处理。此外,还提到了DQN的优化方法如DDQL、DRQN和DDRQN,以适应不同场景的需求。

本文介绍了深度Q学习作为强化学习的一种方法,用于处理高维数据。通过对比传统Q学习和深度Q学习(DQL)的区别,展示了如何在Python中使用TensorFlow实现,并探讨了在Java中实现DQL的细节,包括误差计算和状态处理。此外,还提到了DQN的优化方法如DDQL、DRQN和DDRQN,以适应不同场景的需求。

598

598

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?