摘要

《Federated Learning of a Mixture of Global and Local Models》这篇论文的目的是在Local和Global之间寻找一个trade off,对全局模型和局部模型进行混合,并提出适用于这一想法的几种新的梯度下降算法,如L2GD,该算法还能改进通信复杂度。

本文的两项动机

1、全局模型在客户端的实用性问题。

2、传统的LGD在理论上,并不能改善通信复杂度。

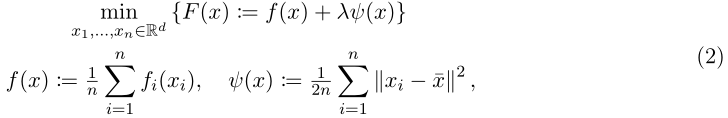

目标函数

其中f(x)是全局平均损失值,λ≥0是惩罚项参数, x 1 x_1 x1… x n x_n xn∈ R d R^d Rd是本地模型,x:=( x 1 x_1 x1… x n x_n xn

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9941

9941

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?