《FEDERATED OPTIMIZATION IN HETEROGENEOUS NETWORKS》这篇文章提出了一个基于FedAvg的优化框架Fedprox,主要在于解决FedAvg未曾处理的联邦学习中的异构性问题,并提供了更强的鲁棒性。

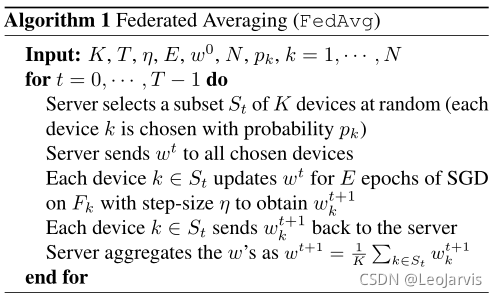

FedAvg

在FedAvg中,每个设备在模型训练过程中具有相同的学习率和迭代次数。在每一轮更新中,被选中参与本轮训练的设备K在本地运行E轮SGD,每个设备将更新结果返回给服务器,服务器对得到的模型更新进行平均从而获得全局更新,并完成本轮训练。伪代码如Algorithm 1所示。

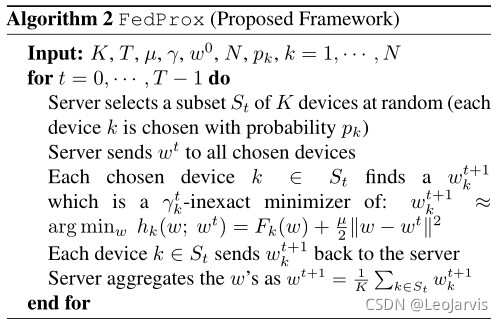

FedProx对FedAvg的改进之处

首先,由于FedAvg本身的设置,本地迭代次数 E 的增大虽能减少通信成本,但迭代次数过多不仅可能使一些受限于算力的设备无法完成训练,还容易使设备的本地模型偏离全局模型,影响全局收敛。导致这一问题的原因主要是联邦学习中存在的异构性问题。

FedProx主要解决了两种异构问题:

1.设备异构:设备间通信和计算能力存在差异,可能导致不同设备间更新不同步等问题。

2.数据异构:主要是设备间的non-IID问题。

FedProx

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1006

1006