数据记录数据信息的称为元数据(例如:-rw-r–r–. 1 root root 1931 1月 30 2018 initial-setup-ks.cfg)

删除创建的ceph

ceph-deloy uninstall node1 node2 node3 删除创建的ceph集群

rm -rf /var/lib/ceph/*

rm -rf /var/run/ceph/*

rm -rf /var/log/ceph/*

rm -rf /etc/ceph/ceph.conf

先来学习ceph的一些知识

NSD CLUSTER DAY04

案例1:实验环境

案例2:部署ceph集群

案例3:创建Ceph块存储

1 案例1:实验环境

1.1 问题

准备四台KVM虚拟机,其三台作为存储集群节点,一台安装为客户端,实现如下功能:

创建1台客户端虚拟机

创建3台存储集群虚拟机

配置主机名、IP地址、YUM源

修改所有主机的主机名

配置无密码SSH连接

配置NTP时间同步

创建虚拟机磁盘

1.2 方案

使用4台虚拟机,1台客户端、3台存储集群服务器,拓扑结构如图-1所示。

4.

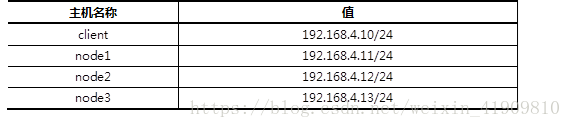

所有主机的主机名及对应的IP地址如表-1所示。

1.3 步骤

实现此案例需要按照如下步骤进行。

步骤一:安装前准备

1)物理机为所有节点配置yum源,注意所有的虚拟主机均需要挂载安装光盘。

[root@root9pc01 ~]# yum -y install vsftpd

[root@root9pc01 ~]# mkdir /var/ftp/ceph

[root@root9pc01 ~]# mount -o loop \

rhcs2.0-rhosp9-20161113-x86_64.iso /var/ftp/ceph

[root@root9pc01 ~]# systemctl restart vsftpd

2)修改所有节点yum配置(以node1为例)

[root@node1 ~]# cat /etc/yum.repos.d/ceph.repo

[mon]

name=mon

baseurl=ftp://192.168.4.254/ceph/rhceph-2.0-rhel-7-x86_64/MON

gpgcheck=0

[osd]

name=osd

baseurl=ftp://192.168.4.254/ceph/rhceph-2.0-rhel-7-x86_64/OSD

gpgcheck=0

[tools]

name=tools

baseurl=ftp://192.168.4.254/ceph/rhceph-2.0-rhel-7-x86_64/Tools

gpgcheck=0

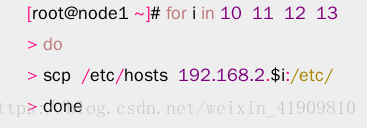

3)修改/etc/hosts并同步到所有主机。

[root@node1 ~]# cat /etc/hosts

… …

192.168.4.10 client

192.168.4.11 node1

192.168.4.12 node2

192.168.4.13 node3

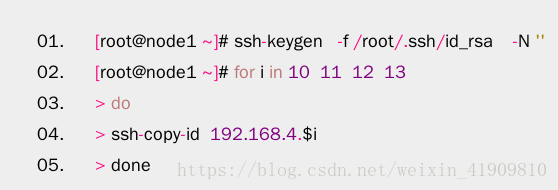

3)配置无密码连接。

[root@node1 ~]# ssh-keygen -f /root/.ssh/id_rsa -N ”

步骤二:配置NTP时间同步

1)创建NTP服务器。

[root@client ~]# yum -y install chrony

[root@client ~]# cat /etc/chrony.conf

server 0.centos.pool.ntp.org iburst

allow 192.168.4.0/24

local stratum 10

[root@client ~]# systemctl restart chronyd

2)其他所有节点与NTP服务器同步时间(以node1为例)。

[root@node1 ~]# cat /etc/chrony.conf

server 192.168.4.10 iburst

[root@node1 ~]# systemctl restart chronyd

步骤三:准备存储磁盘

1)物理机上为每个虚拟机准备3块磁盘。(可以使用命令,也可以使用图形直接添加)

[root@root9pc01 ~]# cd /var/lib/libvirt/images

[root@root9pc01 ~]# qemu-img create -f qcow2 node1-vdb.vol 10G

[root@root9pc01 ~]# qemu-img create -f qcow2 node1-vdc.vol 10G

[root@root9pc01 ~]# qemu-img create -f qcow2 node1-vdd.vol 10G

[root@roo

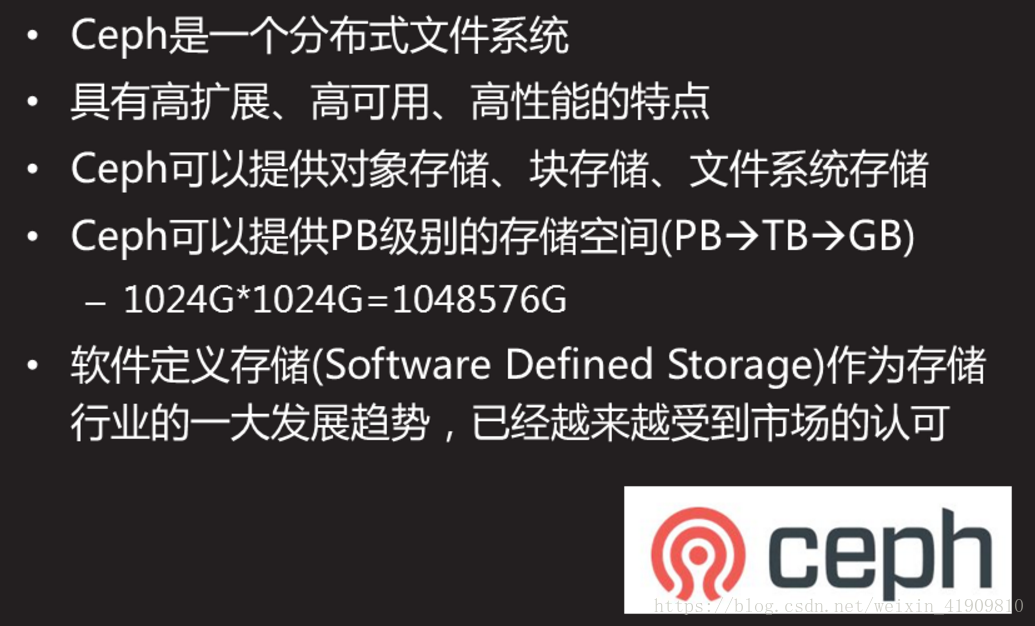

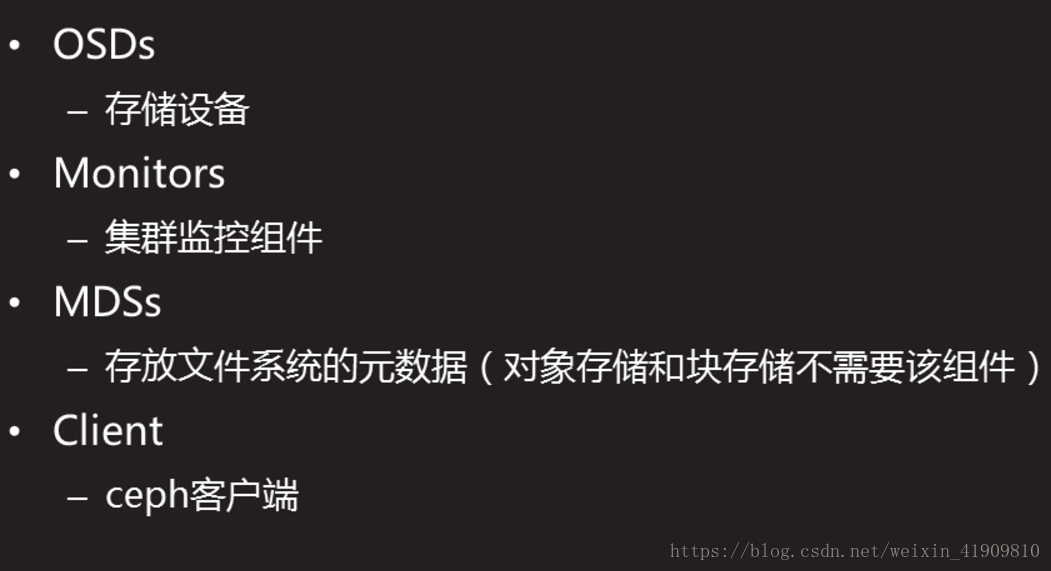

本文详细介绍了如何部署Ceph存储集群,包括创建和管理Ceph块存储,实现快照和克隆功能。此外,还涵盖了Ceph文件系统和对象存储的设置,提供了丰富的案例和步骤,适合于学习和实践中使用Ceph存储解决方案。

本文详细介绍了如何部署Ceph存储集群,包括创建和管理Ceph块存储,实现快照和克隆功能。此外,还涵盖了Ceph文件系统和对象存储的设置,提供了丰富的案例和步骤,适合于学习和实践中使用Ceph存储解决方案。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1709

1709

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?