Flume的Agent是运行在JVM上的Java进程,所以Flume的安装运行需要Java1.7及以上的支持,在开始下面工作之前,请确保你的机器已经安装了JDK1.7+。

Flume的安装步骤

(1)下载并解压Flume,进入flume官网,选择二进制版本下载并解压,网址http://flume.apache.org/download.html。

(2)配置环境变量,编辑/etc/profile文件,在文件末尾添加flume文件路径:

export FLUME_HOME= /home/hadoop/apache-flume-1.8.0-bin

export PATH=$PATH:$FLUME_HOME/bin

(3)环境变量立即生效

[hadoop@master~]$ source /etc/profile

(4)修改flume-env.sh文件

[hadoop@master~]$ cd /home/hadoop/apache-flume-1.8.0-bin/conf

[hadoop@master conf]$ cp flume-env.sh.template flume-env.sh

[hadoop@master conf]$ vim flume-env.sh

修改java配置内容:

export JAVA_HOME=/home/hadoop/java/jdk1.8.0_161

export JAVA_OPTS="-Xms100m -Xmx2000m -Dcom.sun.management.jmxremote"

(5)终端输入bin/flume-ng version,验证配置是否成功。出现如下所示信息,则安装成功。

Flume的简单应用

安装好Flume后,使用Flume的步骤分为两步:

(1)写一个配置文件,在配置文件当中描述source、channel与sink的具体实现;(2)运行一个agent实例,在运行agent实例的过程中会读取配置文件的内容,这样flume就会采集到数据。下面介绍一下使用Flume监听一条路径,并随时获取写入该路径的信息。

(1)首先进入/apache-flume-1.8.0-bin/conf目录下,创建Flume配置文件:

[hadoop@master conf]$ vim flume.conf

#从整体上描述代理agent中的sources、sinks、channels所涉及到的组件:

#指定Agent的组件名称

a1.sources = r1

a1.sinks = k1

a1.channels = c1

#详细描述agent中每一个source、sink与channel的具体实现:

#指定Flume source(要监听的路径)

a1.sources.r1.type = spooldir

a1.sources.r1.spoolDir=/home/hadoop/software/apache-flume-1.8.0-bin/logs

#指定Flume sink

a1.sinks.k1.type = logger

#指定Flume channel

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

#通过channel将source与sink连接起来:

#绑定source和sink到channel上

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

(2)启动flume agent:

[hadoop@master ~]$ cd /home/hadoop/software/apache-flume-1.8.0-bin

[hadoop@master apache-flume-1.8.0-bin]$ bin/flume-ng agent --conf conf --conf-file conf/flume.conf --name a1 -Dflume.root.logger=INFO,console

各项参数含义如下表XXX所示:

(3)另外打开一个终端,在apache-flume-1.8.0-bin目录下新建日志目录:

[hadoop@master apache-flume-1.8.0-bin]$ mkdir logs

(4)追加文件到 apache-flume-1.8.0-bin/logs 目录,写入Hello world,作为测试内容,然后将文件拷贝到flume的监听路径上:

[hadoop@master ~]$ echo "Hello World" >. /home/hadoop/software/apache-flume-1.8.0-bin/logs/spool.log

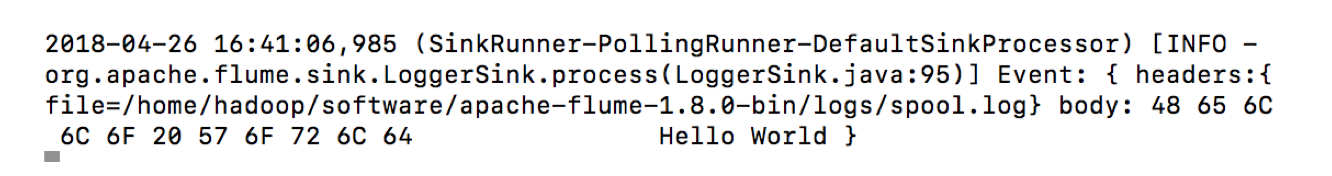

(5)当数据写入监听路径后,如图8-18所示,在控制台就会显示收集到的数据:

662

662

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?