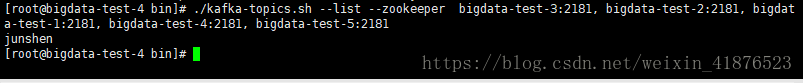

一、查看kafka topic

./kafka-topics.sh --list --zookeeper bigdata-test-3:2181, bigdata-test-2:2181, bigdata-test-1:2181, bigdata-test-4:2181, bigdata-test-5:2181

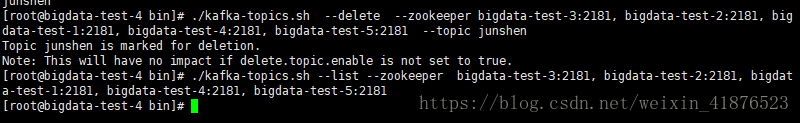

./kafka-topics.sh --delete --zookeeper bigdata-test-3:2181, bigdata-test-2:2181, bigdata-test-1:2181, bigdata-test-4:2181, bigdata-test-5:2181 --topic junshen

可以看到已经删除了,因为我已经配置过delete.topic.enable =true.所以已经都删除掉了

.

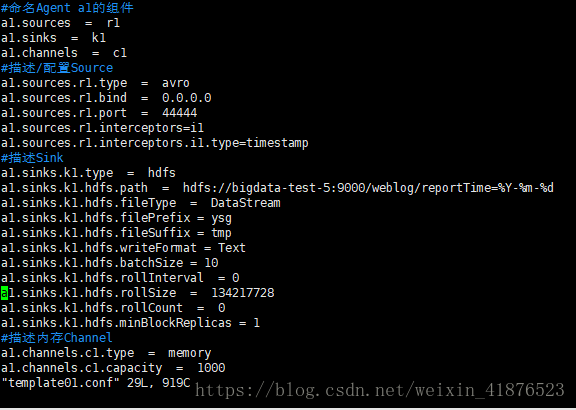

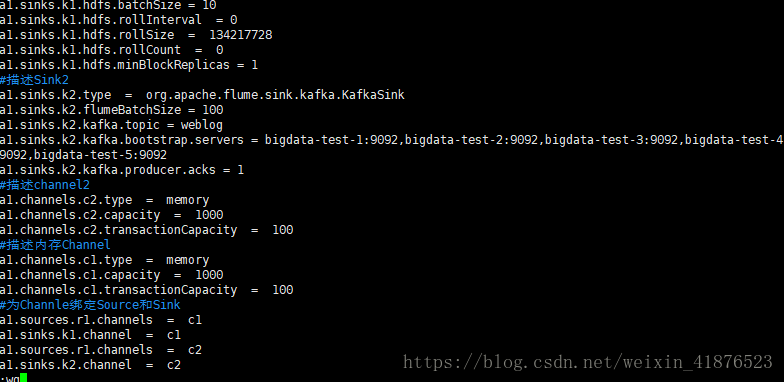

二、flume配置发送数据方式

这个是配置之前的flume 她将数据写入hdfs

flume原理请自己查看flume文档。。新增一个channel和sink。将数据输出到kafka

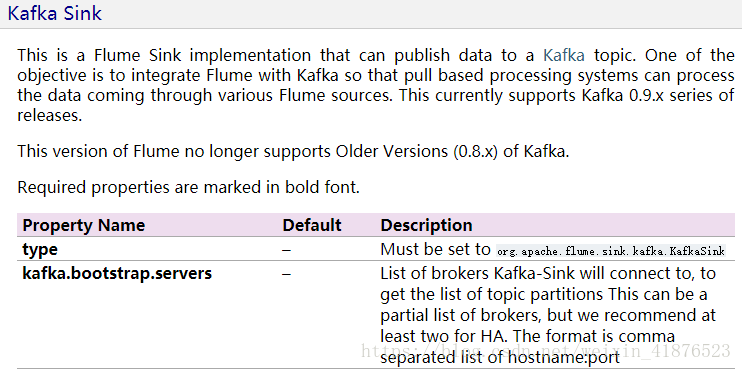

查看flume的官方文档和kafka的配置要求

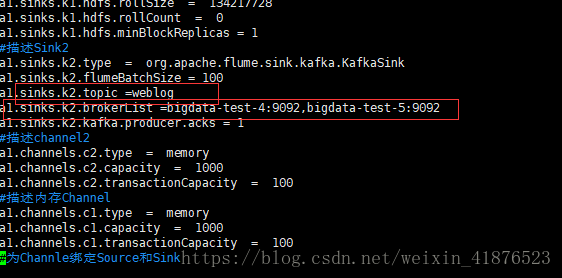

修改后的

启动kafka

./kafka-server-start.sh ../config/server.properties

看看kafka目前的topic

bin/kafka-topics.sh --list --zookeeper bigdata-test-3:2181, bigdata-test-2:2181, bigdata-test-1:2181,bigdata-test-4:2181,bigdata-test-5:2181

查看topic的详细信息

./bin/kafka-topics.sh --describe --zookeeper localhost:2181 --topic weblog

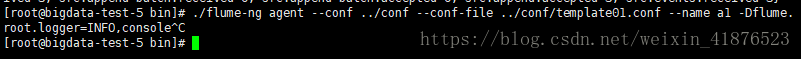

启动flume

./flume-ng agent --conf ../conf --conf-file ../conf/template01.conf --name a1 -Dflume.root.logger=INFO,console

其中出现了消费者接收不到的问题。在flume启动的时候就会报错。链接r2的一只不启动

最后发现是flume版本的问题。之前的配置,新版flume才可以使用

修改后重新启动flume

./flume-ng agent --conf ../conf --conf-file ../conf/template01.conf --name a1 -Dflume.root.logger=INFO,console

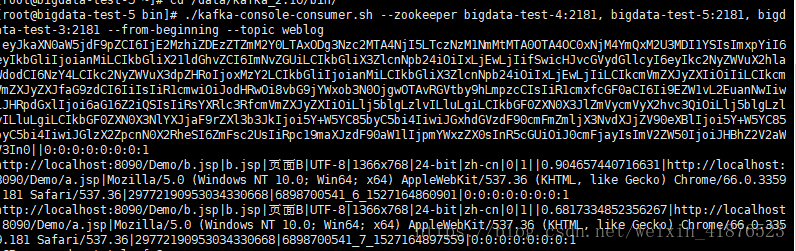

启动kafka客户端

./kafka-console-consumer.sh --zookeeper bigdata-test-4:2181, bigdata-test-5:2181, bigdata-test-3:2181 --from-beginning --topic weblog

启动web客户端 传输过来了数据

验证接受到了数据。。验证完成。

自此kafka集群配置完毕

该博客介绍了如何配置Flume以将数据发送到Kafka,包括查看和删除Kafka topic,修改Flume配置文件以添加新的channel和sink,以及解决Flume版本导致的消费者接收问题。通过启动Kafka和Flume,验证数据成功传输到Kafka。

该博客介绍了如何配置Flume以将数据发送到Kafka,包括查看和删除Kafka topic,修改Flume配置文件以添加新的channel和sink,以及解决Flume版本导致的消费者接收问题。通过启动Kafka和Flume,验证数据成功传输到Kafka。

4495

4495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?