梯度提升迭代决策树GBDT

Boosting家族中另一个重要的算法--梯度提升树(Gradient Boosting Decision Tree,简称GBDT)。GBDT有很多简称,比如GBT(Gradient Boosting Tree),GTB(Gradient Tree Boosting), GBRT(Gradient Boosting Regression Tree),MART(Multiple Additive Regression Tree),其实都是指的同一种算法,本文统一简称GBDT。

思路:

GBDT也是Boosting算法的一种,但是和AdaBoost算法不同;区别如下:AdaBoost算法是利用前一轮的弱学习器的误差来更新样本权重值,然后一轮一轮的迭代;GBDT也是迭代,但是GBDT要求弱学习器必须是CART模型,而且GBDT在模型训练的时候,是要求模型预测的样本损失尽可能的小。

算法步骤:

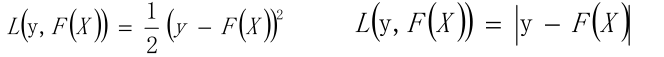

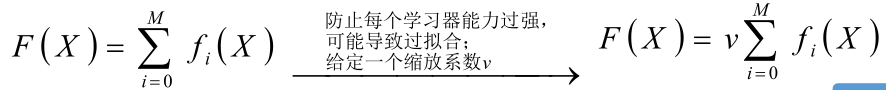

给定输入向量X和输出变量Y组成的若干训练样本(X 1 ,Y 1 ),(X 2 ,Y 2 )......(X n ,Y n ),目标是找到近似函数F(X),使得损失函数L(Y,F(X))的损失值最小。L损失函数一般采用最小二乘损失函数或者绝对值损失函数

![]()

以贪心

GBDT是一种Boosting算法,基于决策树模型,通过最小化损失函数来构建弱学习器的组合。文章介绍了GBDT的思路、算法步骤,并详细讲解了其在分类和回归任务中的损失函数,强调了GBDT在处理各种类型数据和异常值时的鲁棒性优势。

GBDT是一种Boosting算法,基于决策树模型,通过最小化损失函数来构建弱学习器的组合。文章介绍了GBDT的思路、算法步骤,并详细讲解了其在分类和回归任务中的损失函数,强调了GBDT在处理各种类型数据和异常值时的鲁棒性优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5487

5487

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?