一:需求与思路

需求:将新浪新闻的首页的所有新闻爬取到本地 http://news.sina.com.cn/

思路:首先爬首页,通过正则表达式获取所有的新闻链接,然后依次爬取新闻,并存储到本地。

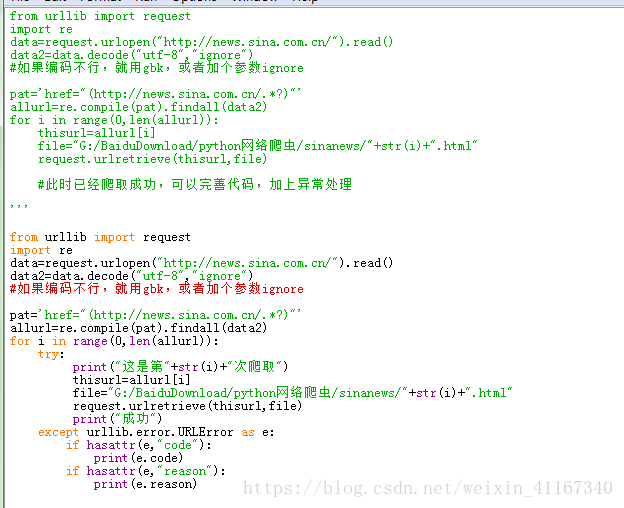

二:实战

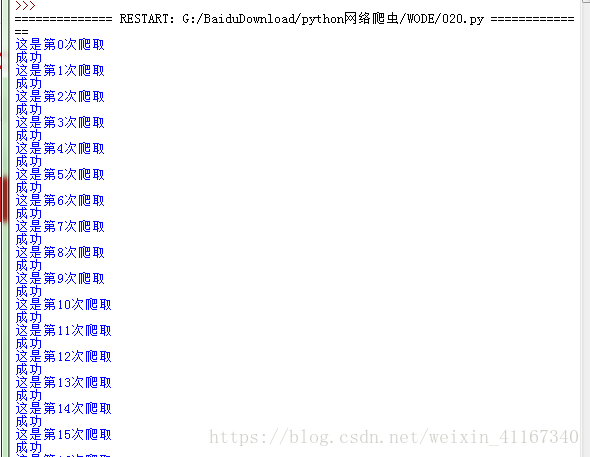

运行程序

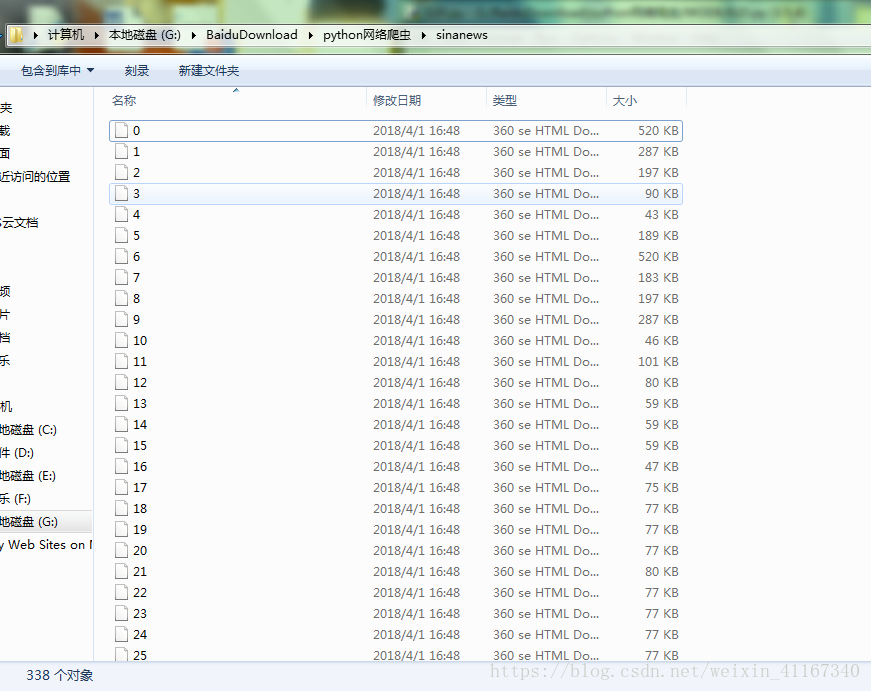

查看爬取结果:

三:综上代码:

from urllib import request

import re

data=request.urlopen("http://news.sina.com.cn/").read()

data2=data.decode("utf-8","ignore")

pat='href="(http://news.sina.com.cn/.*?)"'

allurl=re.compile(pat).findall(data2)

for i in range(0,len(allurl)):

本文介绍如何使用Python的urllib库抓取新浪新闻首页的新闻链接,并逐条爬取存储到本地。首先爬取首页获取新闻链接,再通过正则表达式匹配,最后逐一下载新闻内容。

本文介绍如何使用Python的urllib库抓取新浪新闻首页的新闻链接,并逐条爬取存储到本地。首先爬取首页获取新闻链接,再通过正则表达式匹配,最后逐一下载新闻内容。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

10万+

10万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?