目录

binary_cross_entropysigmoid_cross_entropy

信息论的一些基本概念

信息量

当越不可能的事件发生了,我们获取到的信息量就越大。

越可能发生的事件发生了,我们获取到的信息量就越小。

用公式表示出来就是

熵

熵用来表示所有信息量的期望

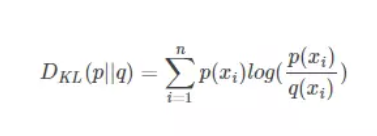

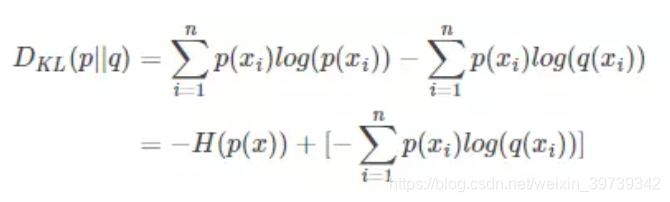

相对熵(KL散度)

相对熵又称KL散度,如果我们对于同一个随机变量 x 有两个单独的概率分布 P(x) 和 Q(x),我们可以使用 KL 散度(Kullback-Leibler (KL) divergence)来衡量这两个分布的差异

交叉熵

损失函数

softmax_cross_entropy

在二分类或者类别相互排斥多分类问题,计算 logits 和 labels 之间的 softmax 交叉熵。

数据必须经过 One-Hot Encoding 编码

binary_cross_entropy

binary_cross_entropy是二分类的交叉熵,实际是多分类softmax_cross_entropy的一种特殊情况,当多分类中,类别只有两类时,即0或者1,即为二分类,二分类也是一个逻辑回归问题,也可以套用逻辑回归的损失函数。

sigmoid_cross_entropy

测量每个类别独立且不相互排斥的离散分类任务中的概率。

6200

6200

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?