个人总结:RNN就是给神经网络加上记忆,为了处理有关联性的数据。

为什么需要RNN?

—— 普通神经网络只能单独的取处理一个个的输入,前一个输入和后一个输入是完全没有关系的。但是,某些任务需要能够更好的处理序列的信息(或者说有关联的信息),即前面的输入和后面的输入是有关系的。

比如:排骨很好吃。(输入是排骨,输出是好吃。这是有关联的,或者一个句子”我 喝 水“输入,输出要判断每个词词性,那么”喝“ 作为v, 他后面是 n 的概率就是最大的。)

序列数据:

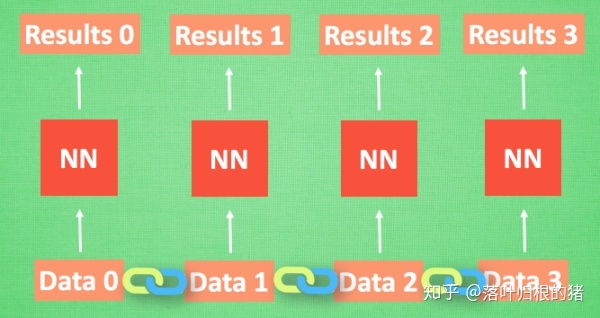

我们想象现在有一组序列数据 data 0,1,2,3. 在当预测 result0 的时候,我们基于的是 data0, 同样在预测其他数据的时候, 我们也都只单单基于单个的数据. 每次使用的神经网络都是同一个 NN. 不过这些数据是有关联 顺序的 , 就像在厨房做菜, 酱料 A要比酱料 B 早放, 不然就串味了. 所以普通的神经网络结构并不能让 NN 了解这些数据之间的关联.

处理序列数据的神经网络:

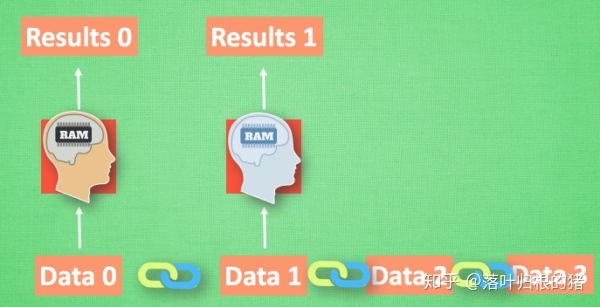

那我们如何让数据间的关联也被 NN 加以分析呢? 想想我们人类是怎么分析各种事物的关联吧, 最基本的方式,就是记住之前发生的事情. 那我们让神经网络也具备这种记住之前发生的事的能力. 再分析 Data0 的时候, 我们把分析结果存入记忆. 然后当分析 data1的时候, NN会产生新的记忆, 但是新记忆和老记忆是没有联系的. 我们就简单的把老记忆调用过来, 一起分析. 如果继续分析更多的有序数据 , RNN就会把之前的记忆都累积起来, 一起分析.

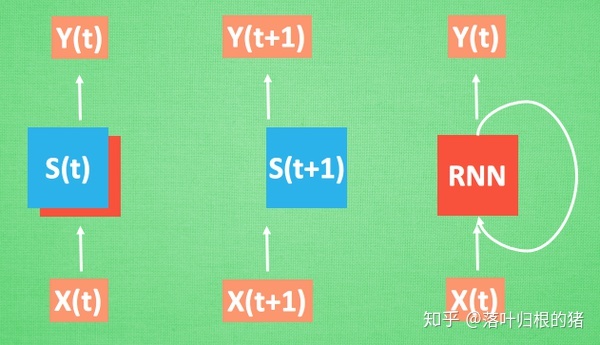

我们再重复一遍刚才的流程, 不过这次是以加入一些数学方面的东西. 每次 RNN 运算完之后都会产生一个对于当前状态的描述 , state. 我们用简写 S( t) 代替, 然后这个 RNN开始分析 x(t+1) , 他会根据

本文介绍了RNN(循环神经网络)的基本概念,阐述了为何需要RNN来处理序列数据,并分析了RNN在处理长序列时遇到的梯度消失和爆炸问题。同时,文章探讨了LSTM(长短期记忆网络)作为解决这些问题的改进模型,详细解释了LSTM的内部结构和工作原理。

本文介绍了RNN(循环神经网络)的基本概念,阐述了为何需要RNN来处理序列数据,并分析了RNN在处理长序列时遇到的梯度消失和爆炸问题。同时,文章探讨了LSTM(长短期记忆网络)作为解决这些问题的改进模型,详细解释了LSTM的内部结构和工作原理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?