今天来讲一下IV值的计算问题

因本人从事风控建模行业,故不可避免需要明白IV值的整个今生前世,故此次来讲解IV值。

一、IV的定义及必备常见知识

IV是什么?全称是Information Value,中文意思是信息价值,或者信息量。

那它有什么内在含义呢?网上公认的答案:变量的预测能力。且通常来讲,变量的IV值越高,则该变量的预测能力越强

这就对选取哪些x进行建模,起到了关键的作用了,但是IV也有其限制的范围。

首先、模型必须是有监督模型(即有y标签变量),其次、y标签必须是二分类(即y只有两类y1,y2)

常见的IV取值范围代表意思如下:

若IV在(-∞,0.02]区间,视为无预测力变量

若IV在(0.02,0.1]区间,视为较弱预测力变量

若IV在(0.1,+∞)区间,视为预测力可以,而实际应用中,也是保留IV值大于0.1的变量进行筛选。

二、IV计算过程

在了解IV计算过程之前,必须明白另一个概念"WOE"

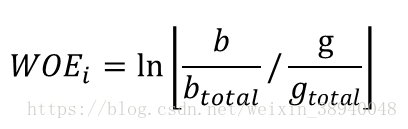

WOE的全称是“Weight of Evidence”,即证据权重。计算公式为:

简单的理解就是 该分箱 坏样本(即b)占比除以好样本(即g)占比的自然对数。(如果对分箱有疑问的同学,可以先简单理解成如果x=0、1、2、3,那么x=0就是一箱,x=1、2、3也是各为一箱)

而从公式也可以体现出WOE的含义:当前分箱中“坏样本占所有坏样本的比例”和“好样本占所有好样本的比例”的差异。很容易可以看出,当差异越大,则该分箱响应坏

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1584

1584

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?