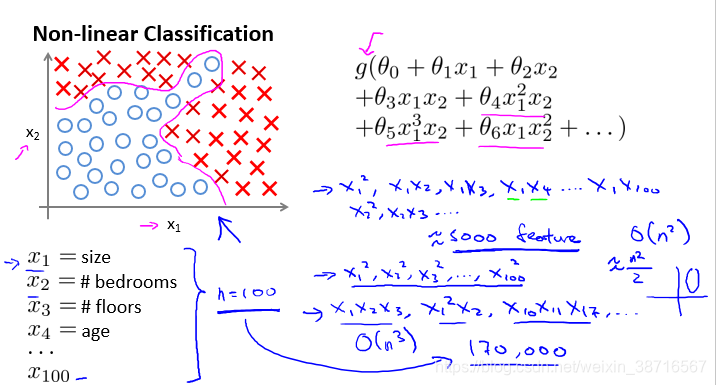

8.1 非线性假设(Non-linear hypotheses)

在非线性的多项式中,特征数变多,特征耦合产生的项数目庞大,普通的逻辑回归根本无法处理此类问题。

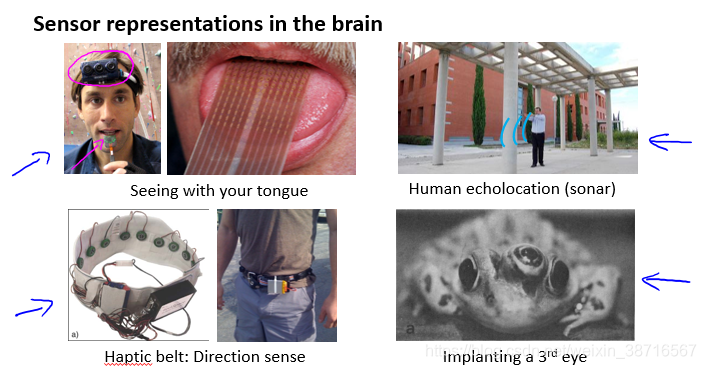

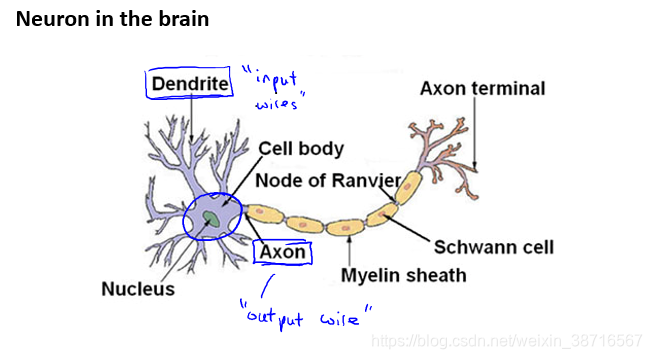

8.2 神经元和大脑(Neurons and the brain)

大脑学习的方法与计算机的算法

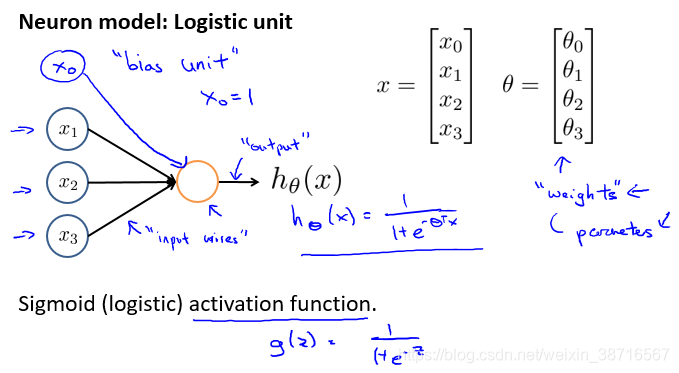

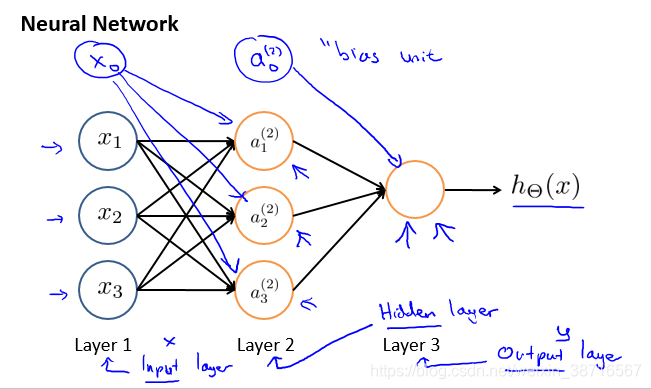

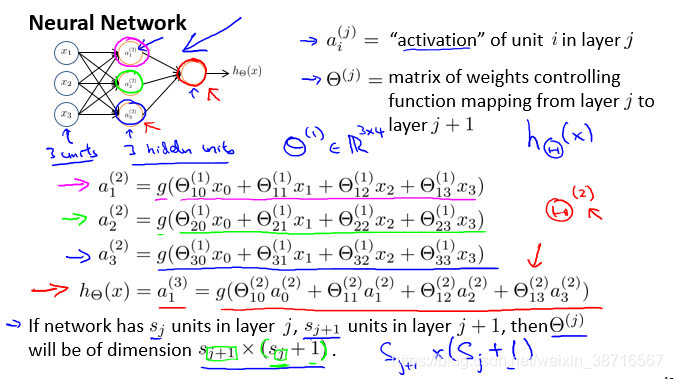

8.3 模型表示 I(Model representation I)

神经网络示意如上图。

神经网络基本结构及其详解。

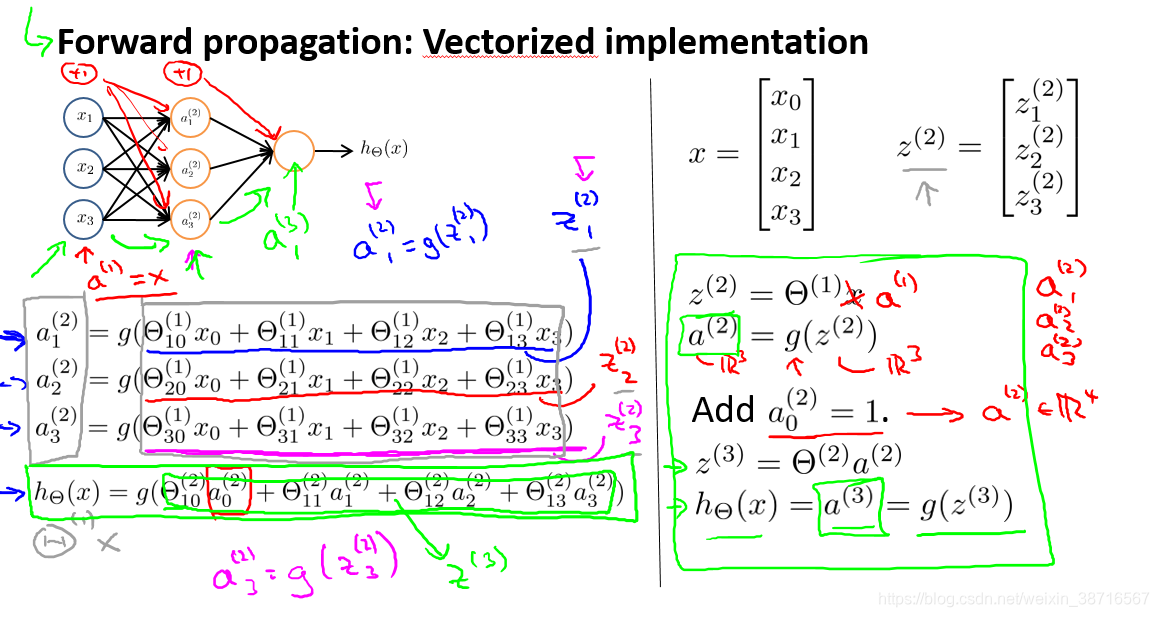

8.4 模型表示 II(Model representation II)

前向传播示意图,如图右半部分所示,可以表示为矩阵 向量乘积。

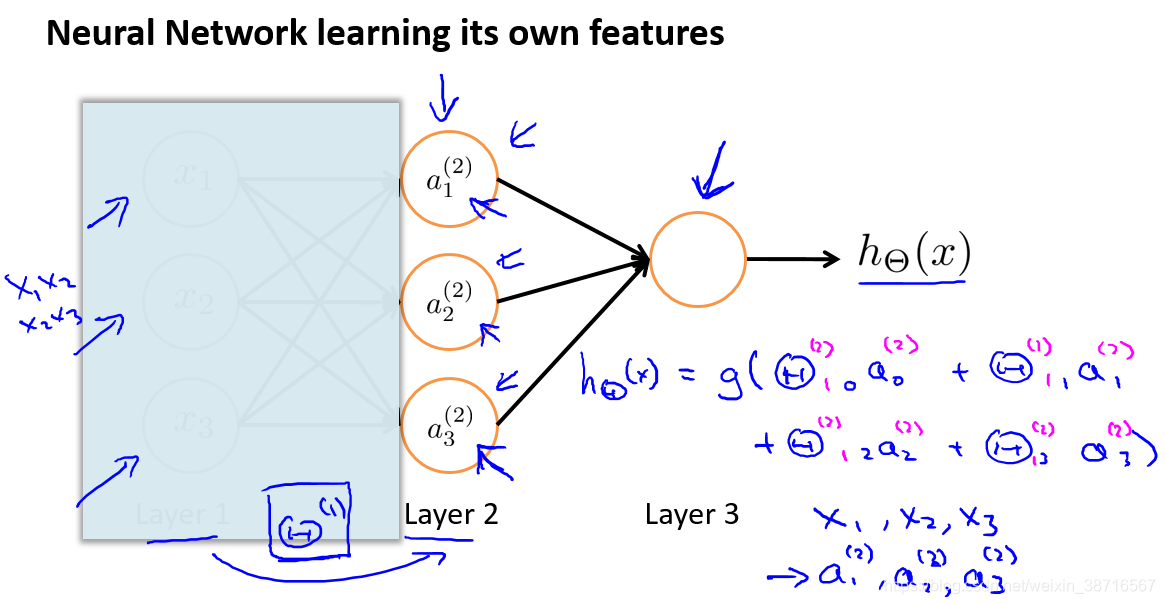

把左边部分挡住,这可以看作一个逻辑回归,但这里的输入不再是x,而是a。不过a也是在x中学习得到的,可以看作比x更高级更复杂也更有效的特征,为什么会更有效或者高阶特征如何利用 ?往下

8.5 例子和直观理解(Examples and intuitions I)

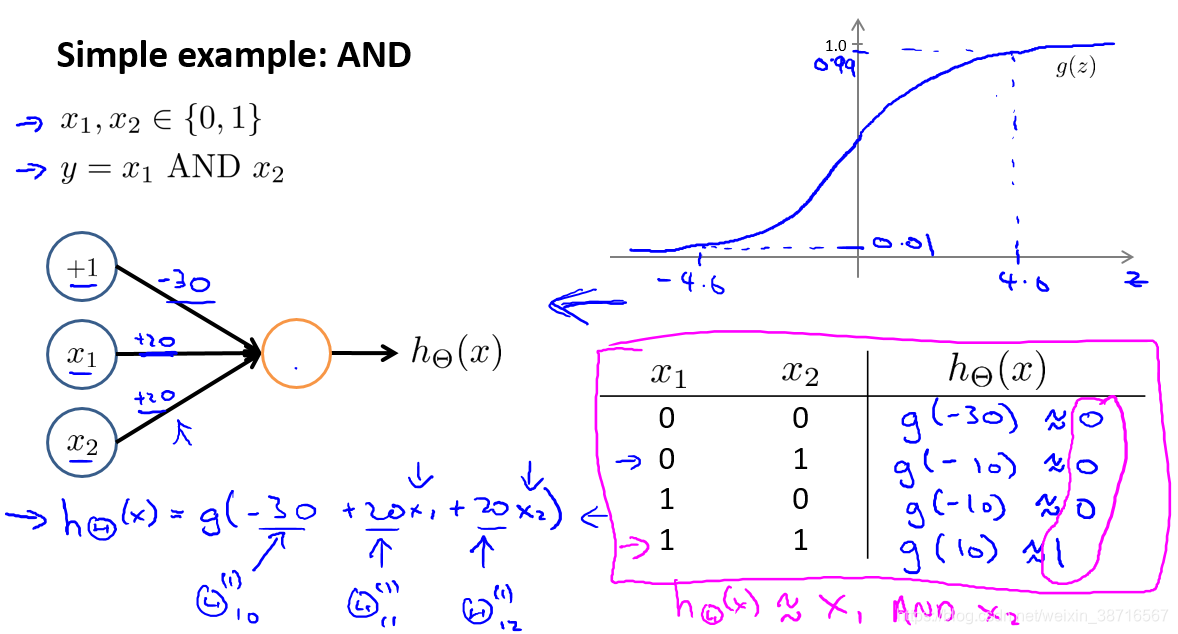

通过一个具体的神经网络求解输入为非线性函数的例子让我们理解神经网络如何学习非线性假设。

加入一个偏置单元

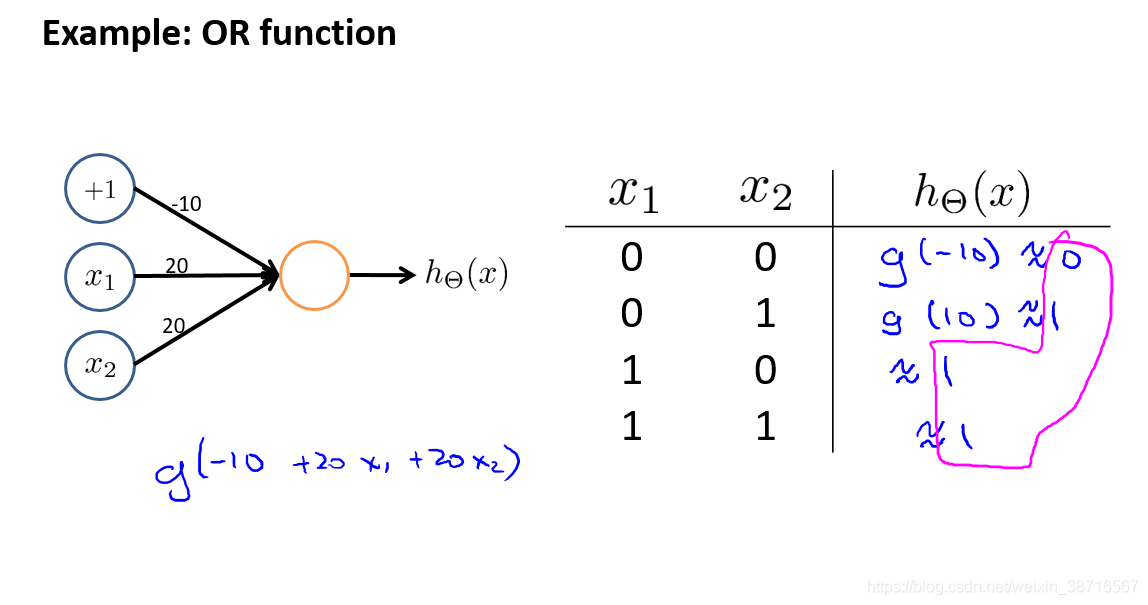

简单的神经元实现AND逻辑门: 简单神经元实现OR逻辑门:

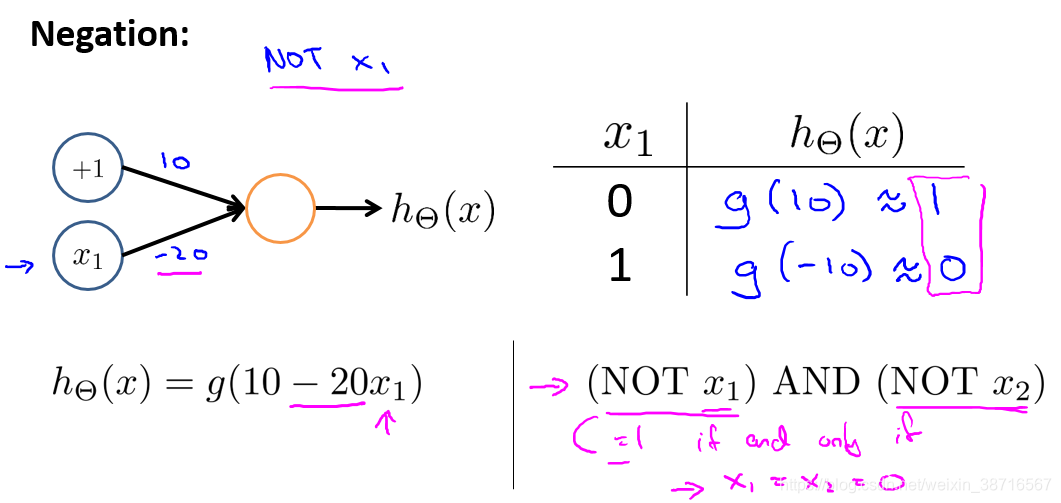

简单神经元实现NOT逻辑门:

8.6 例子和直观理解(Examples and intuitions II)

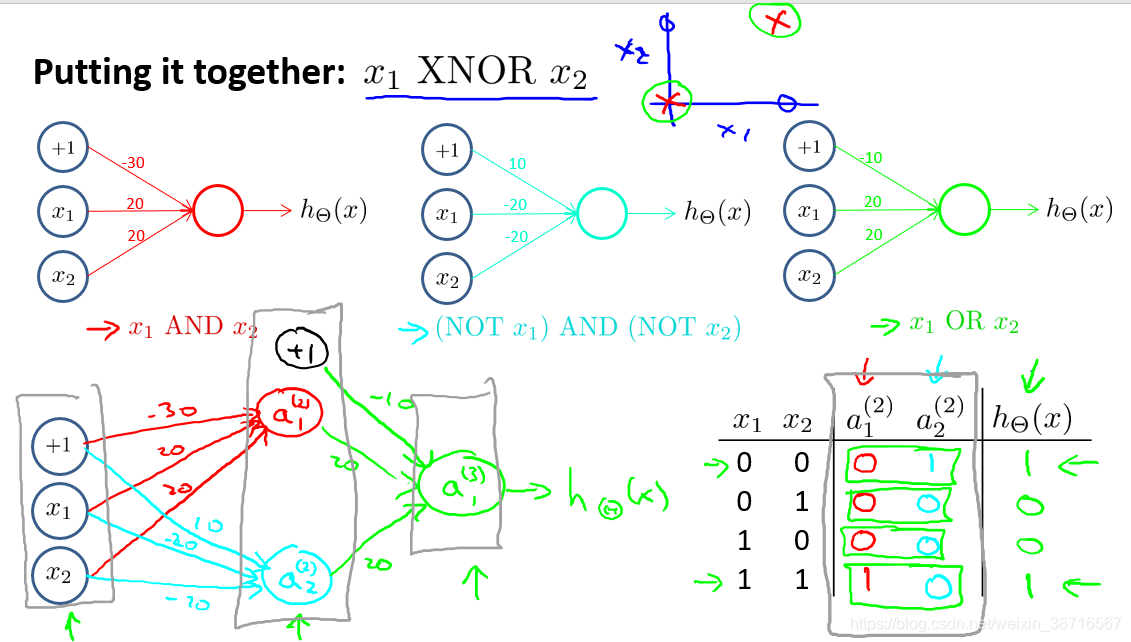

我们想要实现一个同或门XNOR,需要在I中基本逻辑门上建立神经网络:

已知

通过多个隐藏层,我们可以实现更复杂的函数,这就是神经网络这种结构的好处。

输入的特征复杂的特征

更复杂的特征

想要的结果

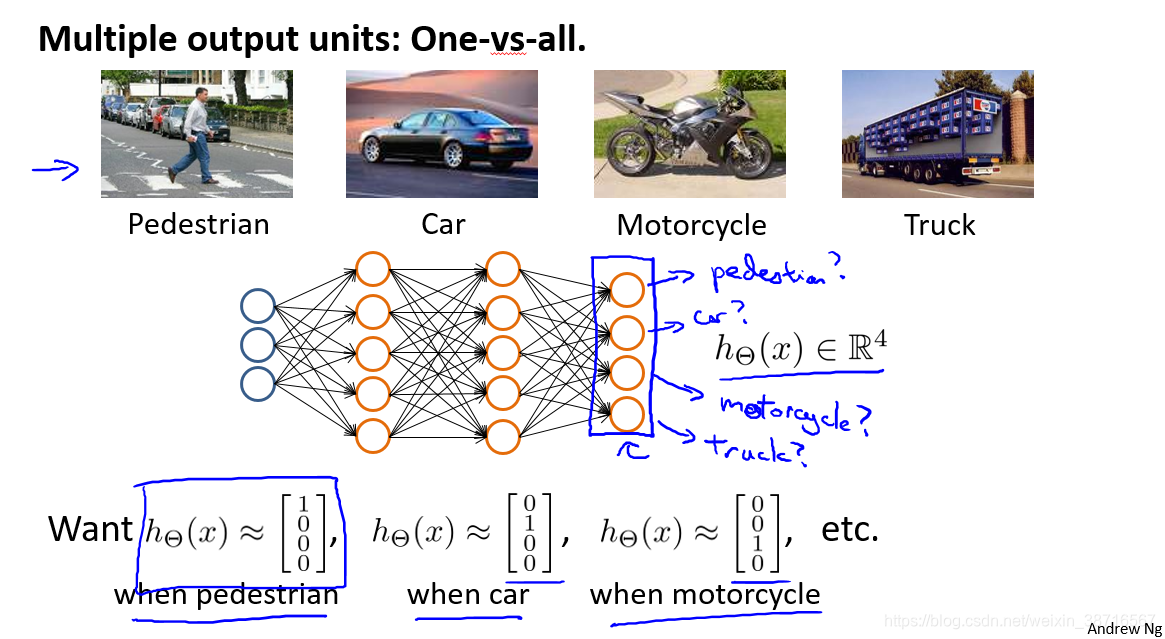

8.7 多类分类

我们需要训练神经网络,得到如下四个输出,来帮助我们分类行人、汽车、摩托、卡车。

值得注意的是这里的输出不用{1,2,3,4}表示。

如何实现如同这里更复杂的神经网络呢?

本文深入探讨了神经网络的基本结构和工作原理,包括非线性假设处理、模型表示、前向传播过程,以及如何通过多层神经元实现复杂的非线性函数。通过具体例子,如逻辑门和XNOR门的实现,展示了神经网络学习非线性假设的能力。此外,还讨论了神经网络在多类分类任务中的应用。

本文深入探讨了神经网络的基本结构和工作原理,包括非线性假设处理、模型表示、前向传播过程,以及如何通过多层神经元实现复杂的非线性函数。通过具体例子,如逻辑门和XNOR门的实现,展示了神经网络学习非线性假设的能力。此外,还讨论了神经网络在多类分类任务中的应用。

5761

5761

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?