1)将vcf转化为plink格式,假定输入的vcf文件名为:17893893-17898893.vcf,也可以参考链接:将vcf文件转化为plink格式并且保持phasing状态

/vcftools --vcf 17893893-17898893.vcf --plink-tped --out 17893893-17898893 /plink --tfile 17893893-17898893 --recode --out 17893893-17898893

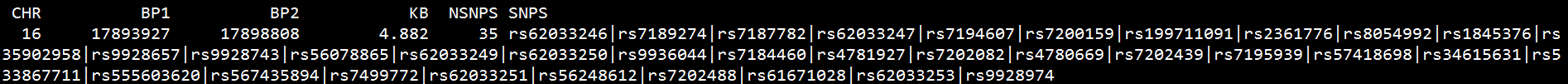

2) 用PLINK确定要研究的位点是否处于连锁的状态;生成blocks和blocks.det两种后缀格式文件;

/plink --file 17893893-17898893 --blocks no-pheno-req --out 17893893-17898893

以上结果说明rs62033

本文详细介绍了如何利用popart软件构建常染色体单倍型网络。首先,从vcf文件转为plink格式,通过PLINK确定连锁位点。接着,提取连锁的35个位点,生成singstring文件和两条单链fas格式文件。然后,用DnaSP6将fas文件转换为nex文件,并统计不同群体的单倍型数量。最后,手动修改nex文件并用popart构建单体型网络。

本文详细介绍了如何利用popart软件构建常染色体单倍型网络。首先,从vcf文件转为plink格式,通过PLINK确定连锁位点。接着,提取连锁的35个位点,生成singstring文件和两条单链fas格式文件。然后,用DnaSP6将fas文件转换为nex文件,并统计不同群体的单倍型数量。最后,手动修改nex文件并用popart构建单体型网络。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3715

3715

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?