直接按照说明跑:

python dataAli-sameUserDevice.py

python pairDataFile.py

python sep_HHAR_data.py但在sep_HHAR_data.py的时候一直跑不出来,我发现这个代码处理的是Dataset_AccGry_SourceDevice-Creation_Time-avgTime这个文件夹下的文件,这个文件夹有2G,代码里需要存储一个dict,是针对所有的文件,这就造成了需要大量的内存来存储这些信息,自己电脑内存比较小就会卡

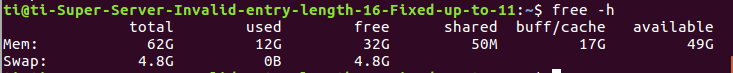

free -h看的是内存、buffer、cache和swap

-h:G为单位 -m:M为单位

total是总共,used是已使用,free是未使用

我的dict使用的都是mem,即内存

buffer 用于存放要输出到磁盘的数据,而cache是从磁盘读出存放到内存中待今后使用的数据。它们的引入均是为了提供IO的性能

swap为虚拟内存

本文介绍了一次尝试运行大数据处理脚本的经历,在处理一个2GB大小的文件夹时遇到内存不足的问题。文中详细分析了问题的原因,并探讨了解决内存瓶颈的方法。

本文介绍了一次尝试运行大数据处理脚本的经历,在处理一个2GB大小的文件夹时遇到内存不足的问题。文中详细分析了问题的原因,并探讨了解决内存瓶颈的方法。

913

913

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?