1 Why?

- Reason1 Knowledge Discovery

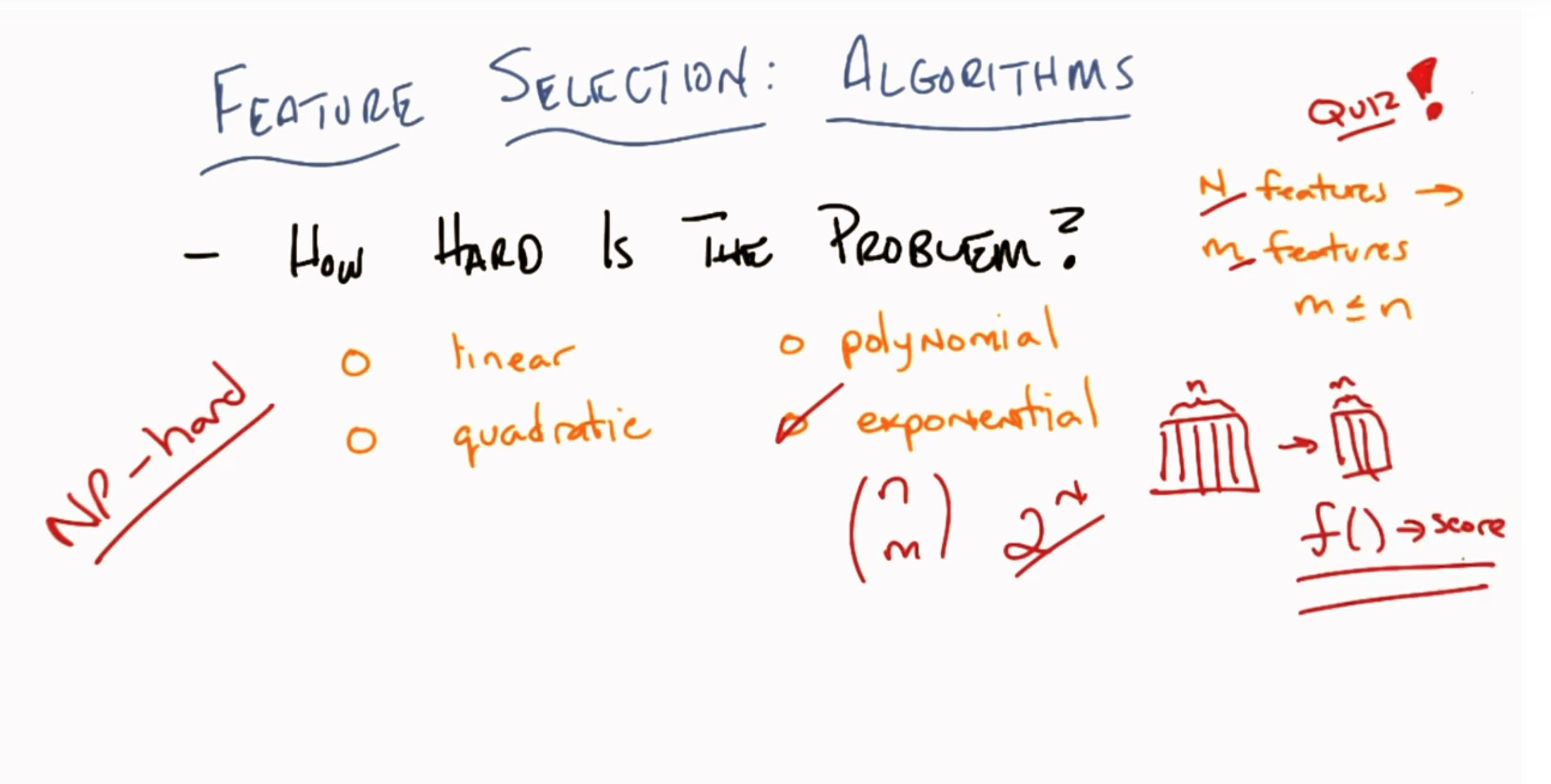

(about human beings limitaitons) Reason2 Cause of Dimensionality (维度灾难)

(about ML algorithm itself)

所需的数据量会根据你所拥有的特征数量以指数速度增长2 NP-Hard Problem

arbitrarily choose m features from n features (m≤n),don't know what m truely is before you choose.

复杂度 exponentail

NP-hard,其中,NP是指非确定性多项式(non-deterministic polynomial,缩写NP)。所谓的非确定性是指,可用一定数量的运算去解决多项式时间内可解决的问题。

NP-hard问题通俗来说是其解的正确性能够被“很容易检查”的问题,这里“很容易检查”指的是存在一个多项式检查算法。相应的,若NP中所有问题到某一个问题是图灵可归约的,则该问题为NP困难问题。

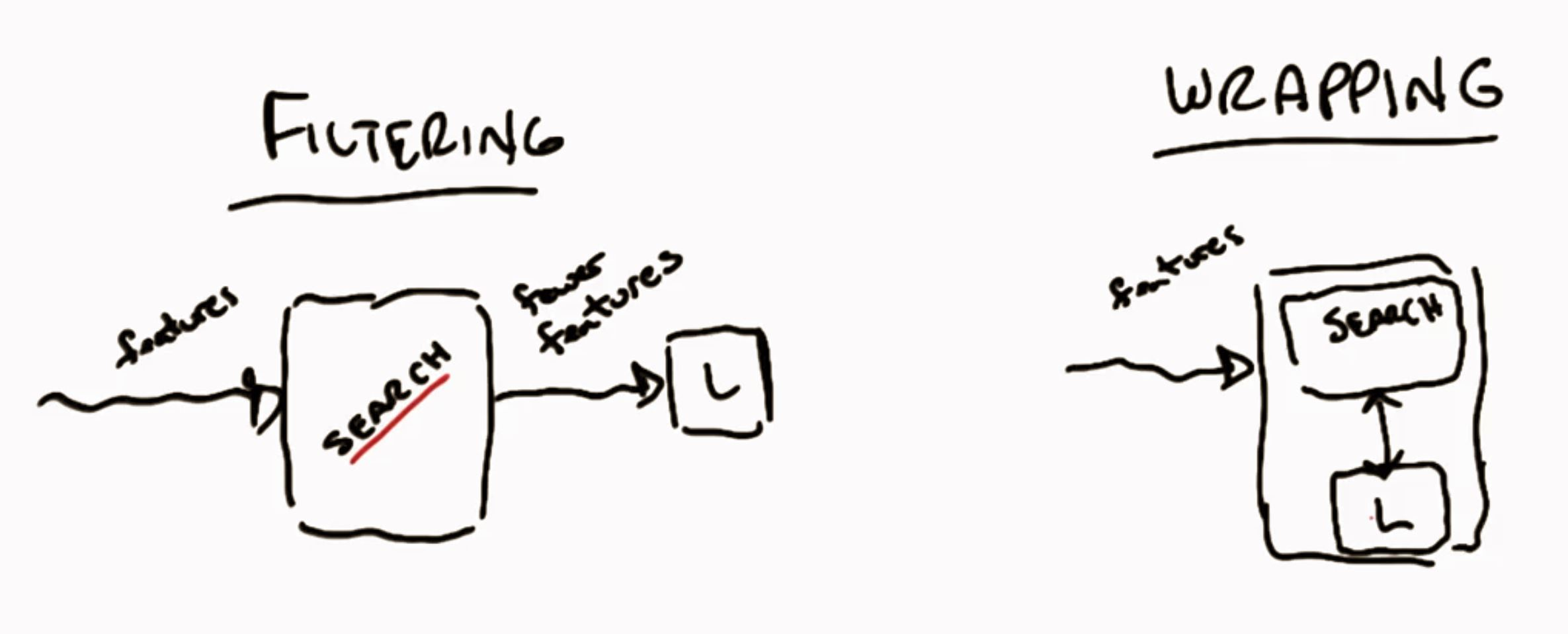

3 Solution: Filtering & Wrapping | 解决方法 过滤&封装

3.1 Filtering | 过滤

先对特征进行过滤,然后将其传递至学习算法(图示 )

+ Speed (pros)

- Ignores the learning problem(cons)

3.2 Wrapping | 封装

对特征的搜索针对你的学习算法展开

+ take model bias into accounts

- so.... slow

Relevance vs Usefulness

- Relevance ~ information

- Usefulness ~ Error

本文探讨了特征选择的重要性,分析了维度灾难的原因及其对机器学习算法的影响,并提出了两种解决方案:过滤法和封装法。过滤法速度快但可能忽略学习问题,封装法则考虑到了模型偏差但速度较慢。

本文探讨了特征选择的重要性,分析了维度灾难的原因及其对机器学习算法的影响,并提出了两种解决方案:过滤法和封装法。过滤法速度快但可能忽略学习问题,封装法则考虑到了模型偏差但速度较慢。

986

986

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?