简介:Apache Airflow是一个开源的工作流管理平台,主要用于创建、监控和调度复杂的数据处理任务。其核心理念是将工作流程定义为代码,便于版本控制、测试和协作。本课程项目将深入探讨工作流定义、Python API、任务与运算符、调度与依赖、Web UI、扩展性、容错与重试机制、资源管理和并行性、集成其他服务以及最佳实践等关键知识点。通过理论与实践的结合,帮助学生掌握如何使用Airflow来构建高效可靠的数据处理工作流。

1. Airflow工作流管理平台简介

在数据工程和数据管道管理领域,Airflow 逐渐成为事实上的工业标准工具。本章将带领读者从零开始,了解Airflow是什么,它能解决什么问题,以及如何搭建一个基础的Airflow工作环境。

1.1 Airflow的诞生背景和核心价值

Apache Airflow是一个开源的工作流编排平台,由Airbnb于2014年创建,并于2016年捐赠给Apache软件基金会。Airflow是用于编写、调度和监控工作流任务的平台,能够以程序化的方式组织和监控这些任务的执行。它的核心价值在于其灵活性和可编程性,允许用户通过Python代码来描述和控制工作流。

1.2 Airflow的主要组件和架构

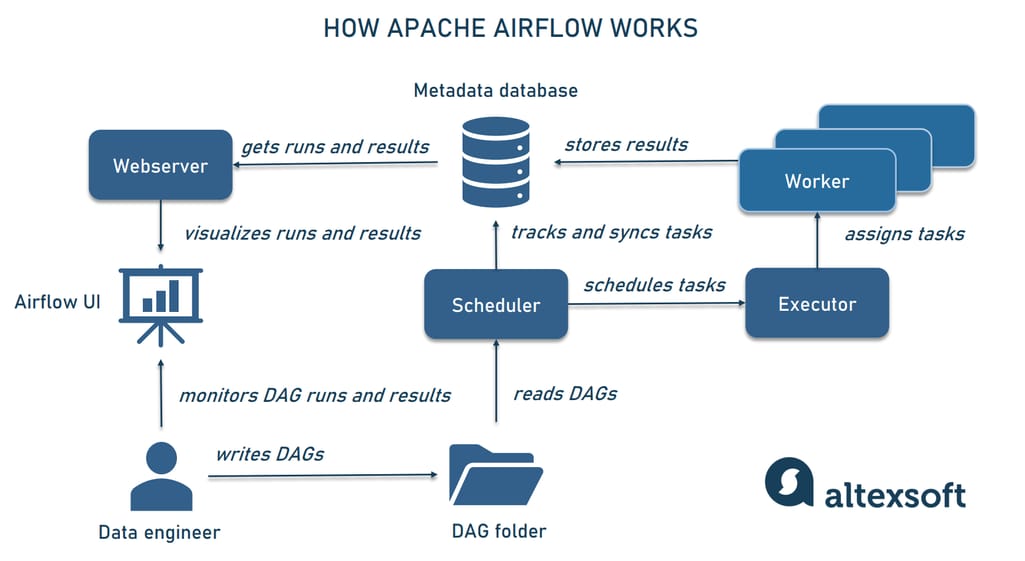

Airflow的主要组件包括调度器(Scheduler)、工作流引擎(Executor)、元数据数据库(Metadata Database)、工作节点(Workers)和Web用户界面(UI)。通过这些组件,Airflow构建了一个从任务定义、调度执行到监控反馈的完整工作流管理体系。

1.3 如何安装和运行Airflow

安装Airflow相对简单,推荐使用官方提供的 apache-airflow Python包进行安装。运行Airflow则需要启动调度器(Scheduler)和至少一个工作节点(Worker)。通过Web UI界面,用户可以直观地查看任务状态和调度情况。以下是一个快速安装并启动Airflow的示例步骤:

# 安装Airflow

pip install apache-airflow

# 初始化Airflow数据库

airflow db init

# 启动Airflow web server

airflow webserver -p <port>

# 启动Airflow scheduler

airflow scheduler

在完成上述步骤后,Airflow便成功搭建在本地环境中,用户可以通过 ***<port> 访问Web UI界面进行后续操作。

Airflow的安装和启动只是开始,接下来的章节将会深入介绍如何定义工作流、使用Python API进行任务的编写和管理,以及如何对任务进行调度和监控。这些内容将为读者提供全面的Airflow使用知识,帮助你构建稳定高效的数据处理管道。

2. DAG工作流定义与执行

在Airflow的世界里,DAG(Directed Acyclic Graph)是构成工作流的骨架。每个DAG都是由一系列的任务节点组成,这些任务按照特定的顺序和依赖关系连接成一个整体,来完成复杂的业务逻辑。理解DAG的工作流对于有效使用Airflow至关重要,因为它不仅关系到任务的定义和执行,还涉及到任务的调度、监控和维护。

2.1 DAG的基本概念解析

2.1.1 DAG的定义和作用

DAG是一种数据结构,它表示了一系列的有向无环图,其中每个节点代表一个任务,有向边代表任务之间的依赖关系。在Airflow中,DAG定义了任务的执行流程、任务间的依赖关系以及任务的执行时间计划等关键信息。DAG的执行需要遵循以下基本原则:

- 有向性 :所有的任务都有明确的执行方向,意味着没有循环依赖的情况发生。

- 无环性 :DAG中不存在任何循环路径,即从一个任务出发,无法通过路径回到这个任务本身。

DAG在Airflow中的作用主要体现在以下几点:

- 任务调度 :DAG确定了任务之间的依赖关系,Airflow可以据此安排任务执行的顺序。

- 数据流管理 :通过DAG,可以清晰地管理任务之间的数据流向,确保数据正确流动。

- 故障处理 :当任务执行失败时,DAG可以定义重试机制,帮助恢复工作流的执行。

2.1.2 DAG文件结构和配置要点

DAG文件通常由Python代码构成,保存为 .py 格式。一个基本的DAG文件结构包含以下几个重要部分:

- 导入必要的模块 :如

airflow.models,airflow.operators, 和airflow.utils等。 - DAG的定义 :通过实例化

DAG类来定义DAG,需要设置诸如start_date,schedule_interval, 和catchup等参数。 - 任务的定义 :使用各种运算符定义具体的任务,并通过DAG实例来组织这些任务。

- 依赖关系的设置 :通过在任务之间建立依赖关系来描述任务之间的执行顺序。

一个简单的DAG配置示例如下:

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

from datetime import datetime

default_args = {

'start_date': datetime(2023, 1, 1),

'owner': 'airflow'

}

dag = DAG(

'tutorial',

default_args=default_args,

description='A simple tutorial DAG',

schedule_interval='@daily',

)

t1 = BashOperator(

task_id='print_date',

bash_command='date',

dag=dag

)

t2 = BashOperator(

task_id='sleep',

bash_command='sleep 5',

retries=3,

dag=dag

)

t1 >> t2 # 设置依赖关系

在此示例中, t1 任务会先执行,然后 t2 任务在 t1 之后执行。这样的设置确保了任务之间的执行顺序和依赖性。

2.2 DAG的编写实战

2.2.1 创建和编排任务节点

在Airflow中,创建任务节点是通过定义运算符(Operators)来完成的。运算符表示了要执行的具体操作,如运行一个脚本、执行一个Hive查询等。任务节点通过运算符来实例化,并且在DAG文件中进行定义。

常见的运算符类型包括但不限于 BashOperator , PythonOperator , HiveOperator 等。每种运算符都有其特定的用途和参数配置。

创建任务节点的步骤如下:

- 导入所需的运算符模块。

- 创建DAG实例。

- 定义具体的运算符实例,并为其指定必要参数,例如

task_id,bash_command等。 - 使用

>>或set_upstream/set_downstream方法来设置任务之间的依赖关系。

2.2.2 设置任务依赖关系

任务间的依赖关系是通过DAG中的定义来表达的。当两个任务存在依赖时,执行顺序会严格按照定义的关系进行。依赖关系可以是简单的线性顺序,也可以是复杂的分支结构。

Airflow支持多种方式来设置任务依赖:

- 使用

>>和<<操作符来表示任务之间的顺序。 - 使用

set_upstream和set_downstream方法来表示任务之间的上游和下游关系。 - 使用

add_task()方法来动态地添加任务依赖。

例如,以下代码片段演示了如何使用 >> 来设置两个任务的依赖关系:

t3 = BashOperator(

task_id='echo_3',

bash_command='echo "Task 3!"',

dag=dag

)

t4 = BashOperator(

task_id='echo_4',

bash_command='echo "Task 4!"',

dag=dag

)

t3 >> t4 # t4 依赖于 t3

2.2.3 DAG的启动与暂停机制

DAG在Airflow中的执行可以由用户启动或由调度系统根据设置的调度策略自动执行。启动DAG的操作可以是单次执行,也可以是周期性执行。

- 手动触发 :可以在Airflow的Web UI界面上选择特定的DAG进行启动。

- 自动调度 :根据DAG文件中设置的

start_date,schedule_interval等参数,Airflow会定时执行DAG。

Airflow也提供了灵活的暂停和恢复DAG的功能,这允许在特定情况下暂停执行,以进行维护或调试。在Web UI中,可以通过简单地点击按钮来暂停或恢复DAG,也可以通过编程方式设置DAG的状态。

以下是暂停和恢复DAG的一个编程示例:

from airflow.utils.state import State

from airflow.models import DagRun

from airflow.utils.dates import days_ago

dag_id = 'tutorial'

# 暂停DAG

dag_runs = DagRun.find(dag_id=dag_id)

for dag_run in dag_runs:

dag_run.state = State.PAUSED

dag_run.save()

# 恢复DAG

dag_runs = DagRun.find(dag_id=dag_id, state=State.PAUSED)

for dag_run in dag_runs:

dag_run.state = State.RUNNING

dag_run.save()

通过这些机制,DAG的执行变得灵活可控,既可以满足日常的自动化执行需求,也能够适应意外情况的处理。

3. Python API在Airflow中的应用

3.1 Python API基础

3.1.1 Python API的基本使用方法

Airflow 提供了强大的 Python API,允许用户以编程方式创建和管理任务、DAGs 以及执行各种操作。基本的 Python API 使用方法涉及到导入 Airflow 相关模块,然后使用这些模块提供的类和方法进行工作流定义。Airflow 的核心是 DAG 对象,它表示有向无环图。通过 Python 的 DAG 对象,可以定义任务之间的依赖关系,以及设置任务执行的顺序。

使用 Python API 时,通常需要导入 Airflow 相关的模块,例如 airflow.models.dagbag , airflow.utils.dates 等。然后通过定义函数来创建任务,这些函数需要包含实际的任务逻辑。最后,通过调用 airflow.models.dag.DAG 对象来创建 DAG 实例,并将定义的任务作为 DAG 的一部分。

下面是一个简单的代码示例,展示了如何使用 Python API 定义一个包含两个任务的 DAG:

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

from datetime import datetime, timedelta

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': datetime(2021, 1, 1),

'email': ['***'],

'email_on_failure': False,

'email_on_retry': False,

'retries': 1,

'retry_delay': timedelta(minutes=5)

}

dag = DAG(

'tutorial',

default_args=default_args,

description='A simple tutorial DAG',

schedule_interval=timedelta(days=1),

)

# define the tasks

task1 = BashOperator(

task_id='print_date',

bash_command='date',

dag=dag)

task2 = BashOperator(

task_id='sleep',

bash_command='sleep 5',

retries=3,

dag=dag)

# set dependencies

task1 >> task2

在这个例子中,我们首先导入了所需的类和方法,然后定义了 default_args ,这是一个字典,用来指定 DAG 的默认参数。接着,我们创建了一个 DAG 实例,指定了 DAG 的名称、默认参数、描述和调度间隔。然后,我们创建了两个 BashOperator 类型的任务,分别是 task1 和 task2 。最后,我们通过 >> 操作符设置了任务之间的依赖关系。

3.1.2 使用Python API定制任务

Python API 提供了高度的灵活性来定制任务。通过编写 Python 函数,可以实现复杂的数据处理逻辑、动态生成任务以及构建复杂的依赖关系。使用 Python API 定制任务,可以方便地与其他 Python 库和框架集成,例如使用 pandas 进行数据处理,或者使用 requests 进行 HTTP 请求。

当使用 Python API 定制任务时,通常需要实现一个函数,并使用 PythonOperator 来执行该函数。例如,我们可以创建一个函数 custom_task_function ,然后将其作为参数传递给 PythonOperator :

from airflow.operators.python_operator import PythonOperator

def custom_task_function(**context):

print("This is a custom task.")

# 这里可以添加更多复杂的数据处理逻辑

custom_task = PythonOperator(

task_id='custom_task',

python_callable=custom_task_function,

provide_context=True,

dag=dag

)

在上面的代码中, custom_task_function 是一个接收 **context 参数的函数,它打印了一个简单的消息。我们使用 PythonOperator 来创建 custom_task 任务,指定了任务 ID 和要执行的函数 custom_task_function 。 provide_context=True 参数表示在调用 custom_task_function 时,需要传递 context 参数,它包含了运行时的上下文信息。

利用这种灵活性,可以进一步实现动态任务生成、条件判断和复杂的业务逻辑处理,让 Airflow 的应用范围更加广泛。

3.2 Python API高级应用

3.2.1 动态任务生成技术

动态任务生成是在运行时基于条件或数据动态创建任务的能力。这种技术在处理不同类型数据源或根据配置文件生成任务时特别有用。在 Airflow 中,可以使用 BranchPythonOperator 和 ShortCircuitOperator 来实现动态任务生成。

BranchPythonOperator 允许用户在运行时决定接下来应该执行的任务,它运行 Python 函数并根据函数的返回值来选择执行路径。如果返回一个任务 ID,则执行该任务;如果返回 None 或者抛出异常,则跳过或停止执行。 ShortCircuitOperator 在运行时返回布尔值,根据返回的 True 或 False 来决定后续执行的路径。

下面是一个使用 BranchPythonOperator 来实现动态任务生成的示例:

from airflow.operators.python_operator import BranchPythonOperator

from airflow.operators.dummy_operator import DummyOperator

def dynamic_task_selection(**kwargs):

x = random.randint(1, 10)

if x > 5:

return 'task_b'

else:

return 'task_c'

dynamic_task = BranchPythonOperator(

task_id='branch_task',

python_callable=dynamic_task_selection,

provide_context=True,

dag=dag

)

task_b = DummyOperator(task_id='task_b')

task_c = DummyOperator(task_id='task_c')

dynamic_task >> [task_b, task_c]

在这个例子中, dynamic_task_selection 函数根据随机数生成的值决定执行 task_b 还是 task_c 。 BranchPythonOperator 根据函数的返回值,决定接下来执行的任务。

3.2.2 参数化任务的实现

参数化任务是指根据传递给任务的参数执行不同的操作。在 Airflow 中,可以通过 Python API 将参数传递给任务,这些参数可以是硬编码值、模板变量或动态生成的值。

参数可以作为上下文传递给 PythonOperator 中的函数,也可以在函数内部通过特定的参数获取。模板变量是 Airflow 中用于传递参数的强大工具,它们可以在 DAG 文件中使用 Jinja 模板语法定义,并在运行时被替换。

以下是如何在 Python API 中使用参数化任务的示例:

from airflow.operators.python_operator import PythonOperator

from airflow.models import Variable

def parameterized_task(**context):

param_value = Variable.get("my_variable")

print(f"Parameter value: {param_value}")

parameterized_task = PythonOperator(

task_id='parameterized_task',

python_callable=parameterized_task,

provide_context=True,

dag=dag

)

在这个例子中,我们定义了一个名为 parameterized_task 的任务。函数 parameterized_task 通过上下文接收传递的参数,并使用 Variable.get 方法来获取存储在 Airflow 变量中的参数值。

3.2.3 错误处理与重试策略

在实际的工作流中,任务可能会因为各种原因失败。Airflow 提供了灵活的错误处理和重试策略来管理这些情况。通过 Python API,可以定义自定义的异常处理逻辑,并且可以设置任务在失败时进行自动重试。

在 PythonOperator 中,可以通过 retries 参数设置任务失败后的重试次数, retry_delay 参数定义重试之间的延迟时间。此外,可以通过捕获异常来实现更复杂的错误处理逻辑。

以下是一个简单的重试策略示例:

from airflow.exceptions import AirflowFailException

def error_prone_task(**context):

if random.randint(0, 10) < 3:

raise AirflowFailException('Task failed intentionally!')

print('Task executed successfully!')

task = PythonOperator(

task_id='error_prone_task',

python_callable=error_prone_task,

retries=5,

retry_delay=timedelta(minutes=1),

dag=dag

)

在这个例子中, error_prone_task 函数会随机失败。如果失败,它会抛出一个 AirflowFailException 异常,根据重试策略,任务会自动尝试重新执行,直到达到最大重试次数。 retry_delay 参数指定了两次重试之间的延迟时间。

通过这种方式,可以根据任务的需要定制复杂的错误处理逻辑,并且通过调整重试策略来优化工作流的可靠性和效率。

4. 任务与运算符的定义和使用

任务和运算符是Airflow工作流的基石。任务定义了工作流中每个步骤应该做什么,而运算符决定了任务如何执行。了解如何正确地定义和使用任务与运算符对于设计和管理复杂的工作流至关重要。

4.1 任务的基本定义

4.1.1 任务的生命周期

任务(Task)是Airflow中最小的工作单元,它代表了数据管道中的一个特定操作。每个任务都会经历一个生命周期,包括定义、实例化、排队、执行、成功或失败等状态。

- 定义阶段 :在编写DAG文件时,我们定义了一个任务,此时它仅是代码中的一段声明。

-

实例化阶段 :当DAG被加载到Airflow时,定义的任务会转化为具体的任务实例(Task Instances),每个实例代表了任务的一次运行。

-

排队阶段 :根据依赖关系和调度策略,任务实例会被Airflow放入队列中等待执行。

-

执行阶段 :一旦被调度器选中,任务实例会开始执行。这个阶段可能包括任务实例的启动、运行、成功完成或失败。

-

结束阶段 :任务实例执行完成后,状态被更新(成功或失败),相关的日志记录也会完成。

4.1.2 任务实例化与执行

每个任务在实例化时都会根据其依赖和调度时间产生一个具体的时间点。Airflow的任务执行机制可以概括如下:

- 依赖检查 :Airflow会检查任务是否满足运行的所有前置条件,包括任务依赖是否全部满足和时间是否已达到预定的执行时间。

- 任务调度 :调度器检查任务实例是否可以被分配资源进行执行。

- 资源分配 :调度器决定执行任务的机器,并将任务实例放入队列中。

- 执行 :在适当的时间点,执行器会取走队列中的任务实例,并执行之。

- 状态更新 :任务执行完成后,其状态(成功或失败)会被更新,并且相关的日志信息会被记录。

任务的执行可以使用多种执行器(Executor),例如 SequentialExecutor (串行执行)、 LocalExecutor (本地执行)、 CeleryExecutor (分布式执行)等。

4.2 运算符的种类和用途

运算符(Operator)是Airflow中用于定义任务的类。每个运算符都有特定的功能和用法。运算符的选择对工作流的性能和可维护性有重要影响。

4.2.1 常见运算符介绍

以下是一些在Airflow中最常见的运算符:

- BashOperator :执行Bash命令。

- PythonOperator :运行Python函数。

- EmailOperator :发送电子邮件。

- Sensor :等待某些条件成立。

- HttpOperator :执行HTTP请求。

这些运算符涵盖了从文件操作到外部API调用等多种操作。选择合适的运算符可以简化DAG的编写和任务的管理。

4.2.2 自定义运算符的实现

在Airflow中,也可以根据需要自定义运算符。自定义运算符继承自 BaseOperator 类,并实现 execute() 方法,定义了任务的执行逻辑。

例如,一个自定义的运算符用于执行自定义Python脚本:

from airflow.models import BaseOperator

from airflow.utils.decorators import apply_defaults

class CustomScriptOperator(BaseOperator):

@apply_defaults

def __init__(self, script_path, *args, **kwargs):

super(CustomScriptOperator, self).__init__(*args, **kwargs)

self.script_path = script_path

def execute(self, context):

# 执行脚本的代码

pass

4.2.3 运算符的选择和适用场景

在定义任务时,正确的运算符选择至关重要。下面是选择运算符时应该考虑的因素:

- 任务需求 :确定任务需要完成什么操作,选择最直接实现功能的运算符。

- 性能要求 :考虑运算符的性能特点,例如是否支持并行执行。

- 维护性 :优先选择社区支持良好、文档齐全的运算符。

- 可扩展性 :根据工作流的扩展需求,选择容易定制和扩展的运算符。

以下是使用不同运算符的一个示例:

from airflow.operators.bash_operator import BashOperator

from airflow.operators.python_operator import PythonOperator

# Bash运算符用于执行Shell命令

bash_task = BashOperator(

task_id='print_date',

bash_command='date',

)

# Python运算符用于运行Python函数

def print_date():

from datetime import datetime

print(datetime.now())

python_task = PythonOperator(

task_id='print_date_py',

python_callable=print_date,

)

在定义任务时,建议结合具体任务类型和运算符的特性,按照清晰、简单且高效的规则来进行。合理利用运算符可以使得DAG设计更加直观,易于维护和扩展。

5. 调度与依赖设置方法

5.1 调度策略的理解和应用

5.1.1 时间调度的原理

时间调度是工作流管理系统中至关重要的功能,它决定了任务何时被触发执行。Airflow通过内置的调度器,可以设定以特定时间间隔周期性执行任务。调度器是一个后台服务,它不断检查时间表,决定何时触发任务实例的执行。任务实例的调度基于DAG定义中的 default_args 和 schedule_interval 参数。

在Airflow中,时间调度的原理可以总结为以下几个步骤: 1. 解析DAG文件中的 schedule_interval 参数。 2. 根据 start_date 确定调度开始的时间点。 3. 调度器以固定的频率检查是否到了触发任务的时间。 4. 如果到了预定时间,调度器会创建一个任务实例,并放入待执行队列。

5.1.2 使用cron表达式进行调度

Airflow支持使用cron表达式进行复杂的调度设置。Cron表达式是一个字符串,由五或六个空格分隔的时间字段组成。这些字段代表了不同的时间单位:

- 分钟 (0 - 59)

- 小时 (0 - 23)

- 日 (1 - 31)

- 月 (1 - 12)

- 星期 (0 - 7) (其中0和7都代表星期天)

某些Airflow版本还支持秒字段,使得调度更加精确。

下面是一个使用cron表达式的例子:

from datetime import datetime

default_args = {

'start_date': datetime(2023, 1, 1),

# 其他参数...

}

dag = DAG(

dag_id='example_cron',

default_args=default_args,

schedule_interval='0 10 *** 1-5', # 每个工作日的上午10点执行

# 其他参数...

)

该cron表达式意味着任务将在每个星期一到星期五的上午10点执行。

5.2 依赖关系的高级设置

5.2.1 依赖关系的类型和作用

在Airflow中,任务依赖关系定义了任务执行的顺序和条件。依赖关系分为两类:

- 上下游依赖 :定义了任务之间的执行顺序。一个任务可以有多个上游任务和多个下游任务。

- 时间依赖 :决定任务是否因为时间原因被触发执行。

依赖关系的作用在于确保数据处理流程的逻辑正确性和数据完整性。没有正确的依赖设置,工作流可能会因为数据未准备好而失败,或者因为不必要的等待而造成效率低下。

5.2.2 解决任务依赖冲突的方法

依赖冲突主要发生在两个任务需要相同资源或数据时。Airflow提供了 priority_weight 参数用于解决这种情况。优先级高的任务可以先运行,但需要注意的是,Airflow不会强制任务以特定顺序执行,只是在资源紧张时提供一个决策依据。

要解决依赖冲突,还可以:

- 利用

depends_on_past确保任务依赖于前一个周期的任务成功执行。 - 使用

wait_for_downstream参数,使任务在所有下游任务完成后才标记为成功。

5.2.3 处理复杂的任务依赖图

当工作流变得非常复杂时,依赖关系图也可能变得错综复杂。为了有效地处理这些情况,Airflow提供了以下工具和技巧:

- SubDAGs : 将复杂DAG分解为更小的模块,每个模块是一个子DAG。

- Branching : 使用

BranchPythonOperator根据条件执行不同的任务路径。 - TaskGroup : 在新版本的Airflow中,可以使用TaskGroup来组织任务,使之逻辑上成组,但不会影响依赖关系图的其他部分。

- 可视化工具 : 利用Airflow的Web UI直观地查看和分析复杂的依赖图。

通过这些方法和工具,可以有效地管理和优化复杂的工作流依赖关系。

6. Airflow的Web UI功能和重要性

Airflow的Web界面是管理员和开发者日常工作中不可或缺的一部分,其提供的直观的用户界面极大地提高了管理和监控工作流的效率。以下是Web UI的详细功能介绍和如何使用这些功能来提高工作效率。

6.1 Web UI的基本功能介绍

6.1.1 UI界面布局和导航

Airflow的Web用户界面采用清晰的布局和导航,帮助用户快速理解和操作工作流。从登录页开始,用户会看到一个仪表盘,上面显示了所有DAG的概览信息,包括状态、最近的运行和警告信息。

UI仪表盘布局示例:

+-----------------------------------------------+

| Dashboard |

| +-------------------------------------------+ |

| | DAG List | |

| | | |

| | +------------+ +---------------------+ | |

| | | Dag状态统计 | | 最近运行的工作流 | | |

| | +------------+ +---------------------+ | |

| | | |

| | +-----------+ +---------------------+ | |

| | | 任务实例状态 | | 警告和错误提示 | | |

| | +-----------+ +---------------------+ | |

| +-------------------------------------------+ |

+-----------------------------------------------+

用户可以通过点击DAG列表中的DAG名称进入DAG详情页面,查看DAG的完整信息、图表视图和任务实例的详细信息。

6.1.2 DAG列表和任务实例查看

在DAG详情页,用户可以查看到该DAG的所有任务节点和它们的状态,同时可以查看整个工作流的依赖关系图。每个节点的颜色和标记直观地表示了任务的状态(成功、失败、正在运行等)。

DAG详情页面布局示例:

+-----------------------------------------------+

| DAG Details |

| +-------------------------------------------+ |

| | DAG基本信息 | |

| | | |

| | DAG图表视图 | |

| | | |

| | +----------------+ +------------------+ | |

| | | 任务实例列表 | | 依赖关系图 | | |

| | +----------------+ +------------------+ | |

| +-------------------------------------------+ |

+-----------------------------------------------+

每个任务实例都可以被点击来查看该任务的执行详情,包括执行日志、参数、开始时间、持续时间等信息。

6.2 Web UI的高级功能

6.2.1 日志查看与分析

对于想要深入分析任务执行情况的用户,Airflow提供了强大的日志查看功能。用户可以直接在Web UI中查看实时生成的任务日志,这些日志按时间顺序排列,并且支持关键字搜索。

日志查看界面示例:

+-----------------------------------------------+

| 日志查看 |

| +-------------------------------------------+ |

| | 日志搜索框 | |

| | | |

| | 日志内容展示 | |

| | | |

| | +---------------------------------------+ | |

| | | 搜索结果列表 | | |

| | +---------------------------------------+ | |

| +-------------------------------------------+ |

+-----------------------------------------------+

在高级设置中,还可以根据不同的日志级别(如INFO、WARNING、ERROR)过滤查看内容,帮助快速定位问题。

6.2.2 错误任务的诊断与处理

当任务失败时,Airflow的Web UI可以指导用户诊断问题。它提供了错误详情、堆栈跟踪和失败任务的上下文信息,帮助用户理解失败的原因。

错误任务诊断界面示例:

+-----------------------------------------------+

| 错误任务诊断 |

| +-------------------------------------------+ |

| | 错误摘要 | |

| | | |

| | 堆栈跟踪 | |

| | | |

| | +---------------------------------------+ | |

| | | 失败任务的上下文信息 | | |

| | +---------------------------------------+ | |

| +-------------------------------------------+ |

+-----------------------------------------------+

用户还可以根据日志信息执行重试操作或手动触发任务。

6.2.3 调度和暂停任务的操作

在Web UI上,用户可以执行任务调度和暂停操作,这对于需要临时调整工作流执行计划的场景非常有用。

任务调度和暂停操作界面示例:

+-----------------------------------------------+

| 任务调度和暂停 |

| +-------------------------------------------+ |

| | 任务调度选项 | |

| | | |

| | 暂停/恢复任务按钮 | |

| | | |

| | +---------------------------------------+ | |

| | | 任务暂停/恢复确认 | | |

| | +---------------------------------------+ | |

| +-------------------------------------------+ |

+-----------------------------------------------+

用户可以对单个任务或整个DAG进行调度设置,例如手动触发、回退到特定日期、暂停和恢复执行等。

通过这些功能,Airflow的Web UI为用户提供了便捷的管理和监控工作流的方法,同时也支持在任务出现问题时进行快速的诊断和处理。在接下来的章节中,我们将进一步探讨如何利用Airflow的扩展性和自定义插件来增强工作流的功能。

7. Airflow的扩展性和自定义插件

在前面章节中,我们已经深入探讨了Airflow的基础架构和工作原理,以及如何通过Python API编写和执行DAGs。在这一章节,我们将目光投向Airflow的扩展性和自定义插件,以实现更加复杂和特定的业务需求。

7.1 Airflow的扩展机制

Airflow作为一个强大的开源工作流管理平台,其扩展机制允许开发者在保持核心功能的同时,加入定制化的组件以适应不同的业务场景。

7.1.1 标准扩展的开发方法

标准扩展通常指的是在Airflow的 $AIRFLOW_HOME/plugins 目录下添加自定义模块。开发标准扩展需要遵循一些基本步骤:

- 创建一个Python包,通常是一个包含

__init__.py的目录。 - 在包中定义你需要扩展的类或函数。

- 在

__init__.py中导入这些类或函数,以便Airflow可以加载它们。 - 在

setup.py文件中配置包信息,确保Airflow安装插件时可以正确识别。

# example_plugin/__init__.py

from .example_operator import ExampleOperator

__all__ = ['ExampleOperator']

# example_plugin/example_operator.py

from airflow.models import BaseOperator

from airflow.utils.decorators import apply_defaults

class ExampleOperator(BaseOperator):

@apply_defaults

def __init__(self, example_param, *args, **kwargs):

super(ExampleOperator, self).__init__(*args, **kwargs)

self.example_param = example_param

def execute(self, context):

# 执行自定义操作逻辑

pass

# setup.py

from setuptools import setup, find_packages

setup(

name='example_plugin',

packages=find_packages(),

# 其他需要的包配置...

)

7.1.2 扩展组件的注册与加载

为了使Airflow能够识别并加载自定义扩展,我们需要在Airflow配置文件中(通常是 airflow.cfg )注册该插件。

[core]

plugins_folder = /path/to/your/plugins

完成以上步骤后,重启Airflow服务,你的自定义插件就会被加载并可以在Airflow中使用。

7.2 自定义插件的开发与应用

自定义插件可以根据具体的业务需求提供特定的功能。

7.2.1 插件开发的基本步骤

自定义插件的开发通常遵循以下步骤:

- 明确插件需要实现的功能和业务目标。

- 设计插件的架构和接口。

- 编写代码实现功能,并确保遵循Airflow的编程范式。

- 编写单元测试,验证插件的正确性。

- 部署插件到Airflow环境中,并进行集成测试。

7.2.2 插件在实际工作流中的应用实例

假设我们需要一个自定义的插件来处理特定文件格式的数据。我们可以创建一个名为 FileProcessorPlugin 的插件,其内部包含一个 FileProcessingOperator 操作符。

# FileProcessingOperator.py

from airflow.models import BaseOperator

from airflow.utils.decorators import apply_defaults

class FileProcessingOperator(BaseOperator):

@apply_defaults

def __init__(self, filepath, *args, **kwargs):

super(FileProcessingOperator, self).__init__(*args, **kwargs)

self.filepath = filepath

def execute(self, context):

# 文件处理逻辑

with open(self.filepath, 'r') as ***

***

*** 自定义的处理函数

return "File processing complete"

然后,在Airflow的DAG中使用这个自定义操作符:

from airflow import DAG

from datetime import datetime

from FileProcessingOperator import FileProcessingOperator

default_args = {

'start_date': datetime(2023, 1, 1),

}

dag = DAG('file_processing_dag', default_args=default_args, schedule_interval=None)

file_processing_task = FileProcessingOperator(

task_id='file_processing_task',

filepath='/path/to/file.txt',

dag=dag

)

7.2.3 插件管理和维护的最佳实践

当Airflow环境中的插件数量增多时,插件的管理和维护会变得更加重要。以下是一些最佳实践:

- 文档化 : 为每个插件编写清晰的文档,包括安装、配置、使用方法以及维护指南。

- 版本控制 : 使用版本控制系统(如git)来管理插件代码,并进行版本控制。

- 单元测试 : 编写单元测试,确保插件代码的质量和可靠性。

- 错误跟踪 : 使用错误跟踪系统来记录和处理插件中出现的问题。

- 配置管理 : 使用配置文件或环境变量来管理插件配置,使其更加灵活。

在本章节中,我们详细探讨了Airflow的扩展机制和自定义插件的开发与应用。通过遵循这些实践,可以充分利用Airflow的可扩展性来满足日益增长的业务需求。接下来的章节,我们将介绍如何利用Airflow的Web UI进行更高效的工作流管理。

简介:Apache Airflow是一个开源的工作流管理平台,主要用于创建、监控和调度复杂的数据处理任务。其核心理念是将工作流程定义为代码,便于版本控制、测试和协作。本课程项目将深入探讨工作流定义、Python API、任务与运算符、调度与依赖、Web UI、扩展性、容错与重试机制、资源管理和并行性、集成其他服务以及最佳实践等关键知识点。通过理论与实践的结合,帮助学生掌握如何使用Airflow来构建高效可靠的数据处理工作流。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?