简介:Python语言和深度学习理论是数据科学领域的两大支柱,为人工智能的进步提供了重要动力。通过Python,可以使用其简洁的语法和丰富的库来构建深度学习模型,包括Numpy、Scipy、Pandas、TensorFlow和PyTorch等。本主题不仅涵盖Python的基础语法、数据结构和控制流,还包括了深入的深度学习理论,如神经网络结构、激活函数、损失函数、优化算法等。同时,也强调了数据预处理、模型构建和调试工具的重要性。掌握这些内容有助于开发复杂的智能系统,并能应对人工智能技术的快速发展。

1. Python基础语法和数据结构

1.1 Python简介和基本概念

Python是一种广泛使用的高级编程语言,以其简洁的语法和强大的功能赢得了全球开发者的喜爱。它支持多种编程范式,包括过程式、面向对象和函数式编程。Python的可读性和简洁性使得它成为初学者学习编程的优选语言,同时也足够强大,可以在各个领域(如Web开发、数据科学、人工智能等)实现复杂的应用。

1.2 Python的基础语法

Python的基础语法包括变量声明、控制流(如条件判断和循环)、函数定义等。Python使用缩进来定义代码块,而非大括号。例如,一个简单的条件判断和循环可以表示如下:

# 条件判断

if x > 0:

print("x is positive")

# 循环

for i in range(5):

print(i)

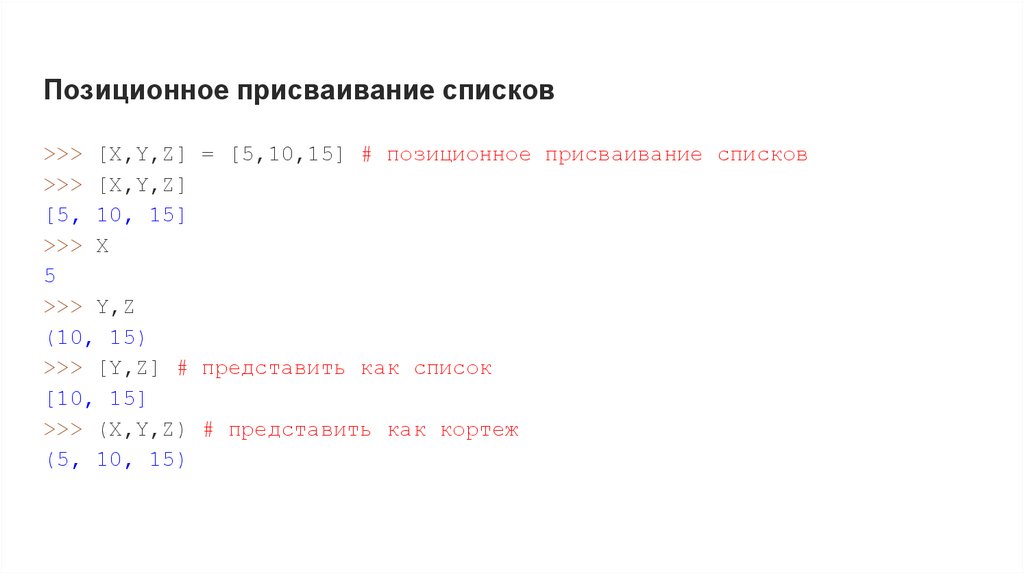

1.3 数据类型和结构

Python中的主要数据类型包括整数、浮点数、字符串、布尔值等。Python还提供了丰富的数据结构,如列表(list)、元组(tuple)、字典(dict)和集合(set)。这些数据结构为数据操作提供了极大的便利,例如:

# 列表操作

fruits = ["apple", "banana", "cherry"]

fruits.append("date")

# 字典操作

person = {"name": "Alice", "age": 30}

print(person["age"])

通过这些基本概念和语法,我们可以开始构建简单的程序,进而探索更高级的编程技术。随着对Python掌握程度的提升,我们可以逐步深入到更复杂的数据结构和算法中,为后续学习更高级的工具和框架打下坚实的基础。

2.2 高级数组操作

2.2.1 数组形状的变换

数组形状的变换在数据处理中至关重要,因为不同的问题往往需要不同形状的数据。Numpy提供了多种方法来改变数组的形状,而不需要复制数据。

在改变数组形状时,要注意数据总数量必须保持不变,除非使用如 ravel 等方法生成副本。Numpy数组可以使用 reshape 方法来改变其形状。

import numpy as np

# 创建一个一维数组

a = np.array([1, 2, 3, 4, 5, 6])

# 改变数组为2x3的二维数组

a_reshaped = a.reshape(2, 3)

print(a_reshaped)

在上述代码中, reshape 函数改变了数组 a 的形状,使得它由一维数组变成了2行3列的二维数组,没有复制任何数据。而原始数组 a 的形状是(6,),改变后变成了(2, 3)。

还可以使用 resize 方法直接就地改变数组大小,而不是返回一个新的数组。 transpose 方法可以改变数组的轴顺序,这在多维数组操作中经常被使用。

# 将原数组就地改变为3x2的二维数组

a.resize(3, 2)

# 转置数组

a_transposed = a.transpose()

print(a_transposed)

2.2.2 广播机制的理解与应用

广播(Broadcasting)机制是Numpy的一个重要特性,允许不同形状的数组进行算术运算。广播机制使得较小的数组在较大的数组上进行操作,像是沿着较大数组的对应轴重复自身。

为了广播,较小的数组会在缺失的维度上增加1,直到两个数组在所有维度上的大小匹配。

import numpy as np

# 创建一个3x3的数组

a = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 创建一个1x3的数组

b = np.array([1, 2, 3])

# 利用广播机制进行加法操作

result = a + b

print(result)

在这个例子中,数组 b 是一个1x3数组,而数组 a 是一个3x3数组。为了使 b 和 a 进行逐元素的加法, b 在第二维上广播。其结果是,数组 b 被看作是3x3数组,其中每行都是 [1, 2, 3] 。

如果要对一个一维数组进行逐元素的平方操作,可以使用以下代码:

c = np.array([1, 2, 3])

c_squared = c**2

print(c_squared)

广播机制极大地提高了数组操作的灵活性,并使得对不同形状的数组进行操作变得轻而易举。

下一章节我们将深入探讨如何将Numpy应用于深度学习中的数据预处理与批处理。

3. 科学计算工具Scipy

在现代科学和工程领域,数据的计算和分析是不可或缺的环节。Python 作为一门强大的编程语言,在科学计算领域也有着广泛的应用。本章节将重点介绍 Python 在科学计算中的一个强大库 —— Scipy。

3.1 Scipy的子库概览

Scipy 是一个开源的 Python 算法库和数学工具包,提供了许多对科学、工程以及数学有用的功能。它构建在 NumPy 之上,用于解决科学计算中的各种问题。

3.1.1 常用子库的介绍和功能

Scipy 包含多个子库,每个子库针对特定的科学计算领域提供了相应的工具。比如, scipy.integrate 用于数值积分, scipy.optimize 用于优化问题, scipy.stats 用于统计分析等等。

让我们以 scipy.integrate 子库为例,展示如何使用它解决实际问题。下面的代码段将演示如何进行简单的数值积分:

import numpy as np

from scipy import integrate

def f(x):

return np.sin(x) + x

x = np.linspace(0, np.pi, 25)

y = f(x)

# 使用数值积分

area, error = integrate.quad(f, 0, np.pi)

print("积分结果:", area)

这段代码首先定义了一个函数 f(x) ,然后在区间[0, π]上进行数值积分。 integrate.quad 函数返回积分的估计值和估计误差。

3.1.2 子库间的协作与集成

不同子库之间可以互相协作,构成一个完整的科学计算体系。例如,在解决优化问题时,可能需要数值积分来计算目标函数的值,这时候就可以将 scipy.integrate 和 scipy.optimize 结合使用。

在下面的示例中,我们将结合 scipy.optimize 中的 minimize 函数,来寻找函数 f(x) 在区间[0, π]上的最小值:

from scipy import optimize

result = optimize.minimize(f, 0, method='BFGS')

print("最小值点:", result.x)

print("最小值:", result.fun)

minimize 函数尝试找到函数 f(x) 的最小值。此处使用了BFGS算法,这是一种常用的拟牛顿法优化算法。

3.2 数值分析和优化算法

Scipy 不仅提供了数学计算的函数,还包括数值分析和优化算法,这些工具在科学和工程计算中经常使用。

3.2.1 数值积分与微分方程求解

数值积分是利用数值方法近似计算定积分的过程。Scipy 提供了多种积分方法,包括梯形法、辛普森法、高斯求积法等。

对于微分方程求解, scipy.integrate.odeint 函数可以用来求解常微分方程初值问题。下面的代码演示了如何使用它:

from scipy.integrate import odeint

# 定义微分方程

def model(y, t):

dydt = -2 * y + np.exp(-t)

return dydt

y0 = [1.0]

t = np.linspace(0, 5, 20)

solution = odeint(model, y0, t)

# 绘制结果

import matplotlib.pyplot as plt

plt.plot(t, solution)

plt.xlabel('time')

plt.ylabel('solution y')

plt.title('Differential Equation Solution')

plt.show()

3.2.2 极值问题和线性规划

Scipy 的 scipy.optimize 子库提供了用于解决极值问题的工具。例如, minimize 函数用于求解无约束或有约束的非线性规划问题。

对于线性规划, scipy.optimize.linprog 方法可以解决。下面代码展示了如何使用 linprog 解决一个简单的线性规划问题:

# 定义目标函数的系数

c = [-1, -2]

# 定义不等式约束矩阵

A = [[-3, 1], [1, 2], [2, 1]]

# 定义不等式约束的右侧值

b = [3, 3, 5]

# 定义变量的上下界

x0_bounds = (0, None)

x1_bounds = (0, None)

# 求解线性规划问题

res = optimize.linprog(c, A_ub=A, b_ub=b, bounds=[x0_bounds, x1_bounds], method='highs')

print("最优值:", -res.fun) # linprog默认求最小值,所以乘以-1获取最大值

此示例中, linprog 函数求解了具有两个变量和三个约束条件的线性规划问题。

3.3 信号处理和统计分析

Scipy 在信号处理和统计分析方面同样提供了强大的工具。这些工具有助于数据的分析、处理、可视化和解释。

3.3.1 信号处理工具的使用

scipy.signal 子库提供了各种信号处理的工具,例如滤波器设计、卷积、相关性分析等。

以快速傅里叶变换(FFT)为例,下面的代码演示了如何对一个信号进行频谱分析:

from scipy.fft import fft

import numpy as np

# 创建一个简单的信号

t = np.linspace(0, 1.0, 1000, endpoint=False)

signal = 0.5 * np.sin(2 * np.pi * 50 * t) + np.sin(2 * np.pi * 120 * t)

# 进行快速傅里叶变换

fft_result = fft(signal)

# 取模得到频谱

spectrum = np.abs(fft_result)

# 计算频率轴对应的值

freq = np.fft.fftfreq(t.shape[-1])

# 绘制频谱

plt.figure(figsize=(12, 6))

plt.plot(freq[:500], spectrum[:500])

plt.title('Spectrum of the signal')

plt.xlabel('Frequency')

plt.ylabel('Spectrum Magnitude')

plt.show()

3.3.2 统计分析中的应用实例

scipy.stats 子库则提供了统计分析中经常用到的各种分布和测试方法。例如,正态分布、t检验、卡方检验等。

下面的示例中,我们将使用 scipy.stats 进行一个简单的正态分布的假设检验:

from scipy import stats

# 假设我们有一组数据,想要检验它是否来自正态分布

data = np.random.normal(0, 1, 100)

# 使用Shapiro-Wilk检验正态性

stat, p_value = stats.shapiro(data)

print("Shapiro-Wilk检验统计量:", stat)

print("p值:", p_value)

alpha = 0.05

if p_value > alpha:

print("数据看起来是正态分布的 (不能拒绝原假设)")

else:

print("数据不是正态分布的 (拒绝原假设)")

在此示例中, stats.shapiro 函数用于检验数据是否符合正态分布。如果p值大于显著性水平α(通常为0.05),则不能拒绝原假设,数据看起来符合正态分布。

Scipy 库的子库众多,功能强大,涵盖了科学计算的各个主要方面,是科学工程领域中不可或缺的计算工具。本章节内容仅是对 Scipy 的一个概括性介绍,通过实际代码和应用示例,旨在展示 Scipy 在实际科学计算任务中的应用方法和优势。

4. 数据预处理与分析工具Pandas

4.1 数据结构介绍

4.1.1 Series与DataFrame的构建

在Python的数据分析世界中,Pandas库作为最核心的库之一,为数据处理提供了强大的支持。Pandas提供了两种主要的数据结构:Series和DataFrame。这两种数据结构在很多方面都类似于R语言中的向量和数据框。

Series可以视为一个一维数组,用于存储一系列的数据。它由一组数据以及一组与之相对应的数据标签(索引)组成。而DataFrame则是一个二维的标签化数据结构,可以看作是一个表格,拥有行索引和列索引。DataFrame可以容纳不同数据类型,从而更加灵活和强大。

下面是一个创建Series和DataFrame的示例代码:

import pandas as pd

# 创建一个Series

series_example = pd.Series([1, 2, 3, 4, 5])

# 创建一个DataFrame

data = {'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Age': [28, 19, 33, 25]}

df_example = pd.DataFrame(data)

print(series_example)

print(df_example)

在上述代码中,我们首先导入了pandas库,并使用 pd.Series 和 pd.DataFrame 构造函数分别创建了一个Series对象和一个DataFrame对象。Series中的数据索引默认为整数序列,而DataFrame允许我们通过字典来定义列标签和数据。

4.1.2 数据清洗和预处理方法

数据清洗是数据预处理中非常重要的一步。在实际应用中,往往需要对原始数据进行大量的清洗工作以提高数据质量。Pandas提供了大量的函数和方法来帮助我们完成数据清洗的任务。

常见的数据清洗方法包括:缺失值处理、数据类型转换、异常值处理、重复数据处理等。

# 处理缺失值

df_example.fillna(value=0, inplace=True) # 用0填充缺失值

# 转换数据类型

df_example['Age'] = df_example['Age'].astype(str) # 将年龄列转换为字符串类型

# 删除重复数据

df_example.drop_duplicates(inplace=True)

# 异常值处理(示例:年龄小于18岁和大于60岁的数据视为异常值)

age_mask = (df_example['Age'].astype(int) < 18) | (df_example['Age'].astype(int) > 60)

df_example = df_example[~age_mask]

print(df_example)

在这些代码块中,我们使用了 fillna 方法来填充缺失值, astype 方法来转换数据类型, drop_duplicates 方法删除了重复数据,并通过条件筛选来处理异常值。

4.2 数据操作和数据聚合

4.2.1 数据的合并、连接和重塑

数据合并、连接和重塑是数据分析中常用的操作,Pandas提供了相应的函数来完成这些任务。 concat 函数用于合并两个或多个数据结构, merge 函数用于连接两个数据集,而 pivot 或 melt 函数用于数据的重塑。

# 数据合并示例

df_concat = pd.concat([df_example, df_example], axis=0) # 垂直合并

df_concat = pd.concat([df_example, df_example], axis=1) # 水平合并

# 数据连接示例

df_example2 = pd.DataFrame({'Name': ['Peter', 'Linda'], 'Country': ['USA', 'Canada']})

df_merged = pd.merge(df_example, df_example2, on='Name', how='inner') # 内连接

# 数据重塑示例

df_pivot = df_example.pivot(index='Name', columns='Age', values='Age') # 转换为宽格式

print(df_concat)

print(df_merged)

print(df_pivot)

在上述代码中,我们分别演示了如何使用 concat 进行垂直和水平的数据合并, merge 进行内连接操作,以及 pivot 进行数据重塑。

4.2.2 数据聚合与分组操作

数据聚合和分组操作能够帮助我们对数据进行汇总和分析。Pandas提供了 groupby 方法,让我们可以对数据进行分组并应用聚合函数(如sum, mean, max, min等)。

# 分组操作示例

df_grouped = df_example.groupby('Name').mean()

# 数据聚合示例

df_aggregated = df_example.groupby('Name')['Age'].agg(['min', 'max'])

print(df_grouped)

print(df_aggregated)

在这个例子中,我们通过 groupby 方法按照姓名分组,并计算了每个组的平均年龄。同时,我们也演示了对特定列进行聚合操作,计算了年龄的最小值和最大值。

4.3 Pandas在深度学习预处理中的应用

4.3.1 特征提取与数据标准化

Pandas在数据预处理阶段扮演着至关重要的角色,尤其是在特征提取和数据标准化方面。通过对数据进行转换和归一化,我们可以为深度学习模型提供更好的输入。

from sklearn.preprocessing import StandardScaler

# 提取特征

features = df_example[['Age']]

target = df_example['Name']

# 数据标准化

scaler = StandardScaler()

features_scaled = scaler.fit_transform(features)

print(features_scaled)

在上述代码中,我们首先提取了年龄作为特征,并把姓名作为目标变量。然后,使用 StandardScaler 进行数据标准化处理。Pandas允许我们方便地选择数据列,并与scikit-learn这样的机器学习库无缝集成。

4.3.2 与TensorFlow和PyTorch的数据交互

在构建深度学习模型时,我们经常需要将Pandas处理好的数据转换为TensorFlow或PyTorch能够接受的格式。这包括将数据转换为张量以及根据模型需要进行批处理。

import tensorflow as tf

# 将Pandas的DataFrame转换为TensorFlow张量

tf_dataset = tf.data.Dataset.from_tensor_slices((features_scaled, target.values))

# 进行批处理

tf_batched_data = tf_dataset.batch(2)

# 创建一个TensorFlow模型

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(1)

])

# 训练模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

model.fit(tf_batched_data, epochs=5)

print(model.summary())

在这个代码片段中,我们首先将Pandas的DataFrame转换成了TensorFlow的 Dataset 对象。然后,通过 batch 方法对数据进行了批处理,并创建了一个简单的神经网络模型进行训练。

以上内容就是本章节对Pandas进行数据预处理与分析工具的相关介绍,具体的使用方法和应用场景也通过代码示例进行了说明。这些内容的深入理解和实践应用,对于构建高效且准确的机器学习和深度学习模型至关重要。

5. 深度学习框架的理论与实践

5.1 TensorFlow和PyTorch框架概述

深度学习框架简化了复杂的数学运算,自动化了后端细节,并且让开发者能够专注于网络架构和模型训练过程。TensorFlow和PyTorch是目前最受欢迎的两个深度学习框架。

5.1.1 TensorFlow的基本结构和API

TensorFlow是一个开源的深度学习库,由Google团队开发。它的名字来源于数据流图,即Tensor和Flow这两个单词。Tensor表示多维数组,Flow表示计算之间的依赖关系。

TensorFlow的API设计为分层结构,其核心是一个用C++编写的高性能计算库,而上层提供了易于使用的Python接口。

import tensorflow as tf

# 创建一个常量运算

node1 = tf.constant(3.0, dtype=tf.float32)

node2 = tf.constant(4.0)

node3 = tf.add(node1, node2)

print(node3)

在上面的代码块中,我们首先导入了TensorFlow,然后创建了两个常量节点,并将它们相加。打印出来的结果是两个常量相加后的值。

5.1.2 PyTorch的动态计算图和灵活性

PyTorch由Facebook的人工智能研究团队开发,它以其动态计算图(也称为定义即运行(define-by-run))而闻名。动态图意味着网络是在运行时构建的,它提供了更高的灵活性。

import torch

# 创建张量

t1 = torch.tensor([1., 2., 3.])

t2 = torch.tensor([4., 5., 6.], dtype=torch.float32)

# 进行运算

result = t1 + t2

print(result)

在这段代码中,我们导入了PyTorch,并创建了两个张量,然后将它们相加。PyTorch允许即时修改和探索模型,这在研究和实验阶段特别有用。

5.2 神经网络的基本结构与组件

神经网络由多个层次的神经元组成,它们通过权重连接。每一层都执行不同的计算功能,以实现从输入到输出的映射。

5.2.1 神经元、层、网络结构的搭建

在深度学习框架中,一个神经元可以是全连接层、卷积层、循环层等。层是对多个神经元进行组织和管理的容器。网络结构则是由不同层构成的复杂组合。

import torch.nn as nn

# 定义一个简单的全连接网络

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(in_features=3, out_features=10) # 第一层,3个输入,10个输出

self.relu = nn.ReLU() # 激活函数

self.fc2 = nn.Linear(in_features=10, out_features=1) # 第二层,10个输入,1个输出

def forward(self, x):

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

return x

# 实例化模型

model = SimpleNet()

这段代码定义了一个简单的两层全连接网络,其中包含了一个激活函数ReLU。网络构建后,可以用来对数据进行前向传播,进行预测或训练。

5.2.2 常用的神经网络架构和模型

神经网络架构如卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)和Transformer等,已经在多个领域取得了巨大的成功。

class CNNNet(nn.Module):

def __init__(self):

super(CNNNet, self).__init__()

self.conv1 = nn.Conv2d(in_channels=1, out_channels=32, kernel_size=3, stride=1, padding=1)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2, padding=0)

self.fc1 = nn.Linear(32 * 7 * 7, 128) # 假设输入尺寸是28x28

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = x.view(-1, 32 * 7 * 7) # 展平特征图

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

这里创建了一个CNN网络,包括卷积层、池化层和全连接层,这样的架构在图像识别任务中非常常见。

5.3 深度学习理论深入

理解深度学习的基本理论对于设计有效的网络至关重要。包括激活函数、损失函数和优化算法在内的理论知识是构建成功模型的关键。

5.3.1 激活函数的数学原理和应用

激活函数负责引入非线性因素,使得神经网络能够解决更复杂的问题。

import matplotlib.pyplot as plt

def sigmoid(x):

return 1 / (1 + torch.exp(-x))

x = torch.linspace(-5, 5, 100)

y = sigmoid(x)

plt.plot(x.numpy(), y.numpy())

plt.title('Sigmoid Function')

plt.xlabel('x')

plt.ylabel('sigmoid(x)')

plt.show()

这段代码绘制了sigmoid函数的图像。Sigmoid函数是深度学习中常见的激活函数之一,它将任何实数值压缩到0和1之间。

5.3.2 损失函数的设计与选择

损失函数用来衡量模型预测值与实际值之间的差异,它帮助模型通过优化算法进行学习。

def mse_loss(y_pred, y_true):

return torch.mean((y_pred - y_true) ** 2)

# 假设y_pred是模型预测值,y_true是真实值

y_pred = torch.tensor([1.0, 2.0, 3.0])

y_true = torch.tensor([1.2, 2.2, 2.8])

loss = mse_loss(y_pred, y_true)

print(f"MSE Loss: {loss}")

在这个例子中,我们定义了均方误差(MSE)损失函数。MSE是回归问题中最常用的损失函数之一。

5.3.3 优化算法的优化目标和策略

优化算法负责更新模型的权重,以减少损失函数的值。梯度下降是最基本的优化算法,它根据损失函数的梯度来调整权重。

import torch.optim as optim

# 假设model是我们的神经网络模型,loss是我们计算得到的损失

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 执行优化步骤

optimizer.zero_grad() # 清除梯度

loss.backward() # 反向传播计算梯度

optimizer.step() # 更新权重

在上述代码块中,我们初始化了随机梯度下降(SGD)优化器,并用它来更新模型的参数。学习率(lr)是调整更新步长的重要参数。

5.4 模型的可视化和调试

模型的可视化和调试对于诊断模型性能和理解模型行为非常有帮助。它们可以帮助我们识别和修复问题。

5.4.1 权重可视化和特征图分析

可视化权重和中间层的特征图可以帮助我们理解模型在学习什么。

# 假设layer是一个卷积层

# 可视化该层的权重

weights = layer.weight.detach().numpy()

plt.imshow(weights.mean(axis=1).mean(axis=1)) # 展示一个滤波器的权重平均图

plt.title('Weight Visualization')

plt.show()

# 可视化卷积层的特征图

feature_maps = layer(img).detach().numpy()

plt.imshow(feature_maps[0, 0, :, :]) # 展示第一个特征图的激活

plt.title('Feature Map Visualization')

plt.show()

这里我们首先可视化了一个卷积层的权重,然后可视化了同一层处理输入图片后产生的第一个特征图。

5.4.2 模型调试的技巧和工具

调试深度学习模型通常需要一些特定的技巧和工具。例如,使用TensorBoard可视化训练过程,可以非常直观地查看损失函数和指标的变化。

# 在训练循环中添加 TensorBoard 记录

# 假设writer是创建好的TensorBoard对象

for step, (batch_x, batch_y) in enumerate(train_loader):

optimizer.zero_grad()

outputs = model(batch_x)

loss = criterion(outputs, batch_y)

loss.backward()

optimizer.step()

# 记录训练过程中的损失值

writer.add_scalar('training loss', loss.item(), step)

在这段代码中,我们在每个训练步骤结束后,使用TensorBoard记录损失值。之后可以在TensorBoard中观察损失值的变化趋势,帮助我们判断模型训练是否正常。

简介:Python语言和深度学习理论是数据科学领域的两大支柱,为人工智能的进步提供了重要动力。通过Python,可以使用其简洁的语法和丰富的库来构建深度学习模型,包括Numpy、Scipy、Pandas、TensorFlow和PyTorch等。本主题不仅涵盖Python的基础语法、数据结构和控制流,还包括了深入的深度学习理论,如神经网络结构、激活函数、损失函数、优化算法等。同时,也强调了数据预处理、模型构建和调试工具的重要性。掌握这些内容有助于开发复杂的智能系统,并能应对人工智能技术的快速发展。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?