本篇主要介绍一些基本概念:

- 损失函数

- 过拟合

- 精确率与召回率,RoC曲线和PR曲线

一:损失函数

$Y$为真实值;$f(X)$为预测值

(1) 0-1损失函数

![]()

(2) 平方损失函数

![]()

(3) 绝对损失函数

![]()

(4) 对数损失函数

![]()

损失函数的值越小,模型就越好!常用的优化方法一般采用最小二乘。然而,当学习器将训练样本学得“太好”的时候,很可能把训练样本自身的一些特点当作了所有潜在样本都会具有的一些性质,这样就会导致泛化能力下降,这种现象在机器学习中称为过拟合!(说的让人听不懂了?哈哈,简单点就是训练的时候准确率很高,但应用到新样本进行预测的时候效果很差)

二:精确率与召回率,PR曲线和RoC曲线

在机器学习的算法评估中,尤其是分类算法评估中,我们经常听到精确率(precision)与召回率(recall),RoC曲线与PR曲线这些概念,那这些概念到底什么个意思呢?

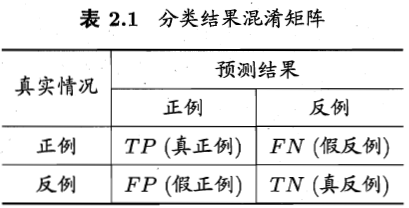

对二分类问题,可将样例根据其真实类别与学习器预测类别的组合划分为以下四类:

- True Positives,TP:预测为正样本,实际也为正样本的特征数

- False Positives,FP:预测为正样本,实际为负样本的特征数

- True Negatives,TN:预测为负样本,实际也为负样本的特征数

- False Negatives,FN:预测为负样本,实际为正样本的特征数

显然有,TP+FP+TN+FN=样例总数。正样本可以理解为我们所关注的类,由此可以按照同样的思路划分多分类问题。

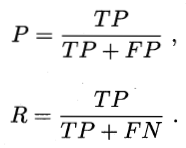

查准率 $P$ 和查全率 $R$ 分别定义为:

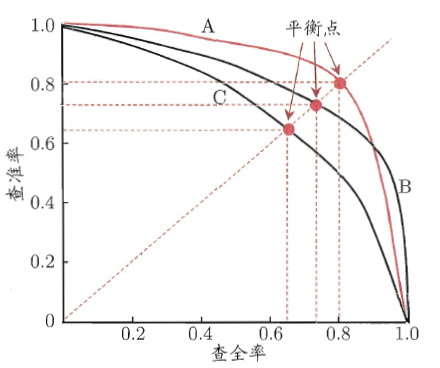

以$P$为纵轴,以$R$为横轴作图,就得到了PR曲线。例如:

在进行模型比较时,若一个模型的PR曲线被另一个模型的PR曲线完全包住,则可断言后者的性能优于前者。例如上图中A的性能就优于C。但A和B曲线有交叉这时该怎么做呢?平衡点(Break-Event Point)便派上了用场,它是一个综合考虑查准率和查全率的性能度量。它是查准率=查全率时的取值。上图BEP的值A>B可认为A性能优于B。但人们认为这样还是简化 了,更常用的是$F1$度量:

![]()

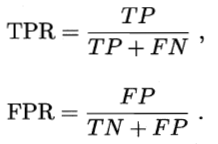

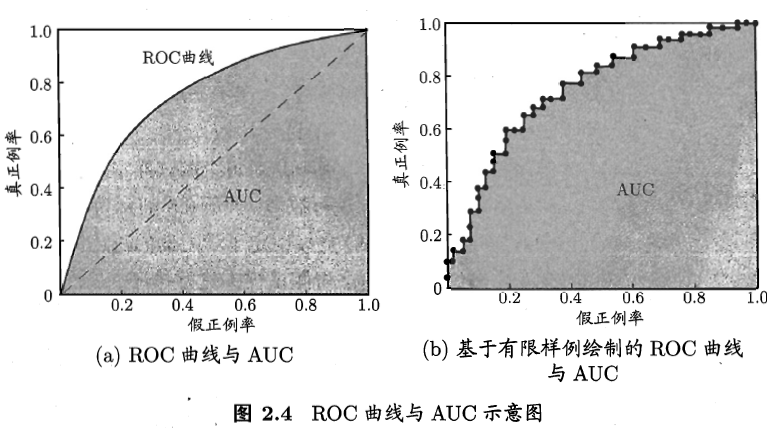

ROC曲线与PR曲线类似,只不过它的纵轴是“真正样本率(True Positive Rate, TPR)”,横轴是“假正样本率(False Positive Rate, FPR)”。

ROC曲线是研究模型泛化能力的有力工具。在进行模型比较时,与PR曲线相似,若一个模型的ROC曲线被另一个模型的ROC曲线完全包住,则可断言后者的性能优于前者。若二者发生交叉,则比较ROC曲线下的面积,即AUC(Area Under ROC Curve)。

636

636

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?