联邦学习的过程分为自治和联合两部分。

- 自治的部分:首先,两个或两个以上的的参与方们在各自终端安装初始化的模型,每个参与方拥有相同的模型,之后参与方们可以使用当地的数据训练模型。由于参与方们拥有不同的数据,最终终端所训练的模型也拥有不同的模型参数。

- 联合的部分:不同的模型参数将同时上传到云端,云端将完成模型参数的聚合与更新,并且将更新好的参数返回到参与方的终端,各个终端开始下一次的迭代。以上的程序会一直重复,直到整个训练过程的收敛。

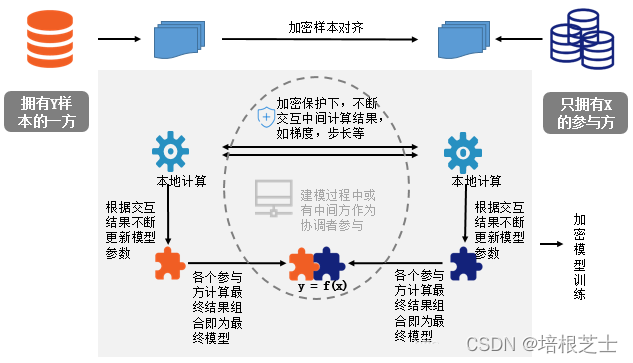

现以包含两个数据拥有方(即企业A和B)的场景为例来介绍联邦学习的系统构架,该构架可扩展至包含多个数据拥有方的场景。假设企业 A 和 B 想联合训练一个机器学习模型,它们的业务系统分别拥有各自用户的相关数据。此外,企业 B 还拥有模型需要预测的标签数据。出于数据隐私和安全考虑, A 和 B 无法直接进行数据交换。此时,可使用联邦学习系统建立模型,系统构架如图所示。

第一部分:加密样本对齐。

由于两家企业的用户群体并非完全重合,系统基于加密的用户样本对齐技术(如RSA),在A和B不公开各自数据的前提下确认双方的共有用户,并且不暴露不互相重叠的用户。以便联合这些用户的特征进行建模。

第二部分:加密模型训练。

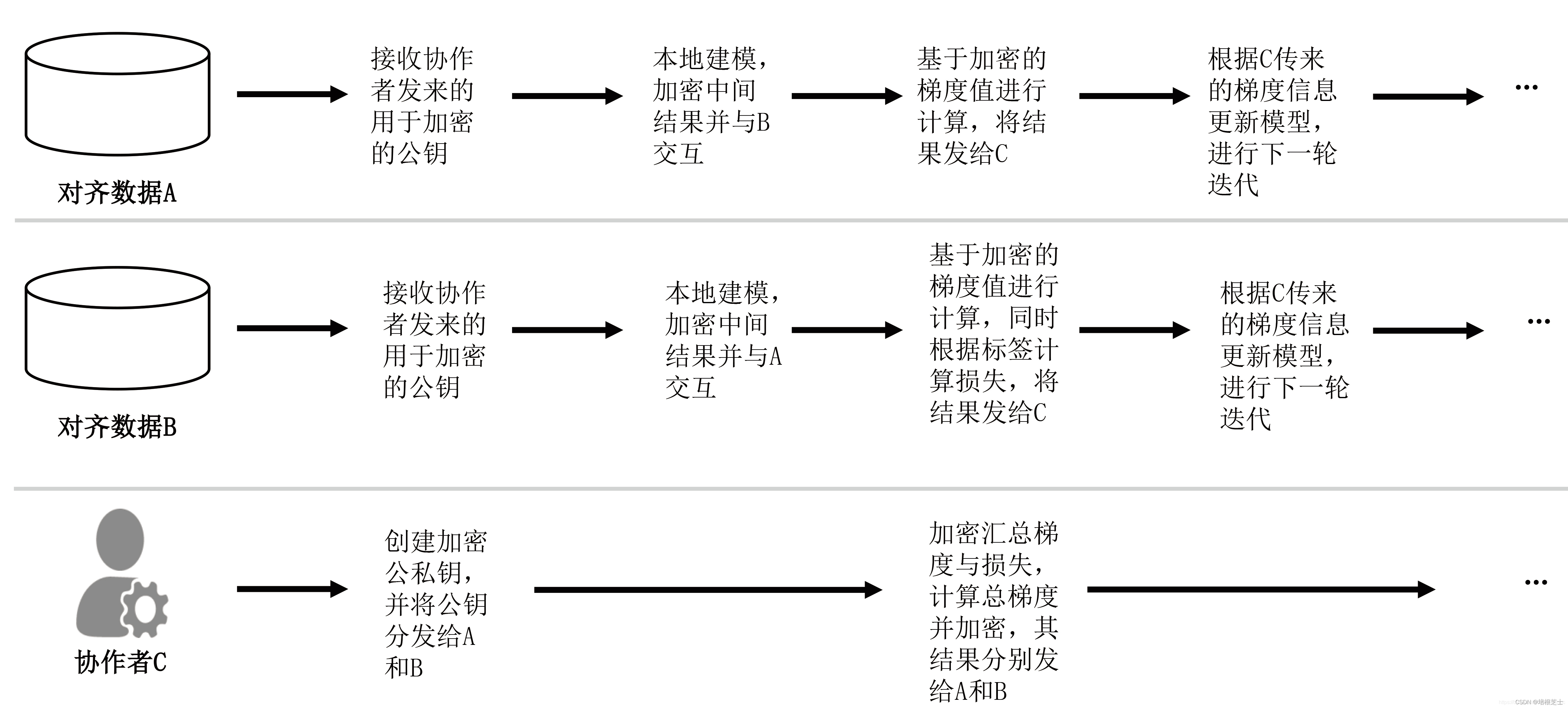

在确定共有用户群体后,就可以利用这些数据训练机器学习模型。为了保证训练过程中数据的保密性,有时需要借助第三方协作者C进行加密训练。以线性回归模型为例,训练过程可分为以下 4 步:

- 第①步:协作者C把公钥分发给A和B,用以对训练过程中需要交换的数据进行加密;

- 第②步:A和B之间以加密形式交互用于计算梯度的中间结果;

- 第③步:A和B分别基于加密的梯度值进行计算,同时 B 根据其标签数据计算损失,并把这些结果汇总给C。 C 通过汇总结果计算总梯度并将其解密;

- 第④步: C将解密后的梯度分别回传给A和B; A和B根据梯度更新各自模型的参数。

迭代上述步骤直至损失函数收敛,这样就完成了整个训练过程。在样本对齐及模型训练过程中,A和B各自的数据均保留在本地,且训练中的数据交互也不会导致数据隐私泄露。因此,双方在联邦学习的帮助下得以实现合作训练模型。

第三部分:效果激励。

联邦学习的一大特点就是它解决了为什么不同机构要加入联邦共同建模的问题,即建立模型以后模型的效果会在实际应用中表现出来,并记录在永久数据记录机制(如区块链)上。提供的数据多的机构会看到模型的效果也更好,这体现在对自己机构的贡献和对他人的贡献。这些模型对他人效果在联邦机制上以分给各个机构反馈,并继续激励更多机构加入这一数据联邦。

以上三个步骤的实施,即考虑了在多个机构间共同建模的隐私保护和效果,有考虑了如何奖励贡献数据多的机构,以一个共识机制来实现。所以,联邦学习是一个“闭环”的学习机制。

联邦学习是一种在保持数据本地化的同时,允许不同机构联合训练模型的技术。通过加密样本对齐确保用户隐私,然后利用加密模型训练进行迭代,各参与方在不共享数据的情况下更新模型参数。最后,通过效果激励机制鼓励更多机构参与,形成数据安全的闭环学习模型构建。

联邦学习是一种在保持数据本地化的同时,允许不同机构联合训练模型的技术。通过加密样本对齐确保用户隐私,然后利用加密模型训练进行迭代,各参与方在不共享数据的情况下更新模型参数。最后,通过效果激励机制鼓励更多机构参与,形成数据安全的闭环学习模型构建。

926

926

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?