首先

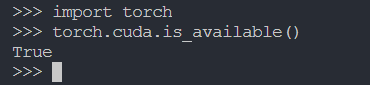

①使用 torch.cuda.is_available()查看是否正确安装cuda以及cudnn,

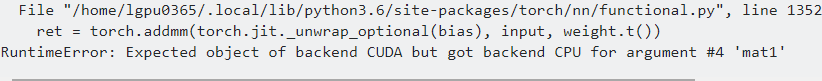

但是有时候会发现明明是有GPU存在就是调用不了,出现以下错误

PyTorch非常容易的就可以使用GPU,可以用如下方式把一个模型放到GPU上:

device = torch.device("cuda:0")

model.to(device)

然后可以复制所有的张量到GPU上:

mytensor = my_tensor.to(device)

请注意,调用my_tensor.to(device)返回一个GPU上的my_tensor副本,而不是重写my_tensor。我们需要把它赋值给一个新的张量并在GPU上使用这个张量。

本文详细介绍如何在PyTorch中使用GPU进行模型训练和张量运算,包括检查CUDA安装状态,将模型和数据转移到GPU上,以及常见错误解决办法。

本文详细介绍如何在PyTorch中使用GPU进行模型训练和张量运算,包括检查CUDA安装状态,将模型和数据转移到GPU上,以及常见错误解决办法。

2353

2353

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?